一、说明

随着深度学习和新的一亿参数模型的大肆宣传,人们很容易忘记这些大型神经网络只是工具,它们有其所有的偏见和弱点。我通过我的内容强调的想法之一是,您应该拥有多样化技能的坚实基础,以便您能够以有效且高效的方式解决问题。

二、现状和概述

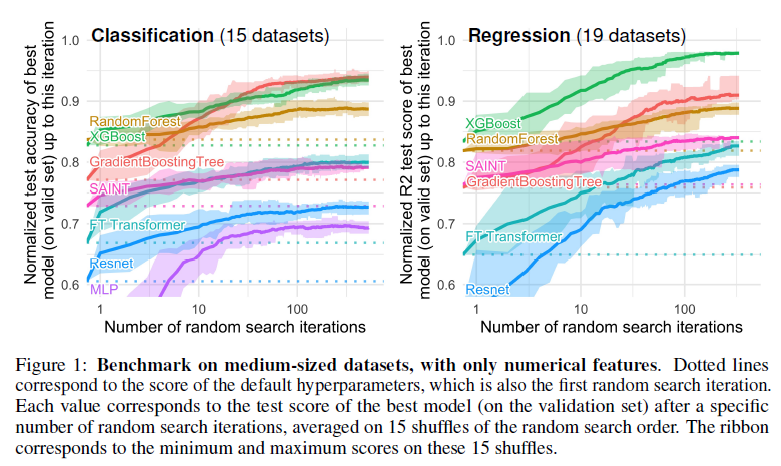

虽然深度学习在文本和图像数据集方面取得了巨大进步,其在表格数据上的优越性尚不清楚。我们提供广泛的基准标准和新颖的深度学习方法以及基于树的模型,例如XGBoost 和随机森林,跨越大量数据集和超参数组合。我们定义了来自不同领域的 45 个数据集的标准集表格数据的清晰特征和基准会计方法用于拟合模型和寻找良好的超参数。

结果表明,即使在中等规模的数据(~10K 样本)上,基于树的模型仍然保持着最先进的水平。不考虑他们卓越的速度。为了了解这一差距,我们进行了对基于树的模型的不同归纳偏差进行实证研究神经网络 (NN)。这导致了一系列应指导的挑战旨在构建表格特定神经网络的研究人员: 1. 对无信息性具有鲁棒性特征,2. 保留数据的方向,3. 能够轻松学习不规则函数。为了促进表格架构的研究,我们贡献了标准基准测试和基线原始数据:20 000 次计算的每个点

每个学习者的超参数搜索时间。

在本文中,我将分解这篇论文——为什么基于树的模型在表格数据上仍然优于深度学习? 该论文解释了世界各地在各种领域工作的机器学习从业者观察到的一个现象——基于树的模型(如随机森林)在分析表格数据时比深度学习/神经网络要好得多。我将分享他们的发现,帮助您了解为什么会发生这种情况,以及如何利用这些经验教训来创建最佳的人工智能管道来应对您遇到的挑战。

不要向所有简历中带有“深度学习专家|播客|区块链|软件”的人展示此图表。他们可能会开始尖叫并变得暴力。

三、论文注意事项

在我们开始研究论文的发现之前,我们应该首先了解论文的一些重要方面。这将帮助我们将研究结果结合起来并更好地评估结果。太多人直接跳到结果,没有花足够的时间来评估上下文。这是致命的罪孽,如果你这样做,我将不再爱你。

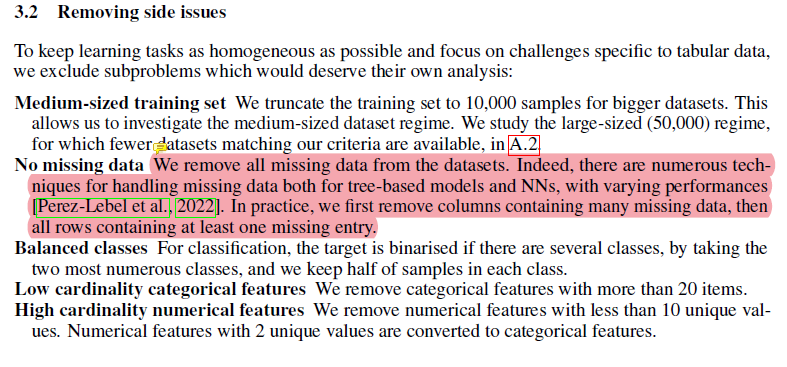

对我来说突出的一件事是这篇论文进行了大量的预处理。有些人喜欢删除丢失的数据,这会影响树的性能。正如我在本文中所介绍的 -如何处理丢失的环境数据,随机森林非常适合丢失数据的情况。当我与约翰·霍普金斯大学合作建立一个系统来预测不断变化的卫生系统政策将如何影响公共卫生时,我经常使用它们。这些数据非常嘈杂,具有大量的特征和维度。射频的稳健性和优势使它们比更“先进”的解决方案更好,因为后者很容易损坏。

其中大部分都是非常标准的东西。我个人不太喜欢应用太多预处理技术,因为这可能会导致您丢失数据集的很多细微差别,但此处采取的步骤将生成与工作时发现的数据集类似的数据集。然而,在评估最终结果时请记住这些限制,因为它们很重要。如果您的数据集看起来非常不同,那么请对这些结果持保留态度。

他们还使用随机搜索进行超参数调整。这也是行业标准,但根据我的经验,贝叶斯搜索更适合扫描更广泛的搜索空间。我很快就会制作一个视频,因此请确保您关注我的 YouTube 频道以了解最新动态。该链接(以及我所有其他工作)将位于本文末尾。

好了,现在是时候回答您点击本文的主要问题了——为什么基于树的方法能够击败深度学习?

四、基于树的方法高于深度学习的地方

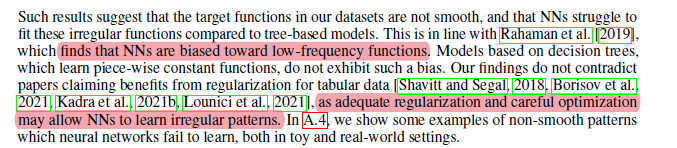

4.1 原因 1:神经网络偏向于过于平滑的解决方案

这是作者认为深度学习神经网络无法与随机森林竞争的第一个原因。简而言之,当涉及非平滑函数/决策边界时,神经网络很难创建最适合的函数。随机森林在奇怪/锯齿状/不规则模式方面做得更好。

如果我必须猜测原因,一个可能的原因可能是神经网络中梯度的使用。梯度依赖于可微的搜索空间,根据定义,它是平滑的。无法区分尖函数、破碎函数和随机函数。这就是我建议学习人工智能概念(如进化算法、传统搜索和更基本的概念)的原因之一,这些概念可以在神经网络失败时在各种情况下获得很好的结果。

有关基于树的方法(随机森林)和深度学习器之间决策边界差异的更具体示例,请查看下图 -

RF 的更好性能可归因于它们生成的更精确的决策边界。

在附录中,作者对上述可视化做了以下声明

在这一部分中,我们可以看到随机森林能够学习 MLP 无法学习的 x 轴(对应于日期特征)上的不规则模式。我们展示了默认超参数的这种差异,但在我们看来,这是神经网络的典型行为,实际上很难(尽管并非不可能)找到超参数来成功学习这些模式。

这显然非常重要。当您意识到基于树的方法的调整成本要低得多时,这一点就变得更加引人注目,这使得它们在物有所值的解决方案方面变得更好。

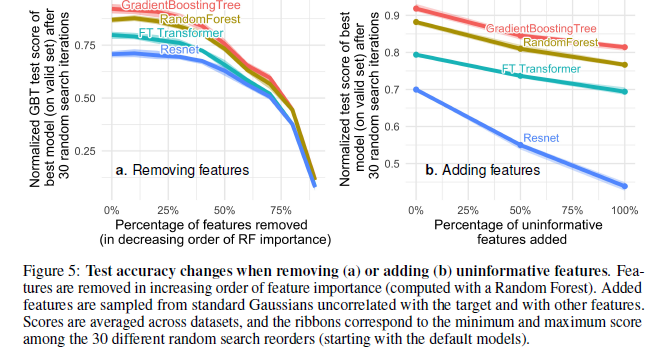

4.2 发现 2:无信息特征影响更多类似 MLP 的神经网络

另一个重要因素,特别是对于那些使用同时编码多个关系的庞大数据集的人来说。如果您向神经网络提供不相关的特征,结果将很糟糕(并且您将浪费更多资源来训练模型)。这就是为什么花费大量时间进行 EDA/领域探索如此重要的原因。这将有助于理解功能,并确保一切顺利进行。

该论文的作者测试了添加(随机)和删除无用(更正确 - 不太重要)特征时的模型性能。根据他们的结果,出现了两件有趣的事情——

- 删除大量功能缩小了模型之间的性能差距。这清楚地表明树的一大优势是它们能够免受较差特征的影响。

- 向数据集中添加随机特征表明,网络中的下降比基于树的方法要急剧得多。ResNet 尤其受到这些无用功能的打击。我假设变压器中的注意力机制在某种程度上保护了它。

树至上。需要注意的一件事是他们仅使用随机森林特征重要性。涉及更多协议来创建更好的特征准确度分数将使事情变得更好。

这种现象的一个可能的解释可能就是决策树的设计方式。任何学习过人工智能课程的人都会了解决策树中的信息增益和熵的概念。这些允许决策树通过比较剩余的特征来选择最佳的前进路径,以选择允许最佳选择的路径。对于那些不熟悉这个概念(或 RF)的人,我建议观看有关这些概念的 StatQuests 视频。我将他的指南链接到此处的 RandomForests。

回到正题,最后一件事使得 RF 在表格数据方面比 NN 表现更好。这就是旋转不变性。

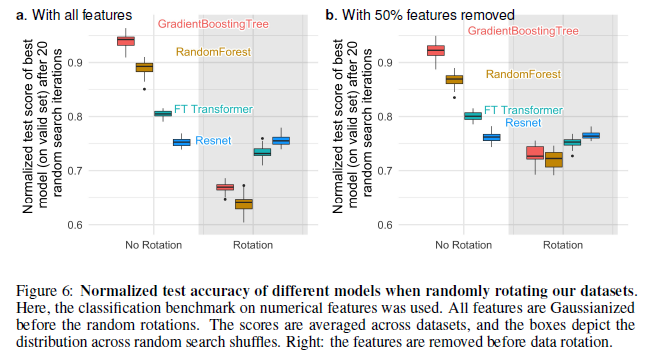

4.3 发现 3:神经网络对于旋转具有不变性。实际数据不是

神经网络对于旋转具有不变性。这意味着如果您旋转数据集,不会改变它们的性能。轮换数据集后,不同学习器的性能排名发生翻转,ResNet(最差)名列前茅。他们保持了原来的表现,而所有其他学习者实际上损失了相当多的表现。

这很有趣,但我必须了解更多。具体来说,旋转数据集实际上意味着什么?我翻阅了报纸,但找不到细节。我已经联系了作者并会写一篇后续文章。查看一些旋转数据集的示例将帮助我更好地理解这一发现的含义。如果你们有任何想法,请在评论中/通过我的链接与我分享。

同时,让我们看看为什么旋转方差很重要。根据作者的说法,采用特征的线性组合(这就是 ResNet 不变的原因)实际上可能会歪曲特征及其关系。

…存在一个自然基础(这里是原始基础),它编码最佳数据偏差,并且无法通过旋转不变的模型来恢复,旋转可能会混合具有非常不同的统计属性的特征

从性能下降来看,这显然是一个需要考虑的非常重要的因素。展望未来,我可以看到研究最佳数据方向的巨大价值。但在对此做出任何真正的评论之前,我想更多地了解这一点。过去 4 天我一直在努力了解这一点,但到目前为止(就像琼恩·雪诺一样),我一无所知。现在,我就先在这里结束事情吧。

如果您想进入机器学习领域,这篇文章将为您提供逐步提高机器学习能力的计划。它使用免费资源。与其他训练营/课程不同,该计划将帮助您发展基础技能,并为您在该领域取得长期成功做好准备。

对于机器学习来说,软件工程、数学和计算机科学的基础至关重要。它将帮助您概念化、构建和优化您的机器学习。我的每日时事通讯《技术访谈变得简单》涵盖了算法设计、数学、技术近期事件、软件工程等主题,旨在让您成为更好的开发人员。我目前全年提供 20% 的折扣,所以一定要检查一下。

我使用通过辅导多人进入顶级科技公司而发现的新技术创建了“技术面试变得简单” 。该时事通讯旨在帮助您取得成功,避免您在 Leetcode 苦苦挣扎中浪费时间。我有 100% 满意的政策,所以你可以毫无风险地尝试。您可以在此处阅读常见问题解答并了解更多信息

如果您对我有任何有趣的工作/项目/想法,请随时与我联系。总是很高兴听到你的声音。

Devansh-机器学习变得简单

![[echarts] 两侧堆叠柱状图](https://img-blog.csdnimg.cn/8f4ecb451db649a5a8769b4402b47395.png)

![计算机视觉与深度学习-卷积神经网络-纹理表示卷积神经网络-纹理表示-[北邮鲁鹏]](https://img-blog.csdnimg.cn/759031e1316e495e99808c0728f83ee3.png)

![[Vue] 绑定下拉菜单](https://img-blog.csdnimg.cn/c3c3a0b89eef47ff8737093f906aa424.png)