文章目录

- 利用Java编写程序访问HDFS

- 1、创建Maven项目

- 2、添加相关依赖

- 3、创建日志属性文件

- 4、启动集群HDFS服务

- 5、在HDFS上创建文件

利用Java编写程序访问HDFS

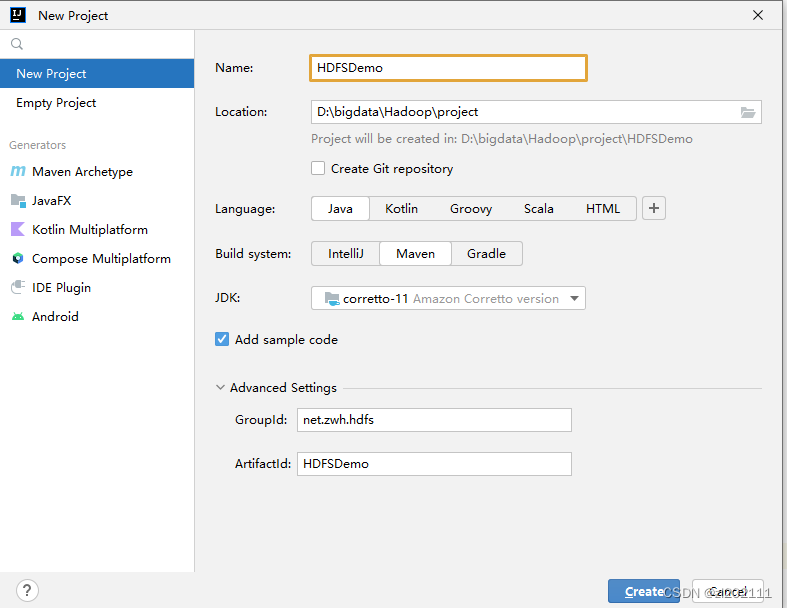

1、创建Maven项目

-

创建Maven项目 - HDFSDemo

-

单击【Create】按钮

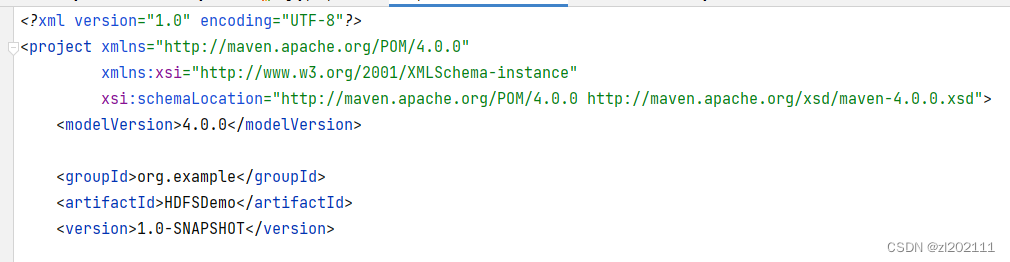

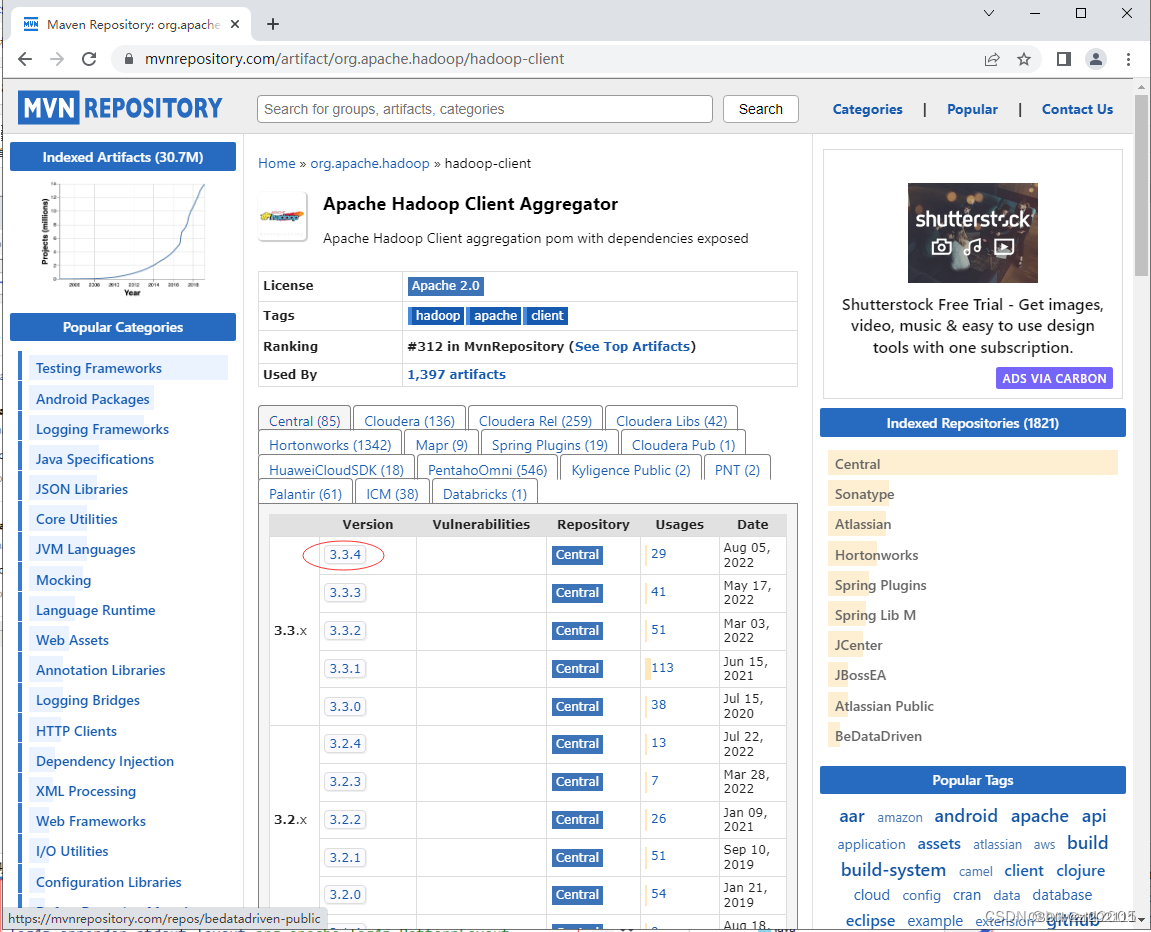

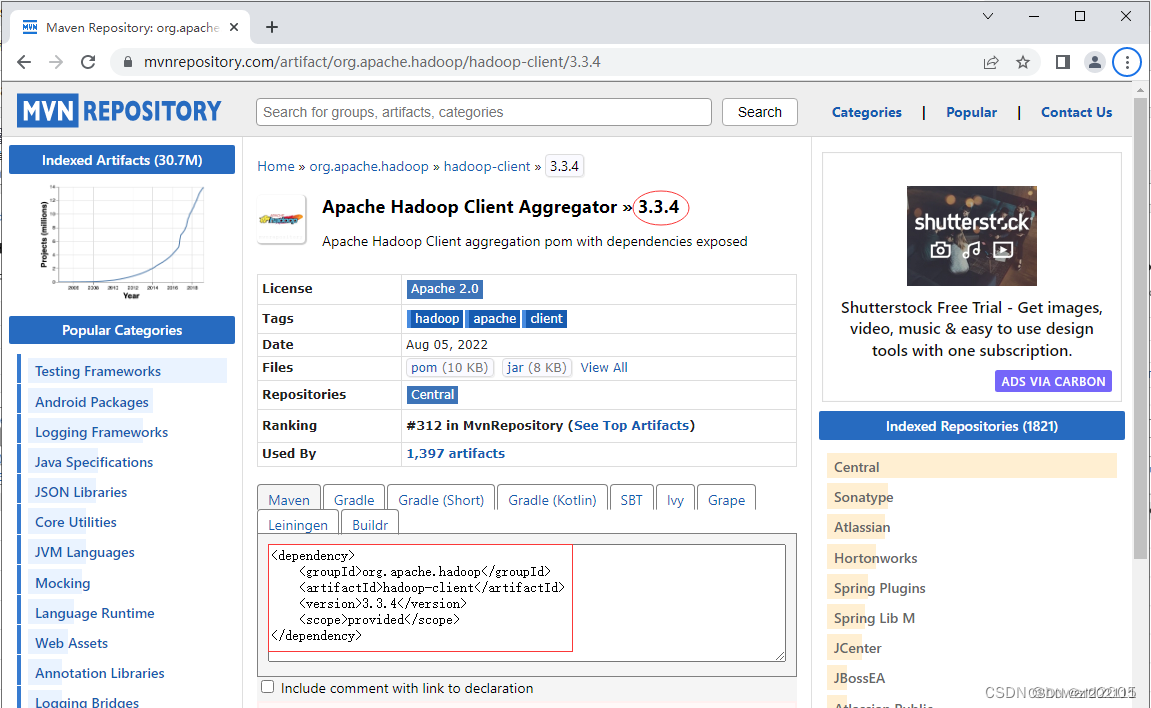

2、添加相关依赖

- 在

pom.xml文件里添加hadoop和junit依赖

<dependencies>

<!--hadoop客户端-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

-

Maven Repository(Maven仓库)-https://mvnrepository.com/

-

搜索

hadoop

-

单击

hadoop-client超链接

-

单击

3.3.4超链接

3、创建日志属性文件

在resources目录里创建log4j.properties文件

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

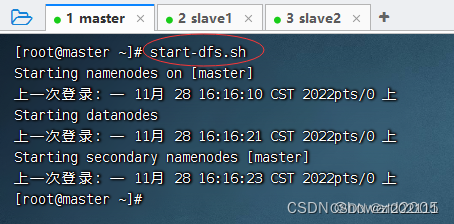

4、启动集群HDFS服务

-

在主节点上执行命令:

start-dfs.sh

-

在Hadoop WebUI界面查看

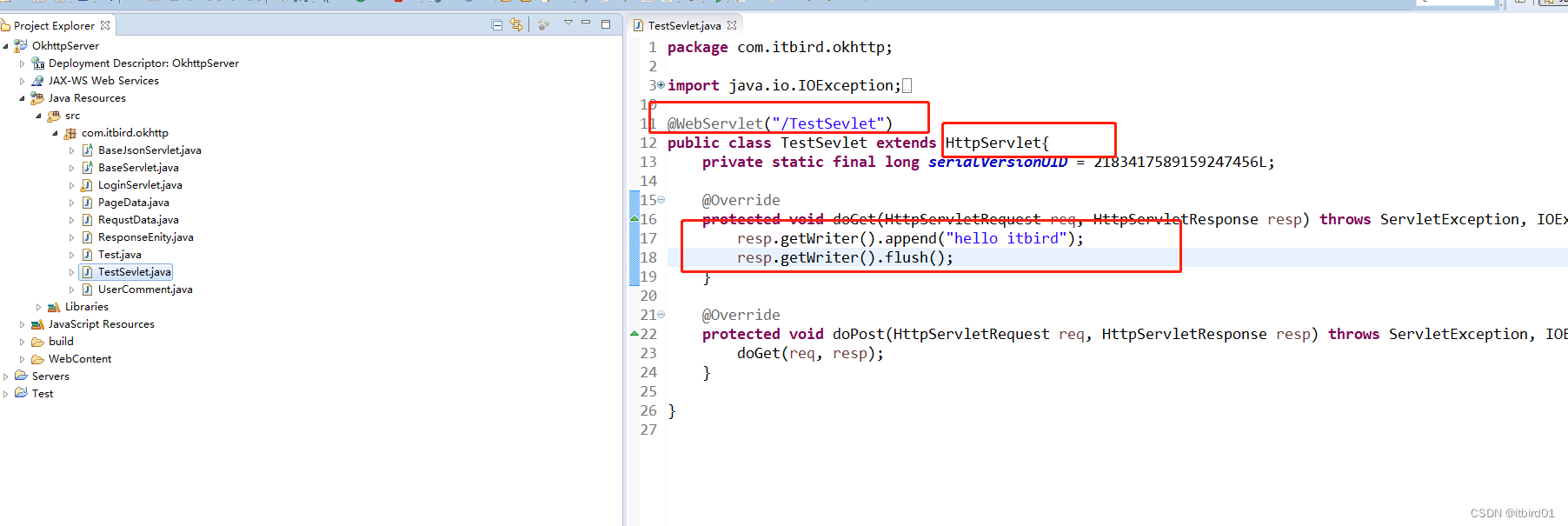

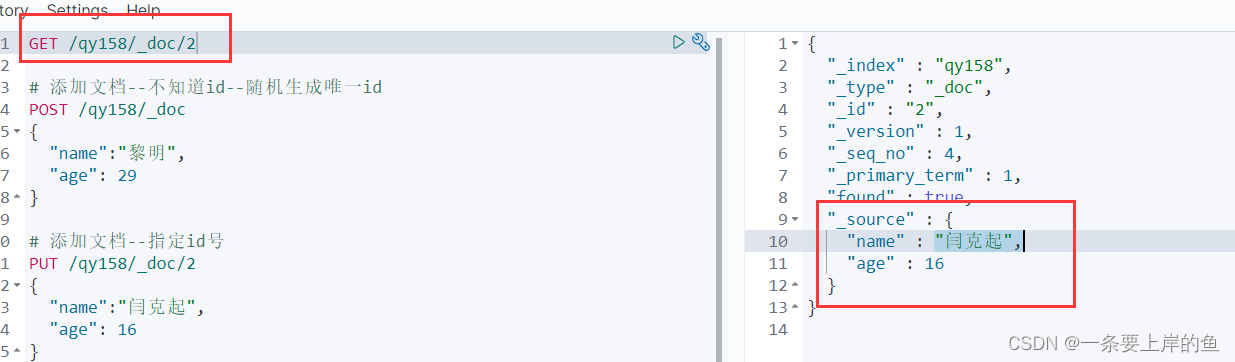

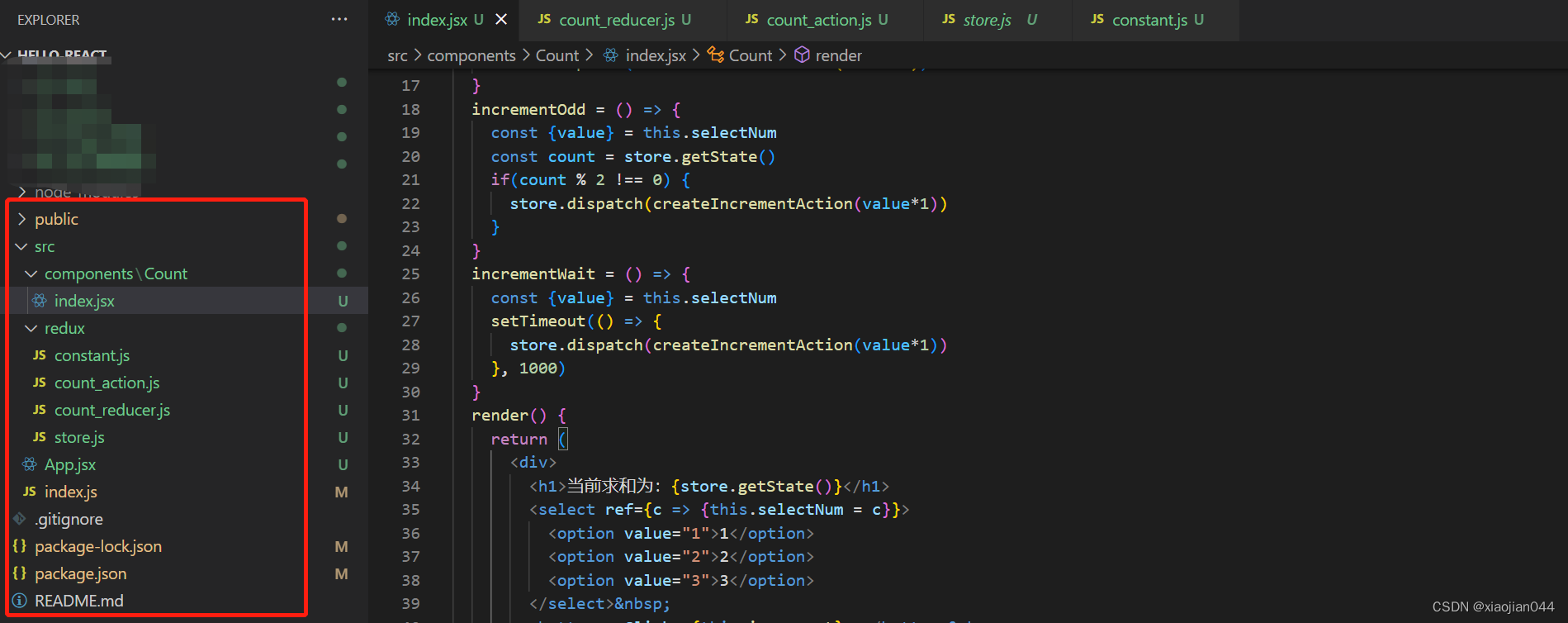

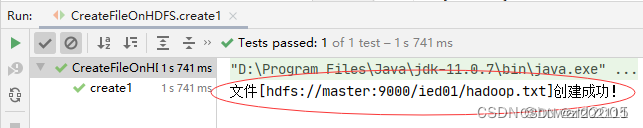

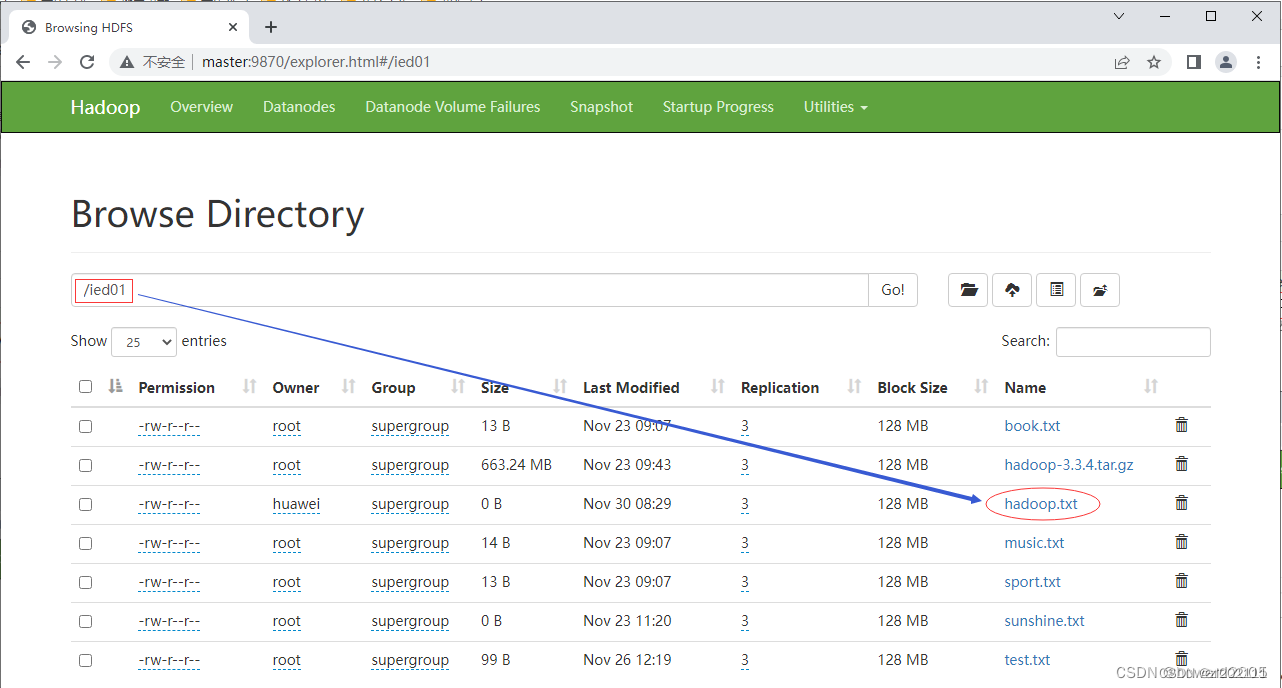

5、在HDFS上创建文件

-

在HDFS Shell里利用

hdfs dfs -touchz命令可以创建时间戳文件 -

在

/ied01目录创建hadoop.txt文件 -

创建

net.zwh.hdfs包,在包里创建CreateFileOnHDFS类 -

编写

create1()方法

package net.zwh.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

/**

* 功能:在HDFS上创建文件

*/

public class CreateFileOnHDFS {

@Test

public void create1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hadoop.txt");

// 基于路径对象创建文件

boolean result = fs.createNewFile(path);

// 根据返回值判断文件是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

}

}

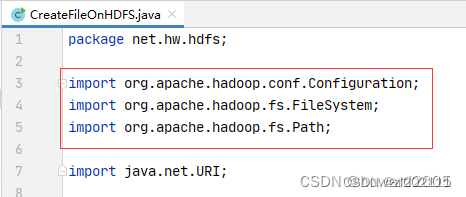

这里导包很容易出错

-

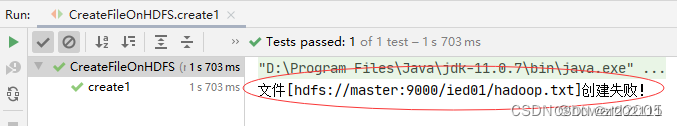

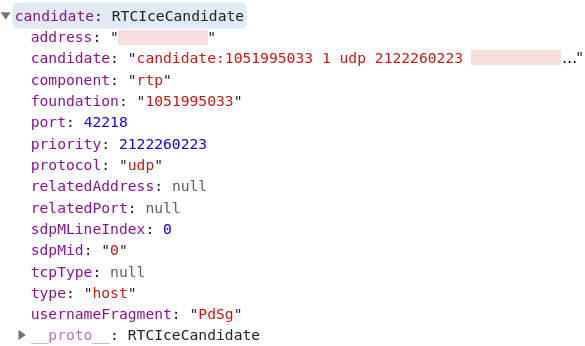

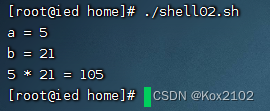

运行程序,查看结果

-

利用Hadoop WebUI查看

-

在

/ied01目录里确实创建了一个0字节的hadoop.txt文件,有点类似于Hadoop Shell里执行hdfs dfs -touchz /ied01/hadoop.txt命令的效果,但是有一点不同,hdfs dfs -touchz命令重复执行,不会失败,只是不断改变该文件的时间戳。

再次运行程序,由于hadoop.txt已经存在,此时会提示用户创建失败