提示:兜兜转转还是来到了C++,欠的债该还的得还,因此本篇文章试图从C++来撬动tensorrt 完成转换模型和推理,而不是借助python库

文章目录

- 前言

- 一、Tensorrt前置

- 1.1 Tensorrt基本概念

- 1.2 异步推演说明

- 二、实战YOLO V5推演

- 1.TensorRT模型转换

- 2.读入数据

- 总结

前言

提示:希望本篇文章结束后,我能回答两个问题:

- python不好用么,为什么还要转C++; yolov5的export.py 已经实现在python端的模型转化了啊?

不需要c++的可以看这个《【深度学习】目标检测 yolov5模型量化安装教程以及转ONXX,torchscript,engine和速度比较一栏表》 - C++的学习曲线那么陡峭,性能在服务器端不如go,所以为什么不是go?

go 在服务器端性能牛,但是在终端设备不咋样,所以从这个角度,还是C++

提示:以下是本篇文章正文内容,下面案例可供参考

一、Tensorrt前置

首先需要有个环境,搭建环境的指引《【深度学习】基于深度学习的linux服务器,需要搭建哪些服务,一步步搭建深度学习的环境,cuda,pytorch,opencv,ftp服务, nfs服务 docker等等》

文章很长,是深度学习的最大化安装,基于进入Tensorrt的操作,至少要安装显卡驱动,cuda,cudann,tensorrt,gpu的torch环境,并且他们之间的版本要匹配。老实说,新手直接绕道《【深度学习】目标检测 yolov5模型量化安装教程以及转ONXX,torchscript,engine和速度比较一栏表》

1.1 Tensorrt基本概念

本章节你将了解TensorRT中的以下几个关键概念:Runtime、CudaEngine、ExecutionContext、与Binding。

在使用ONNX Runtime的Python API执行模型推演大致分四步:

-

初始化:使用onnx格式存储的模型文件初始化 InferenceSession 。

-

预处理:将输入数据做预处理。

-

执行推演:调用 run 方法执行模型推演,获得模型输出。

-

后处理:执行后处理逻辑。

TensorRT的推演与其类似,只是要更加复杂一些: -

模型准备:TensorRT使用私有模型格式,其它格式的模型文件如ONNX需要先完成转换才可以被使用。该转换过程可以通过调 用TensorRT的C++或者Python API来在线实现,也可以通过 trtexec 这个工具离线完成。

-

初始化:包括初始化运行时 Runtime ,使用 Runtime 加载模型文件形成 CudaEngine ,再基于 CudaEngine 创建 ExecutionContext ;这三者组合起来可以大致等同为 ONNX Runtime中的 InferenceSession 。此外还需要按照模型的输入与输出规格分别申请CPU一侧的内存与GPU一侧的显存,指向这些存储区域的指针集合称为 Binding 。

-

将输入数据做预处理,然后将其从CPU侧存储(内存)拷贝到GPU侧存储(显存)。

-

调用 ExecutionContext 的enqueueV2 方法异步执行模型推演,然后调用 cudaStreamSynchronize 方法同步结果,获得模型输出。

-

将输出结果从GPU侧存储(显存)拷贝到CPU侧存储(内存),然后执行后处理逻辑。

1.2 异步推演说明

TensorRT支持同步与异步推演,这里以异步推演作为说明实例。

与ONNX Runtime Python API的推演流程相比,TensorRT C++ API推演明显有着更加底层、更加细粒度的数据与流程控制。这些正是使用C++作为开发语言与Python相比所带来的主要区别。

接下来,你将通过YOLO v5这个实例来掌握TensorRT的实际使用过程。本章节所涉及到的概念都会出现在代码中,希望到时候你看到它们时不会感觉太陌生。

二、实战YOLO V5推演

本章节你将借助YOLO v5模型推演的完整代码掌握TensorRT C++ 推演API,以及将ONNX格式神经网络模型转换为TensorRT专用格式的具体方法。

YOLO v5是一款在物体检测领域颇为流行的神经网络模型。在这里我们不会深入探究其原理与设计,而将直接使用GitHub上的一款开源实现所生成的预训练模型。在此基础上,本章节展示了以下内容。

- 使用TensorRT的 trtexec 工具将ONNX模型文件转换为TensorRT的Engine格式。

- 使用CMake构建TensorRT工程。

- 使用OpenCV实现输入图像读取与存储。

- YOLO v5模型预处理与后处理。

- 使用TensorRT实现YOLO v5模型推演。

让我们开始吧!

1.TensorRT模型转换

首先下载YOLO v5预训练好的模型权重文件,其地址为:

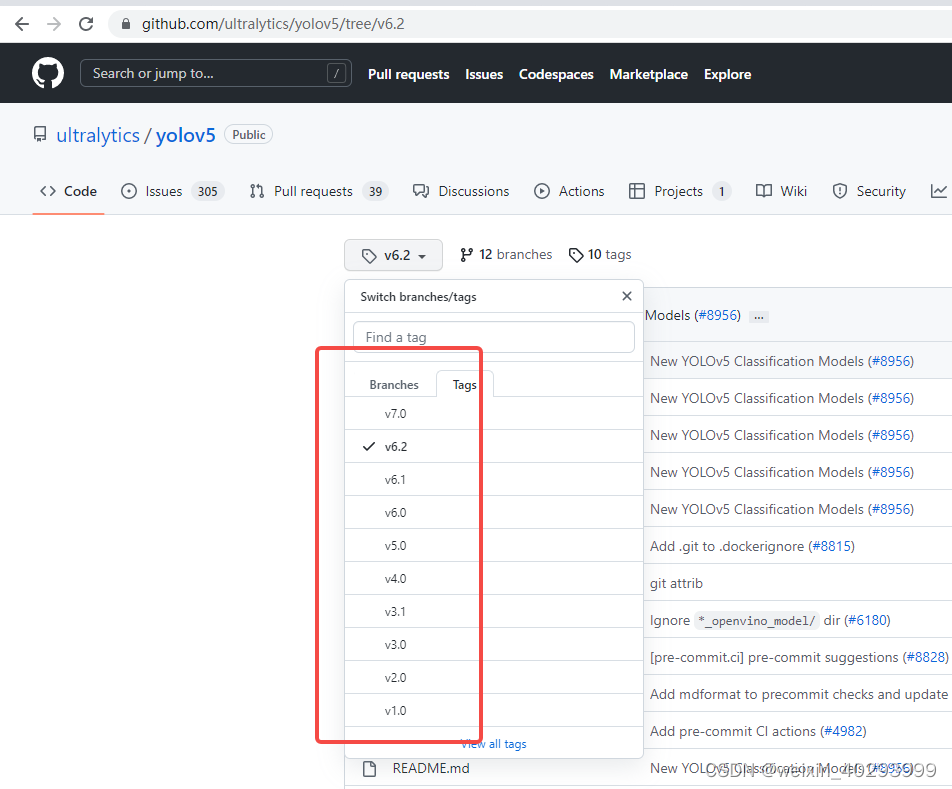

https://github.com/ultralytics/yolov5/releases/download/v6.1/yolov5s.pt

然后遵循官方教程,导出ONNX格式模型:

代码如下(示例):

在写一次吧,安装

pip install -r requirements.txt coremltools onnx onnx-simplifier onnxruntime-gpu openvino-dev tensorflow # GPU

其实只需要onnx相关的,其它的有tf使用的,apple使用的opencv使用的,用不到 ,我这里偷个懒,安装少的

pip install -r requirements.txt onnx onnxruntime-gpu # GPU

上边这一步完成后,你应当获得一个ONNX格式模型文件 yolov5s.onnx 。

转换一版试一下:

python export.py --weights weights/yolov5s.pt -- --include onnx engine

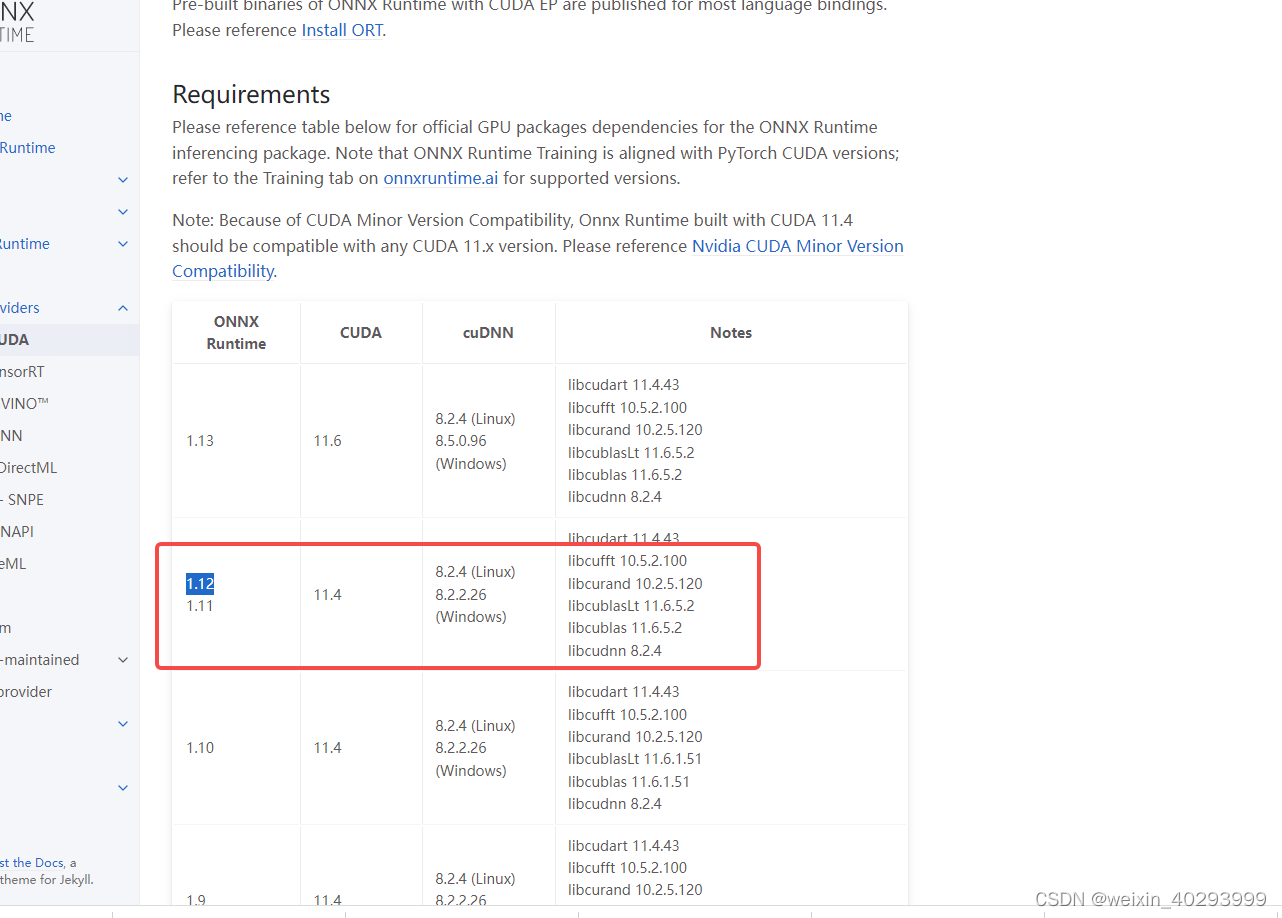

转化报错,原因是:https://onnxruntime.ai/docs/execution-providers/CUDA-ExecutionProvider.html,默认安装的1.13,匹配11.6的吗我的是11.4,换回来重新运行

接下来,使用如下命令将其转换为TensoRT格式模型文件。

还是报错

[8] Assertion failed: scales.is_weights() && "Resize scales must be an initializer!"

TensorRT: export failure ❌ 4.3s: failed to load ONNX file: weights/yolov5s.onnx

解决问题指引:

https://blog.csdn.net/zaf0516/article/details/122932651

snap install netron

pip install onnx-simplifier

pip install onnx_graphsurgeon --index-url https://pypi.ngc.nvidia.com

还是报错:

指引是改模型,我偷个懒,退一下版本 yolov5 tag6.2搞下来试一试,现在用的是最新的用于分割的tag7.0

都是相同的错误,先不改了,直接转onnx是可以的

python export.py --weights weights/yolov5s.pt --device 0 --include onnx

切換到6.1 上面報錯,解決指引

https://blog.csdn.net/Thebest_jack/article/details/124723687

然后转换engine

trtexec --onnx=weights/yolov5s.onnx --saveEngine=yolov5s.engine

问题出来了,不管用7.0 还是 6.1, 6.2 都报错

[12/07/2022-20:49:09] [E] [TRT] ModelImporter.cpp:776: --- End node ---

[12/07/2022-20:49:09] [E] [TRT] ModelImporter.cpp:779: ERROR: builtin_op_importers.cpp:3609 In function importResize:

[8] Assertion failed: scales.is_weights() && "Resize scales must be an initializer!"

[12/07/2022-20:49:09] [E] Failed to parse onnx file

[12/07/2022-20:49:09] [I] Finish parsing network model

[12/07/2022-20:49:09] [E] Parsing model failed

[12/07/2022-20:49:09] [E] Failed to create engine from model.

[12/07/2022-20:49:09] [E] Engine set up failed

&&&& FAILED TensorRT.trtexec [TensorRT v8205] # trtexec --onnx=weights/yolov5s.onnx --saveEngine=yolov5s.engine

python 命令和trtexec命令都报错

trtexec --onnx=weights/yolov5s.onnx --saveEngine=yolov5s.engine

[12/07/2022-20:53:43] [E] [TRT] ModelImporter.cpp:776: --- End node ---

[12/07/2022-20:53:43] [E] [TRT] ModelImporter.cpp:779: ERROR: builtin_op_importers.cpp:3609 In function importResize:

[8] Assertion failed: scales.is_weights() && "Resize scales must be an initializer!"

[12/07/2022-20:53:43] [E] Failed to parse onnx file

[12/07/2022-20:53:43] [I] Finish parsing network model

[12/07/2022-20:53:43] [E] Parsing model failed

[12/07/2022-20:53:43] [E] Failed to create engine from model.

[12/07/2022-20:53:43] [E] Engine set up failed

&&&& FAILED TensorRT.trtexec [TensorRT v8205] # trtexec --onnx=weights/yolov5s.onnx --saveEngine=yolov5s.engine

python export.py --weights weights/yolov5s.pt --device 0 --include onnx engine

所以要替换模型了,明天见!

2.读入数据

代码如下(示例):

data = pd.read_csv(

'https://labfile.oss.aliyuncs.com/courses/1283/adult.data.csv')

print(data.head())

该处使用的url网络请求的数据。

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。

![[附源码]JAVA毕业设计体检系统(系统+LW)](https://img-blog.csdnimg.cn/7c2f1352fa2d46859dfd0c7149f7fb61.png)

![[论文解析] HeadNeRF: A Realtime NeRF-based Parametric Head Model](https://img-blog.csdnimg.cn/d74f02afb29944c192942102f90f7066.png)

![[附源码]计算机毕业设计JAVA中达小区物业管理系统](https://img-blog.csdnimg.cn/7fbe4f764ddb471d8fb9128812b2faa0.png)