文章目录

- NodeFormer: A Scalable Graph Structure Learning Transformer for Node Classification

- Abstract

- 方法

- General Model and Key Challenges

- Efficient Learning Discrete Structures

- 可微随机结构学习

- Input Structures as Relational Bias

- Learning Objective

NodeFormer: A Scalable Graph Structure Learning Transformer for Node Classification

Abstract

图神经网络已经被广泛研究用于利用互连数据进行学习。尽管如此,最近的证据表明,GNN的缺陷与过度挤压、异质性、处理长程依赖性、边缘不完全性有关,尤其是完全没有图。虽然一个合理的解决方案是学习用于消息传递的新的自适应拓扑,但有关二次复杂性的问题阻碍了在大型网络中同时保证可扩展性和精度。

本文方法

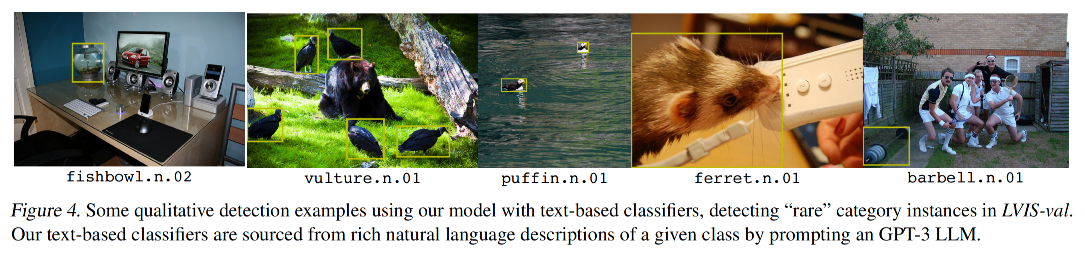

- 介绍了一种新的全对消息传递方案,用于在任意节点之间有效传播节点信号,作为用于大型图上节点分类的开创性Transformer型网络的重要构建块

- 有效的计算是通过核化的Gumbel-Softmax算子实现的,该算子将算法复杂度降低到线性节点数,用于以可微的方式从大的、潜在的全连通图学习潜在图结构。

- 还提供了相应的理论作为我们设计的理由。

代码地址

方法

General Model and Key Challenges

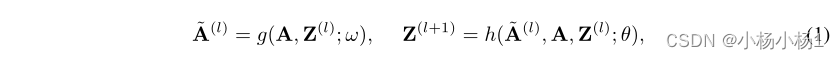

首先观察到,输入结构可能不是在节点之间传播信号的理想结构,相反,存在一些潜在的结构,可以帮助学习更好的节点表示。因此,我们考虑更新规则

Z:结点表征

A:l层潜在图

可能使消息能够在每一层中的任何节点对之间传递,然而,这带来了两个挑战:

1.(可伸缩性):如何降低学习新图时令人望而却步的二次复杂度?

2.(可微性):如何实现离散结构的端到端可微优化?

请注意,第一个挑战在节点级预测任务中是不平凡的(我们论文的重点),因为潜在图可能连接所有实例节点(例如,根据数据集的大小,从数千到数百万),这很难保证精度和可扩展性。

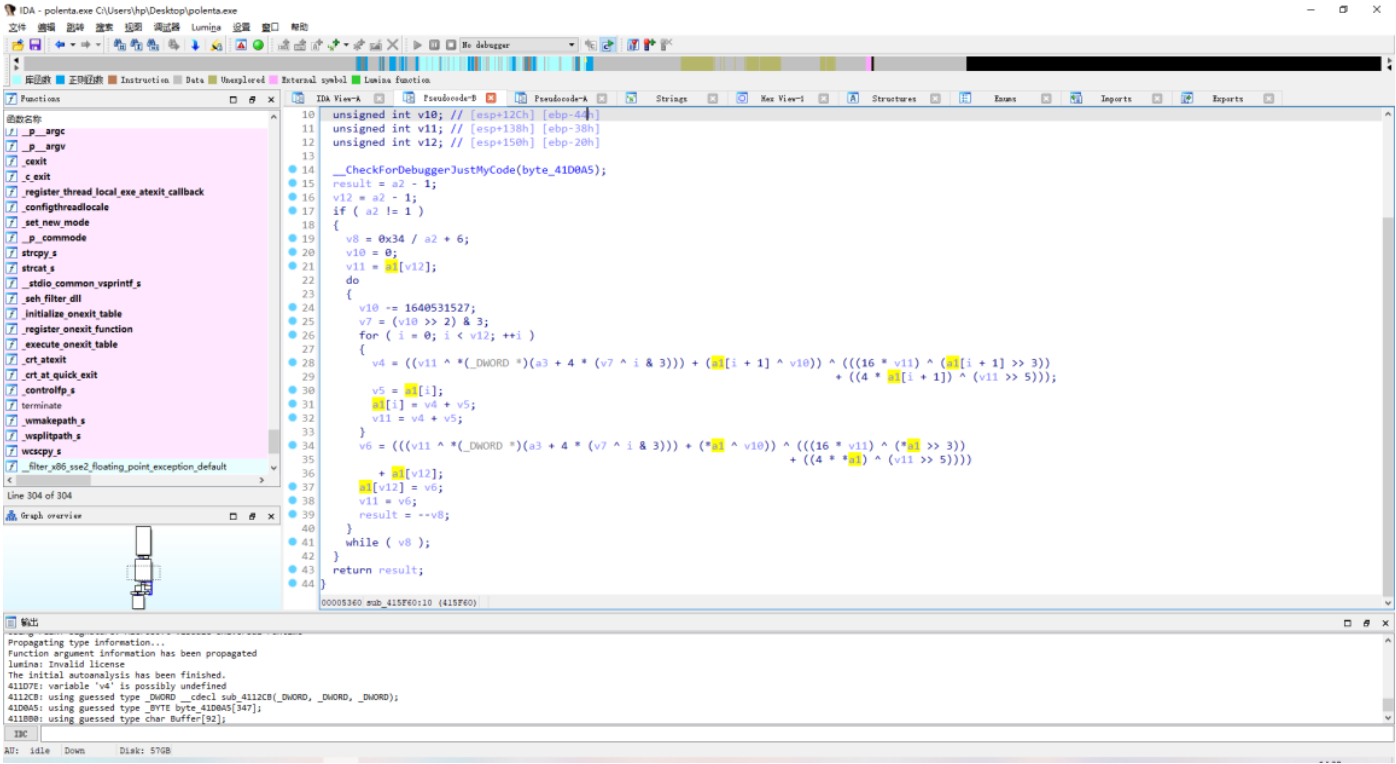

Efficient Learning Discrete Structures

我们用一个高效的内核化Gumbel-Softmax算子描述了我们的新消息传递方案,以解决上述挑战。我们假设z(0)u=xu作为初始节点表示

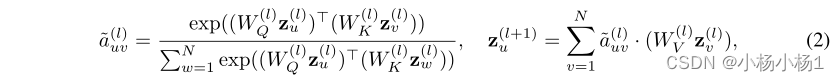

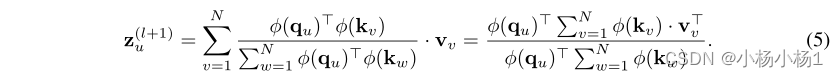

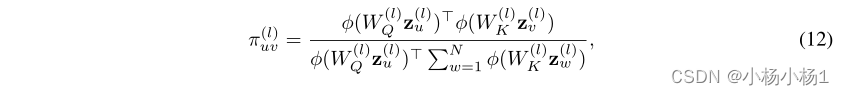

内核化消息传递。我们定义了一个全图关注网络,该网络估计实例节点之间的潜在交互,并实现相应的密集连接消息传递:

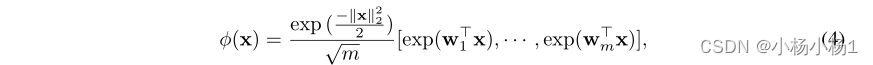

正随机特征(PRF)

可微随机结构学习

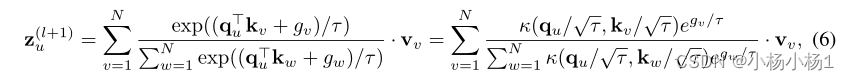

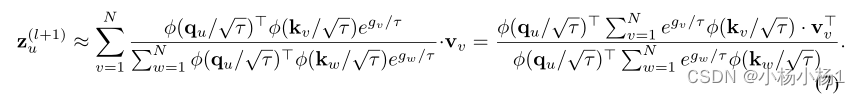

难点在于如何实现离散图结构的可微优化。原则上,我们可以对每个节点的分类分布进行多次采样,以获得其邻居。然而,采样过程会引入不连续性并阻碍反向传播。幸运的是,我们注意到方程。可以被修改以结合重新参数化技巧以允许可微分学习:

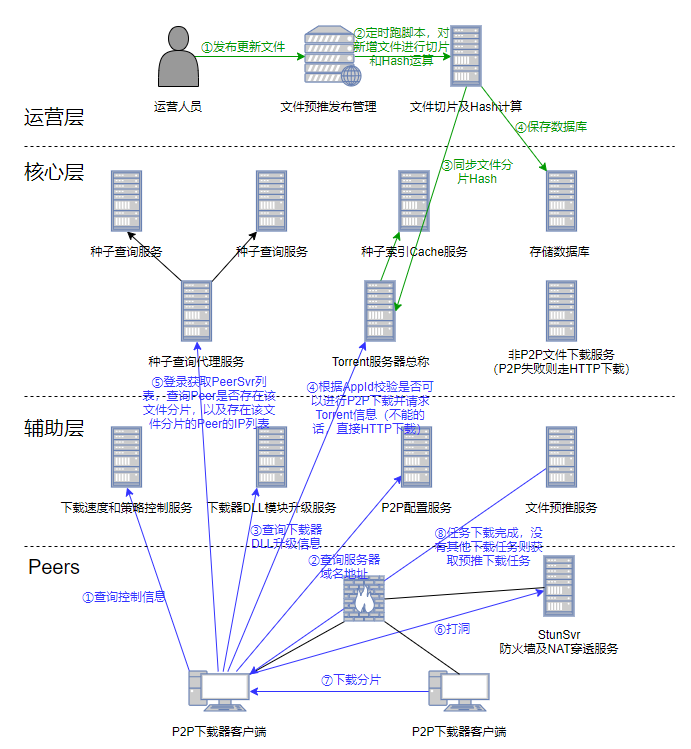

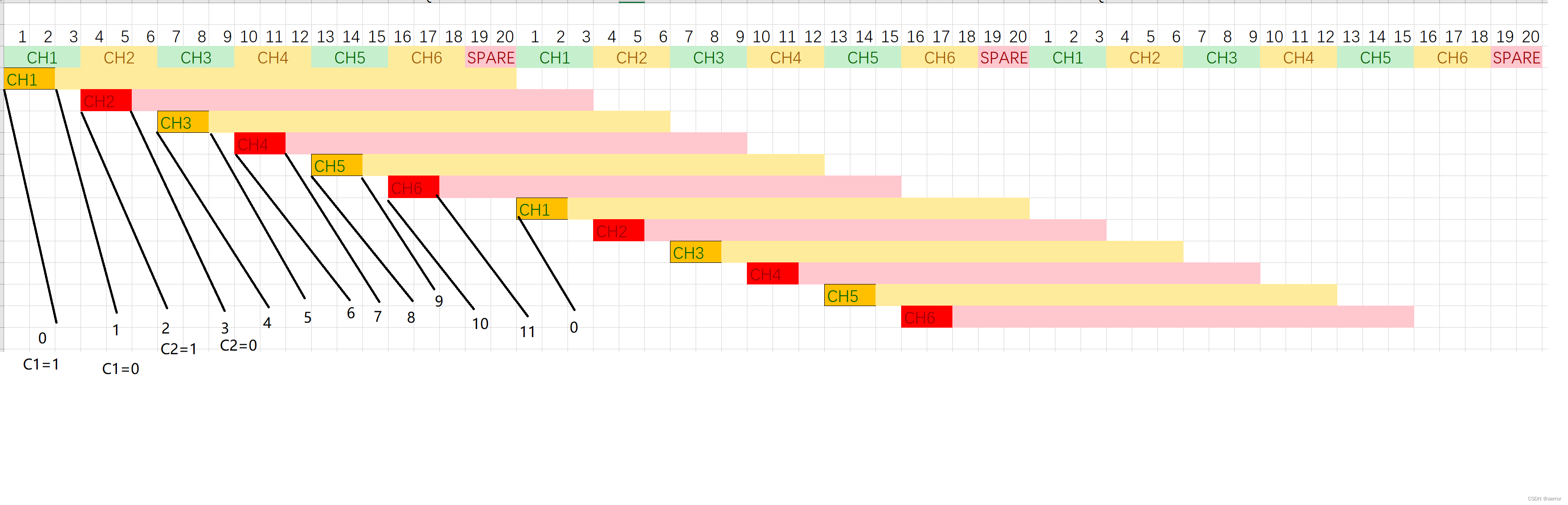

Input Structures as Relational Bias

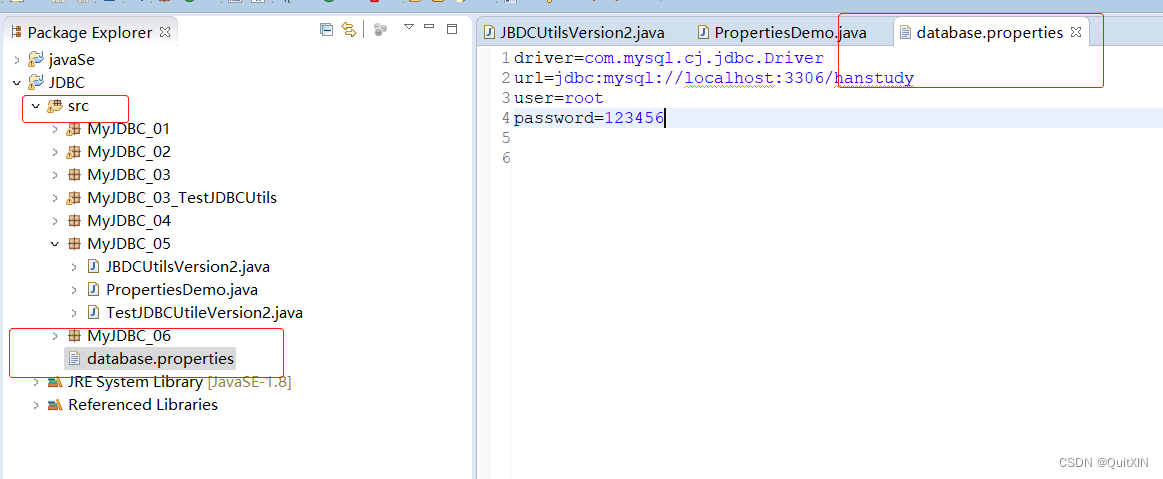

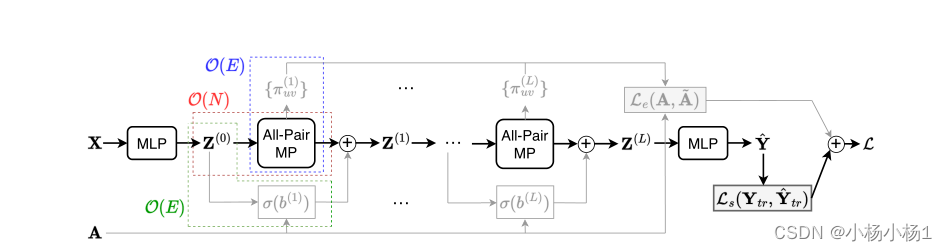

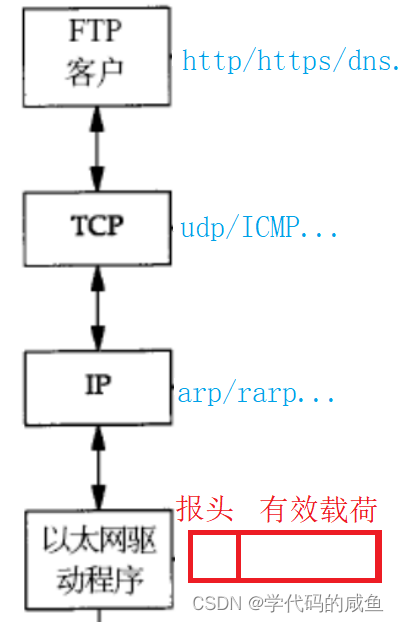

以节点嵌入矩阵X和(可选)图邻接矩阵A为输入的NODEFORMER的数据流示意图。NODEFORMER中有三个组件。

第一个是全对消息传递(MP)模块(红色),它采用我们提出的核化Gumbel-Softmax算子来更新每层中具有O(N)复杂度的节点嵌入。

根据输入图的可用性,其他两个组成部分是可选的:

1)关系偏差(绿色),它增强了观察到的边上的传播权重;

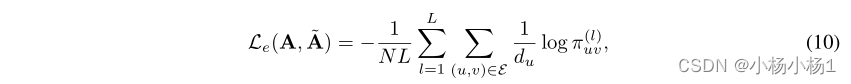

2) 边缘正则化损失(蓝色),旨在最大化观测到的边缘的概率。这两个组成部分需要O(E)的复杂性。最终训练损失L是标准监督分类损失和边缘正则化损失的加权和

Learning Objective

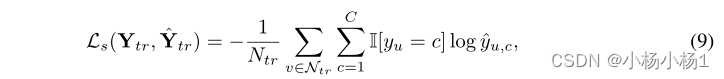

给定训练标签Ytr={yu}u∈Ntr,其中Ntr表示标记节点的集合,通常的做法是最大化观测数据日志的可能性,这会产生监督损失(使用C类)

![[unity]Pico VR unity开发笔记(一)](https://img-blog.csdnimg.cn/img_convert/7821a2edf89c89d623f2a5c812ec3755.png)