文章目录

- pytorch中Dataloader读取数据太慢的问题

- 1. 方法

- 2. 方法

- 3. 解决方法:提取加载数据

pytorch中Dataloader读取数据太慢的问题

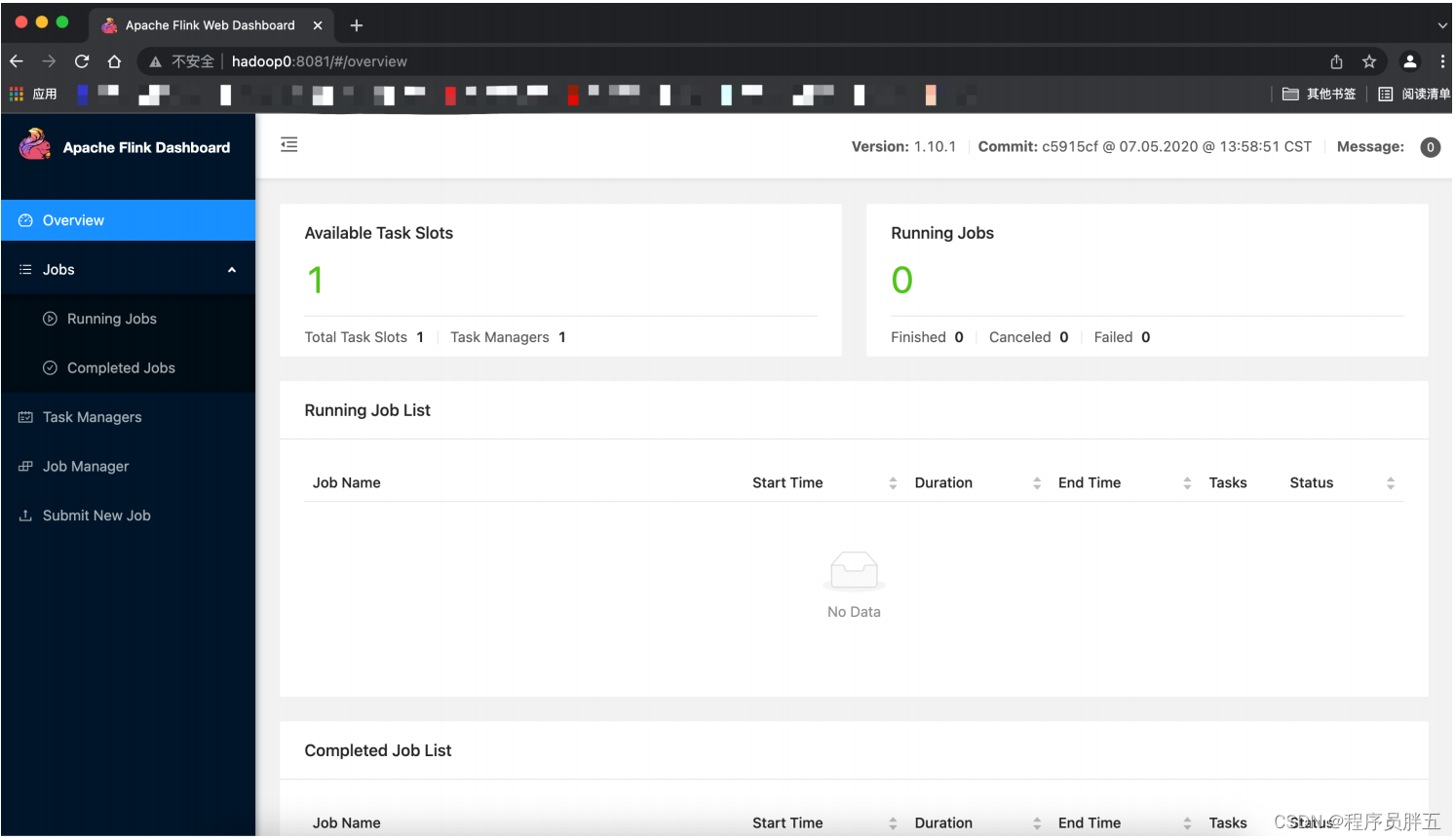

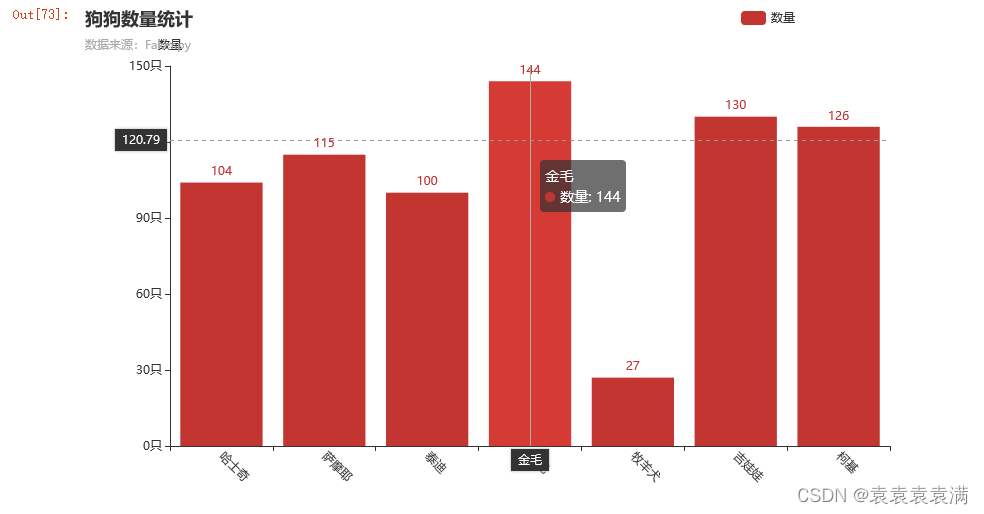

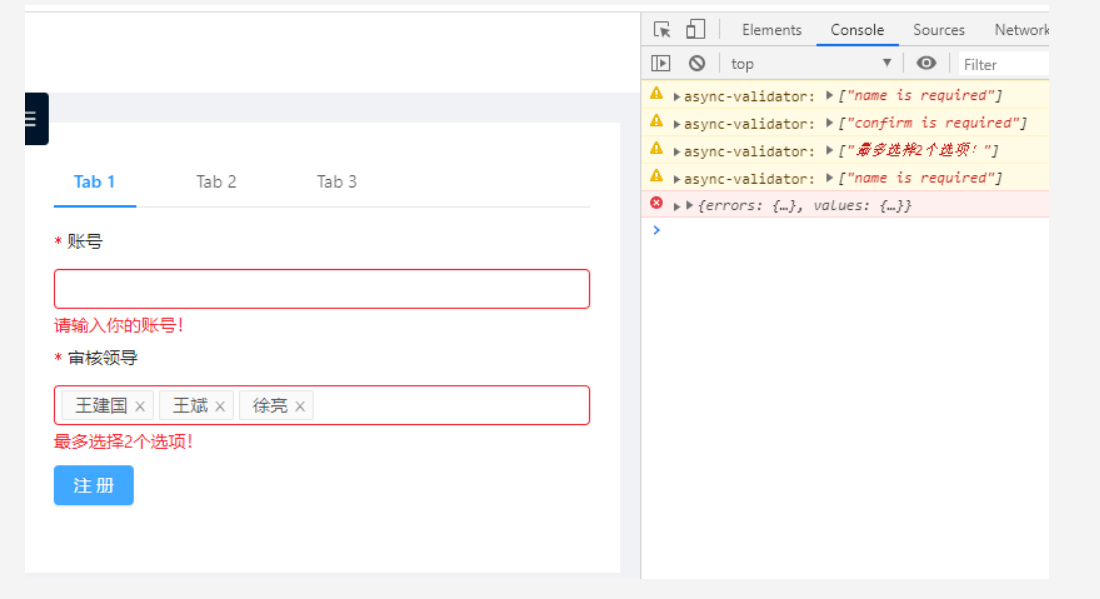

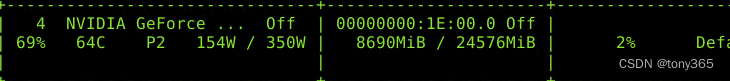

数据读取的速度远远大于GPU训练的速度,导致整个训练流程中有大部分时间都在等待数据发送到GPU,在资源管理器中呈现出CUDA使用率周期性波动,且大部分时间都是在等待数据加载。

cuda使用率可能很低或者为0:

1. 方法

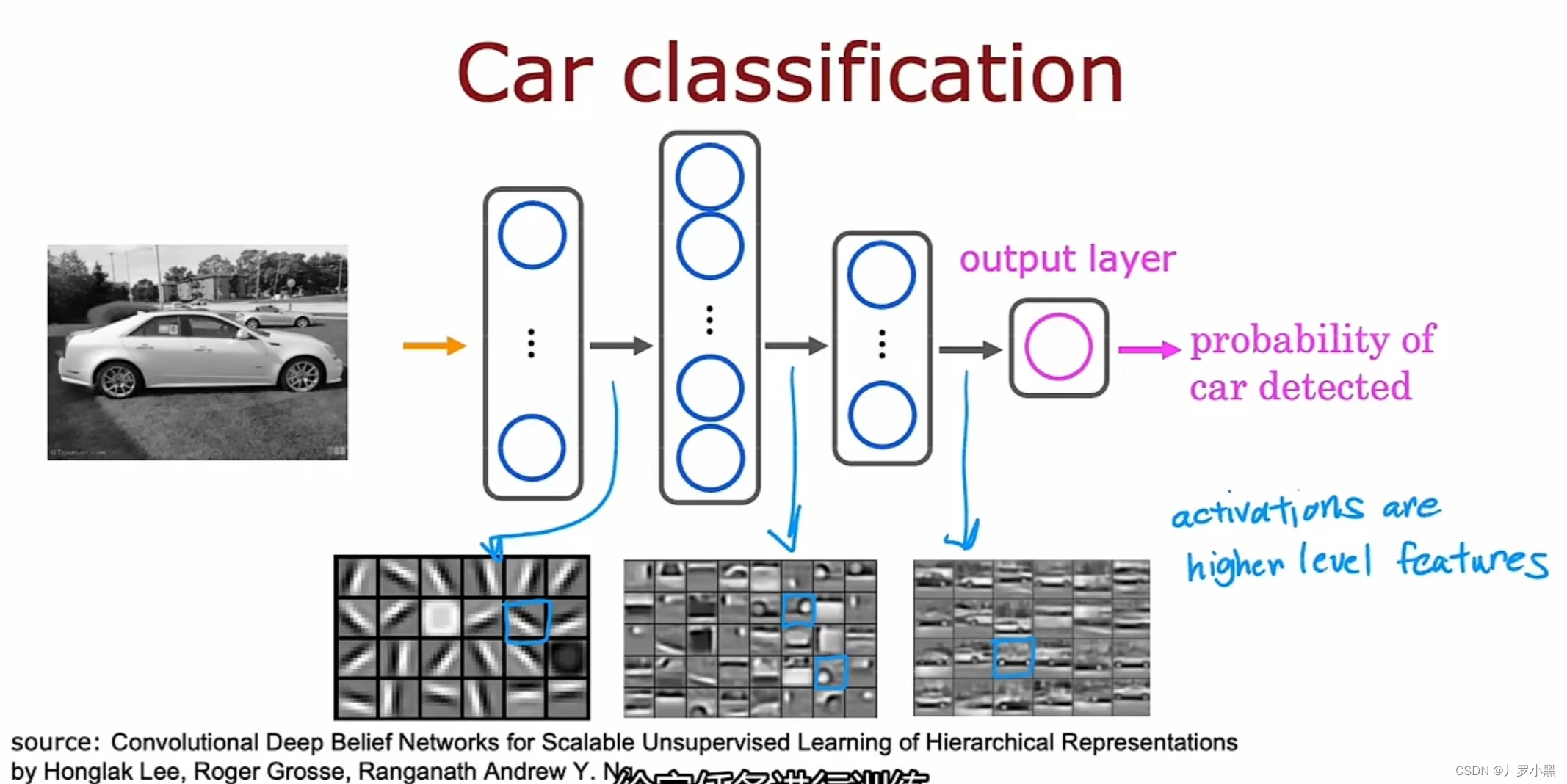

在dataset中,会将数据从磁盘读入内存中,如果启用了dataloader中的pin_memory,就会让数据常驻内存,同时设置num_workers还能实现多进程读取数据,但即使设置了这些,数据加载速度依然没有质的提升。

2. 方法

dataset中的transform是导致性能慢的一个原因,dataset中有个函数为__getitem__,每获取一个数据就会让这个数据过一次transform。

transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.ToTensor(),

transforms.Normalize([0.4914, 0.4822, 0.4465], [0.5, 0.5, 0.5])

])

如果把__getitem__中的一些操作移到 __init__中。

这样__getitem__直接取索引即可。

3. 解决方法:提取加载数据

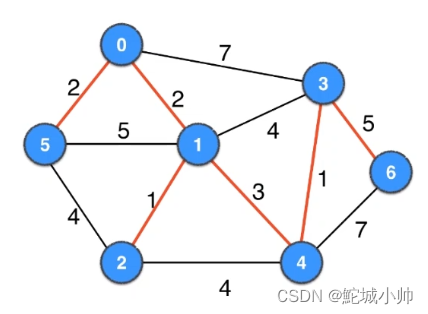

编写datast的__init__函数的时候

1)提前加载所有数据到cpu

2)或者提前加载所有数据 直接加载到GPU:这个要求显存够大

3)__get_item__项目尽量少,尽量再1,2步预处理数据中完成。

4)存大图降低存取次数

很好的博客:https://blog.csdn.net/Twilightzsj/article/details/123941780

https://www.cnblogs.com/pprp/p/14199865.html

https://blog.csdn.net/qq_42255269/article/details/127528662