Flink 集群安装

1. 单机版 Flink 安装与使用

1、下载 Flink 安装包并上传至服务器

- 下载 flink-1.10.1-bin-scala_2.11.tgz 并上传至

Hadoop0 /software下

2、解压

[root@hadoop0 software]# tar -zxvf flink-1.10.1-bin-scala_2.11.tgz

3、创建快捷方式

[root@hadoop0 software]# ln -s flink-1.10.1 flink

4、配置环境变量

vi /etc/profile

# 将下边两行配置信息添加到文件末尾

export FLINK_HOME=/software/flink-1.10.1

export PATH=$PATH:$FLINK_HOME/bin

# 然后 source 下使环境变量配置文件生效

source /etc/profile

5、启动

[root@hadoop0 ~]# cd /software/flink-1.10.1/bin/

[root@hadoop0 bin]# start-cluster.sh # 停止用 stop-cluster.sh

Starting cluster.

Starting standalonesession daemon on host hadoop0.

Starting taskexecutor daemon on host hadoop0.

[root@hadoop0 bin]# jps

8243 StandaloneSessionClusterEntrypoint

8568 TaskManagerRunner

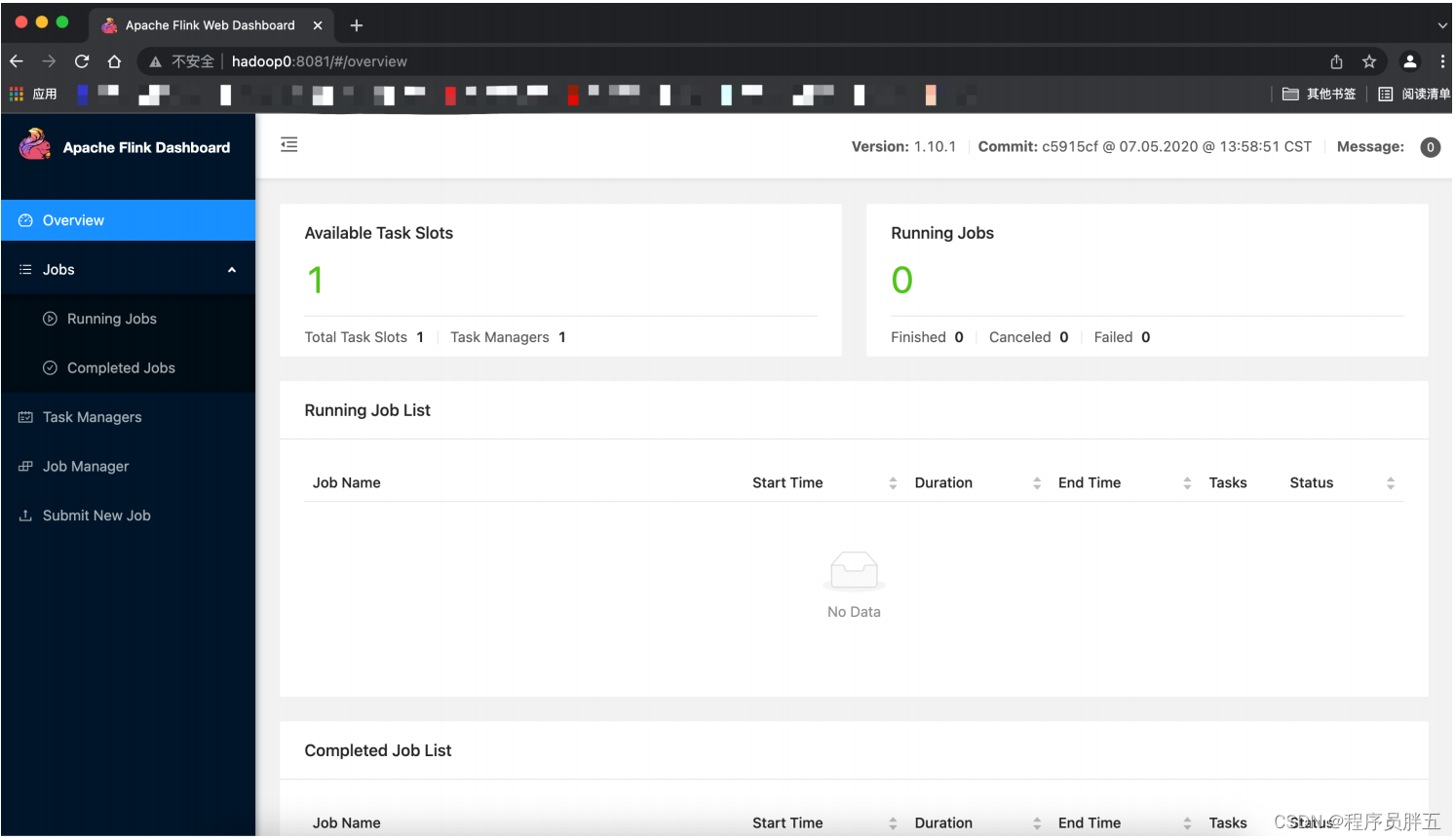

6、页面查看:hadoop0:8081

2. Standalone 模式安装

1、集群规划

| 主机名 | JobManager | TaskManager |

|---|---|---|

| hadoop1 | 是 | 是 |

| hadoop2 | 是 |

2、依赖

- jdk1.8以上,配置

JAVA_HOME - 主机之间免密登录

3、安装步骤

- 修改 conf/flink-conf.yaml

jobmanager.rpc.address:hadoop1

- 修改conf/salves

hadoop1

hadoop2

- 拷贝到其他节点

scp -rq /software/flink-1.10.1 hadoop2:/software/

- 在hadoop1(JobManager)节点启动

[root@hadoop1 ~]# cd /software/flink-1.10.1/bin/

[root@hadoop1 bin]# start-cluster.sh

Starting cluster.

Starting standalonesession daemon on host hadoop1.

Starting taskexecutor daemon on host hadoop1.

Starting taskexecutor daemon on host hadoop2.

[root@hadoop1 bin]# jps #查看Flink相关进程

12897 TaskManagerRunner

12548 StandaloneSessionClusterEntrypoint

[root@hadoop2 conf]# jps #查看Hadoop2上的进程

8278 TaskManagerRunner

- 访问页面:

http://hadoop1:8081

4、StandAlone模式需要考虑的参数

conf/flink-conf.yaml

| 参数 | 含义 |

|---|---|

| jobmanager.heap.mb | jobmanager节点可用的内存大小 |

| taskmanager.heap.mb | taskmanager节点可用的内存大小 |

| taskmanager.numberOfTaskSlots | 每台机器可用的CPU数量 |

| parallelism.default | 默认情况下任务的并行度 |

| taskmanager.tmp.dirs | taskmanager的临时数据存储目录 |

![深度学习应用篇-计算机视觉-图像分类[2]:LeNet、AlexNet、VGG、GoogleNet、DarkNet模型结构、实现、模型特点详细介绍](https://img-blog.csdnimg.cn/img_convert/e4242253915a2acbc6612fb5fcdf5b2c.png)