压缩-激励的宽残差网络在图像分类中的应用(ICIP 2019)

- 1. INTRODUCTION

- 2. PROPOSED METHODS

- 2.1 总体框架

- 2.2 通道的重要性

- 3. EXPERIMENTS

- 3.1 Datasets

- 3.2 训练和测试的设置

- 3.3 分类结果及分析

- 4. CONCLUSION

SQUEEZE-AND-EXCITATION WIDE RESIDUAL NETWORKS IN IMAGE CLASSIFICATION

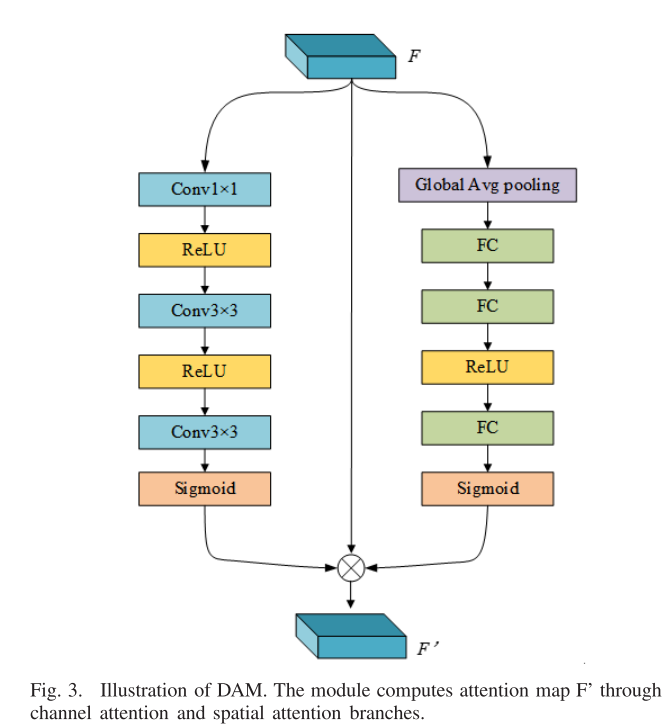

在昨天的论文中,DAM模块中右侧分支就是基于本文所提出的SE-block,今天来了解一下这个模块。

1. INTRODUCTION

宽残差网络(WRNs:Wide residual networks)表明,与增加残差网络深度相比,拓宽残差块(如果处理得当)可以更有效地提高残差网络的性能。

SE-WRNs可以增强信息通道并抑制不太有用的通道,SE-WRNs块是计算轻量级的,只略微增加模型复杂度和计算量。

SE-blocks中的全局平均池化会导致信息的丢失,因此我们提出了一个r(残差)SE-blocks块,将在后面的章节中介绍,我们的rSE-blocks在计算上也是轻量级的。

综上所述,我们的工作贡献如下:

(1 )我们提出了SE-WRNs。与WRNs仅仅增加通道数量不同,SE-WRNs增加了有效通道。为了避免过拟合,提出了一种带有dropout的SE-block块。

(2) 然后,我们提出了利用通道间关系提高图像分类性能的SE-WRNs-GVP(全局平均池化)算法。

(3) 为了避免SE-block中的信息丢失,提出了一种残差SE-block。

2. PROPOSED METHODS

2.1 总体框架

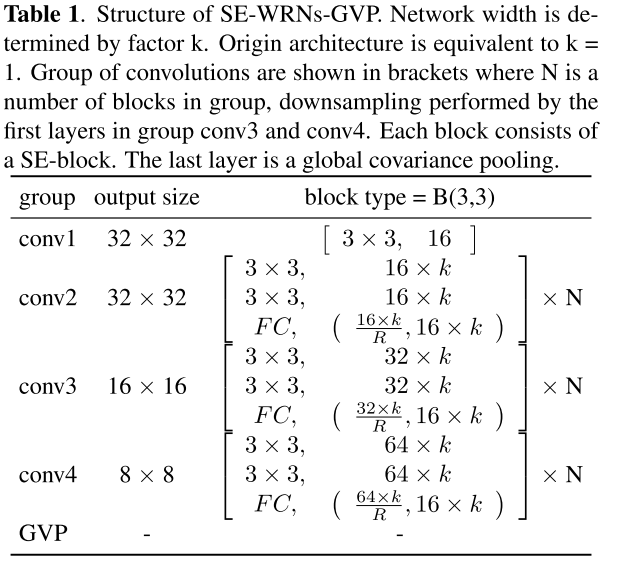

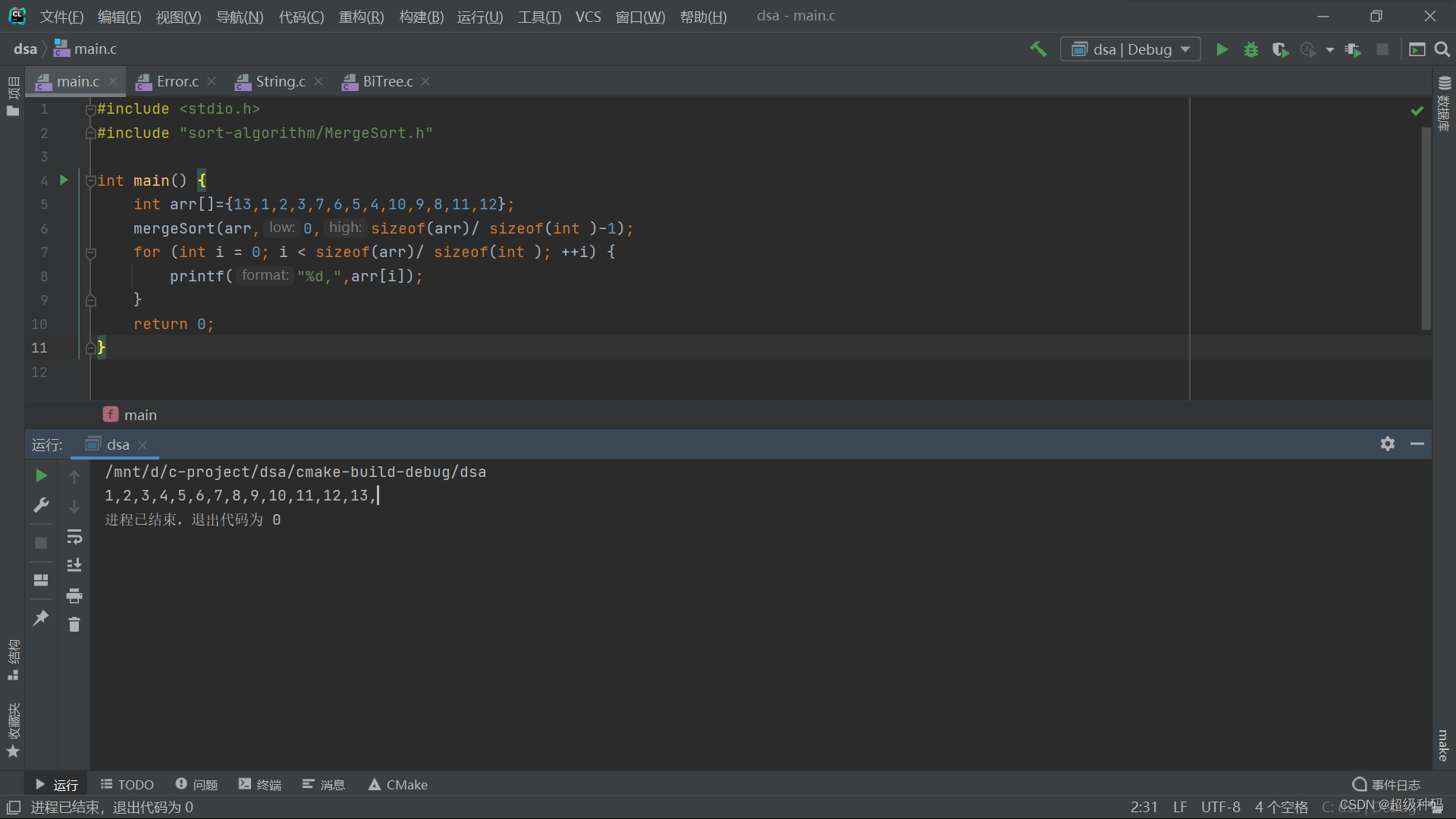

WRN已经证明基本残差结构的3 × 3卷积层中的每一层都是重要的,因此我们采用在WRN中的卷积类型。WRN-n-k表示具有卷积层总数n和加宽因子k的残差网络。其结构如表1所示。

GVP:全局平均池化 🎃

2.2 通道的重要性

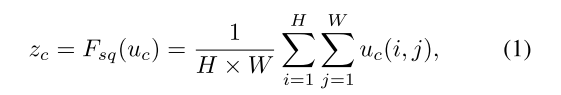

SE-WRN可以通过简单地堆叠一组SE构造块来生成。这些特征首先通过一个挤压操作(全局平均池化),该操作聚集空间维度H × W上的特征图以产生一个通道描述符。统计量z ∈ RC通过将U收缩到空间维度H ×W来生成,其中z的第c个计算公式为:

该描述符嵌入了信道特征响应的全局分布,使得来自网络的全局感受域的信息能够被其较低层利用。

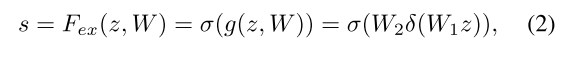

随后是激发操作,其中通过基于通道依赖性的自门控机制针对每个通道学习的样本特异性激活控制每个通道的激发。

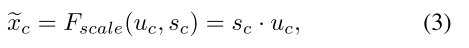

块的最终输出是通过用激活重新缩放变换输出U来获得的:

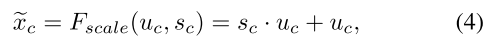

其中X = [x1,x2,…,xc]和Fscale(uc,sc)是指特征映射Uc ∈ RH×C和尺度sc之间的通道乘法。变换输出U可以解释为局部描述符的集合,所述局部描述符的统计对于整个图像是有表现力的。SC不能将每个信道的重要性表示为SE块中的全局平均池,因此我们提出了残差SE-blok。未通过SE块的特征被加到具有权重的特征上,如公式(4)所示。然后将融合特征图馈入后续层。

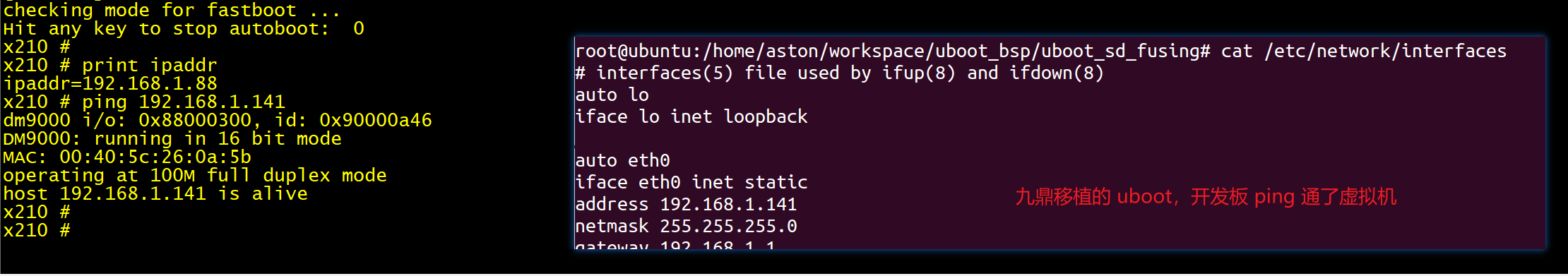

图1显示了SE阻断和rSE阻断之间的差异。缩减比R是一个重要的超参数,它允许我们改变模型中SE块的容量和计算成本。

3. EXPERIMENTS

3.1 Datasets

我们选择了著名的CIFAR10和CIFAR100数据集进行实验。CIFAR10和CIFAR100数据集由10和100类绘制的32 × 32彩色图像组成,这些图像分为50,000张训练图像和10,000张测试图像。对于数据增强,我们做水平翻转,从图像中随机选取作物,每边填充4个像素,用原始图像的反射填充缺失的像素。

3.2 训练和测试的设置

所有的网络使用随机梯度下降(SGD)训练。

3.3 分类结果及分析

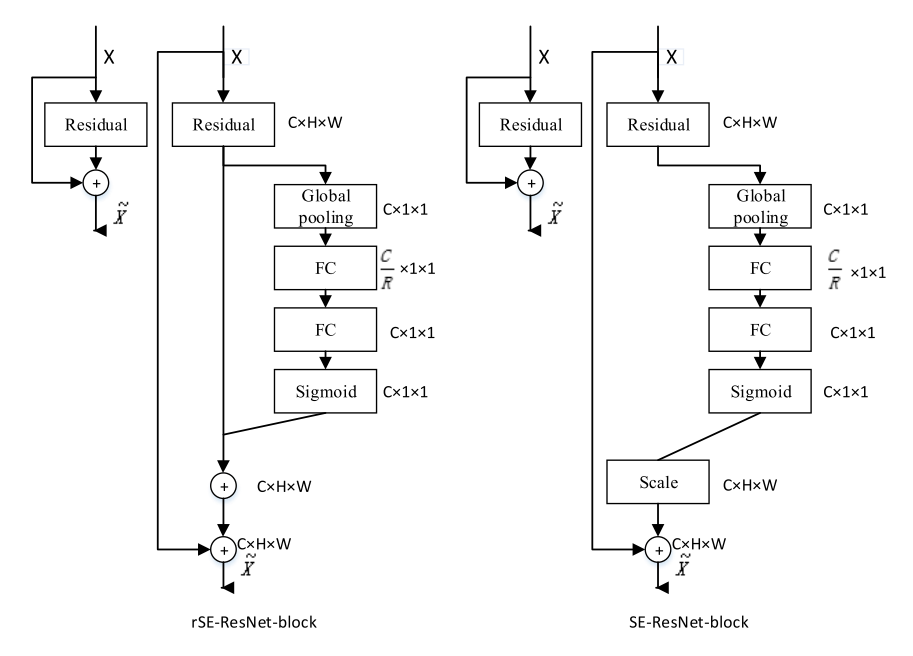

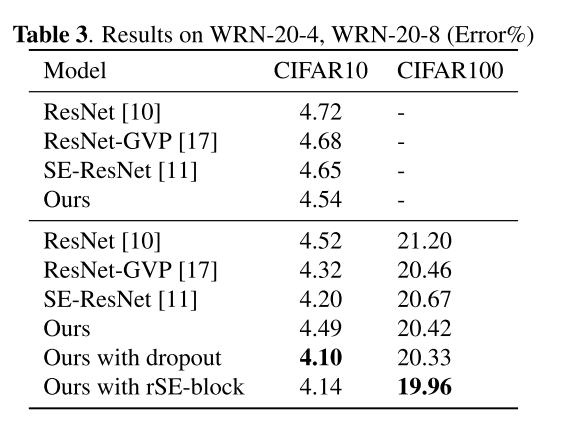

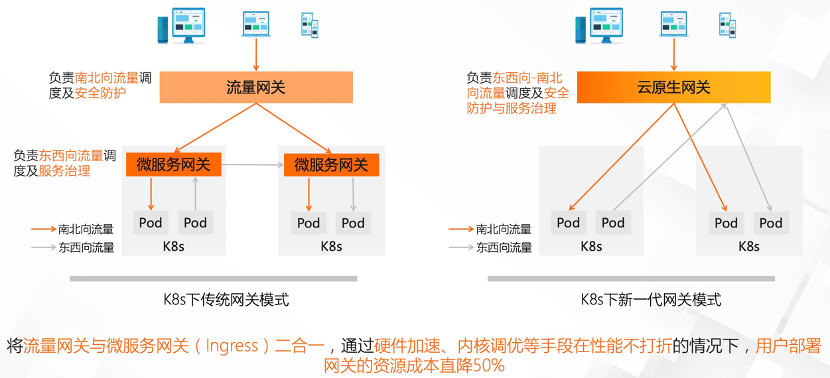

随着通道的有效利用,分类性能逐渐提高。表2显示了结果。

SE-block阻断增强了有效通道的作用,抑制了非有效通道的作用。然后利用全局协方差池来表征信道之间的相关性,从而有效地利用信道信息。

我们的网络只略微增加了模型的复杂性和计算负担。结果如表4所示。

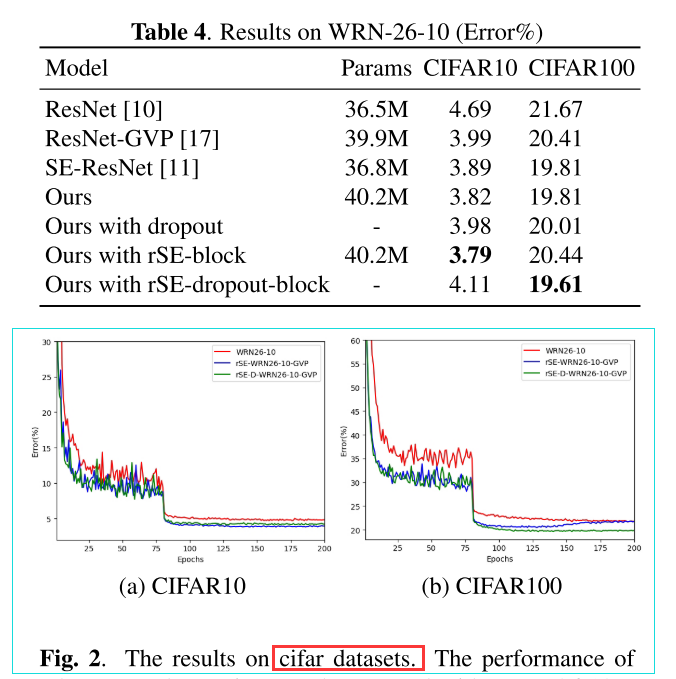

图二。在cifar数据集上的结果。

4. CONCLUSION

SeNets的目的是通过明确地建模其卷积特征的信道之间的相互依赖关系来提高网络的表示能力。全局协方差池描述了特征通道之间的相关性。

本文提出了利用信道信息的SE-WRNs-GVP。为了避免SE-blocks造成的信息丢失,提出了一种rSE-blocks。我们的rSE-WRN-26-10-GVP对CIFAR10的错误率为3.79%,对CIFAR100的错误率为20.44%,低于WRN。在加入全局协方差池时,学习速率衰减和带有dropout的SE-blocks对解决过拟合问题至关重要。信道信息的有效利用将提高分类的性能。

![[vue]vue3.x 组合式API不同写法](https://img-blog.csdnimg.cn/f2427de30d9e4ff6a73423d5b04ac997.png)