目录

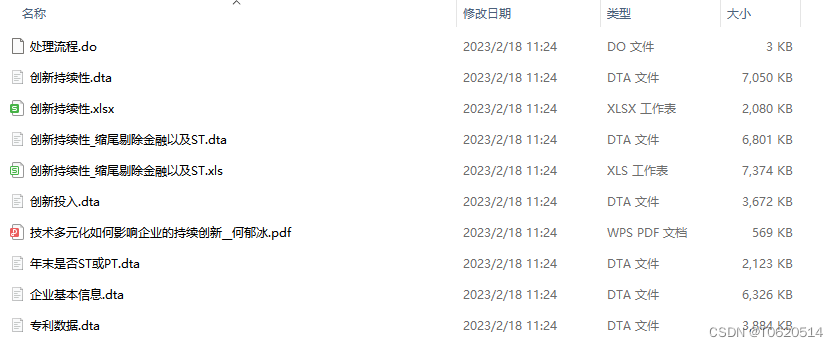

1.xftp上传flink压缩包至hadoop102的/opt/software/目录下

2.解压flink压缩包至/opt/module/目录下

3. 配置flink-conf.yaml

4.配置masters

5.配置workers

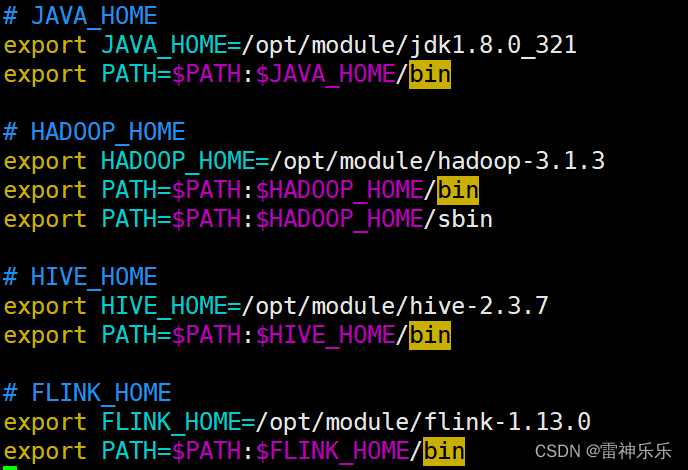

6.配置环境变量my_env.sh

7.重启环境变量

8.分发/opt/module/flink-1.13.0和/etc/profile.d/my_env.sh

9.另外两台重启环境变量

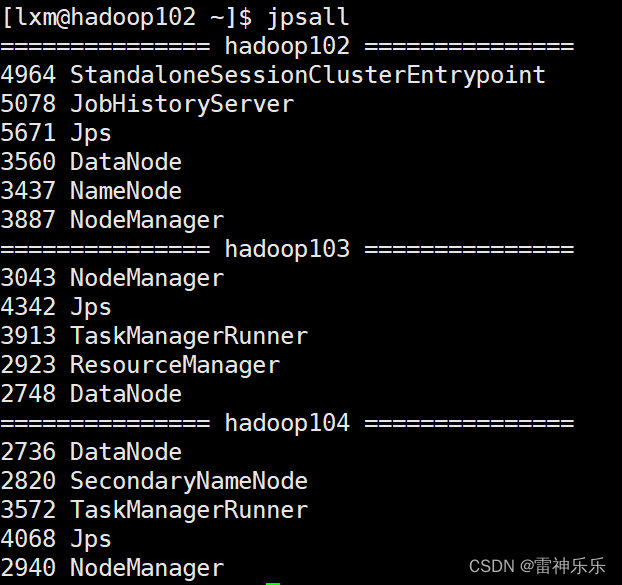

10.开启hadoop集群和flink集群

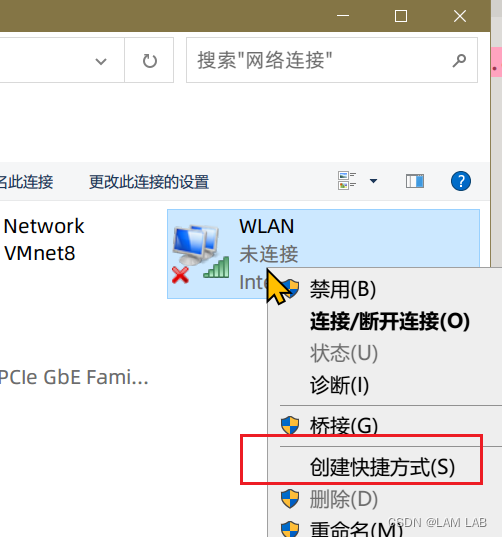

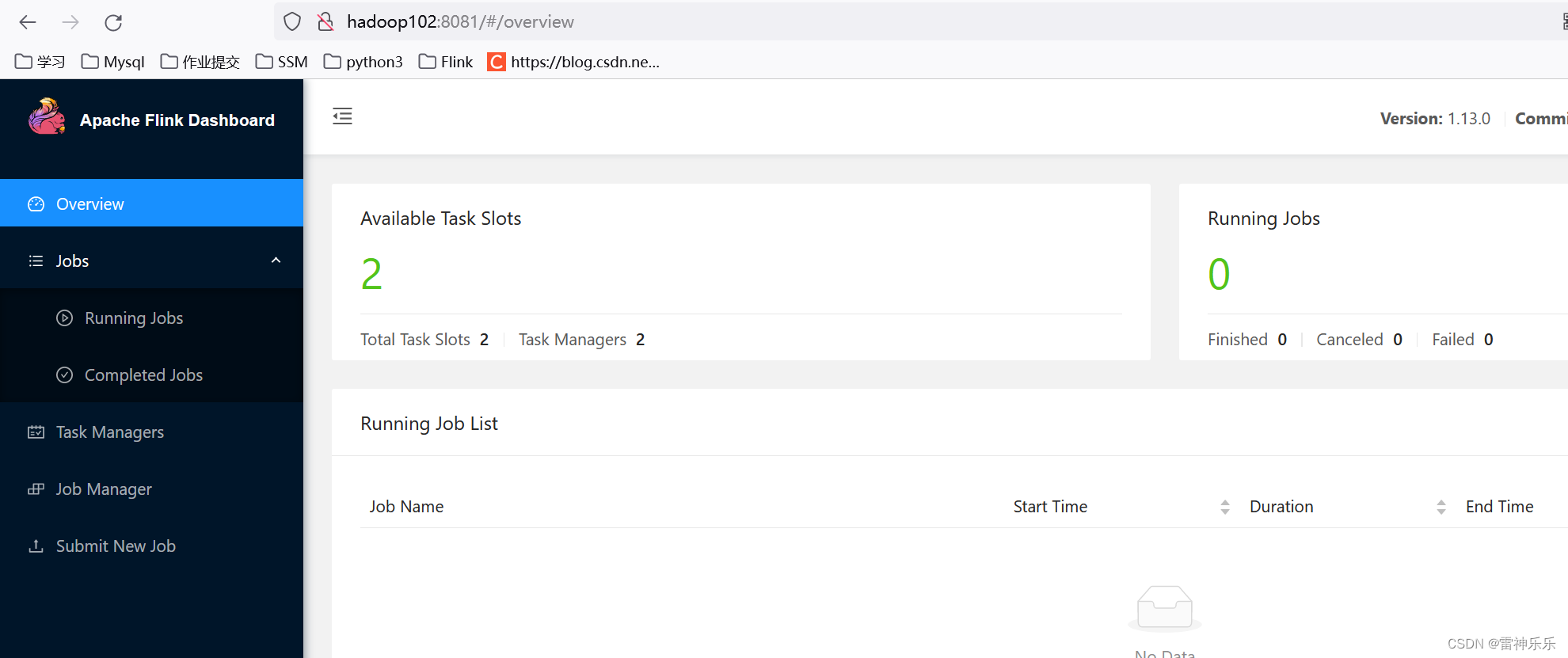

11.浏览器输入网址查验flink集群是否开启

12. 关闭flink集群命令

Hadoop集群搭建请参考博文《Hadoop集群搭建详细步骤》

1.xftp上传flink压缩包至hadoop102的/opt/software/目录下

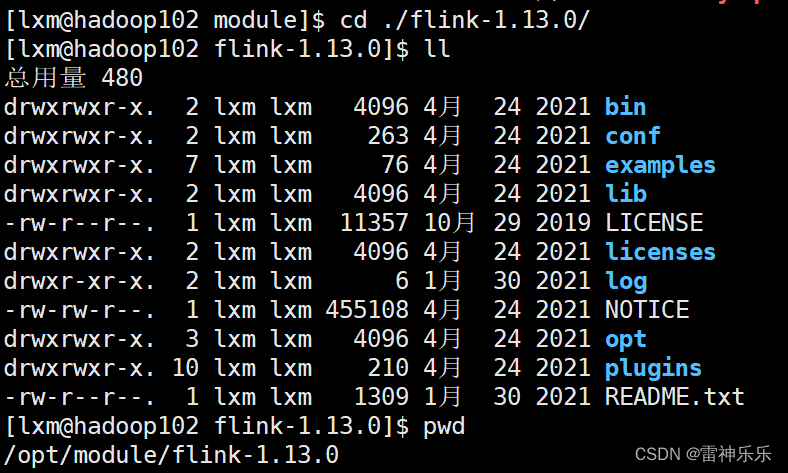

2.解压flink压缩包至/opt/module/目录下

[lxm@hadoop102 software]$ tar -zxvf ./flink-1.13.0-bin-scala_2.12.tgz -C /opt/module/

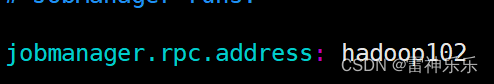

3. 配置flink-conf.yaml

4.配置masters

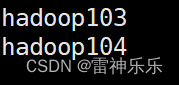

5.配置workers

6.配置环境变量my_env.sh

7.重启环境变量

[lxm@hadoop102 software]$ source /etc/profile

8.分发/opt/module/flink-1.13.0和/etc/profile.d/my_env.sh

[lxm@hadoop102 flink-1.13.0]$ xsync /opt/module/flink-1.13.0/

[lxm@hadoop102 ~]$ sudo ./bin/xsync /etc/profile.d/my_env.sh

9.另外两台重启环境变量

重启环境变量之前也可以查看是否分发成功

[lxm@hadoop103 ~]$ source /etc/profile

[lxm@hadoop104 ~]$ source /etc/profile10.开启hadoop集群和flink集群

[lxm@hadoop102 ~]$ myhadoop.sh start

[lxm@hadoop102 ~]$ start-cluster.sh

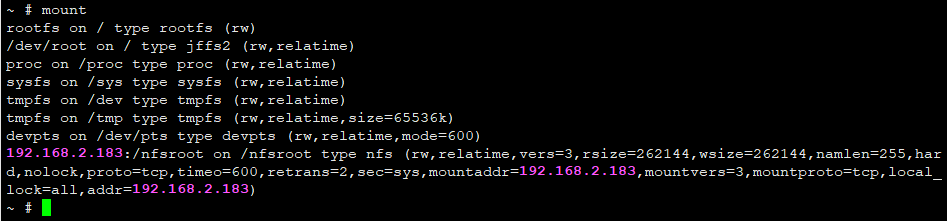

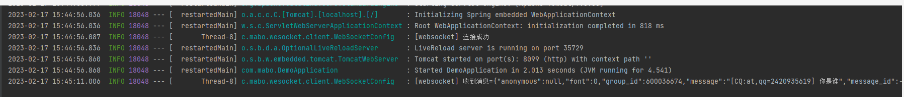

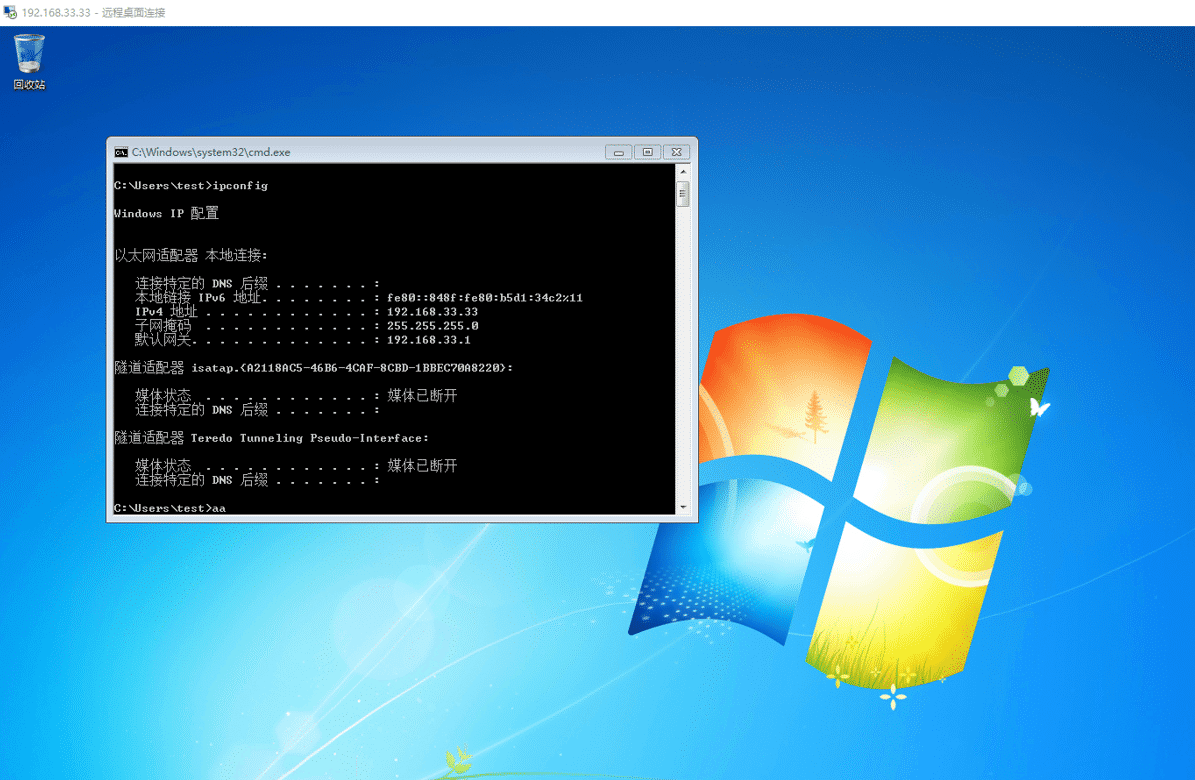

[lxm@hadoop102 ~]$ jpsall

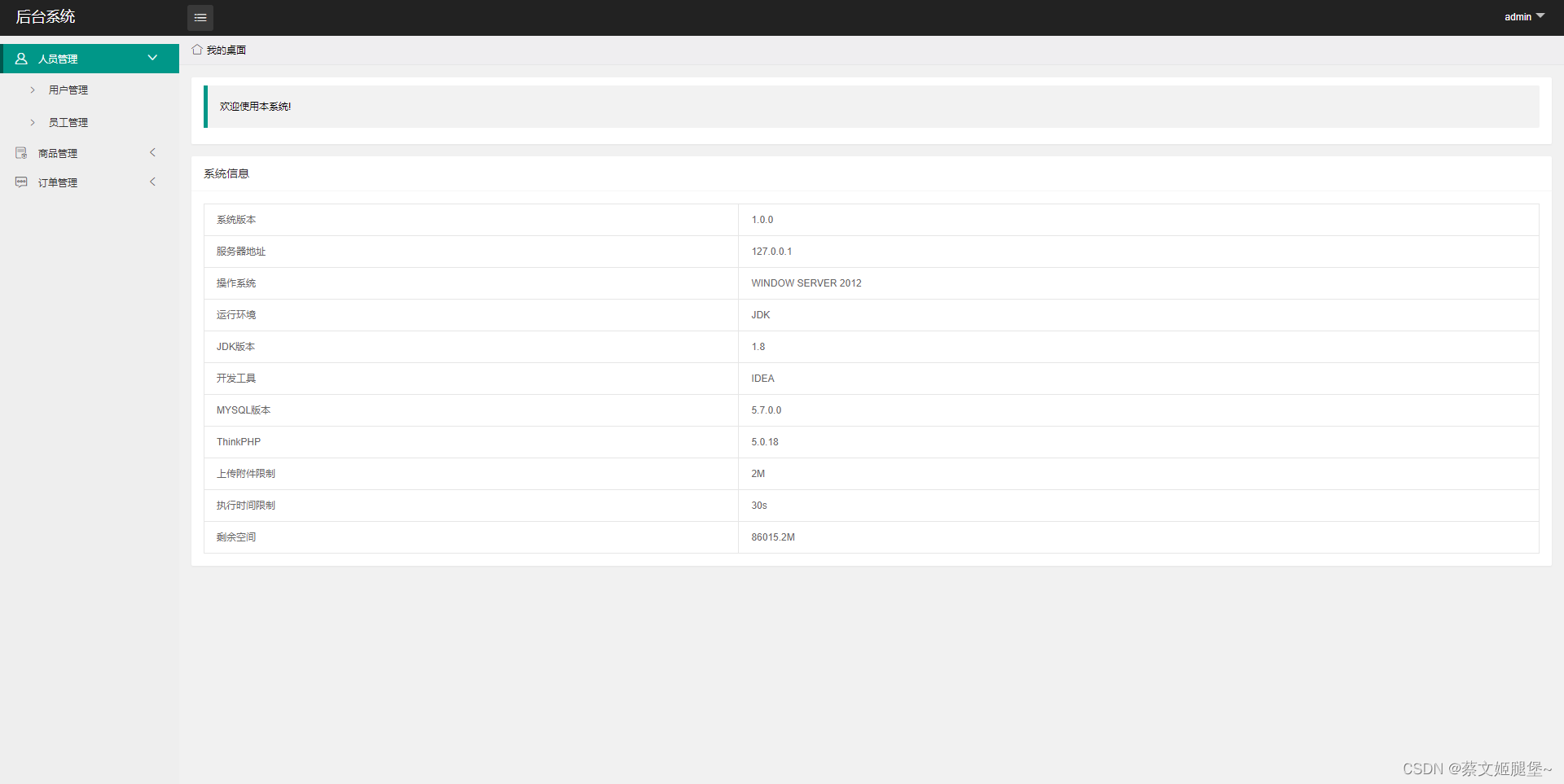

11.浏览器输入网址查验flink集群是否开启

http://hadoop102:8081

12. 关闭flink集群命令

[lxm@hadoop102 ~]$ stop-cluster.sh