嗨,大家好,我是心海

以下是一份详细的Windows系统下通过Ollama本地部署DeepSeek R1模型的教程,内容简洁易懂,适合新手用户参考

本地部署大模型,就有点像在你自己的电脑或者服务器上,安装并运行这样一个“私人小助手”,拥有一个安全、快速、可定制且稳定的私人智能助手,所有的数据和运算都在你自己的掌控之中。

一、环境准备

1.1 下载Ollama安装包

-

下载地址:访问 Ollama官网,选择Windows版本下载安装包。因为网络限制,所以下载会很慢,如果需要安装包可以联系我。

1.2 安装ollama

(1)方法1,使用命令安装

这种方法的好处是安装位置可以自定义,不用后面再去移动文件,默认安装位置是 C 盘

-1- 以管理员身份运行CMD

-2- 定位到OllamaSetup.exe所在的目录,并执行下面命令

OllamaSetup.exe /DIR="D:\ollama\dev"注意"D:\ollama\dev"是你自己的安装目录,下面图中 D:\liuINI 是你自己的安装包所在目录

-3- 输入命令后,会自动弹出安装界面,直接点击install即可

注意:安装完成后,Ollama会自动打开,此时我们先退出Ollama(桌面右下角图标)

(2)方法2 直接点击安装

双击 exe 安装包,点击install直接安装也是可以的,只不过这样默认会安装在C盘,但是后面可以自己手动移动到其它盘

同样的,安装完先退出

我们可以到对应安装目录下,查看文件

如果你是安装在C盘并且想移动到其它盘,直接全选这些文件,剪切到新目录,然后按下图修改环境变量,将路径改成你移动到的那个目标目录

(3) 打开方式

ollama默认没有图标, 可以在底部搜索栏找到它

1.3 验证安装

在命令行窗口,使用命令查看

ollama -v

使用ollama -h 可以查看相关操作命令

1.4 修改模型存放位置

因为ollama需要下载大语言模型,占用空间较大,而其默认存放位置在C盘,所以我们最好重新指定位置

在环境变量中配置,点击“新建”变量,变量名 OLLAMA_MODELS 变量值为存放模型的位置(目录)

二、下载安装DeepSeek模型

2.1 下载模型

在ollama官网点击 Models

找到想要的模型,比如我们的 DeepSeek r1

选择合适的模型,点击右上角复制命令(未指定数据大小,默认是 7b 模型)

DeepSeek R1提供多个参数版本(如1.5B、7B、14B等),参数越大模型效果越好,但对显存要求更高。根据显卡显存选择合适版本(仅供参考):

1.5B:需约4GB显存(适合入门显卡如GTX 1080)

7B:需约8GB显存(推荐RTX 3060及以上)

14B及以上:需更高显存(专业级显卡如RTX 4090)

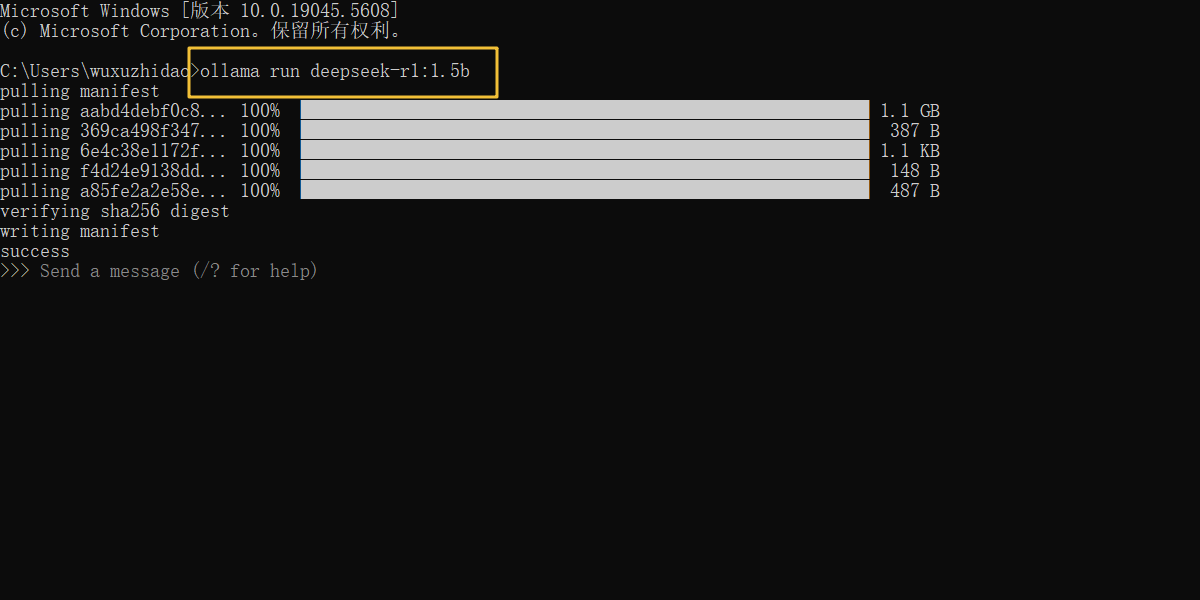

在命令行窗口执行命令,等待下载完成即可

注意:上述下载命令需要在新打开的CMD窗口中执行(因为我们在【5、🎄修改大模型存储位置】中修改了大模型存储的位置),否则下载的文件存储在 C盘 原来位置,就不是我们修改的

D盘这个位置了。

进度条加载完毕,显示 success 即下载完成

完成后可以直接输入提示词进行对话 ,比如“你是谁”

2.2 验证模型

当我们退出安装模型界面,重新进入时,使用命令 ollama run 模型名称 即可调用模型(注意ollama需要是启动状态)

例如 ollama run deepseek-r1:1.5b

其实这就是我们一开始的安装命令,只是你有了这个模型就可以直接调用,没有则下载

输入 /bye 可以结束对话

如果你下载了多个模型,使用 ollama-list 可以查看模型列表

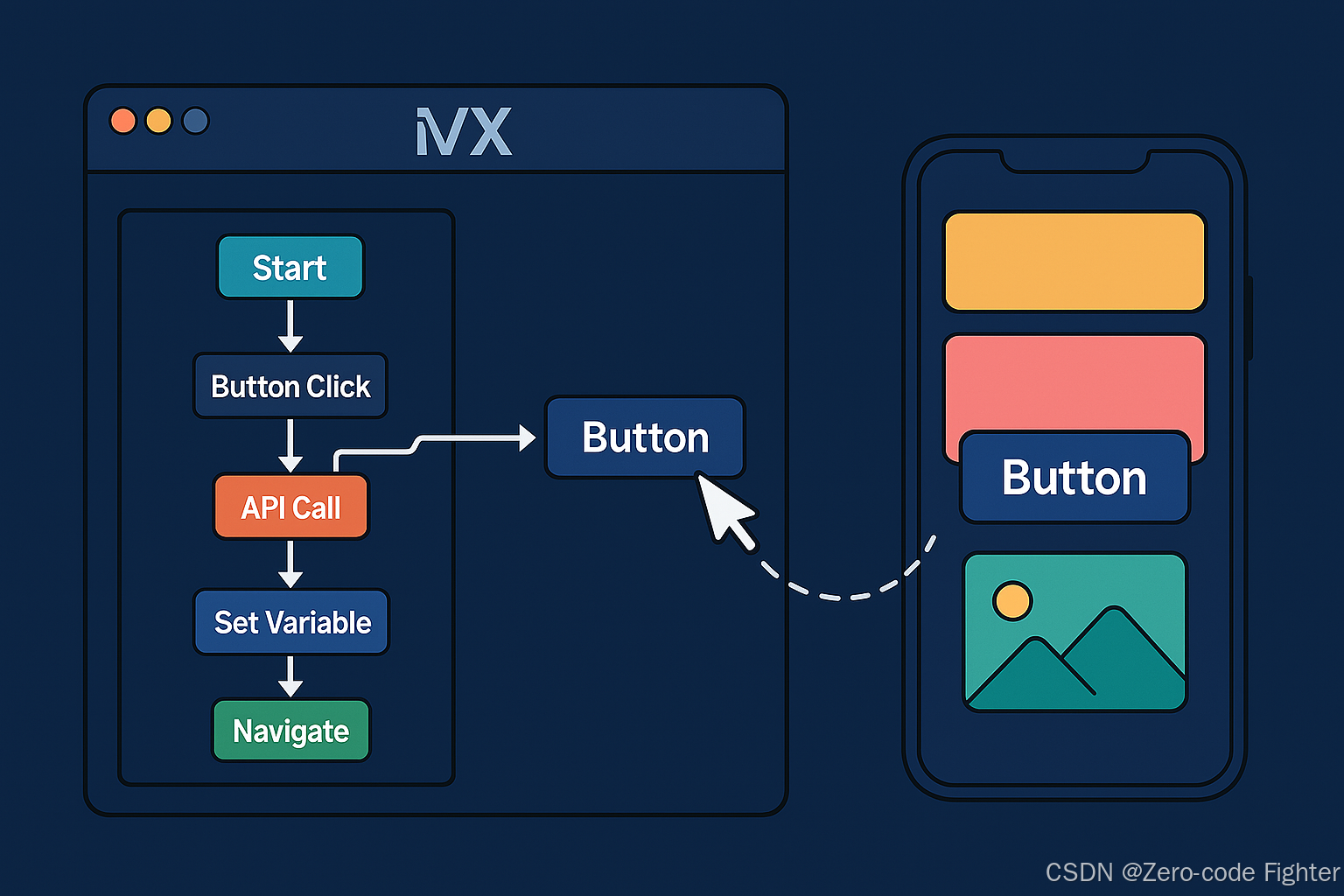

三、Web UI 界面

虽然我们可以通过命令行窗口进行对话,但是相对不那么好看,我们可以选择通过第三方Web UI来实现对话效果。

Chrome插件-Page Assist

我们直接在电脑,谷歌浏览器插件商店搜索 Page Assist

将插件添加到浏览器

点击即可进入一个新界面,连接成功如下图(注意ollama是启动着的)

如果英语不是很好,可以将界面改成中文

回到主界面,选择模型

到这里就可以开始对话

此外,我们还可以通过在线Web UI Chatbox网页版 进行对话 ,操作不难,并且对于我们开发者而言,更多的还是通过代码去调用,后面的文章会继续分享,如果是对UI界面感兴趣的朋友可以自己试一试

结语

本文我们详细讲解了 Ollama 部署 DeepSeek R1的流程,通过结合可视化工具可大幅提升体验。本地部署不仅可以去避免网络依赖,还能保护隐私数据,适合开发者和技术爱好者探索AI应用。

如果本文对你有所启发,期待你的点赞关注,你的一点点支持,就是我持续更新的最大动力。

![[ctfshow web入门] web16](https://i-blog.csdnimg.cn/direct/2d6d52a24c8d4b378d4fe16f4c7aab39.png)