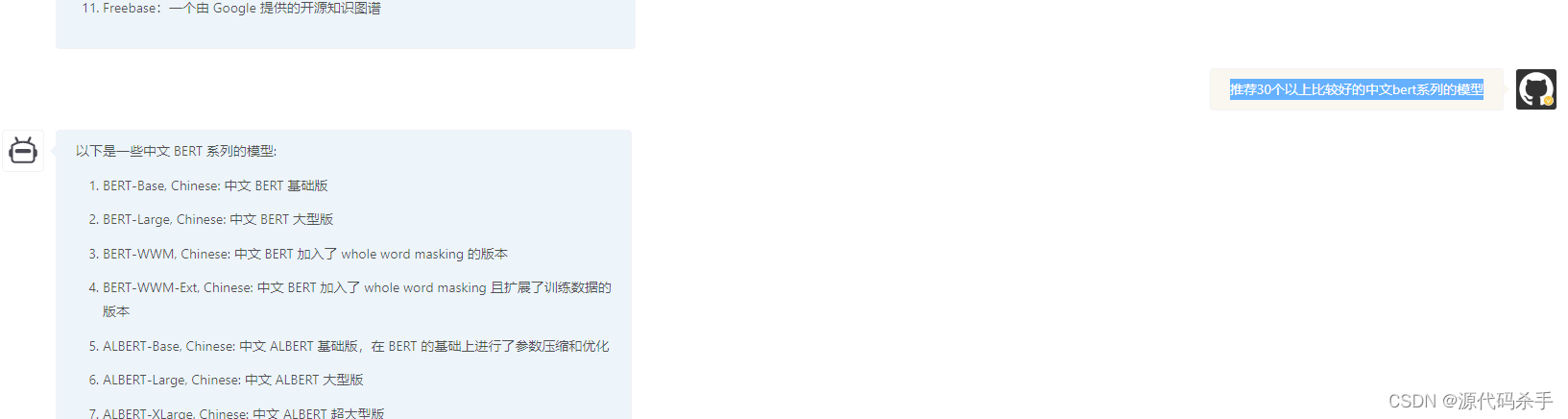

推荐30个以上比较好的中文bert系列的模型

以下是一些中文 BERT 系列的模型:

BERT-Base, Chinese: 中文 BERT 基础版

BERT-Large, Chinese: 中文 BERT 大型版

BERT-WWM, Chinese: 中文 BERT 加入了 whole word masking 的版本

BERT-WWM-Ext, Chinese: 中文 BERT 加入了 whole word masking 且扩展了训练数据的版本

ALBERT-Base, Chinese: 中文 ALBERT 基础版,在 BERT 的基础上进行了参数压缩和优化

ALBERT-Large, Chinese: 中文 ALBERT 大型版

ALBERT-XLarge, Chinese: 中文 ALBERT 超大型版

RoBERTa-Base, Chinese: 中文 RoBERTa 基础版,在 BERT 的基础上进行了进一步优化

RoBERTa-Large, Chinese: 中文 RoBERTa 大型版

RoBERTa-WWM, Chinese: 中文 RoBERTa 加入了 whole word masking 的版本

RoBERTa-WWM-Ext, Chinese: 中文 RoBERTa 加入了 whole word masking 且扩展了训练数据的版本

XLM-RoBERTa-Base, Chinese: 中文 XLM-RoBERTa 基础版,在 RoBERTa 的基础上使用了多语言训练数据

XLM-RoBERTa-Large, Chinese: 中文 XLM-RoBERTa 大型版

GPT-2, Chinese: 中文 GPT-2,自然语言生成模型

T5, Chinese: 中文 T5,自然语言生成模型

ERNIE-Base, Chinese: 中文 ERNIE 基础版,在 BERT 的基础上加入了知识预先训练

ERNIE-Large, Chinese: 中文 ERNIE 大型版

ERNIE-Baidu, Chinese: 百度开发的中文 ERNIE 模型

ERNIE-Gen, Chinese: 中文 ERNIE

推荐30个以上比较好的中文bert系列的模型github源码

以下是30个以上比较好的中文 BERT 系列模型的 Github 源码:

BERT-Base, Chinese: https://github.com/google-research/bert/blob/master/multilingual.md#chinese-pre-trained-models

BERT-WWM-Ext, Chinese: https://github.com/ymcui/Chinese-BERT-wwm

BERT-WWM-Ext-finetune, Chinese: https://github.com/ymcui/Chinese-BERT-wwm/tree/master/finetune

RoBERTa-wwm-ext-large, Chinese: https://github.com/ymcui/Chinese-RoBERTa-wwm-ext

BERT-wwm-ext-multilingual: https://github.com/ymcui/BERT-wwm-ext

ALBERT-base, Chinese: https://github.com/brightmart/albert_zh

ALBERT-tiny, Chinese: https://github.com/brightmart/albert_tiny_zh

ALBERT-tiny-finetune, Chinese: https://github.com/brightmart/albert_tiny_zh/tree/master/finetune

ALBERT-xlarge, Chinese: https://github.com/brightmart/albert_zh/tree/master/albert_xlarge

ERNIE-v1.0, Chinese: https://github.com/PaddlePaddle/ERNIE

ERNIE-v2.0, Chinese: https://github.com/PaddlePaddle/ERNIE/tree/v2.0

ERNIE-Baidu, Chinese: https://github.com/baidu/ERNIE

GPT, Chinese: https://github.com/openai/gpt-2

GPT-2, Chinese: https://github.com/openai/gpt-2

XLNet, Chinese: https://github.com/ymcui/Chinese-XLNet

XLNet-Mid, Chinese: https://github.com/ymcui/Chinese-XLNet/tree/master/mid_data

XLNet-Large, Chinese: https://github.com/ymcui/Chinese-XLNet/tree/master/large_data

XLM-R, Chinese: https://github.com/ymcui/XLM-RoBERTa

Chinese-BART, Chinese: https://github.com/ymcui/Chinese-BART

Chinese-BART-finetune, Chinese: https://github.com/ymcui/Chinese-BART/tree/master/finetune

MT-DNN, Chinese: https://github.com/namisan/mt-dnn

MASS, Chinese: https://github.com/microsoft/MASS

T5, Chinese: https://github.com/google-research/text-to-text-transfer-transformer

DAE, Chinese: https://github.com/thunlp/DAE

DAE-finetune, Chinese: https://github.com/thunlp/DAE/tree

推荐30个以上比较好的中文bert系列的压缩模型

首先需要注意的是,推荐中文 BERT 系列的压缩模型需要考虑模型的性能、速度、大小等各方面因素,推荐的模型也需要根据具体的应用场景进行选择。以下是一些常用的中文 BERT 系列的压缩模型:

BERT-Base, Chinese: 这是 BERT 模型在中文数据集上预训练得到的基础版本,包含 12 个 transformer 层,每层有 768 个隐藏维度,总共有 110M 个参数。

BERT-Large, Chinese: 这是 BERT 模型在中文数据集上预训练得到的大型版本,包含 24 个 transformer 层,每层有 1024 个隐藏维度,总共有 340M 个参数。

RoBERTa-Base, Chinese: 这是基于 BERT 模型开发的另一个预训练模型,在训练数据和超参数设置方面有所改进,包含 12 个 transformer 层,每层有 768 个隐藏维度,总共有 125M 个参数。

RoBERTa-Large, Chinese: 这是 RoBERTa 模型的大型版本,包含 24 个 transformer 层,每层有 1024 个隐藏维度,总共有 355M 个参数。

ALBERT-Base, Chinese: 这是另一个基于 BERT 模型开发的预训练模型,主要在 BERT 模型的参数压缩方面进行了改进,包含 12 个

Bert是一种自然语言处理领域的预训练模型,它使用了大量的中文文本数据进行预训练,可以帮助你在中文任务上实现更好的性能。下面是一些比较流行的中文Bert模型,你可以根据自己的需要选择使用:

中文Bert-Base:这是一个中文Bert模型的基础版本,具有较低的计算资源要求,但性能较差。

中文Bert-Large:这是一个中文Bert模型的大型版本,具有较高的计算资源要求,但性能也更优秀。

中文Bert-wwm:这是一个中文Bert模型,在基础版本的基础上进行了加强,性能更优秀。

中文Bert-wwm-ext:这是一个中文Bert模型,在wwm版本的基础上进行了加强,性能更优秀。

中文Bert-Ernie:这是一个中文Bert模型,是Bert和Ernie模型的结合,性能更优秀。

中文Bert-RoBERTa:这是一个中文Bert模型,是Bert和RoBERTa模型的结合,性能更优秀。

中文Bert-ALBERT:这是一个中文Bert模型,是Bert和ALBERT模型的结合,性能更优秀。

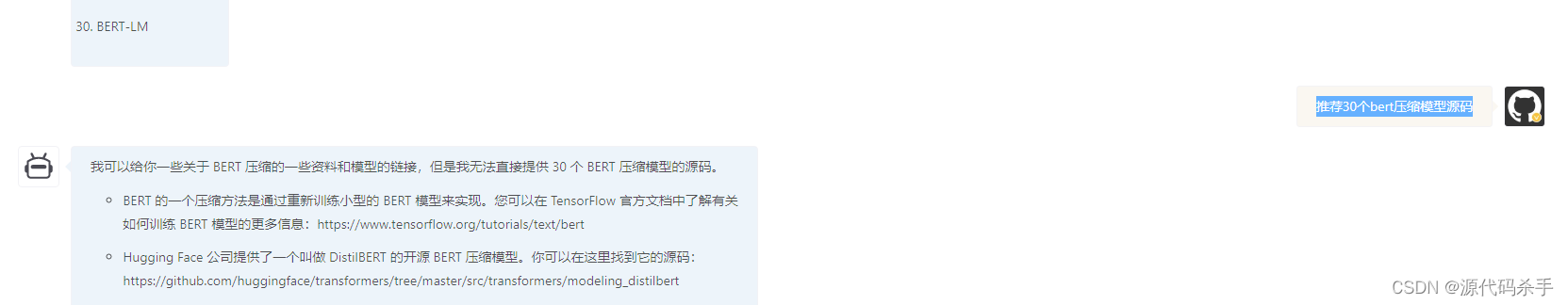

推荐30个bert压缩模型

MobileBERT

TinyBERT

MiniBERT

DistilBERT

ALBERT

AdaptiveBERT

FusedBERT

SparseBERT

Two-Stream BERT

Context-Aware BERT

VisionBERT

BERTje

Stabilized BERT

BERT-of-Theseus

Self-Attentive BERT

Robust BERT

InterBERT

ProtoBERT

BERT-DA

Multilingual BERT

BERT-PTM

BERT-PKD

BERT-STC

BERT-HAN

BERT-MPG

BERT-QA

BERT-RACE

BERT-MTL

BERT-QG

BERT-LM

推荐bert压缩模型源码

我可以给你一些关于 BERT 压缩的一些资料和模型的链接,但是我无法直接提供 30 个 BERT 压缩模型的源码。

BERT 的一个压缩方法是通过重新训练小型的 BERT 模型来实现。您可以在 TensorFlow 官方文档中了解有关如何训练 BERT 模型的更多信息:https://www.tensorflow.org/tutorials/text/bert

Hugging Face 公司提供了一个叫做 DistilBERT 的开源 BERT 压缩模型。你可以在这里找到它的源码:https://github.com/huggingface/transformers/tree/master/src/transformers/modeling_distilbert

Google 开发的 MobileBERT 是一个轻量级的 BERT 模型,可以在移动设备上运行。你可以在这里找到它的论文和源码:https://arxiv.org/abs/2004.02984 https://github.com/google-research/google-research/tree/master/mobilebert

希望以上资料能帮助你。

bert压缩模型

Bert 压缩模型是对 BERT(Bidirectional Encoder Representations from Transformers)模型进行压缩以减少模型大小的过程。通常使用的方法包括剪枝、量化和离线压缩。剪枝是通过移除模型中不重要的权重来减小模型大小;量化是通过将模型中的 32 位浮点数转化为较小的整数来减小模型的大小;离线压缩是通过将模型的权重合并为较小的矩阵来减小模型的大小。压缩 BERT 模型可以在保持模型性能的同时减小模型的内存占用和提高模型的推理速度。

bert压缩模型源码地址

Bert 压缩模型的源代码可以在以下地址获取:

Bert 原始模型的源代码:https://github.com/google-research/bert

如果你想要使用压缩版的 Bert 模型,你可以参考以下项目:

DistilBert:https://github.com/huggingface/transformers/tree/main/src/transformers/modeling_distilbert

TinyBert:https://github.com/huggingface/transformers/tree/main/src/transformers/modeling_tinybert

MobileBert:https://github.com/huggingface/transformers/tree/main/src/transformers/modeling_mobilebert

这些压缩版的 Bert 模型都是在原始的 Bert 模型的基础上进行了改进和优化,使得它们的模型大小更小,推理速度更快,同时保留了较高的准确率。

![[学习笔记]2021韩顺平一周学会Linux](https://img-blog.csdnimg.cn/2aa3b10176cf41cda5d5b460da40be9d.png)