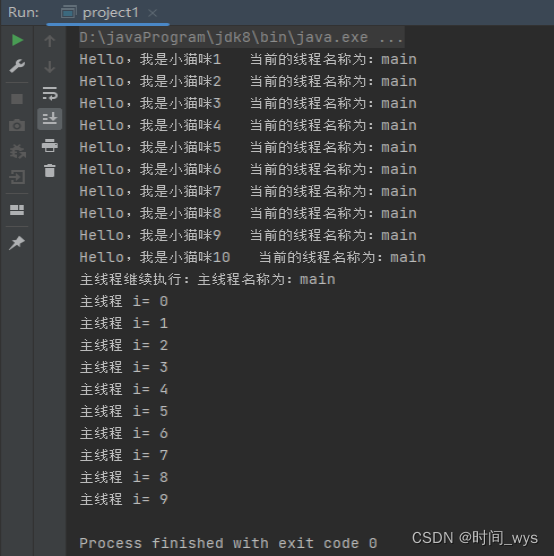

1. 直接在IDEA中执行,方便在本地环境调试代码

2. 使用spark-submit提交到集群执行【实际工作中使用】

3. 使用spark-shell,方便在集群环境调试代码

比如:需要连接数据库,无法在本地调试的情况。

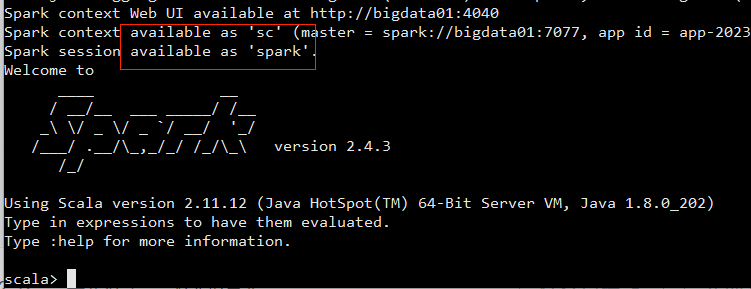

spark-shell 实现了用户可以逐行输入代码,进行操作的功能。 即可以不像Java一样,编写完所有代码,然后编译才能运行。spark-shell 支持 Scala交互环境 和 python交互环境,在学习测试中可以使用spark-shell 进行API学习。

spark-shell会自动创建sparkContext

- spark-shell的local模式

bin/spark-shell- spark-shell的独立集群模式

bin/spark-shell --master spark://bigdata01:7077

注意:需要先启动spark standalone集群

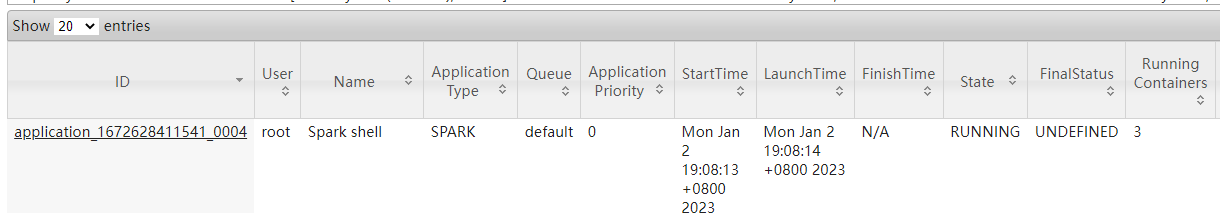

- spark-shell的YARN模式

bin/spark-shell --master yarn --deploy-mode client

会启动一个spark任务

![[学习笔记]2021韩顺平一周学会Linux](https://img-blog.csdnimg.cn/2aa3b10176cf41cda5d5b460da40be9d.png)

![【WSL】[04]从C盘解放出来WSL的linux镜像](https://img-blog.csdnimg.cn/6475bf1b269f43a5a465f8157819a1f9.png)