目录

依赖环境

AIP操作hdfs基本流程

创建目录

文件上传

参数优先级

文件下载

文件删除

文件更名与移动

查看HDFS文件的详情信息

文件和文件夹的判断

依赖环境

hadoop依赖:

Maven Repository(Maven仓库)- https://mvnrepository.com/

junit依赖

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

在resources目录里创建log4j.properties文件并写入以下数据

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

AIP操作hdfs基本流程

public void test() throws URISyntaxException, IOException, InterruptedException {

//连接集群地址

URI uri = new URI("hdfs://master:9000");

//创建配置文件

Configuration configuration = new Configuration();

//用户

String user = "master";

//获取客户对象

FileSystem fs = FileSystem.get(uri, configuration, user);

//关闭资源

fs.close();由于初始化流程会多次使用该部分代码,所以可以将其封装一下。

package testHDFS;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class HdfsClient {

//设置对象全局变量

private static FileSystem fs;

@Before //最先执行

public void start_() throws URISyntaxException, IOException, InterruptedException {

//连接集群地址

URI uri = new URI("hdfs://master:9000");

//创建配置文件

Configuration configuration = new Configuration();

//用户

String user = "master";

//获取客户对象

fs = FileSystem.get(uri, configuration, user);

}

@After //最后执行

public void close_() throws IOException {

//关闭资源

fs.close();

}

@Test //@Before执行后再执行

public void test() throws IOException {

//操作的逻辑代码

}

}

创建目录

在test()方法中为业务操作代码的部分 将所需的操作代码写到其中。

//创建目录

fs.mkdirs(new Path("/news/a"));到HDFS中查看目录创建成功

![]()

文件上传

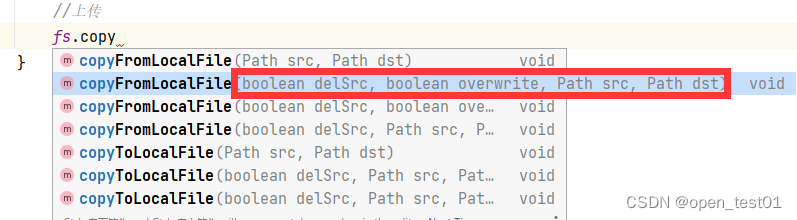

上传文件使用copyFromLocalFile() 参数解读:

delSrc:上传后是否删除原数据

overwrite:是否允许覆盖文件

src:原数据路径(为使用API的windows本地主机文件)

dst:目标地址路径

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

//操作的逻辑代码

//上传

fs.copyFromLocalFile(false,false,new Path("D:\\newHDFS.txt"),new Path("/news"));

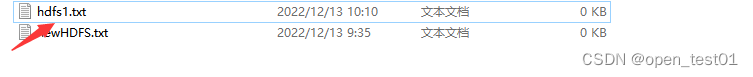

}windows下的文件

到HDFS中查看文件上传成功

参数优先级

参数优先级排序:

(1)客户端代码中设置的值 >(2)ClassPath 下的用户自定义配置文 件 >(3)然后是服务器的自定义配置(hdfs-site.xml)>(4)服务器的默认配置(hdfs-default.xml)

文件下载

下载文件使用copyToLocalFile() 参数解读:

delSrc:下载后是否删除文件

src:原文件路径(为HDFS目录文件)

dst:目标地址路径

useRawLocalFileSystem:是否开启本地校验

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

//下载文件

fs.copyToLocalFile(false,new Path("/hhh/hdfs1.txt"),new Path("D:\\"),false);

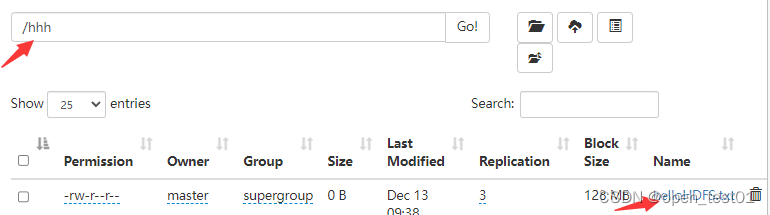

}HDFS下的文件

在windows中查看文件下载成功

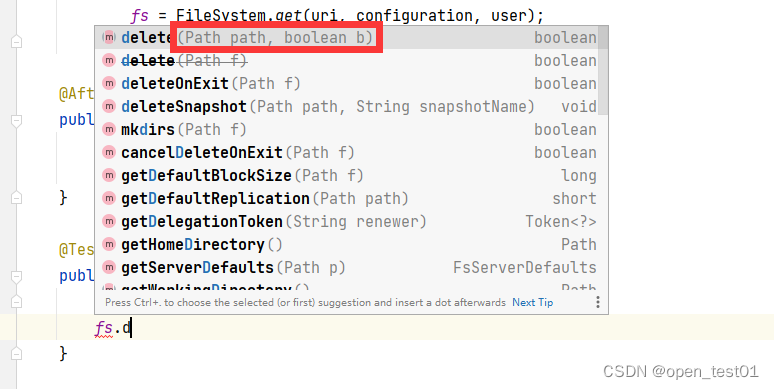

文件删除

下载文件使用delete() 参数解读:

path:删除的文件路径(为HDFS目录文件)

b:是否递归删除

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

//删除文件

fs.delete(new Path("/hhh/hdfs1.txt"),false);//我这目录只有一个文件所以不选递归删除

}查看hdfs1.txt文件已被删除

不止有删除文件 该方法还能删除空目录与非空目录(非空目录必须使用递归删除)

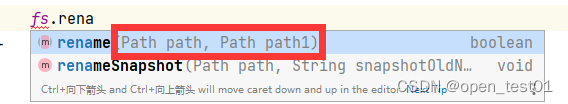

文件更名与移动

下载文件使用rename() 参数解读:

path:原文件路径

path1:移动到的位置路径

修改文件名

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

//更名文件

fs.rename(new Path("/news/newHDFS.txt"),new Path("/news/helloHDFS.txt"))

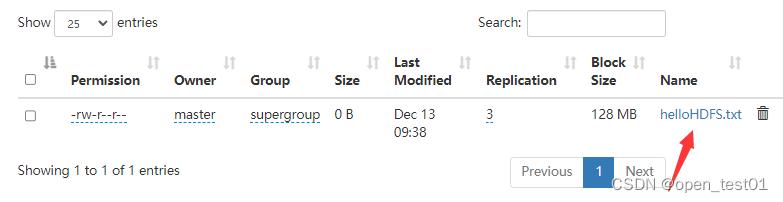

}查看修改成功

移动文件

将/news/helloHDFS.txt移动到/hhh目录下

fs.rename(new Path("/news/helloHDFS.txt"),new Path("/hhh/helloHDFS.txt"));查看移动成功

不止能对文件 该方法还能对目录进行进行更名和移动

查看HDFS文件的详情信息

查看目录信息使用rename() 参数解读:

f:查看路径信息

recursive:是否递归

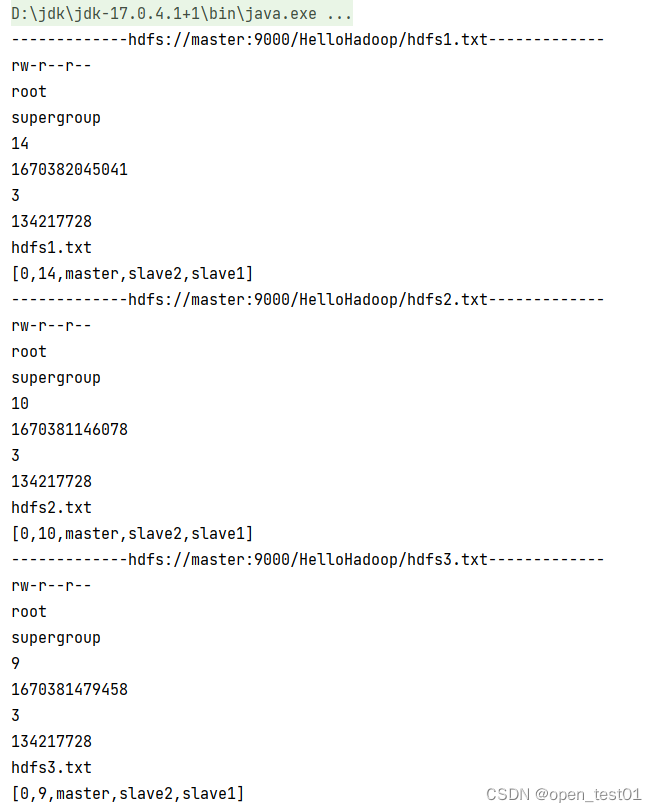

查看HelloHadoop目录下的文件信息

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

//获取所有文件信息

//返回一个迭代器

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/HelloHadoop"), true);

//遍历迭代器

while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

//获取文件路径

System.out.println("-------------"+fileStatus.getPath()+"-------------");

//获取信息

System.out.println(fileStatus.getPermission());

System.out.println(fileStatus.getOwner());

System.out.println(fileStatus.getGroup());

System.out.println(fileStatus.getLen());

System.out.println(fileStatus.getModificationTime());

System.out.println(fileStatus.getReplication());

System.out.println(fileStatus.getBlockSize());

System.out.println(fileStatus.getPath().getName());

//获取块信息

BlockLocation[] blockLocations = fileStatus.getBlockLocations();

//打印数组中的块信息

System.out.println(Arrays.toString(blockLocations));

}

}控制台文件信息输出结果

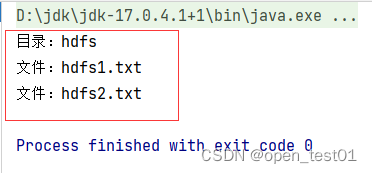

文件和文件夹的判断

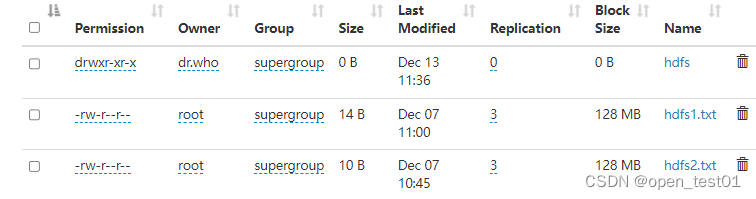

判断HelloHadoop目录下的是文件还是文件夹

@Test //@Before执行后再执行

public void test() throws IOException {//抛出异常

// 判断是文件夹还是文件

//选定遍历判断的目录

FileStatus[] listStatus = fs.listStatus(new Path("/HelloHadoop"));

//循环遍历

for (FileStatus status : listStatus) {

//判断是否为文件

if (status.isFile()) {

//打印信息

System.out.println("文件:"+status.getPath().getName());

}else {

System.out.println("目录:"+status.getPath().getName());

}

}

}控制台文件信息输出判断结果