文章目录

- 一、概述

- 二、实现

- 1. 导入需要的库

- 2. 加载数据集

- 3. 构造缺失值

- 4. 使用0和均值填充缺失值

- 5. 使用随机森林填充缺失值

- 6. 对填充好的数据进行建模

- 7. 评估效果对比

一、概述

现实中收集的数据,几乎不可能是完美无缺的,往往都会有一些缺失值。面对缺失值,可以直接删除、数值填充等,在这个案例中,将使用均值,0,和随机森林回归来填补缺失值,并验证四种状况下的拟合状况,找出对使用的数据集来说最佳的缺失值填补方法。

二、实现

1. 导入需要的库

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.datasets import load_boston

from sklearn.impute import SimpleImputer

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import cross_val_score

2. 加载数据集

实现所使用的数据集为波士顿房价数据集

dataset = load_boston()

print(dataset.data.shape) # (506, 13)

X_full, y_full = dataset.data, dataset.target

n_samples = X_full.shape[0] # 506

n_features = X_full.shape[1] # 13

3. 构造缺失值

# 缺失值比例为50%

rng = np.random.RandomState(0)

missing_rate = 0.5

n_missing_samples = int(np.floor(n_samples * n_features * missing_rate))

# 缺失值所在的行位置和列位置

missing_features = rng.randint(0,n_features,n_missing_samples)

missing_samples = rng.randint(0,n_samples,n_missing_samples)

# 复制原始数据

X_missing = X_full.copy()

y_missing = y_full.copy()

# 构造缺失值

X_missing[missing_samples,missing_features] = np.nan

X_missing = pd.DataFrame(X_missing)

4. 使用0和均值填充缺失值

# 使用均值进行填充

from sklearn.impute import SimpleImputer

imp_mean = SimpleImputer(missing_values=np.nan, strategy='mean')

X_missing_mean = imp_mean.fit_transform(X_missing)

# 使用0进行填补

imp_0 = SimpleImputer(missing_values=np.nan, strategy="constant",fill_value=0)

X_missing_0 = imp_0.fit_transform(X_missing)

5. 使用随机森林填充缺失值

对于一个有n个特征的数据来说,其中特征T有缺失值,我们就把特征T当作标签,其他的n-1个特征和原本的标签组成新的特征矩阵。那对于T来说,它没有缺失的部分,就是我们的Y_test,这部分数据既有标签也有特征,而它缺失的部分,只有特征没有标签,就是我们需要预测的部分。

X_train:特征T不缺失的值对应的其他n-1个特征 + 本来的标签Y_train:特征T不缺失的值X_test:特征T缺失的值对应的其他n-1个特征+ 本来的标签Y_test:特征T缺失的值:未知,我们需要预测的

那如果数据中除了特征T之外,其他特征也有缺失值怎么办?

答案是遍历所有的特征,从缺失最少的开始进行填补(因为填补缺失最少的特征所需要的准确信息最少)。填补一个特征时,先将其他特征的缺失值用0代替,每完成一次回归预测,就将预测值放到原本的特征矩阵中,再继续填补下一个特征。每一次填补完毕,有缺失值的特征会减少一个,所以每次循环后,需要用0来填补的特征就越来越少。当进行到最后一个特征时(这个特征应该是所有特征中缺失值最多的),已经没有任何的其他特征需要用0来进行填补了,而我们已经使用回归为其他特征填补了大量有效信息,可以用来填补缺失最多的特征。遍历所有的特征后,数据就完整,不再有缺失值了

X_missing_reg = X_missing.copy()

sortindex = np.argsort(X_missing_reg.isnull().sum(axis=0)).values

for i in sortindex:

#构建我们的新特征矩阵和新标签

df = X_missing_reg

fillc = df.iloc[:,i]

df = pd.concat([df.iloc[:,df.columns != i],pd.DataFrame(y_full)],axis=1)

#在新特征矩阵中,对含有缺失值的列,进行0的填补

df_0 =SimpleImputer(missing_values=np.nan,

strategy='constant',fill_value=0).fit_transform(df)

#找出我们的训练集和测试集

Ytrain = fillc[fillc.notnull()]

Ytest = fillc[fillc.isnull()]

Xtrain = df_0[Ytrain.index,:]

Xtest = df_0[Ytest.index,:]

#用随机森林回归来填补缺失值

rfc = RandomForestRegressor(n_estimators=100)

rfc = rfc.fit(Xtrain, Ytrain)

Ypredict = rfc.predict(Xtest)

#将填补好的特征返回到我们的原始的特征矩阵中

X_missing_reg.loc[X_missing_reg.iloc[:,i].isnull(),i] = Ypredict

6. 对填充好的数据进行建模

#对所有数据进行建模,取得MSE结果

X = [X_full,X_missing_mean,X_missing_0,X_missing_reg]

mse = []

std = []

for x in X:

estimator = RandomForestRegressor(random_state=0, n_estimators=100)

scores = cross_val_score(estimator,x,y_full,scoring='neg_mean_squared_error',

cv=5).mean()

mse.append(scores * -1)

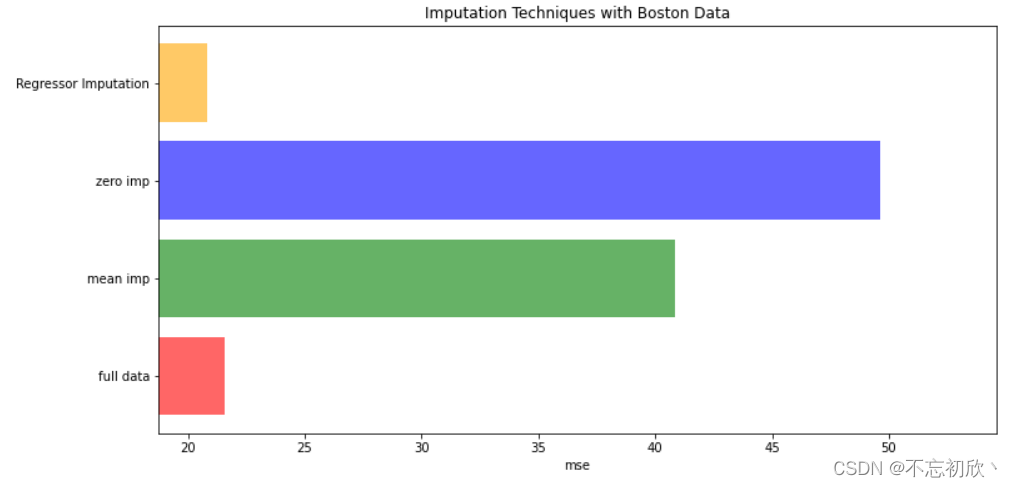

7. 评估效果对比

x_labels = ['full data'

,'zero imp'

,'mean imp'

,'Regressor Imputation']

colors = ['r', 'g','b','orange']

plt.figure(figsize=(12,6))

ax = plt.subplot(111)

for i in np.arange(len(mse)):

ax.barh(i,mse[i],color=colors[i],alpha=0.6,align='center')

ax.set_title('Imputation Techniques with Boston Data')

ax.set_xlim(left=np.min(mse)*0.9,

right=np.max(mse)*1.1)

ax.set_yticks(np.arange(len(mse)))

ax.set_xlabel('mse')

ax.set_yticklabels(x_labels)

plt.show()

可见在进行缺失值处理时使用随机森林进行填补,比单纯使用0或者均值填补效果要好。