Dual attention mechanism network for lung cancer images super-resolution

(肺癌图像超分辨率的双重注意机制网络)

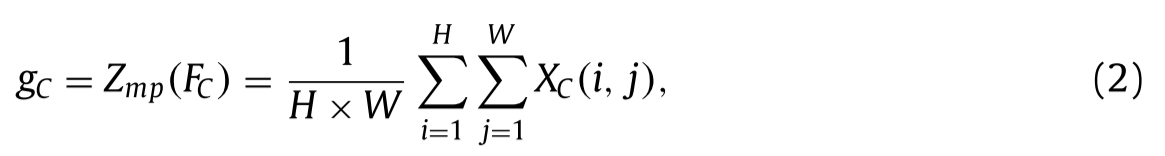

目前,肺癌的发病率和死亡率均居世界恶性肿瘤之首。提高肺部薄层CT的分辨率对于肺癌筛查的早期诊断尤为重要。针对超分辨率(SR)重建技术中网络层次加深导致网络训练困难和特征信息利用率低的问题,提出了单幅图像超分辨率(SISR)的双注意机制网络。首先,直接提取低分辨率图像的特征,保留图像的特征信息;其次,构建了多个独立的双注意机制模块,提取高频细节。残差连接的引入可以有效地解决网络加深引起的梯度消失问题,长短跳跃连接可以有效地增强数据特征。此外,混合损失函数加快了网络的收敛速度,提高了图像SR恢复能力。最后,通过上采样操作,得到重构的高分辨率图像。

介绍

早期肺癌的临床表现多种多样,最常见的是肺实质小结节和磨玻璃结节。肺结节大小、密度不同,病理类型也不同。直径的增大增加了恶性的概率,尤其是毛玻璃结节,原位腺癌和微浸润腺癌常表现为毛玻璃病变,混合型毛玻璃结节常含有浸润性腺癌成分。磨玻璃结节近年来越来越多地出现,这也与剂量螺旋CT技术的普及密切相关。普通胸片不能显示磨玻璃结节,建议行薄层CT筛查,薄层CT是早期发现肺癌最关键的手段。而深度学习医学图像超分辨率重建方法可以为肺结节的早期诊断提供有力的技术帮助。

单幅图像超分辨率重建(SISR)是一种从低分辨率(LR)图像恢复高分辨率(HR)图像的技术。高分辨率图像广泛应用于遥感制图、医学成像、视频监控和图像生成等领域。由于目前技术发展的限制和成本的考虑,利用软件处理方法获取高分辨率图像已成为图像处理领域的研究热点。

与传统算法相比,基于深度学习的方法在性能上有显著提升。Dong等人首先在图像超分辨率(SR)任务中引入了三层卷积神经网络(CNN)。Kim等人将VDSR和DRCN中的网络深度增加到20层,与SRCNN相比,视觉效果和指标显著改善。Shi等人提出了一种亚像素卷积方法,该方法不需要对LR图像进行预处理,直接作为网络的输入进行特征提取。此外,将特征图布置在最后一层实现上采样操作,减少了对LR图像上下文信息的破坏。Lim等人在残差网络的提出下,设计了一种增强型深度随机共振重构网络(Enhanced Deep SR Reconstruction Network,EDSR),通过堆叠更多的网络层来构造更深的卷积网络,并从每层中提取更多的特征来重构图像,显著提高了网络性能。此外,Zhang等人受残差密集网络的启发,设计了残差密集块,通过多个残差密集块的互联融合,可以更有效地提取特征信息,提高重建质量。

贡献

1)提出了有效整合渠道和空间注意的双重注意机制网络结构。该网络可以集中于更有价值的信道,增强判别学习能力,提高算法的准确性。

2)设计了一种混合注意机制,能够学习特征图空间区域与通道像素之间的关系,区分重要特征和非重要特征,加强高频信息的重构。

3)设计一种混合损失函数,利用L1损失函数和多尺度结构相似性损失函数,在训练过程中能够更好地保持图像的颜色和亮度,保留图像边缘和纹理细节等高频信息。

相关工作

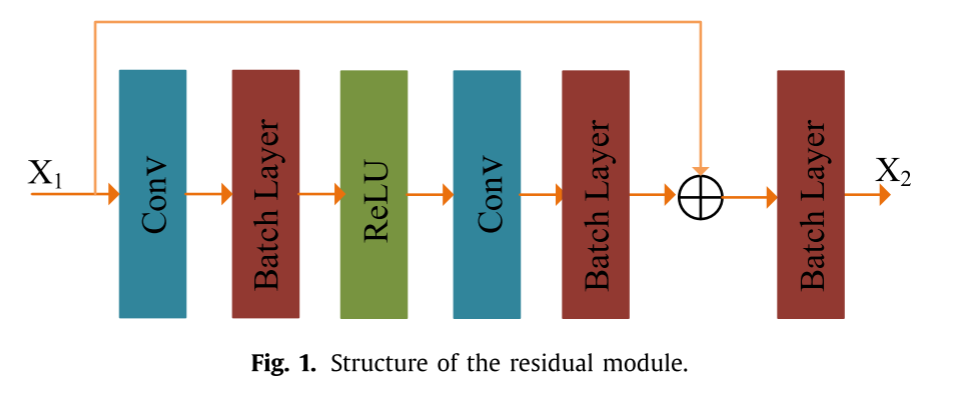

Residual learning

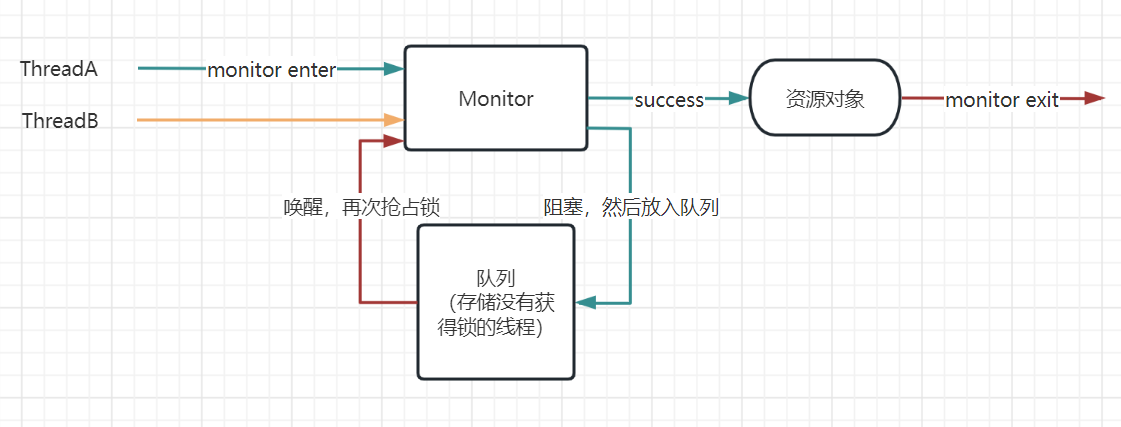

研究表明,神经网络越深入,能够提取的信息越充分,对后续处理越有利。但在实际应用中发现,单纯增加埋深会引起网络中的梯度色散问题。

虽然正则化可以避免这个问题,但它也可能导致网络降级问题。为此,He等人开发了残差网络,以保持网络的稳定性,增强信息的有效提取。该过程为:

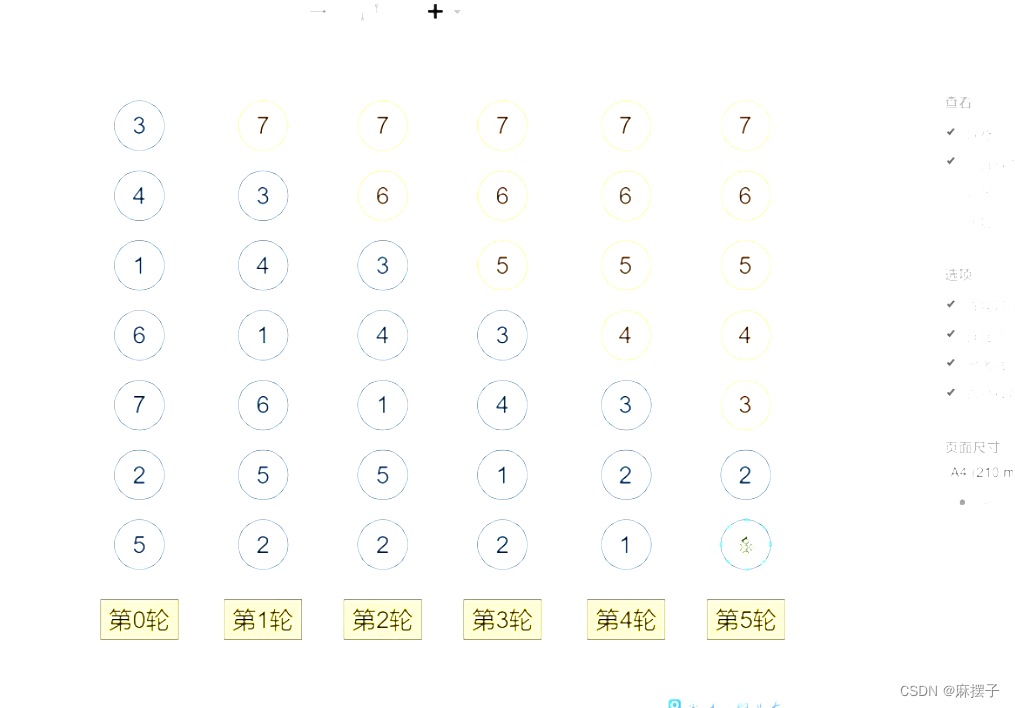

式中,∂x1为残差输入,∂x2为残差输出,w1为权值,b1为偏移量,D(x1,w1,b1)为残差过程学习图,其结构如图1所示。

Attention mechanism

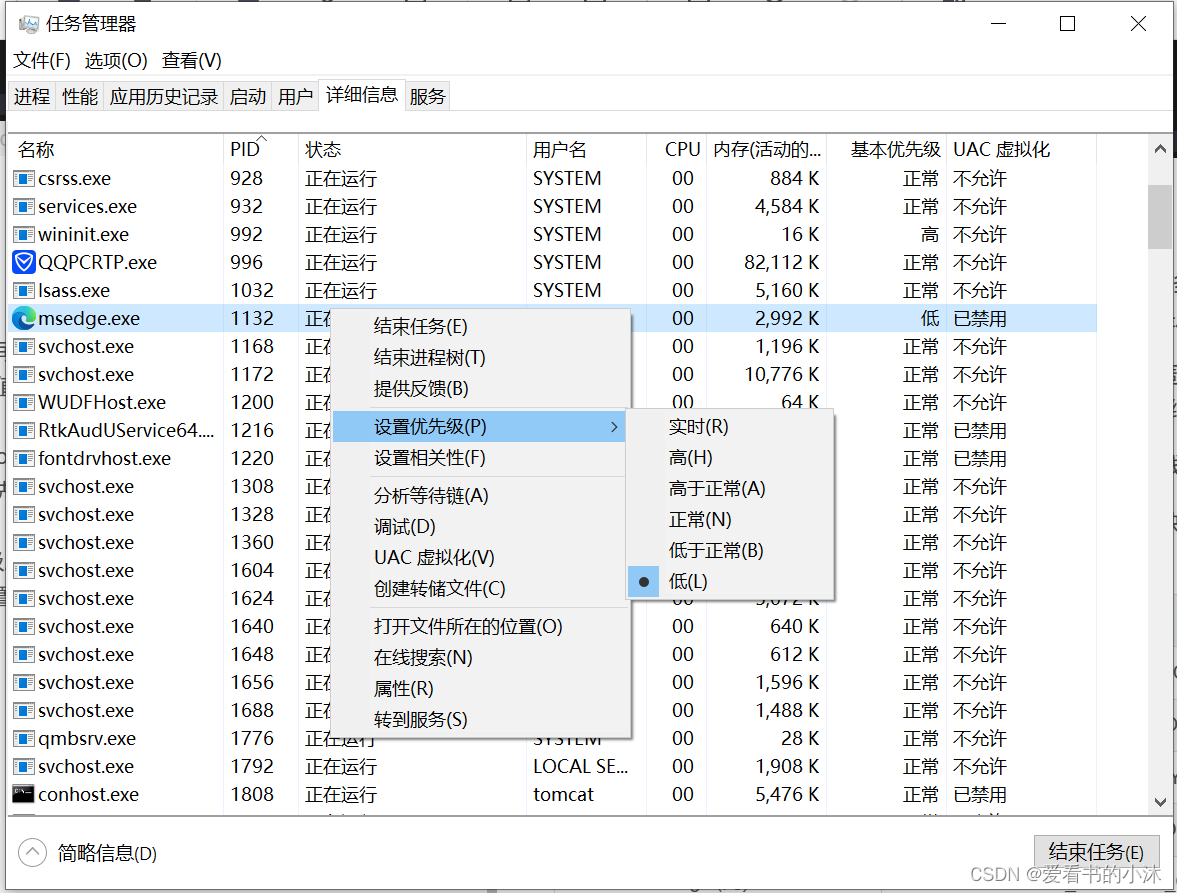

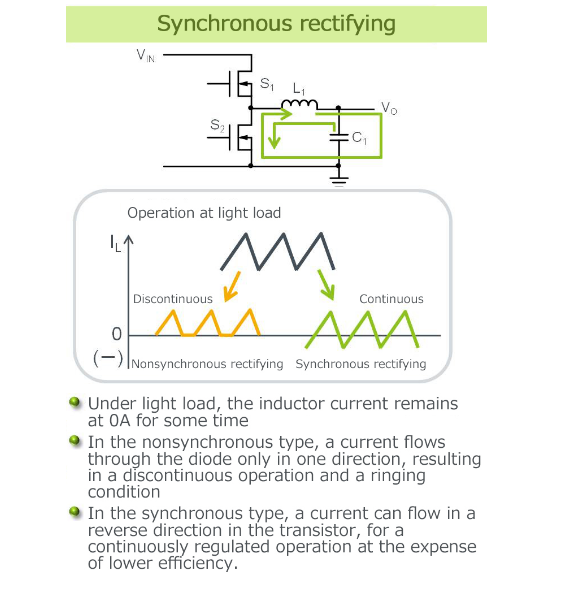

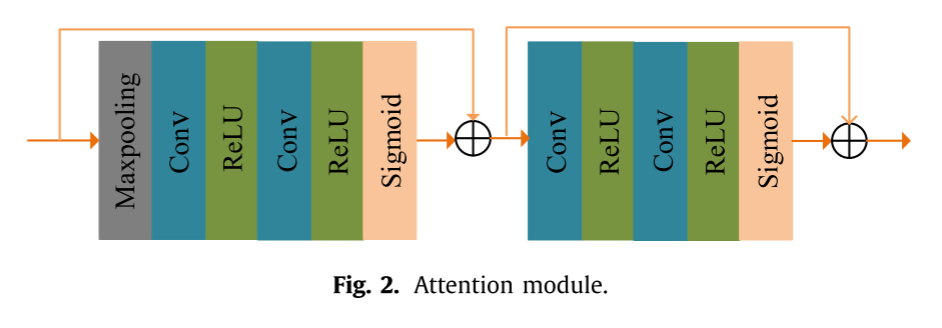

注意机制在计算机视觉任务中的应用越来越广泛。Wang等人提出了行人再识别的空间注意机制,更加关注空间位置提供的有价值信息。Hu等人提出了SENet,其使用挤压和激励(SE)模块来使网络能够集中于通道级别的关系,并在分类任务中实现显著结果。Zhang等人进一步将通道注意机制应用于SR任务。Woo等人提出的卷积模块的注意机制模型表明,每个特征通道空间内各个区域所包含的信息存在间隙,设置了双池结构,可能会降低重构精度。注意机制模块设计如图2所示。

在注意机制模块中,首先,通过最大池化将信道空间信息转换成信道描述符,如等式(1):

其中XC(i,j)表示位置(i,j)处的图像通道C的值,Zmp表示最大池化函数,H表示图像的高度,W表示图像的宽度。这里,相同大小的卷积核用于完全合并,因此特征图的大小从C ×H ×W转换为C ×1 ×1。然后将特征图输入到两个卷积层,以及ReLU激活函数和Sigmoid激活函数,如公式所示:

其中w为ReLU激活函数,σ为Sigmoid函数,Conv为卷积层函数,A C为输出权重,最后将对应的FC乘以AC,如公式所示:

F

∗

F^*

F∗C到下一级的输出与第一级不同。在这一阶段,没有pooling层,

F

∗

F^*

F∗C直接输入到两层卷积层,ReLU激活函数和Sigmoid激活函数也是如此:

其中Ap为输出的权值,最后将对应的

F

∗

F^*

F∗C与Ap相乘得到注意力模块的输出:

方法

DAMN网络直接从原始LR图像重建HR图像,其基本网络结构如图3所示。根据肺结节的特点,DAMN整体网络结构包括浅层特征提取模块、6个剩余注意机制模块(RAM)和重建模块3个部分。

在浅层特征提取部分中,选择单个卷积层来提取LR图像中的浅层特征信息F0,其可以通过以下公式来计算

其中,HSF表示浅层模块的卷积运算,ILR表示LR图像中包含的初始特征信息。

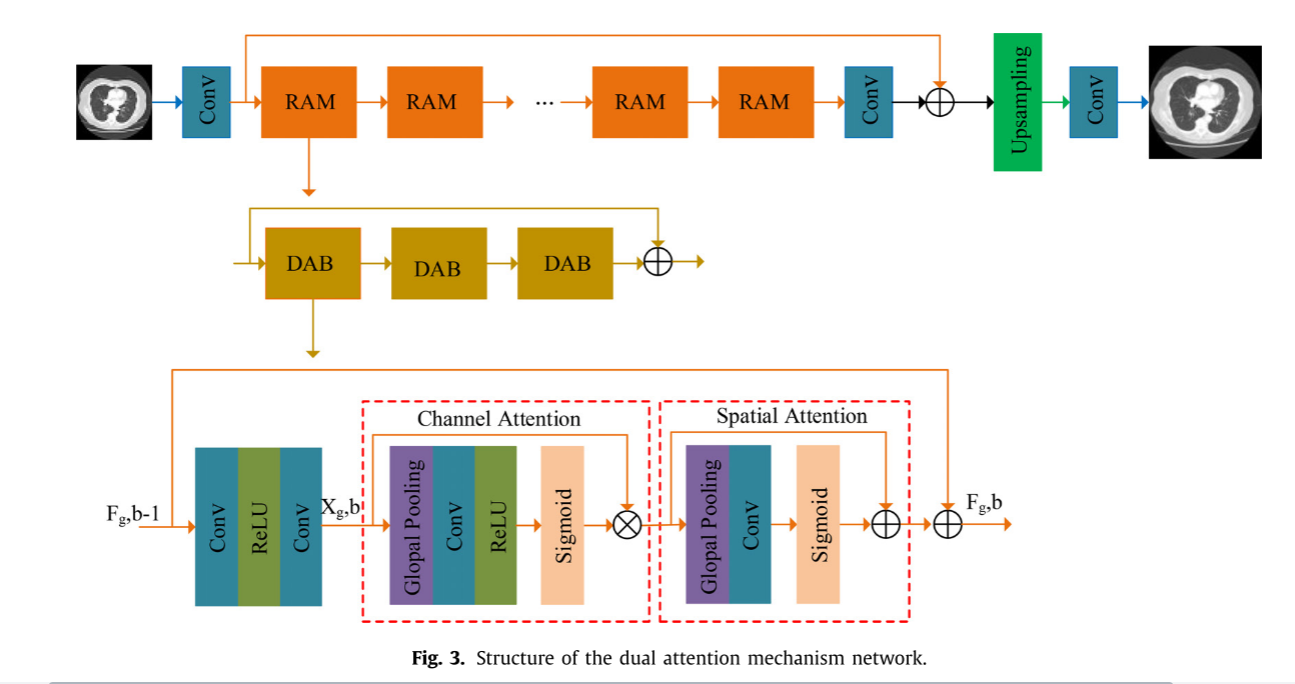

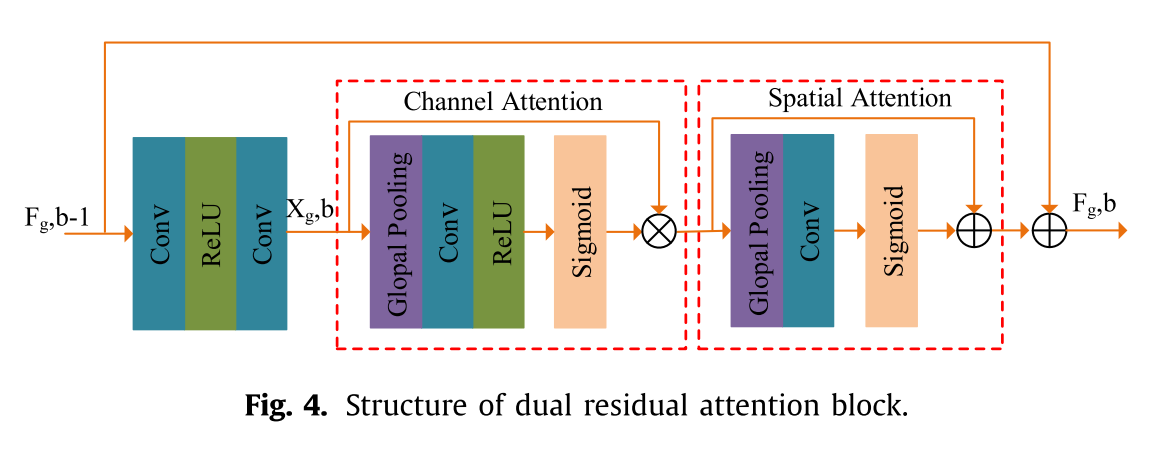

Residual attention module

大多数基于CNN的图像SR方法都是内部处理信息类型,可能无法有效区分细节特征之间的差异。换句话说,网络选择性地使用特征的能力是有限的。为此,设计了DAMN网络中的剩余注意机制模块。如图4所示,RAM注意模块由三个双残差注意块(DRAB)组成。每个DRAB由通道注意块(CA)和空间注意块(SA)两部分组成,考虑了各通道特性与单个通道空间的依赖性。

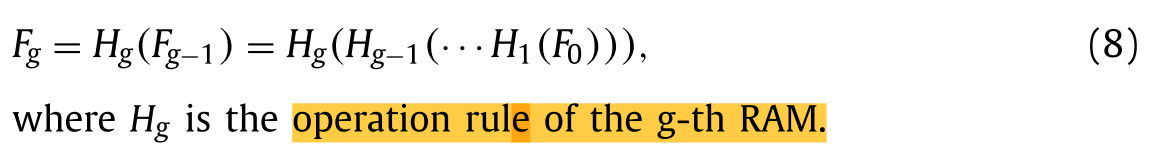

一方面,将得到的F0传送给后续的深度特征提取模块,通过多个串联的剩余注意力模块(RAM)进一步提取更深层次的特征信息。第g个RAM输出的信息Fg的计算公式如下:

另一方面,为了保留LR图像浅层特征中丰富的低频信息,提高网络层数加深时的性能,在DRAB中引入了长短跳跃连接(LSC)。将F0跳变传递到RG的输出端并相加,使最终得到的SR图像在有效保留图像低频特征的基础上,尽可能多地恢复图像的高频细节。LSC,我们设计了一个卷积层进一步增加浅特征提取模块的接受域和保护LR的图像尽可能浅的特性。输出FDF深特征提取模块的计算公式如下:

其中HLSC是LSC中引入的卷积运算,表示提交的RAM总数和第G个RAM模块的输出。

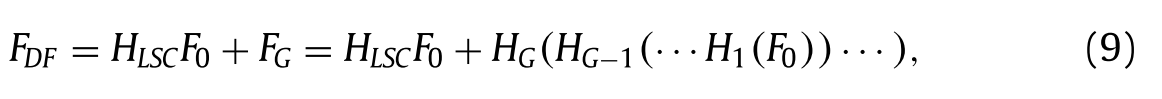

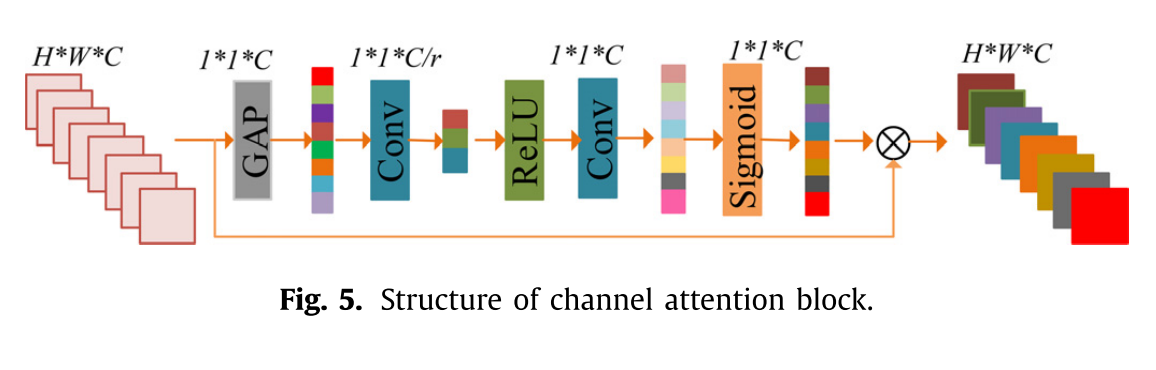

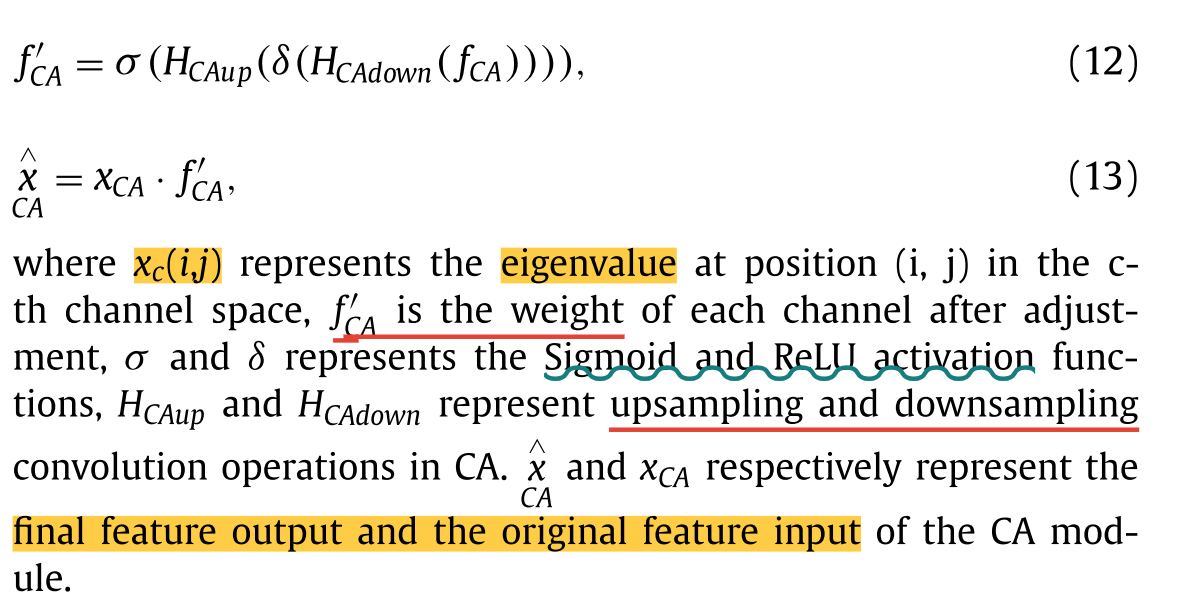

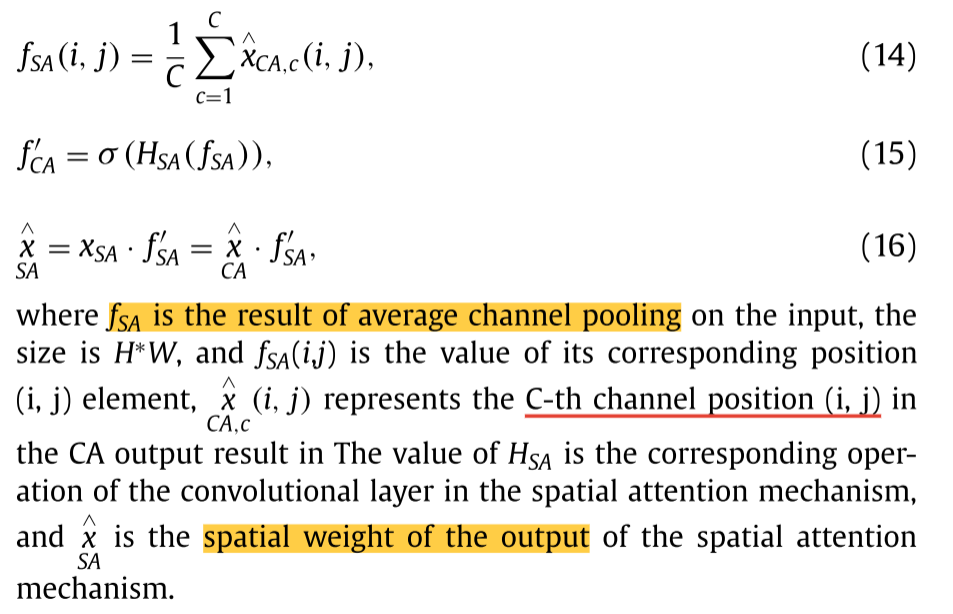

Channel attention block

注意机制帮助深度神经网络确定感兴趣区域,加强对感兴趣区域信息的利用。近年来,注意力机制逐渐成为深度学习的重要组成部分。其中,通道关注机制通过建立特征通道之间的相互依赖关系,自适应地重新分配每个特征通道的权重。与以往的重构算法对各通道提取的特征一视同仁相比,考虑CA后,可以对不同的通道特征进行差异化提取,有效降低了特征冗余,提高了整体特征利用效率。CA的具体结构如图5所示:

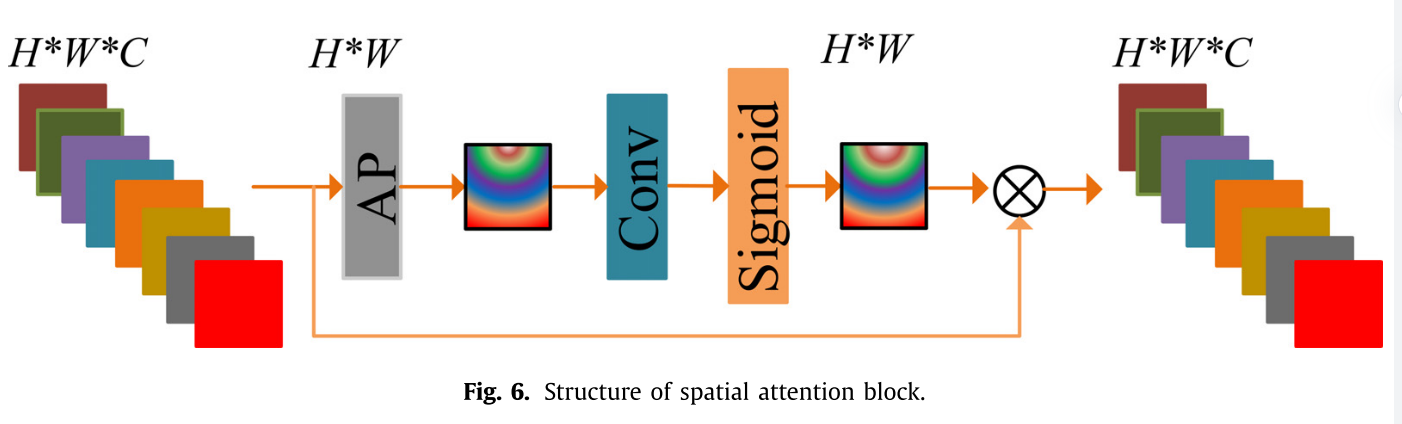

Spatial attention block

在引入通道关注度的同时,提出了一种空间特征关注度机制作为CA的补充,有效提取每个特征通道的内部信息,网络结构如图6所示。

使用平均池(AP)和单个卷积层,将CA传递的特征信息从原始大小H × W × C转换为空间注意力权重f`SA的尺寸为H × W。计算公式如下:

Loss function

重建图像I^SR应该接近对应于高频信息(例如结构和细节)的HR图像ILR。因此,研究人员在损失函数中引入了多尺度结构相似性(MS_SSIM)损失,但仅以MS_SSIM损失为参考,容易导致重建图像的颜色和亮度出现偏差,因此本文最终结合L1损失和MS_SSIM损失为总损失函数。

其中α为平衡参数,G为高斯分布变量,L1损失函数和LMS_SSIM损失函数的定义如下:

其中k是训练图片的数目,并且MS _ SSIM是多尺度结构相似性操作。

Reconstruction layer

在SR重构网络中,上采样提取模块作为网络重构的最后一步。需要根据所获得的特征信息来提高图像的最终分辨率。最常用的上采样方法是反卷积,但反卷积会产生大量的补零区域,导致不能合理利用已有的特征信息。甚至“不均匀重叠”现象也不利于重构结果。因此,网络的重建部分选择亚像素卷积模块以避免重叠的发生,并将其与单个卷积层组合以实现从LR图像到HR图像的重建。上采样重构之后的结果ISR表示如下:

其中HREC表示在上采样之后重构卷积层的操作,并且HUP表示上采样的操作。