一、什么是Hadoop

Hadoop是一个适合大数据存储和计算的分布式框架

Hadoop广义狭义之分

狭义上Hadoop指Hadoop框架

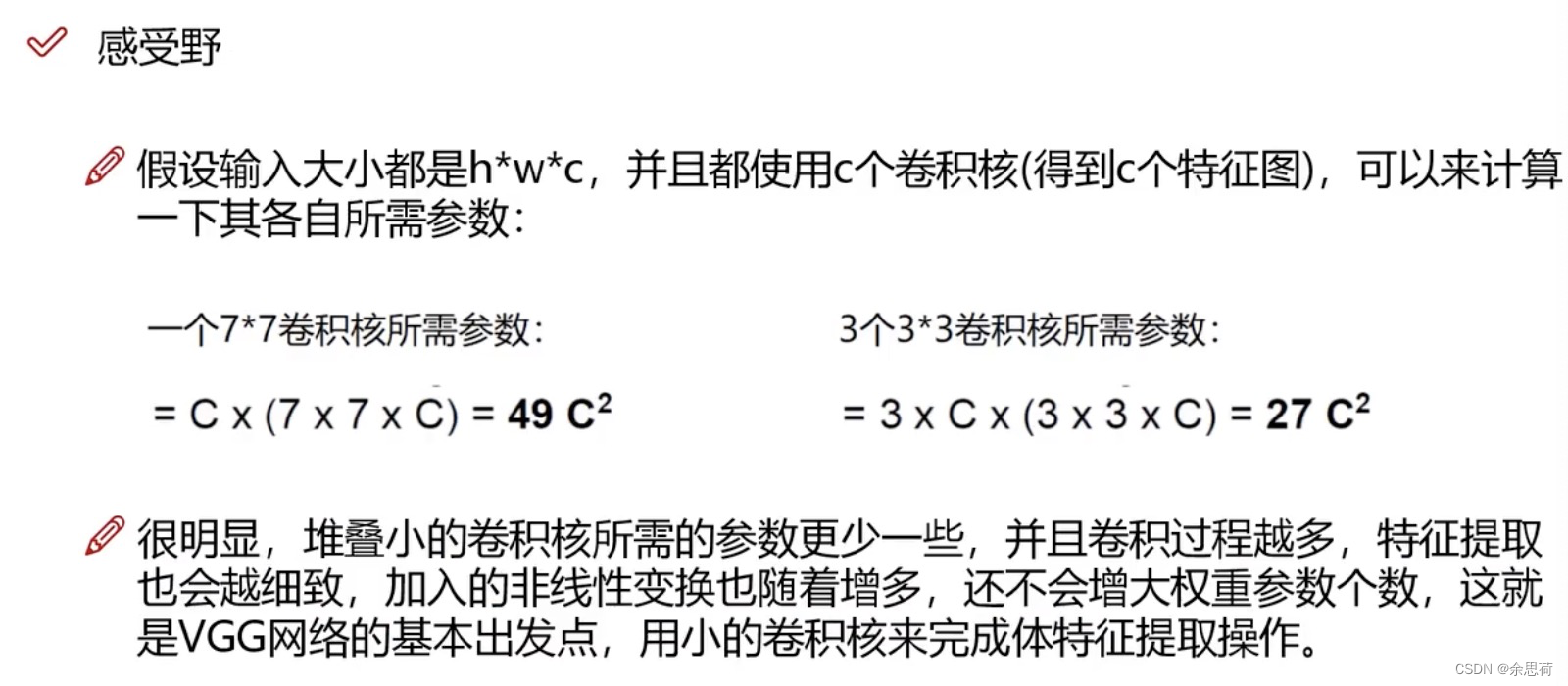

广义上随着大数据技术的发展,Hadoop也发展成了一个生态圈,包含:

Sqoop:Sqoop是一款开源的工具,主要用于在Hadoop、Hive与传统的数据库(MySql)间进行数据的传递,可以将一个关系型数据库(例如:MySQL,Oracle 等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

Flume:Flume是一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;

Kafka:Kafka是一种高吞吐量的分布式发布订阅消息系统;

Spark:Spark是当前最流行的开源大数据内存计算框架。可以基于Hadoop上存储的大数据进行计算。

Flink:Flink是当前最流行的开源大数据内存计算框架。用于实时计算的场景较多。

Oozie:Oozie是一个管理Hdoop作业(job)的工作流程调度管理系统。

Hbase:HBase是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

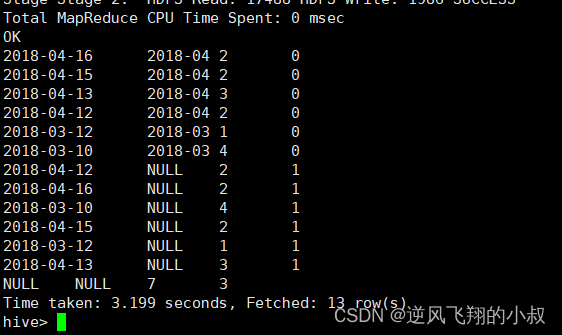

Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

ZooKeeper:它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。

大数据生态体系

二、Hadoop发展史

1、Lucene框架是Doug Cutting开创的开源软件,用Java书写代码,实现全文搜索功能。Lucene不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部分文本分析引擎(英文与德文两种西方语言)

2、2001年底Lucene称为Apache基金会的的一个子项目。

3、对于海量数据场景,Lucene面对与Google同样的困难,存储数据困难,检索速度慢。

4、为提高Lucene性能Doug Cutting开发出Nutch。它提供了我们运行自己的搜索引擎所需的全部工具。包括全文搜索和Web爬虫。

5、Google发表Haddop思想之源的三篇论文,GFS、Map-Reduce、BigTable,其中公开了部分GFSheMapReduce思想的细节,Doug Cuttin以此为基础,实现了DFS和MapReduce机制,使Nutch性能飙升

6、2005年,Hadoop作为Lucene的子项目—Nutch的一部分正式引入Apache基金会

7、2006年,Map-Reduce和Nutch Distributed File System(NDFS)分别被纳入到Hadoop项目中,Hadoop就此诞生,标志着大数据时代的来临

Hadoop三大发行版本:Apache、Cloudera、Hortonworks。

Apache Hadoop 版本最原始(最基础)的版本

Cloudera Hadoop 在大型互联网企业中用的较多

(1)2008年成立的Cloudera是最早将Hadoop商用的公司,为合作伙伴提供Hadoop的商用解决方案,主要是包括支持、咨询服务、培训。

(2)2009年Hadoop的创始人Doug Cutting也加盟Cloudera公司。Cloudera产品主要为CDH,Cloudera Manager,Cloudera Support

(3)CDH是Cloudera的Hadoop发行版,完全开源,比Apache Hadoop在兼容性,安全性,稳定性上有所增强。

(4)Cloudera Manager是集群的软件分发及管理监控平台,可以在几个小时内部署好一个Hadoop集群,并对集群的节点及服务进行实时监控。Cloudera Support即是对Hadoop的技术支持。

(5)Cloudera的标价为每年每个节点4000美元。Cloudera开发并贡献了可实时处理大数据的Impala项目。

Hortonworks Hadoop

(1)2011年成立的Hortonworks是雅虎与硅谷风投公司Benchmark Capital合资组建。

(2)公司成立之初就吸纳了大约25名至30名专门研究Hadoop的雅虎工程师,上述工程师均在2005年开始协助雅虎开发Hadoop,贡献了Hadoop80%的代码。

(3)雅虎工程副总裁、雅虎Hadoop开发团队负责人Eric Baldeschwieler出任Hortonworks的首席执行官。

(4)Hortonworks的主打产品是Hortonworks Data Platform(HDP),也同样是100%开源的产品,HDP除常见的项目外还包括了Ambari,一款开源的安装和管理系统。

(5)HCatalog,一个元数据管理系统,HCatalog现已集成到Facebook开源的Hive中。Hortonworks的Stinger开创性的极大的优化了Hive项目。Hortonworks为入门提供了一个非常好的,易于使用的沙盒。

(6)Hortonworks开发了很多增强特性并提交至核心主干,这使得Apache Hadoop能够在包括Window Server和Windows Azure在内的Microsoft Windows平台上本地运行。定价以集群为基础,每10个节点每年为12500美元。

三、Hadoop优缺点

优点:

1)高可靠性:底层维护多个数据副本,即使Hadoop某个计算单元素或存储出现故障,也不会导致数 据丢失。某个副本丢失以后,可以自动恢复。

2)搞扩展性:在集群间分配任务数据,可方便的扩展数以千计的节点。

3)高效性:在MapReduce思想下,Hadoop是并行工作的,以加快任务处理速度。

4)高容错性:能自动将失败的任务重新分配。

5)低成本:与一体机、商用数据仓库以及QlikView、Yonghong Z-Suite等数据集市相比,Hadoop 是开源的,项目的软件成本因此会大大降低

缺点:

1)不适合低延时数据访问,比如毫秒级的存储数据,是做不到的。

2)无法高效的对大量小文件进行存储。

a.存储大量小文件的话,会占用NameNode大量的内存来存储文件目录和块信息;

b.小文件存储的寻址时间会超过读取时间,违反了HDFS的设计目标

3)不支持并发写入、文件随机修改。

a.一个文件只允许同时有一个写,不允许多线程同时写入;

b.不支持文件的随机修改。

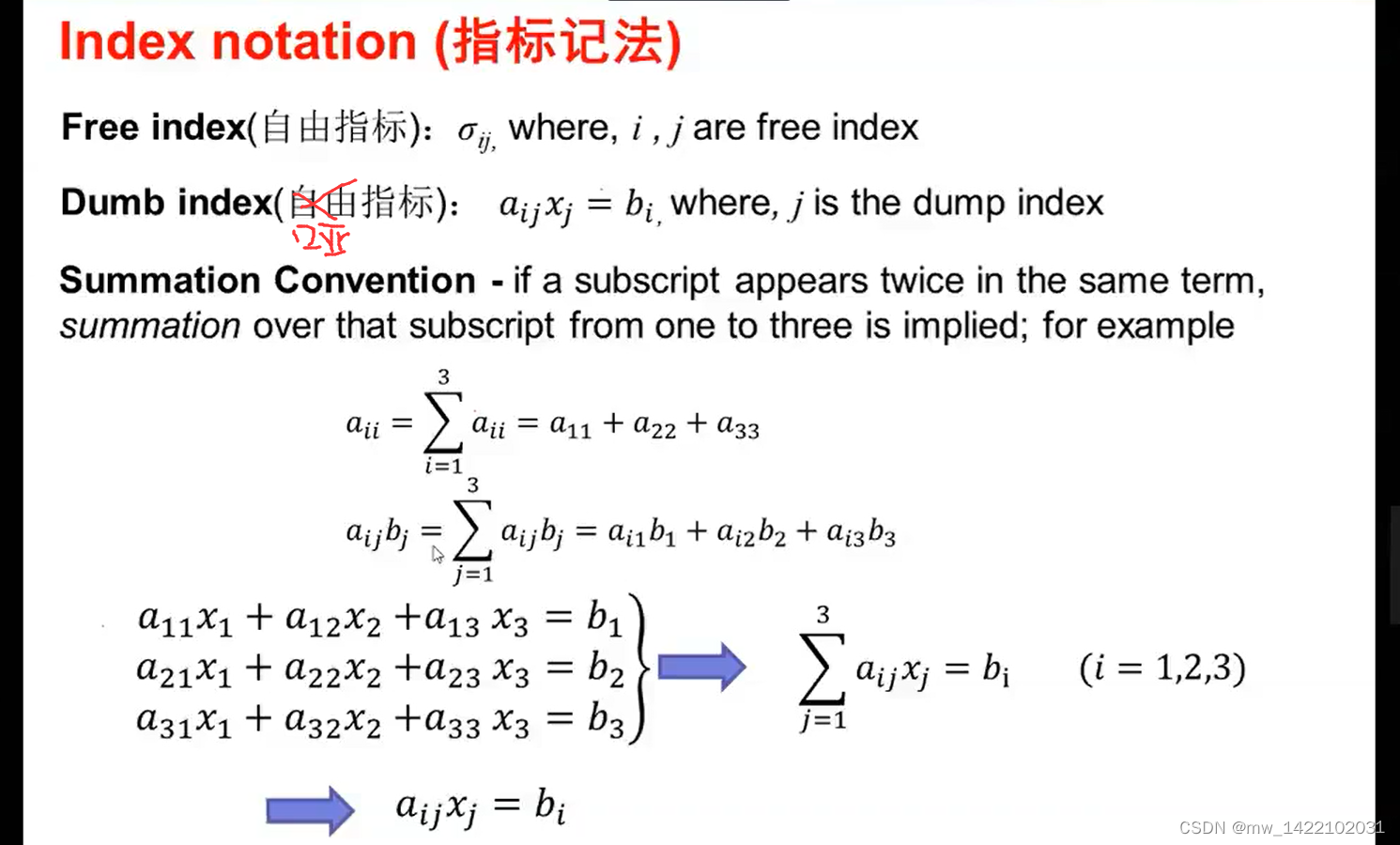

四、Hadoop组成

在Hadoop1.0时代,MapReduce同时处理业务逻辑运算和资源的调度,耦合性较大;

在Hadoop2.0时代,增加了Yarn。Yarn只负责资源的调度,MapReduce只负责运算

Hadoop3.0基于JDK 1.8,引入了一些重要的功能和优化,包括HDFS 可擦除编码、多Namenode支持、MR Native Task优化、YARN基于cgroup的内存和磁盘IO隔离、YARN container resizing等。

hadoop3.x以后将会调整方案架构,将Mapreduce 基于内存+io+磁盘,共同处理数据。改变最大的是hdfs,hdfs 通过最近block块计算,根据最近计算原则,本地block块,加入到内存,先计算,通过IO,共享内存计算区域,最后快速形成计算结果,比Spark快10倍。

HDFS:

HDFS是一个分布式的文件系统,适合一次写入,多次读出的场景,且不支持文件内容的修改。适合数据分析,不适合做网盘。

NameNode:管理HDFS的命名空间、配置副本策略、管理数据块信息、处理客户端读写请求

DataNode:存储实际的数据块、执行数据块的读、写操作

Secondary Namenode:辅助NameNode,分担其工作量,比如定期合并Fsimage和Edits,并推送给NameNode,紧急情况下,可辅助回复NameNode(非HA情况下)

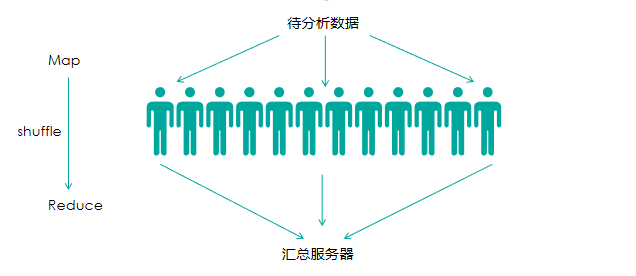

MapReduce

一个分布式运算程序的编程框架。其核心功能是将用户编写的业务逻辑代码和自带默认组件整合成一个完整的分布式运算程序,并运行在一个Hadoop集群上。

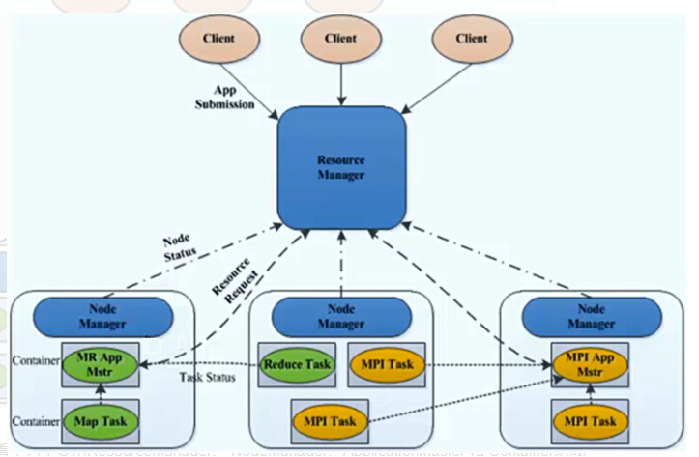

Yarn

Yarn是一个资源调度平台,负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台。而MapReduce等运算程序则相当于运行于操作系统之上的应用程序。

ResourceManager:处理客户端请求、监控NodeManager、启动或监控ApplicationMaster、资源的分配与调度

NodeManager:管理单个节点的资源、处理来自ResourceManager和ApplicationMaster的命令

ApplicationMaster :数据切分、为应用程序申请资源并分配给内部的任务、任务监控与容错

Container:是Yarn中的资源抽象,封装了某个节点上的多维度资源,内存、CPU、磁盘、网络等