更多数字生产力内容,欢迎关注我的公众号“ONE生产力”。

先前的文章中,我们已经介绍使用LM Studio在本地环境中运行Phi-3。LM Studio是一款革命性的桌面应用程序,它允许用户在自己的计算机上本地运行、管理和部署大型语言模型,但有朋友希望有工具能够更好的利用本地语言模型进行开发,今天我就向大家隆重介绍VS Code AI Toolkit,通过AI Toolkit,我们就可以在熟悉的VS Code中实现:

- 在本地运行预先优化的 AI 模型:快速开始使用为各种设置设计的模型,包括使用 DirectML 加速或直接 CPU 运行的 Windows 11、带有 NVIDIA GPU 的 Linux 或仅限 CPU 的环境。

- 无缝测试和集成模型:在用户友好的游乐场中试验模型,或使用 REST API 将它们直接合并到您的应用程序中。

- 根据特定需求对模型进行微调:在本地或云端定制预先训练的模型(如流行的 SLM Phi-3 和 Mistral),以增强性能、定制响应并控制其风格。

- 部署您的 AI 功能:选择云部署或将其嵌入到您的设备应用程序中。

本系列我们将包含两篇文章,今天第一篇我们将继续以Phi-3模型为例,介绍如何通过AI Toolkit在VS Code中使用本地模型,下篇我们将介绍如何通过AI Toolkit在VS Code中微调Phi-3模型。

准备

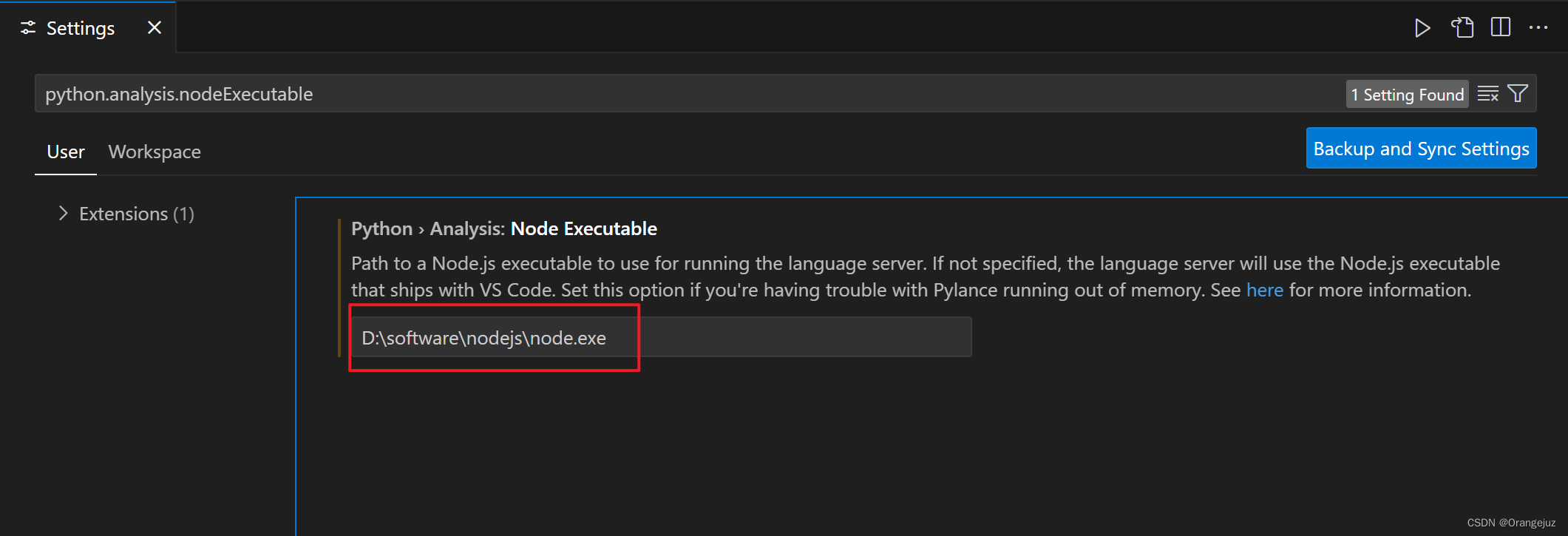

在开始之前,请先准备好您的Visual Studio Code,您可以参考官方教程配置您的VS Code环境:

Getting started with Visual Studio Code。

安装VSC AI Toolkit

AI Toolkit 在 Visual Studio Marketplace 中提供,可以像安装任何其他 VS Code 扩展一样进行安装。

如果不熟悉如何安装 VS Code 扩展,则请执行以下步骤:

- 在 VS Code 中的活动栏中,选择“扩展”

- 在“扩展搜索”栏中键入“AI Toolkit”

- 选择“适用于 Visual Studio Code 的 AI Toolkit”

- 选择“安装”

安装扩展后,你会看到 AI Toolkit 图标显示在“活动栏”中。

下载模型

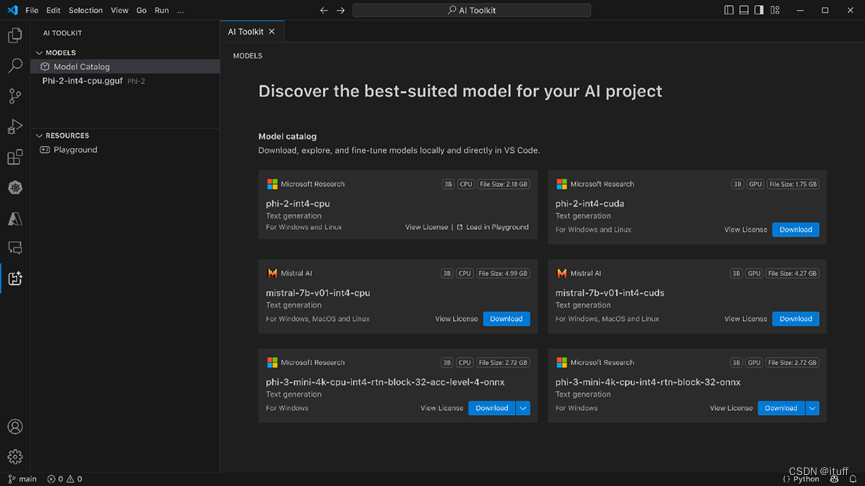

在AI Toolkit中,您将看到模型和资源两部分:

模型部分包含:

模型目录

资源部分包含:

模型Playground

模型微调

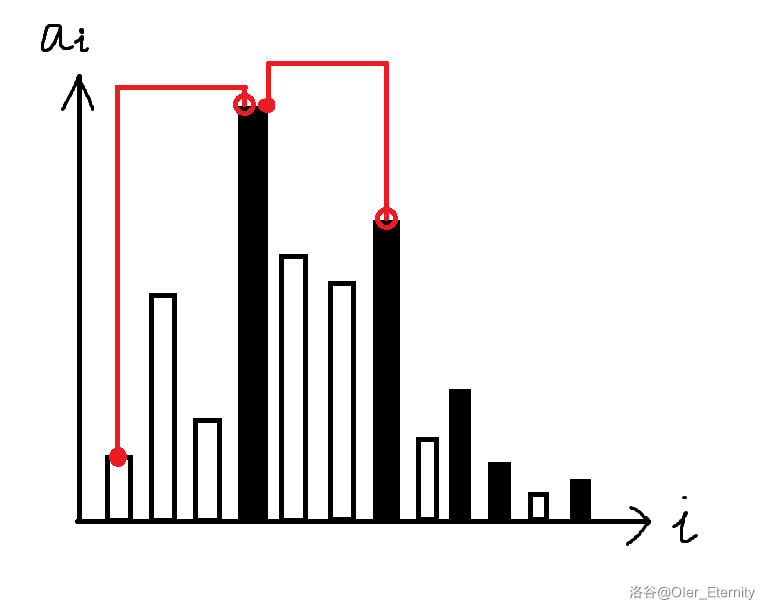

我们在模型目录中选择并下载适合我们用例的模型。AI Toolkit 提供了已针对 Windows 优化的公开 AI 模型集合。这些模型存储在不同的位置,包括 Hugging Face、GitHub 等(备注:如果您在中国大陆,请注意您的网络环境能否访问上述站点),但我们可以浏览这些模型并在一个地方找到所有模型,随时可以在 Windows 应用程序中下载和使用。

我们还可以找到每个模型的模型卡,检查模型的各种参数,以便进一步决定为特定应用选择哪一个。一些详细信息,如模型预训练的参数数量、对 CPU 或 GPU 的依赖性、模型的大小都可以在这里找到。最后,在决定之后,可以使用每个模型的“下载”按钮下载模型。可以下载任意数量的模型。

运行模型

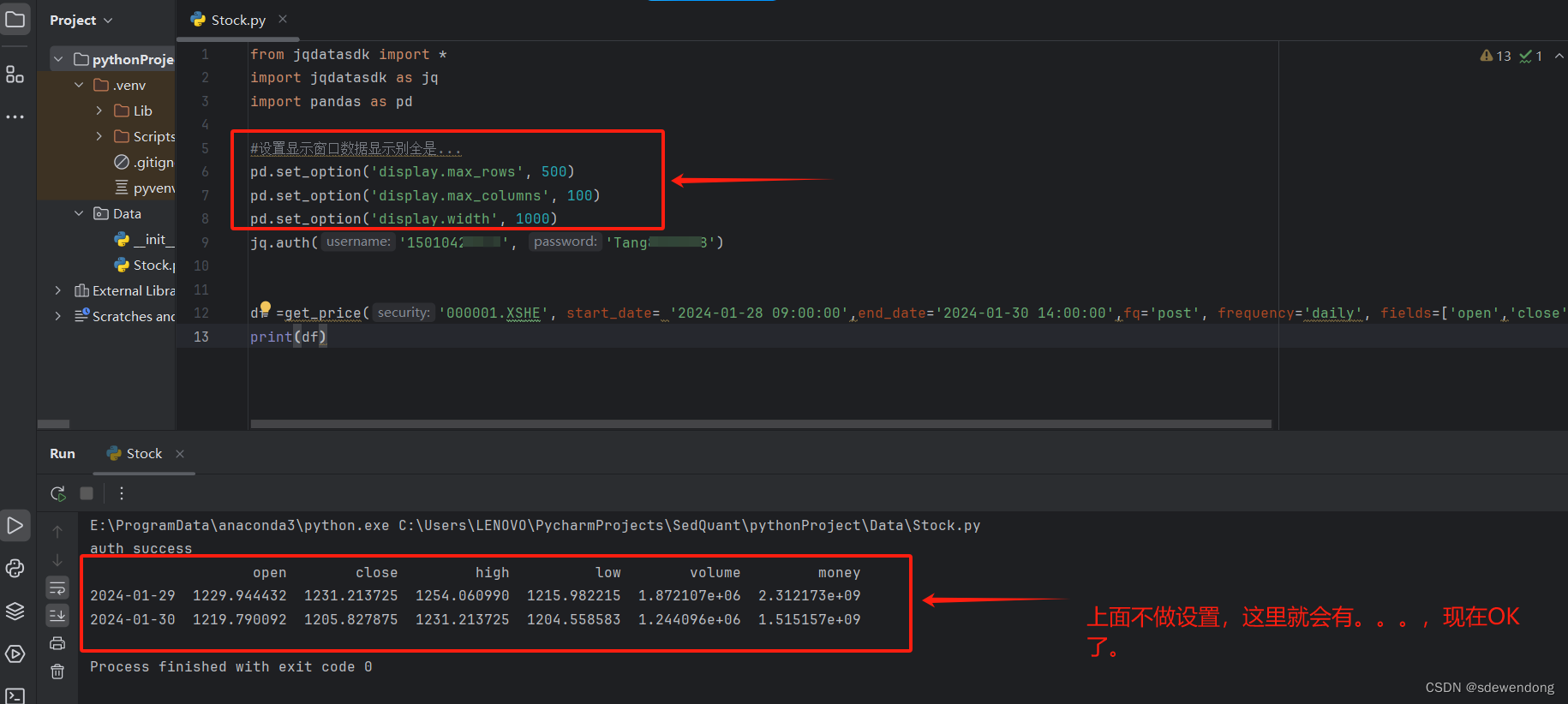

下载模型后,在目录中的模型卡上选择“在Playground中加载”:

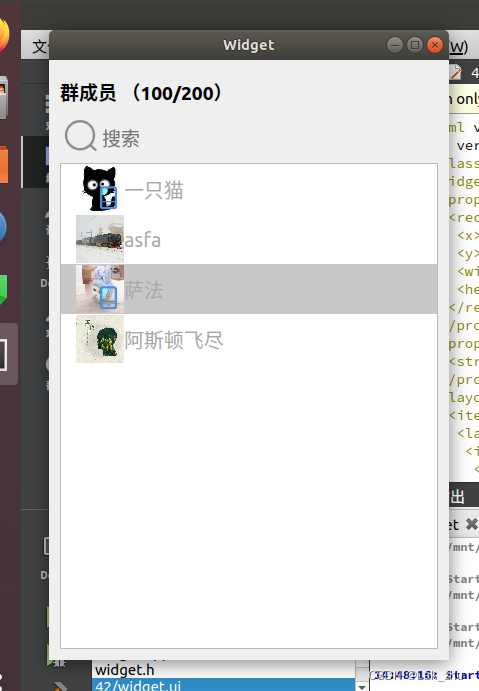

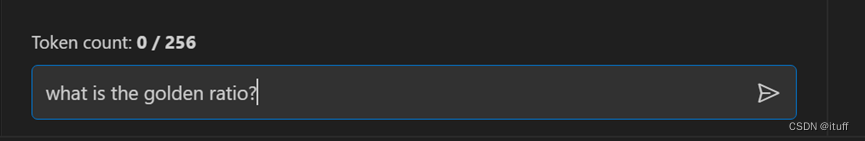

在Playground的聊天界面中,输入以下消息,然后按 Enter 键:

你应会看到流式传输回来的模型回复:

同时您还可以配置上下文说明和推理参数,从而获得更好的答案。

与现有AI应用集成

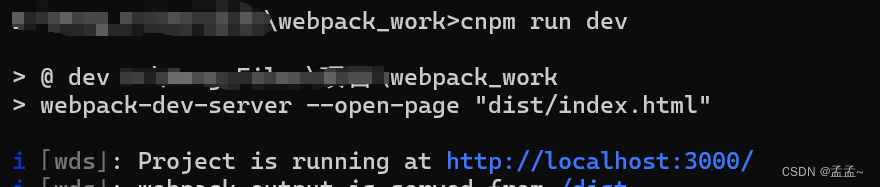

和LM Studio、Ollama一样,AI Toolkit 也附带本地 REST API Web 服务器,其使用OpenAI兼容接口来提供模型。 这样,便可以使用终结点 http://127.0.0.1:5272/v1/chat/completions 在本地测试应用程序,而无需依赖云 AI 模型服务。 如果打算在生产中切换到云终结点,请使用此选项。 可使用 OpenAI 客户端库连接到 Web 服务器。

总结

Visual Studio Code AI Toolkit 是一个为 Visual Studio Code 设计的扩展,它提供了一系列强大的功能,包括下载、测试、微调 AI 模型以及使用应用或云部署 AI 模型的能力。相较于 LM Studio 和 Ollama,AI Toolkit与 Visual Studio Code 的深度集成,具有更好的继承性和易用性。此外,它支持广泛的模型操作,包括模型的发现、下载和运行,以及与云服务的无缝整合,使得模型的开发和部署更加便捷。

参考文献

适用于 Visual Studio Code 的 AI Toolkit 入门指南 | Microsoft Learn

Visual Studio Code AI Toolkit: How to Run LLMs locally