1 功能要求

使用SpringBoot和redis实现一个简单的热搜功能,具备以下功能:

- 搜索栏展示当前登陆的个人用户的搜索历史记录,删除个人历史记录

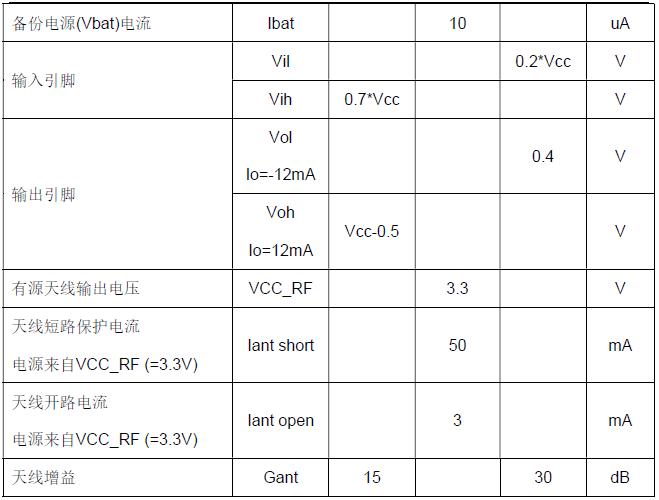

- 用户在搜索栏输入某字符,则将该字符记录下来 以zset格式存储的redis中,记录该字符被搜索的个数以及当前的时间戳 (用了DFA算法,感兴趣的自己百度学习吧)

- 每当用户查询了已在redis存在了的字符时,则直接累加个数, 用来获取平台上最热查询的十条数据。(可以自己写接口或者直接在redis中添加一些预备好的关键词)

- 最后还要做不雅文字过滤功能

代码实现热搜与个人搜索记录功能,主要controller层下几个方法就行了 :

- 向redis 添加热搜词汇(添加的时候使用下面不雅文字过滤的方法来过滤下这个词汇,合法再去存储

- 每次点击给相关词热度 +1

- 根据key搜索相关最热的前十名

- 插入个人搜索记录

- 查询个人搜索记录

2 代码实现

2.1 项目结构如下

2.2 引入相关maven依赖

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.springframework.boot/spring-boot-starter-data-redis -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

<version>2.7.0</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.commons/commons-lang3 -->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-lang3</artifactId>

<version>3.12.0</version>

</dependency>

</dependencies>2.3 application.yml配置

spring:

redis:

#数据库索引

database: 0

host: 192.168.222.131

port: 6379

password: 123456

lettuce:

pool:

#最大连接数

max-active: 8

#最大阻塞等待时间(负数表示没限制)

max-wait: -1

#最大空闲

max-idle: 8

#最小空闲

min-idle: 0

#连接超时时间

timeout: 100002.4 创建RedisKeyUtils工具类

package com.example.demo.Utils;

public class RedisKeyUtils {

/**

* 分隔符号

*/

private static final String SPLIT = ":";

private static final String SEARCH = "search";

private static final String SEARCH_HISTORY = "search-history";

private static final String HOT_SEARCH = "hot-search";

private static final String SEARCH_TIME = "search-time";

/**

* 每个用户的个人搜索记录hash

*/

public static String getSearchHistoryKey(String userId){

return SEARCH + SPLIT + SEARCH_HISTORY + SPLIT + userId;

}

/**

* 总的热搜zset

*/

public static String getHotSearchKey(){

return SEARCH + SPLIT + HOT_SEARCH;

}

/**

* 每个搜索记录的时间戳记录:key-value

*/

public static String getSearchTimeKey(String searchKey){

return SEARCH + SPLIT + SEARCH_TIME + SPLIT + searchKey;

}

}

2.5 核心搜索文件

redis搜索接口:

package com.example.demo.Service;

import java.util.List;

public interface RedisService {

//新增一条该userid用户在搜索栏的历史记录

//searchkey 代表输入的关键词

int addSearchHistoryByUserId(String userid, String searchkey);

//删除个人历史数据

Long delSearchHistoryByUserId(String userid, String searchkey);

//获取个人历史数据列表

List<String> getSearchHistoryByUserId(String userid);

//新增一条热词搜索记录,将用户输入的热词存储下来

int incrementScoreByUserId(String searchkey);

//根据searchkey搜索其相关最热的前十名 (如果searchkey为null空,则返回redis存储的前十最热词条)

List<String> getHotList(String searchkey);

//每次点击给相关词searchkey热度 +1

int incrementScore(String searchkey);

}

接口实现类:

package com.example.demo.Service.Impl;

import com.example.demo.Service.RedisService;

import com.example.demo.Utils.RedisKeyUtils;

import org.apache.commons.lang3.StringUtils;

import org.springframework.data.redis.core.*;

import org.springframework.stereotype.Service;

import org.springframework.transaction.annotation.Transactional;

import javax.annotation.Resource;

import java.util.*;

import java.util.concurrent.TimeUnit;

@Transactional

@Service("redisService")

public class RedisServiceImpl implements RedisService {

//导入数据源

// @Resource(name = "redisSearchTemplate")

@Resource

private StringRedisTemplate redisSearchTemplate;

//新增一条该userid用户在搜索栏的历史记录

//searchkey 代表输入的关键词

@Override

public int addSearchHistoryByUserId(String userid, String searchkey) {

String shistory = RedisKeyUtils.getSearchHistoryKey(userid);

boolean b = redisSearchTemplate.hasKey(shistory);

if (b) {

Object hk = redisSearchTemplate.opsForHash().get(shistory, searchkey);

if (hk != null) {

return 1;

}else{

redisSearchTemplate.opsForHash().put(shistory, searchkey, "1");

}

}else{

redisSearchTemplate.opsForHash().put(shistory, searchkey, "1");

}

return 1;

}

//删除个人历史数据

@Override

public Long delSearchHistoryByUserId(String userid, String searchkey) {

String shistory = RedisKeyUtils.getSearchHistoryKey(userid);

return redisSearchTemplate.opsForHash().delete(shistory, searchkey);

}

//获取个人历史数据列表

@Override

public List<String> getSearchHistoryByUserId(String userid) {

List<String> stringList = null;

String shistory = RedisKeyUtils.getSearchHistoryKey(userid);

boolean b = redisSearchTemplate.hasKey(shistory);

if(b){

Cursor<Map.Entry<Object, Object>> cursor = redisSearchTemplate.opsForHash().scan(shistory, ScanOptions.NONE);

while (cursor.hasNext()) {

Map.Entry<Object, Object> map = cursor.next();

String key = map.getKey().toString();

stringList.add(key);

}

return stringList;

}

return null;

}

//新增一条热词搜索记录,将用户输入的热词存储下来

@Override

public int incrementScoreByUserId(String searchkey) {

Long now = System.currentTimeMillis();

ZSetOperations zSetOperations = redisSearchTemplate.opsForZSet();

ValueOperations<String, String> valueOperations = redisSearchTemplate.opsForValue();

List<String> title = new ArrayList<>();

title.add(searchkey);

for (int i = 0, lengh = title.size(); i < lengh; i++) {

String tle = title.get(i);

try {

if (zSetOperations.score("title", tle) <= 0) {

zSetOperations.add("title", tle, 0);

valueOperations.set(tle, String.valueOf(now));

}

} catch (Exception e) {

zSetOperations.add("title", tle, 0);

valueOperations.set(tle, String.valueOf(now));

}

}

return 1;

}

//根据searchkey搜索其相关最热的前十名 (如果searchkey为null空,则返回redis存储的前十最热词条)

@Override

public List<String> getHotList(String searchkey) {

String key = searchkey;

Long now = System.currentTimeMillis();

List<String> result = new ArrayList<>();

ZSetOperations zSetOperations = redisSearchTemplate.opsForZSet();

ValueOperations<String, String> valueOperations = redisSearchTemplate.opsForValue();

Set<String> value = zSetOperations.reverseRangeByScore("title", 0, Double.MAX_VALUE);

//key不为空的时候 推荐相关的最热前十名

if(StringUtils.isNotEmpty(searchkey)){

for (String val : value) {

if (StringUtils.containsIgnoreCase(val, key)) {

if (result.size() > 9) {//只返回最热的前十名

break;

}

Long time = Long.valueOf(valueOperations.get(val));

if ((now - time) < 2592000000L) {//返回最近一个月的数据

result.add(val);

} else {//时间超过一个月没搜索就把这个词热度归0

zSetOperations.add("title", val, 0);

}

}

}

}else{

for (String val : value) {

if (result.size() > 9) {//只返回最热的前十名

break;

}

Long time = Long.valueOf(valueOperations.get(val));

if ((now - time) < 2592000000L) {//返回最近一个月的数据

result.add(val);

} else {//时间超过一个月没搜索就把这个词热度归0

zSetOperations.add("title", val, 0);

}

}

}

return result;

}

//每次点击给相关词searchkey热度 +1

@Override

public int incrementScore(String searchkey) {

String key = searchkey;

Long now = System.currentTimeMillis();

ZSetOperations zSetOperations = redisSearchTemplate.opsForZSet();

ValueOperations<String, String> valueOperations = redisSearchTemplate.opsForValue();

zSetOperations.incrementScore("title", key, 1);

valueOperations.getAndSet(key, String.valueOf(now));

return 1;

}

}

2.6 不雅字过滤

实现原理

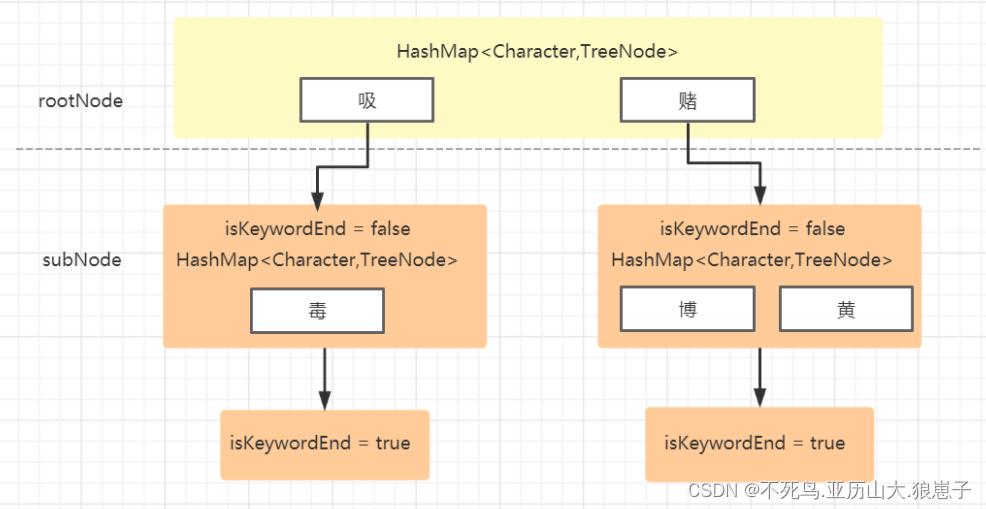

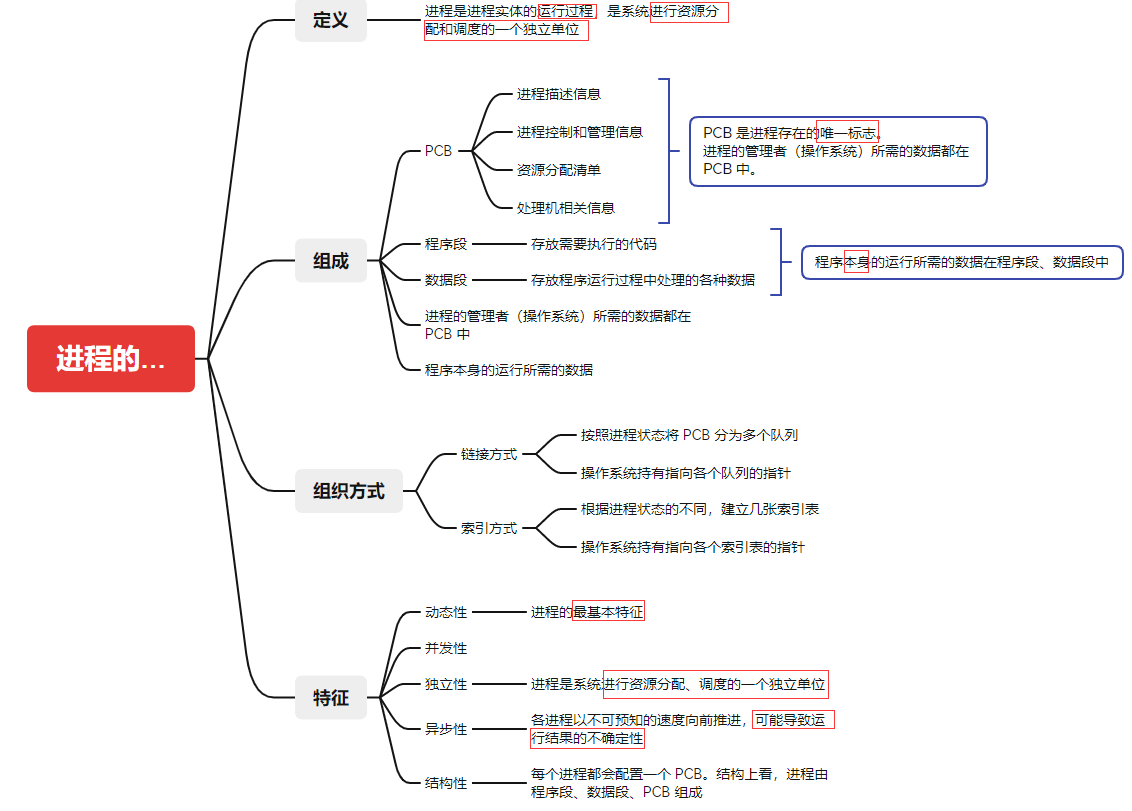

简单原理如下图所示,使用了DFA算法,创建结点类,里面包含是否是敏感词结束符,以及一个HashMap,哈希里key值存储的是敏感词的一个词,value指向下一个结点(即指向下一个词),一个哈希表中可以存放多个值,比如赌博、赌黄这两个都是敏感词。

实现方法

敏感词库的初始化,这里主要工作是读取敏感词文件,在内存中构建好敏感词的Map节点。

package com.example.demo.Config;

import org.springframework.context.annotation.Configuration;

import org.springframework.core.io.ClassPathResource;

import java.io.*;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import java.util.Set;

//屏蔽敏感词初始化

@Configuration

@SuppressWarnings({ "rawtypes", "unchecked" })

public class SensitiveWordInit {

// 字符编码

private String ENCODING = "UTF-8";

// 初始化敏感字库

public Map initKeyWord() throws IOException {

// 读取敏感词库 ,存入Set中

Set<String> wordSet = readSensitiveWordFile();

// 将敏感词库加入到HashMap中//确定有穷自动机DFA

return addSensitiveWordToHashMap(wordSet);

}

// 读取敏感词库 ,存入HashMap中

private Set<String> readSensitiveWordFile() throws IOException {

Set<String> wordSet = null;

ClassPathResource classPathResource = new ClassPathResource("static/word1.txt");

InputStream inputStream = classPathResource.getInputStream();

//敏感词库

try {

// 读取文件输入流

InputStreamReader read = new InputStreamReader(inputStream, ENCODING);

// 文件是否是文件 和 是否存在

wordSet = new HashSet<String>();

// StringBuffer sb = new StringBuffer();

// BufferedReader是包装类,先把字符读到缓存里,到缓存满了,再读入内存,提高了读的效率。

BufferedReader br = new BufferedReader(read);

String txt = null;

// 读取文件,将文件内容放入到set中

while ((txt = br.readLine()) != null) {

wordSet.add(txt);

}

br.close();

// 关闭文件流

read.close();

} catch (Exception e) {

e.printStackTrace();

}

return wordSet;

}

// 将HashSet中的敏感词,存入HashMap中

private Map addSensitiveWordToHashMap(Set<String> wordSet) {

// 初始化敏感词容器,减少扩容操作

Map wordMap = new HashMap(wordSet.size());

for (String word : wordSet) {

Map nowMap = wordMap;

for (int i = 0; i < word.length(); i++) {

// 转换成char型

char keyChar = word.charAt(i);

// 获取

Object tempMap = nowMap.get(keyChar);

// 如果存在该key,直接赋值

if (tempMap != null) {

nowMap = (Map) tempMap;

}

// 不存在则,则构建一个map,同时将isEnd设置为0,因为他不是最后一个

else {

// 设置标志位

Map<String, String> newMap = new HashMap<String, String>();

newMap.put("isEnd", "0");

// 添加到集合

nowMap.put(keyChar, newMap);

nowMap = newMap;

}

// 最后一个

if (i == word.length() - 1) {

nowMap.put("isEnd", "1");

}

}

}

return wordMap;

}

}

最后刚才的SensitiveWordInit.java里面用到了word.txt 文件,放到你项目里面的 resources 目录下的 static 目录中,这个文件就是不雅文字大全,也需要您与时俱进的更新,项目启动的时候会加载该文件。

敏感词过滤器

敏感词过滤器,主要功能是初始化敏感词库,敏感词的过滤以及替换

package com.example.demo.Filter;

import com.example.demo.Config.SensitiveWordInit;

import org.springframework.stereotype.Component;

import java.io.IOException;

import java.util.HashSet;

import java.util.Iterator;

import java.util.Map;

import java.util.Set;

@Component

public class SensitiveFilter {

/**

* 敏感词过滤器:利用DFA算法 进行敏感词过滤

*/

private Map sensitiveWordMap = null;

/**

* 最小匹配规则,如:敏感词库["中国","中国人"],语句:"我是中国人",匹配结果:我是[中国]人

*/

public static int minMatchType = 1;

/**

* 最大匹配规则,如:敏感词库["中国","中国人"],语句:"我是中国人",匹配结果:我是[中国人]

*/

public static int maxMatchType = 2;

/**

* 敏感词替换词

*/

public static String placeHolder = "**";

// 单例

private static SensitiveFilter instance = null;

/**

* 构造函数,初始化敏感词库

*/

private SensitiveFilter() throws IOException {

sensitiveWordMap = new SensitiveWordInit().initKeyWord();

}

/**

* 获取单例

*/

public static SensitiveFilter getInstance() throws IOException {

if (null == instance) {

instance = new SensitiveFilter();

}

return instance;

}

/**

* 获取文字中的敏感词

*/

public Set<String> getSensitiveWord(String txt, int matchType) {

Set<String> sensitiveWordList = new HashSet<>();

for (int i = 0; i < txt.length(); i++) {

// 判断是否包含敏感字符

int length = CheckSensitiveWord(txt, i, matchType);

// 存在,加入list中

if (length > 0) {

sensitiveWordList.add(txt.substring(i, i + length));

// 减1的原因,是因为for会自增

i = i + length - 1;

}

}

return sensitiveWordList;

}

/**

* 替换敏感字字符,使用了默认的替换符合,默认最小匹配规则

*/

public String replaceSensitiveWord(String txt) {

return replaceSensitiveWord(txt, minMatchType ,placeHolder);

}

/**

* 替换敏感字字符,使用了默认的替换符合

*/

public String replaceSensitiveWord(String txt, int matchType) {

return replaceSensitiveWord(txt, matchType,placeHolder);

}

/**

* 替换敏感字字符

*/

public String replaceSensitiveWord(String txt, int matchType,

String replaceChar) {

String resultTxt = txt;

// 获取所有的敏感词

Set<String> set = getSensitiveWord(txt, matchType);

Iterator<String> iterator = set.iterator();

String word = null;

String replaceString = null;

while (iterator.hasNext()) {

word = iterator.next();

replaceString = getReplaceChars(replaceChar, word.length());

resultTxt = resultTxt.replaceAll(word, replaceString);

}

return resultTxt;

}

/**

* 获取替换字符串

*/

private String getReplaceChars(String replaceChar, int length) {

StringBuilder resultReplace = new StringBuilder(replaceChar);

for (int i = 1; i < length; i++) {

resultReplace.append(replaceChar);

}

return resultReplace.toString();

}

/**

* 检查文字中是否包含敏感字符,检查规则如下:<br>

* 如果存在,则返回敏感词字符的长度,不存在返回0

* 核心

*/

public int CheckSensitiveWord(String txt, int beginIndex, int matchType) {

// 敏感词结束标识位:用于敏感词只有1的情况结束

boolean flag = false;

// 匹配标识数默认为0

int matchFlag = 0;

Map nowMap = sensitiveWordMap;

for (int i = beginIndex; i < txt.length(); i++) {

char word = txt.charAt(i);

// 获取指定key

nowMap = (Map) nowMap.get(word);

// 存在,则判断是否为最后一个

if (nowMap != null) {

// 找到相应key,匹配标识+1

matchFlag++;

// 如果为最后一个匹配规则,结束循环,返回匹配标识数

if ("1".equals(nowMap.get("isEnd"))) {

// 结束标志位为true

flag = true;

// 最小规则,直接返回,最大规则还需继续查找

if (SensitiveFilter.minMatchType == matchType) {

break;

}

}

}

// 不存在,直接返回

else {

break;

}

}

// 匹配长度如果匹配上了最小匹配长度或者最大匹配长度

if (SensitiveFilter.maxMatchType == matchType || SensitiveFilter.minMatchType == matchType){

//长度必须大于等于1,为词,或者敏感词库还没有结束(匹配了一半),flag为false

if(matchFlag < 2 || !flag){

matchFlag = 0;

}

}

return matchFlag;

}

}

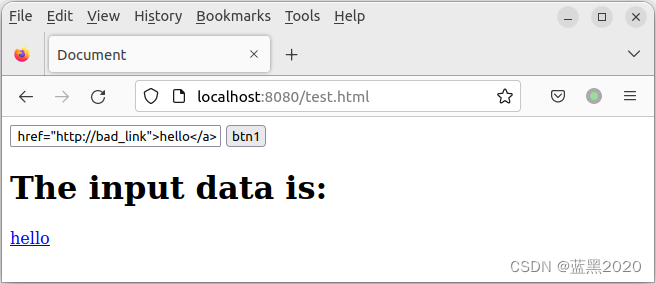

测试不雅文字过滤器

package com.example.demo.Controller;

import com.example.demo.Filter.SensitiveFilter;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class SensitiveController {

private static Logger logger = LoggerFactory.getLogger(SensitiveController.class);

@Autowired

SensitiveFilter sensitiveFilter;

@GetMapping("/sensitive")

public String sensitive(String keyword){

String s = sensitiveFilter.replaceSensitiveWord(keyword);

return s;

}

}

直接测试

测试热点搜索接口

package com.example.demo.Controller;

import com.example.demo.Service.RedisService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

import java.util.List;

@RestController

public class SearchHistoryController {

@Autowired

RedisService redisService;

@GetMapping("/add")

public String addSearchHistoryByUserId(String userId, String searchKey) {

redisService.addSearchHistoryByUserId(userId, searchKey);

redisService.incrementScore(searchKey);

return null;

}

/**

* 删除个人历史数据

*/

@GetMapping("/del")

public Long delSearchHistoryByUserId(String userId, String searchKey) {

return redisService.delSearchHistoryByUserId(userId, searchKey);

}

/**

* 获取个人历史数据列表

*/

@GetMapping("/getUser")

public List<String> getSearchHistoryByUserId(String userId) {

return redisService.getSearchHistoryByUserId(userId);

}

/**

* 根据searchKey搜索其相关最热的前十名 (如果searchKey为null空,则返回redis存储的前十最热词条)

*/

@GetMapping("/getHot")

public List<String> getHotList(String searchKey) {

return redisService.getHotList(searchKey);

}

}

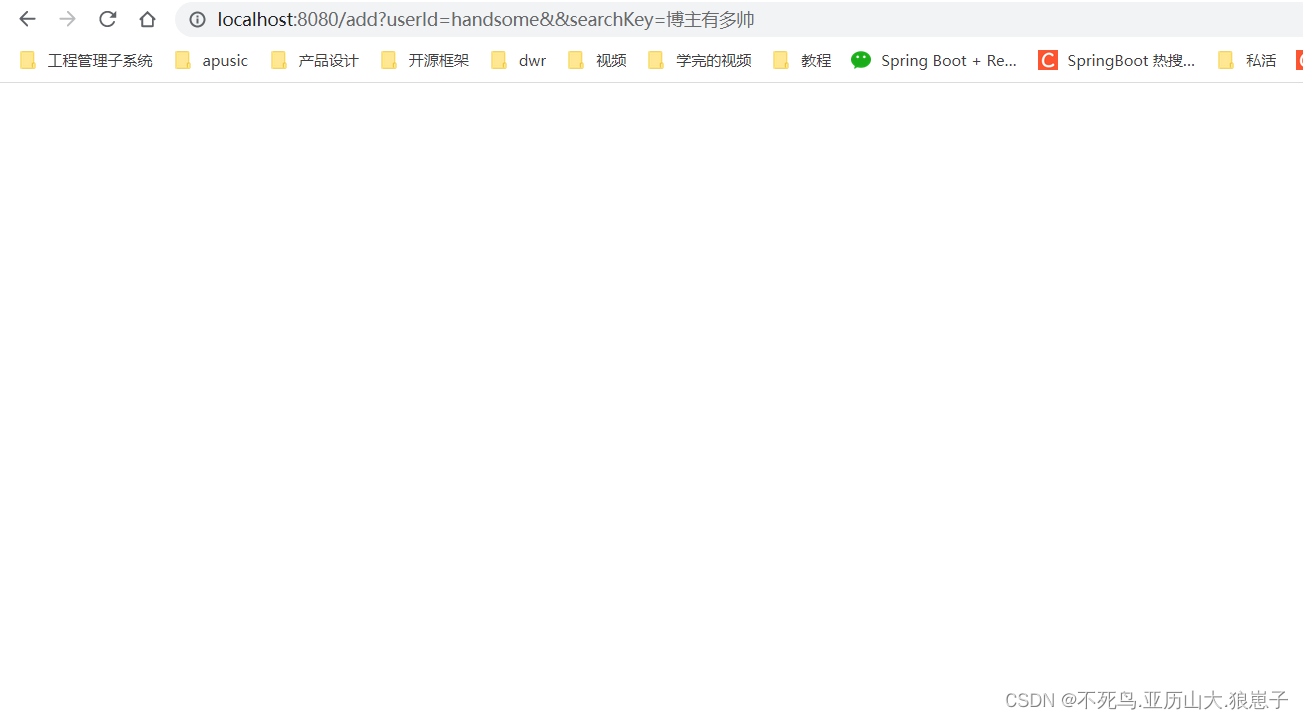

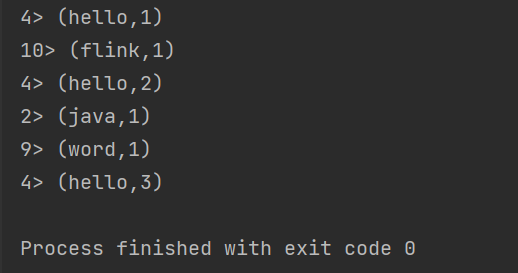

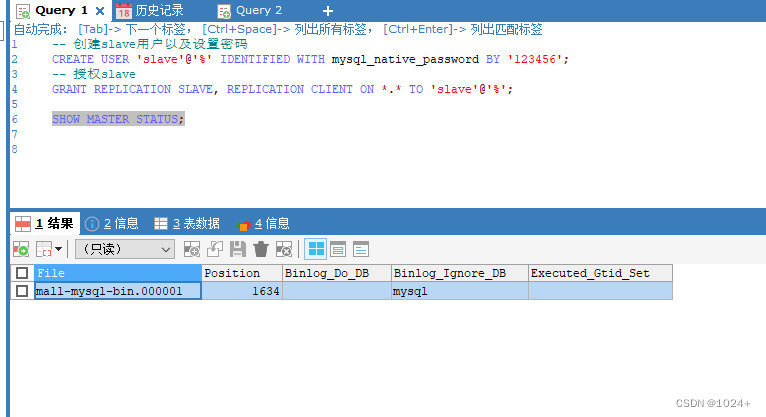

测试搜索接口

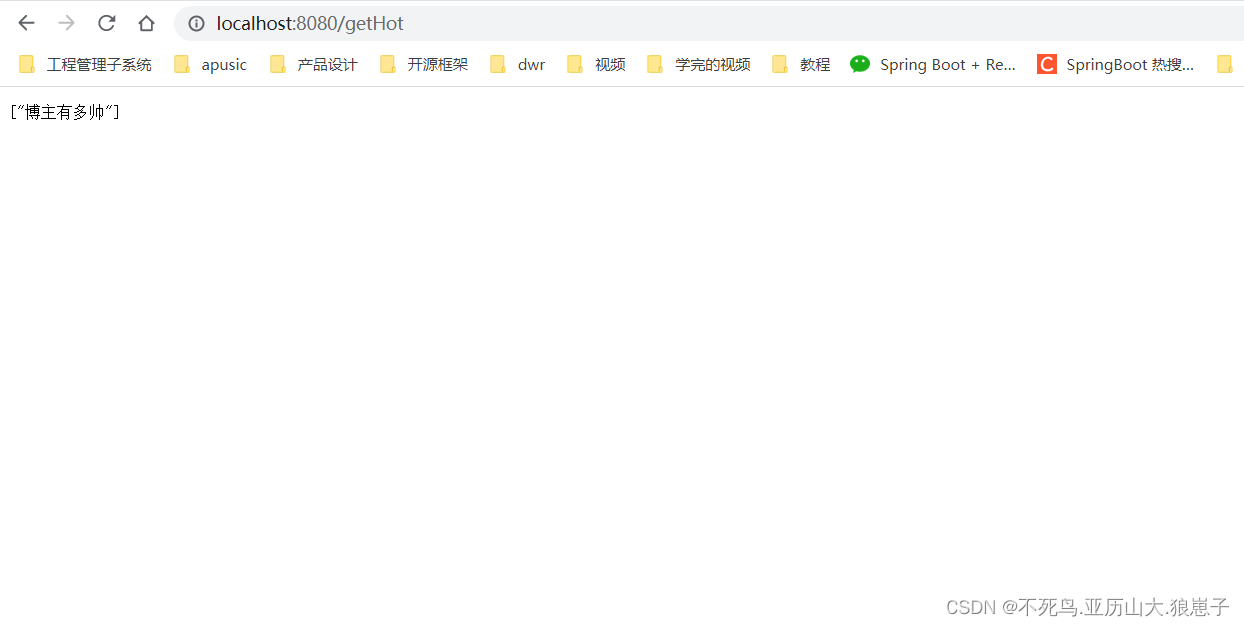

查询搜索热点

代码如下:https://download.csdn.net/download/u013938578/87390464?spm=1001.2014.3001.5503

![[leetcode]刷题--关于位运算的几道题](https://img-blog.csdnimg.cn/3d4f3a11a3a34a75acd00c9287c1a9bc.png)