一、初识梯度

import torch

x = torch.arange(4.0)

print(x)

x.requires_grad_(True)

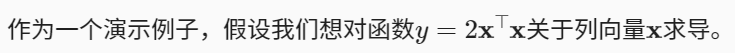

y = 2 * torch.dot(x, x) #torch.matmul(x, x)

print(y)

y.backward()

print(x.grad)

print(x.grad == 4*x)

输出:

tensor([0., 1., 2., 3.])

tensor(28., grad_fn=<MulBackward0>)

tensor([ 0., 4., 8., 12.])

tensor([True, True, True, True])解释:

1.x.requires_grad_(True)

计算y关于x的梯度之前,需要一个地方来存储梯度,这个函数就是申请储存梯度的地方的,我们使用 x.grad 来访问这个梯度

2.y.backward( )

上述代码调用了反向传播函数来自动计算y关于x每个分量的梯度,这个函数就是用来求导的

3.grad_fn=<MulBackward0>

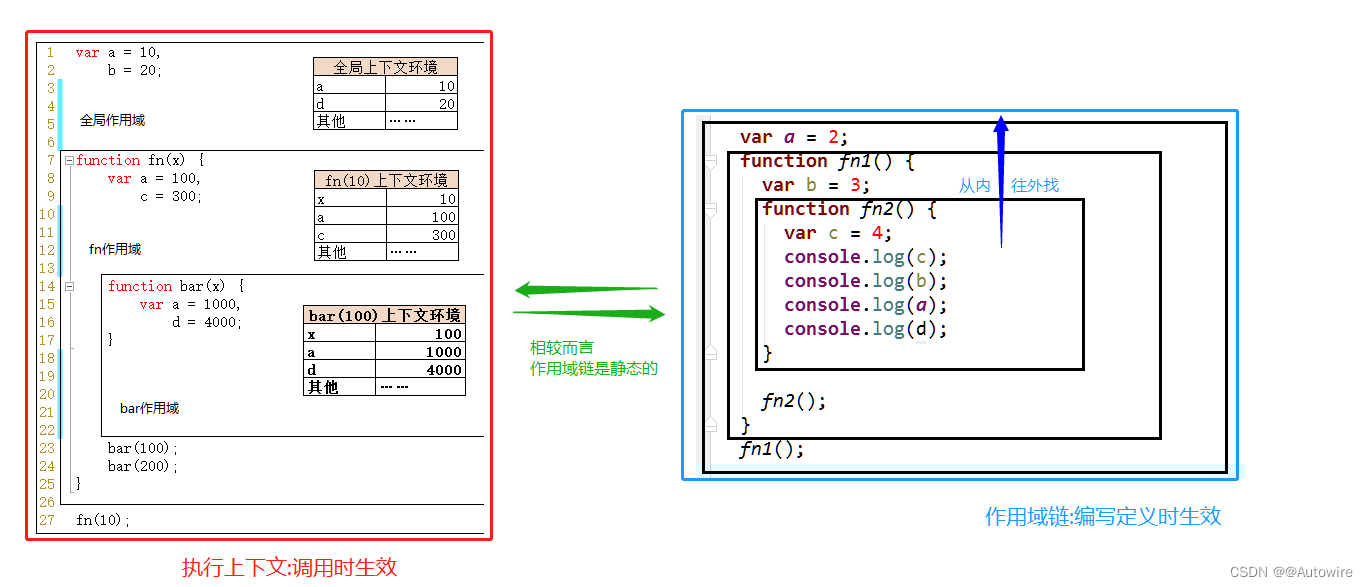

因为它是隐式构造的计算图,所以它有一个求梯度的函数“grad_fn=<MulBackward0>”存在这个地方告诉你y是由x计算得来的

详细解释:requires_grad,grad_fn,grad的含义及使用

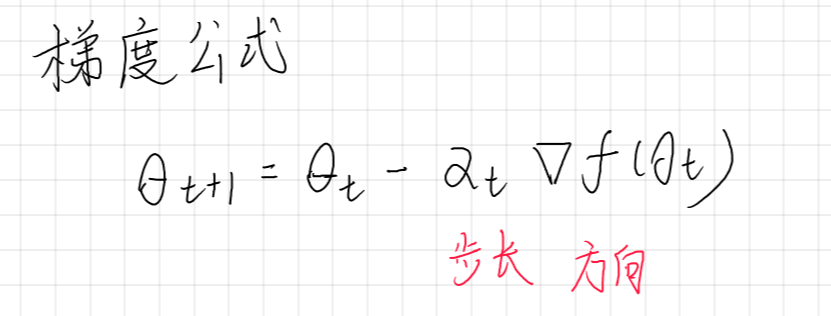

二、梯度详解

课程:这一定是我见过B站最简单讲得最清晰的【梯度】教程!带你快速了解神经网络/激

1.梯度:向量对于每一个方向上的偏微分,它具有方向和大小。梯度的方向代表了函数值越来越大的方向,梯度的长度代表函数变化的趋势。

2.通过梯度搜索极小值:

梯度方向:指从中心往四周,值越来越大的方向