文章目录

- 大于256KB的大块内存申请问题

- 大于256KB的大块释放申请问题

- 使用定长内存池脱离使用new

- 释放对象时优化为不传对象大小

- 完整版代码

- Common.h

- ObjectPool.h

- ThreadCache.h

- ThreadCache.cpp

- ConcurrentAlloc.h

- CentralCache.h

- CentralCache.cpp

- PageCache.h

- PageCache.cpp

大于256KB的大块内存申请问题

如果申请内存大于256KB,那么我们便不用正常的通过三层缓存申请内存,而是直接向Page Cache层申请内存。

static void* ConcurrentAlloc(size_t size)

{

if (size > MAX_BYTES)

{

//计算对齐后的内存大小

size_t alignSize = SizeClass::RoundUp(size);

//计算要多少也内存

size_t kpage = alignSize >> PAGE_SHIFT;

PageCache::GetInstance()->_pageMtx.lock();

//直接向Page Cache层要内存

Span* span = PageCache::GetInstance()->NewSpan(kpage);

PageCache::GetInstance()->_pageMtx.unlock();

//用ptr指向申请的内存

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

return ptr;

}

else

{

// 通过TLS 每个线程无锁的获取自己的专属的ThreadCache对象

if (pTLSThreadCache == nullptr)

{

pTLSThreadCache = new ThreadCache;

pTLSThreadCache = tcPool.New();

}

return pTLSThreadCache->Allocate(size);

}

}

之后我们Page Cache的申请内存也要更改。

// 获取一个K页的span

Span* PageCache::NewSpan(size_t k)

{

assert(k > 0);

// 大于128 page的直接向堆申请

if (k > NPAGES-1)

{

void* ptr = SystemAlloc(k);

Span* span = new Span;

span->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

span->_n = k;

_idSpanMap[span->_pageId] = span;

return span;

}

//k<=128页,我们便走正常的逻辑,向桶里面找

// 先检查第k个桶里面有没有span

if (!_spanLists[k].Empty())

{

Span* kSpan = _spanLists[k].PopFront();

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

// 检查一下后面的桶里面有没有span,如果有可以把他它进行切分

for (size_t i = k+1; i < NPAGES; ++i)

{

if (!_spanLists[i].Empty())

{

Span* nSpan = _spanLists[i].PopFront();

Span* kSpan = new Span;

// 在nSpan的头部切一个k页下来

// k页span返回

// nSpan再挂到对应映射的位置

kSpan->_pageId = nSpan->_pageId;

kSpan->_n = k;

nSpan->_pageId += k;

nSpan->_n -= k;

_spanLists[nSpan->_n].PushFront(nSpan);

// 存储nSpan的首位页号跟nSpan映射,方便page cache回收内存时

// 进行的合并查找

_idSpanMap[nSpan->_pageId] = nSpan;

_idSpanMap[nSpan->_pageId + nSpan->_n - 1] = nSpan;

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

}

// 走到这个位置就说明后面没有大页的span了

// 这时就去找堆要一个128页的span

Span* bigSpan = new Span;

void* ptr = SystemAlloc(NPAGES - 1);

bigSpan->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

bigSpan->_n = NPAGES - 1;

_spanLists[bigSpan->_n].PushFront(bigSpan);

return NewSpan(k);

}

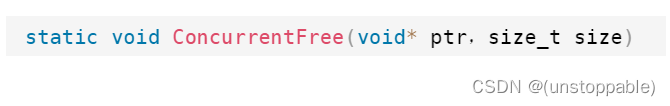

大于256KB的大块释放申请问题

static void ConcurrentFree(void* ptr,size_t size)

{

//如果大于256KB,则直接还给Page Cache

if (size > MAX_BYTES)

{

//找到对应内存的span

//然后归还该span

Span* span = PageCache::GetInstance()->MapObjectToSpan(ptr);

PageCache::GetInstance()->_pageMtx.lock();

PageCache::GetInstance()->ReleaseSpanToPageCache(span);

PageCache::GetInstance()->_pageMtx.unlock();

}

else//如果 <= 256KB 走正常的三层释放逻辑

{

assert(pTLSThreadCache);

pTLSThreadCache->Deallocate(ptr, size);

}

}

所以我们Page Cache层的释放逻辑也要更改

void PageCache::ReleaseSpanToPageCache(Span* span)

{

// 大于128 page的直接还给堆

if (span->_n > NPAGES-1)

{

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

//补充点1:SystemFree(p)的实现

SystemFree(ptr);

delete span;

return;

}

// 如果小于128page是,走正常的释放逻辑

// 对span前后的页,尝试进行合并,缓解内存碎片问题

while (1)

{

PAGE_ID prevId = span->_pageId - 1;

auto ret = _idSpanMap.find(prevId);

// 前面的页号没有,不合并了

if (ret == _idSpanMap.end())

{

break;

}

// 前面相邻页的span在使用,不合并了

Span* prevSpan = ret->second;

if (prevSpan->_isUse == true)

{

break;

}

// 合并出超过128页的span没办法管理,不合并了

if (prevSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_pageId = prevSpan->_pageId;

span->_n += prevSpan->_n;

_spanLists[prevSpan->_n].Erase(prevSpan);

delete prevSpan;

}

// 向后合并

while (1)

{

PAGE_ID nextId = span->_pageId + span->_n;

auto ret = _idSpanMap.find(nextId);

if (ret == _idSpanMap.end())

{

break;

}

Span* nextSpan = ret->second;

if (nextSpan->_isUse == true)

{

break;

}

if (nextSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_n += nextSpan->_n;

_spanLists[nextSpan->_n].Erase(nextSpan);

delete nextSpan;

}

_spanLists[span->_n].PushFront(span);

span->_isUse = false;

_idSpanMap[span->_pageId] = span;

_idSpanMap[span->_pageId+span->_n-1] = span;

}

补充点1:SystemFree§的实现

inline static void SystemFree(void* ptr)

{

#ifdef _WIN32

VirtualFree(ptr, 0, MEM_RELEASE);

#else

// sbrk unmmap等

#endif

}

使用定长内存池脱离使用new

就只有Page Cache层和ConcurrentAlloc.h中会涉及new的问题,所以只要把这里的改成定长内存池即可。

Page Cache层直接定义一个,定长内存池对象:

//展示Page Cache对象部分代码

#pragma once

#include "Common.h"

#include "ObjectPool.h"

class PageCache

{

public:

//省略

private:

SpanList _spanLists[NPAGES];

ObjectPool<Span> _spanPool;

std::unordered_map<PAGE_ID, Span*> _idSpanMap;

PageCache()

{}

PageCache(const PageCache&) = delete;

static PageCache _sInst;

};

然后对.cpp文件进行修改,有用到new的地方,全部改成定长内存池。

#include "PageCache.h"

PageCache PageCache::_sInst;

// 获取一个K页的span

Span* PageCache::NewSpan(size_t k)

{

assert(k > 0);

// 大于128 page的直接向堆申请

if (k > NPAGES-1)

{

void* ptr = SystemAlloc(k);

//Span* span = new Span;

Span* span = _spanPool.New();

span->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

span->_n = k;

_idSpanMap[span->_pageId] = span;

return span;

}

// 先检查第k个桶里面有没有span

if (!_spanLists[k].Empty())

{

Span* kSpan = _spanLists[k].PopFront();

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

// 检查一下后面的桶里面有没有span,如果有可以把他它进行切分

for (size_t i = k+1; i < NPAGES; ++i)

{

if (!_spanLists[i].Empty())

{

Span* nSpan = _spanLists[i].PopFront();

//Span* kSpan = new Span;

Span* kSpan = _spanPool.New();

// 在nSpan的头部切一个k页下来

// k页span返回

// nSpan再挂到对应映射的位置

kSpan->_pageId = nSpan->_pageId;

kSpan->_n = k;

nSpan->_pageId += k;

nSpan->_n -= k;

_spanLists[nSpan->_n].PushFront(nSpan);

// 存储nSpan的首位页号跟nSpan映射,方便page cache回收内存时

// 进行的合并查找

_idSpanMap[nSpan->_pageId] = nSpan;

_idSpanMap[nSpan->_pageId + nSpan->_n - 1] = nSpan;

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

}

// 走到这个位置就说明后面没有大页的span了

// 这时就去找堆要一个128页的span

//Span* bigSpan = new Span;

Span* bigSpan = _spanPool.New();

void* ptr = SystemAlloc(NPAGES - 1);

bigSpan->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

bigSpan->_n = NPAGES - 1;

_spanLists[bigSpan->_n].PushFront(bigSpan);

return NewSpan(k);

}

void PageCache::ReleaseSpanToPageCache(Span* span)

{

// 大于128 page的直接还给堆

if (span->_n > NPAGES-1)

{

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

SystemFree(ptr);

//delete span;

_spanPool.Delete(span);

return;

}

// 对span前后的页,尝试进行合并,缓解内存碎片问题

while (1)

{

PAGE_ID prevId = span->_pageId - 1;

auto ret = _idSpanMap.find(prevId);

// 前面的页号没有,不合并了

if (ret == _idSpanMap.end())

{

break;

}

// 前面相邻页的span在使用,不合并了

Span* prevSpan = ret->second;

if (prevSpan->_isUse == true)

{

break;

}

// 合并出超过128页的span没办法管理,不合并了

if (prevSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_pageId = prevSpan->_pageId;

span->_n += prevSpan->_n;

_spanLists[prevSpan->_n].Erase(prevSpan);

//delete prevSpan;

_spanPool.Delete(prevSpan);

}

// 向后合并

while (1)

{

PAGE_ID nextId = span->_pageId + span->_n;

auto ret = _idSpanMap.find(nextId);

if (ret == _idSpanMap.end())

{

break;

}

Span* nextSpan = ret->second;

if (nextSpan->_isUse == true)

{

break;

}

if (nextSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_n += nextSpan->_n;

_spanLists[nextSpan->_n].Erase(nextSpan);

//delete nextSpan;

_spanPool.Delete(nextSpan);

}

_spanLists[span->_n].PushFront(span);

span->_isUse = false;

_idSpanMap[span->_pageId] = span;

_idSpanMap[span->_pageId+span->_n-1] = span;

}

ConcurrentAlloc.h中new 线程对象也要修改。

static void* ConcurrentAlloc(size_t size)

{

if (size > MAX_BYTES)

{

//不涉及修改便省略,以免代码太长

}

else

{

// 通过TLS 每个线程无锁的获取自己的专属的ThreadCache对象

if (pTLSThreadCache == nullptr)

{

static ObjectPool<ThreadCache> tcPool;

//pTLSThreadCache = new ThreadCache;

pTLSThreadCache = tcPool.New();

}

return pTLSThreadCache->Allocate(size);

}

}

释放对象时优化为不传对象大小

我们之前设计的释放对象逻辑是要传对象大小的。

而正常来说我们应该不用传对象的大小所以我们就要多它进行优化,我们把对象的大小,放在对应的span当中。

// 管理多个连续页大块内存跨度结构

struct Span

{

PAGE_ID _pageId = 0; // 大块内存起始页的页号

size_t _n = 0; // 页的数量

Span* _next = nullptr; // 双向链表的结构

Span* _prev = nullptr;

size_t _useCount = 0; // 切好小块内存,被分配给thread cache的计数

void* _freeList = nullptr; // 切好的小块内存的自由链表

bool _isUse = false; //span是否在被使用

size_t _objSize = 0; // 切好的小对象的大小

};

然后在Central Cache层我们就初始化Page Cache给Central Cache的span对象中的的_objSize。

这里补充之前忘记讲的_isUse也是在这里改为true

// 获取一个非空的span

Span* CentralCache::GetOneSpan(SpanList& list, size_t size)

{

// 查看当前的spanlist中是否有还有未分配对象的span

Span* it = list.Begin();

while (it != list.End())

{

//不涉及修改便省略,以免代码太长

}

// 先把central cache的桶锁解掉,这样如果其他线程释放内存对象回来,不会阻塞

list._mtx.unlock();

// 走到这里说没有空闲span了,只能找page cache要

PageCache::GetInstance()->_pageMtx.lock();

Span* span = PageCache::GetInstance()->NewSpan(SizeClass::NumMovePage(size));

span->_isUse = true;

span->_objSize = size;

PageCache::GetInstance()->_pageMtx.unlock();

// 对获取span进行切分,不需要加锁,因为这会其他线程访问不到这个span

// 计算span的大块内存的起始地址和大块内存的大小(字节数)

char* start = (char*)(span->_pageId << PAGE_SHIFT);

size_t bytes = span->_n << PAGE_SHIFT;

char* end = start + bytes;

// 把大块内存切成自由链表链接起来

// 1、先切一块下来去做头,方便尾插

span->_freeList = start;

start += size;

void* tail = span->_freeList;

int i = 1;

while (start < end)

{

//不涉及修改便省略,以免代码太长

}

NextObj(tail) = nullptr;

// 切好span以后,需要把span挂到桶里面去的时候,再加锁

list._mtx.lock();

list.PushFront(span);

return span;

}

而如果大于256KB不会走这三层缓存,申请内存所以我们的自己再ConcurrentAlloc.h中处理。

static void* ConcurrentAlloc(size_t size)

{

if (size > MAX_BYTES)

{

size_t alignSize = SizeClass::RoundUp(size);

size_t kpage = alignSize >> PAGE_SHIFT;

PageCache::GetInstance()->_pageMtx.lock();

Span* span = PageCache::GetInstance()->NewSpan(kpage);

span->_objSize = size;

span->_isUse = true;

PageCache::GetInstance()->_pageMtx.unlock();

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

return ptr;

}

else

{

// 通过TLS 每个线程无锁的获取自己的专属的ThreadCache对象

if (pTLSThreadCache == nullptr)

{

static ObjectPool<ThreadCache> tcPool;

//pTLSThreadCache = new ThreadCache;

pTLSThreadCache = tcPool.New();

}

//cout << std::this_thread::get_id() << ":" << pTLSThreadCache << endl;

return pTLSThreadCache->Allocate(size);

}

}

之后就是释放内存函数不用传对象大小的修改

static void ConcurrentFree(void* ptr)

{

Span* span = PageCache::GetInstance()->MapObjectToSpan(ptr);

size_t size = span->_objSize;

if (size > MAX_BYTES)

{

PageCache::GetInstance()->_pageMtx.lock();

PageCache::GetInstance()->ReleaseSpanToPageCache(span);

PageCache::GetInstance()->_pageMtx.unlock();

}

else

{

assert(pTLSThreadCache);

pTLSThreadCache->Deallocate(ptr, size);

}

}

完整版代码

Common.h

#pragma once

#include <iostream>

#include <vector>

#include <unordered_map>

#include <map>

#include <algorithm>

#include <time.h>

#include <assert.h>

#include <thread>

#include <mutex>

#include <atomic>

using std::cout;

using std::endl;

#ifdef _WIN32

#include <windows.h>

#else

// ...

#endif

static const size_t MAX_BYTES = 256 * 1024;

static const size_t NFREELIST = 208;

static const size_t NPAGES = 129;

static const size_t PAGE_SHIFT = 13;

#ifdef _WIN64

typedef unsigned long long PAGE_ID;

#elif _WIN32

typedef size_t PAGE_ID;

#else

// linux

#endif

// 直接去堆上按页申请空间

inline static void* SystemAlloc(size_t kpage)

{

#ifdef _WIN32

void* ptr = VirtualAlloc(0, kpage << 13, MEM_COMMIT | MEM_RESERVE, PAGE_READWRITE);

#else

// linux下brk mmap等

#endif

if (ptr == nullptr)

throw std::bad_alloc();

return ptr;

}

inline static void SystemFree(void* ptr)

{

#ifdef _WIN32

VirtualFree(ptr, 0, MEM_RELEASE);

#else

// sbrk unmmap等

#endif

}

static void*& NextObj(void* obj)

{

return *(void**)obj;

}

// 管理切分好的小对象的自由链表

class FreeList

{

public:

void Push(void* obj)

{

assert(obj);

// 头插

//*(void**)obj = _freeList;

NextObj(obj) = _freeList;

_freeList = obj;

++_size;

}

void PushRange(void* start, void* end, size_t n)

{

NextObj(end) = _freeList;

_freeList = start;

_size += n;

}

void PopRange(void*& start, void*& end, size_t n)

{

assert(n <= _size);

start = _freeList;

end = start;

for (size_t i = 0; i < n - 1; ++i)

{

end = NextObj(end);

}

_freeList = NextObj(end);

NextObj(end) = nullptr;

_size -= n;

}

void* Pop()

{

assert(_freeList);

// 头删

void* obj = _freeList;

_freeList = NextObj(obj);

--_size;

return obj;

}

bool Empty()

{

return _freeList == nullptr;

}

size_t& MaxSize()

{

return _maxSize;

}

size_t Size()

{

return _size;

}

private:

void* _freeList = nullptr;

size_t _maxSize = 1;

size_t _size = 0;

};

// 计算对象大小的对齐映射规则

class SizeClass

{

public:

static inline size_t _RoundUp(size_t bytes, size_t alignNum)

{

return ((bytes + alignNum - 1) & ~(alignNum - 1));

}

static inline size_t RoundUp(size_t size)

{

if (size <= 128)

{

return _RoundUp(size, 8);

}

else if (size <= 1024)

{

return _RoundUp(size, 16);

}

else if (size <= 8*1024)

{

return _RoundUp(size, 128);

}

else if (size <= 64*1024)

{

return _RoundUp(size, 1024);

}

else if (size <= 256 * 1024)

{

return _RoundUp(size, 8*1024);

}

else

{

return _RoundUp(size, 1<<PAGE_SHIFT);

}

}

static inline size_t _Index(size_t bytes, size_t align_shift)

{

return ((bytes + (1 << align_shift) - 1) >> align_shift) - 1;

}

// 计算映射的哪一个自由链表桶

static inline size_t Index(size_t bytes)

{

assert(bytes <= MAX_BYTES);

// 每个区间有多少个链

static int group_array[4] = { 16, 56, 56, 56 };

if (bytes <= 128){

return _Index(bytes, 3);

}

else if (bytes <= 1024){

return _Index(bytes - 128, 4) + group_array[0];

}

else if (bytes <= 8 * 1024){

return _Index(bytes - 1024, 7) + group_array[1] + group_array[0];

}

else if (bytes <= 64 * 1024){

return _Index(bytes - 8 * 1024, 10) + group_array[2] + group_array[1] + group_array[0];

}

else if (bytes <= 256 * 1024){

return _Index(bytes - 64 * 1024, 13) + group_array[3] + group_array[2] + group_array[1] + group_array[0];

}

else{

assert(false);

}

return -1;

}

// 一次thread cache从中心缓存获取多少个

static size_t NumMoveSize(size_t size)

{

assert(size > 0);

// [2, 512],一次批量移动多少个对象的(慢启动)上限值

// 小对象一次批量上限高

// 小对象一次批量上限低

int num = MAX_BYTES / size;

if (num < 2)

num = 2;

if (num > 512)

num = 512;

return num;

}

// 计算一次向系统获取几个页

// 单个对象 8byte

// ...

// 单个对象 256KB

static size_t NumMovePage(size_t size)

{

size_t num = NumMoveSize(size);

size_t npage = num*size;

npage >>= PAGE_SHIFT;

if (npage == 0)

npage = 1;

return npage;

}

};

// 管理多个连续页大块内存跨度结构

struct Span

{

PAGE_ID _pageId = 0; // 大块内存起始页的页号

size_t _n = 0; // 页的数量

Span* _next = nullptr; // 双向链表的结构

Span* _prev = nullptr;

size_t _objSize = 0; // 切好的小对象的大小

size_t _useCount = 0; // 切好小块内存,被分配给thread cache的计数

void* _freeList = nullptr; // 切好的小块内存的自由链表

bool _isUse = false; // 是否在被使用

};

// 带头双向循环链表

class SpanList

{

public:

SpanList()

{

_head = new Span;

_head->_next = _head;

_head->_prev = _head;

}

Span* Begin()

{

return _head->_next;

}

Span* End()

{

return _head;

}

bool Empty()

{

return _head->_next == _head;

}

void PushFront(Span* span)

{

Insert(Begin(), span);

}

Span* PopFront()

{

Span* front = _head->_next;

Erase(front);

return front;

}

void Insert(Span* pos, Span* newSpan)

{

assert(pos);

assert(newSpan);

Span* prev = pos->_prev;

// prev newspan pos

prev->_next = newSpan;

newSpan->_prev = prev;

newSpan->_next = pos;

pos->_prev = newSpan;

}

void Erase(Span* pos)

{

assert(pos);

assert(pos != _head);

// 1、条件断点

// 2、查看栈帧

/*if (pos == _head)

{

int x = 0;

}*/

Span* prev = pos->_prev;

Span* next = pos->_next;

prev->_next = next;

next->_prev = prev;

}

private:

Span* _head;

public:

std::mutex _mtx; // 桶锁

};

ObjectPool.h

#pragma once

#include "Common.h"

template<class T>

class ObjectPool

{

public:

T* New()

{

T* obj = nullptr;

// 优先把还回来内存块对象,再次重复利用

if (_freeList)

{

void* next = *((void**)_freeList);

obj = (T*)_freeList;

_freeList = next;

}

else

{

// 剩余内存不够一个对象大小时,则重新开大块空间

if (_remainBytes < sizeof(T))

{

_remainBytes = 128 * 1024;

//_memory = (char*)malloc(_remainBytes);

_memory = (char*)SystemAlloc(_remainBytes >> 13);

if (_memory == nullptr)

{

throw std::bad_alloc();

}

}

obj = (T*)_memory;

size_t objSize = sizeof(T) < sizeof(void*) ? sizeof(void*) : sizeof(T);

_memory += objSize;

_remainBytes -= objSize;

}

// 定位new,显示调用T的构造函数初始化

new(obj)T;

return obj;

}

void Delete(T* obj)

{

// 显示调用析构函数清理对象

obj->~T();

// 头插

*(void**)obj = _freeList;

_freeList = obj;

}

private:

char* _memory = nullptr; // 指向大块内存的指针

size_t _remainBytes = 0; // 大块内存在切分过程中剩余字节数

void* _freeList = nullptr; // 还回来过程中链接的自由链表的头指针

};

ThreadCache.h

#pragma once

#include "Common.h"

class ThreadCache

{

public:

// 申请和释放内存对象

void* Allocate(size_t size);

void Deallocate(void* ptr, size_t size);

// 从中心缓存获取对象

void* FetchFromCentralCache(size_t index, size_t size);

// 释放对象时,链表过长时,回收内存回到中心缓存

void ListTooLong(FreeList& list, size_t size);

private:

FreeList _freeLists[NFREELIST];

};

// TLS thread local storage

static _declspec(thread) ThreadCache* pTLSThreadCache = nullptr;

ThreadCache.cpp

#include "ThreadCache.h"

#include "CentralCache.h"

void* ThreadCache::FetchFromCentralCache(size_t index, size_t size)

{

// 慢开始反馈调节算法

// 1、最开始不会一次向central cache一次批量要太多,因为要太多了可能用不完

// 2、如果你不要这个size大小内存需求,那么batchNum就会不断增长,直到上限

// 3、size越大,一次向central cache要的batchNum就越小

// 4、size越小,一次向central cache要的batchNum就越大

size_t batchNum = min(_freeLists[index].MaxSize(), SizeClass::NumMoveSize(size));

if (_freeLists[index].MaxSize() == batchNum)

{

_freeLists[index].MaxSize() += 1;

}

void* start = nullptr;

void* end = nullptr;

size_t actualNum = CentralCache::GetInstance()->FetchRangeObj(start, end, batchNum, size);

assert(actualNum > 0);

if (actualNum == 1)

{

assert(start == end);

return start;

}

else

{

_freeLists[index].PushRange(NextObj(start), end, actualNum-1);

return start;

}

}

void* ThreadCache::Allocate(size_t size)

{

assert(size <= MAX_BYTES);

size_t alignSize = SizeClass::RoundUp(size);

size_t index = SizeClass::Index(size);

if (!_freeLists[index].Empty())

{

return _freeLists[index].Pop();

}

else

{

return FetchFromCentralCache(index, alignSize);

}

}

void ThreadCache::Deallocate(void* ptr, size_t size)

{

assert(ptr);

assert(size <= MAX_BYTES);

// 找对映射的自由链表桶,对象插入进入

size_t index = SizeClass::Index(size);

_freeLists[index].Push(ptr);

// 当链表长度大于一次批量申请的内存时就开始还一段list给central cache

if (_freeLists[index].Size() >= _freeLists[index].MaxSize())

{

ListTooLong(_freeLists[index], size);

}

}

void ThreadCache::ListTooLong(FreeList& list, size_t size)

{

void* start = nullptr;

void* end = nullptr;

list.PopRange(start, end, list.MaxSize());

CentralCache::GetInstance()->ReleaseListToSpans(start, size);

}

ConcurrentAlloc.h

#pragma once

#include "Common.h"

#include "ThreadCache.h"

#include "PageCache.h"

#include "ObjectPool.h"

static void* ConcurrentAlloc(size_t size)

{

if (size > MAX_BYTES)

{

size_t alignSize = SizeClass::RoundUp(size);

size_t kpage = alignSize >> PAGE_SHIFT;

PageCache::GetInstance()->_pageMtx.lock();

Span* span = PageCache::GetInstance()->NewSpan(kpage);

span->_objSize = size;

span->_isUse = true;

PageCache::GetInstance()->_pageMtx.unlock();

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

return ptr;

}

else

{

// 通过TLS 每个线程无锁的获取自己的专属的ThreadCache对象

if (pTLSThreadCache == nullptr)

{

static ObjectPool<ThreadCache> tcPool;

//pTLSThreadCache = new ThreadCache;

pTLSThreadCache = tcPool.New();

}

//cout << std::this_thread::get_id() << ":" << pTLSThreadCache << endl;

return pTLSThreadCache->Allocate(size);

}

}

static void ConcurrentFree(void* ptr)

{

Span* span = PageCache::GetInstance()->MapObjectToSpan(ptr);

size_t size = span->_objSize;

if (size > MAX_BYTES)

{

PageCache::GetInstance()->_pageMtx.lock();

PageCache::GetInstance()->ReleaseSpanToPageCache(span);

PageCache::GetInstance()->_pageMtx.unlock();

}

else

{

assert(pTLSThreadCache);

pTLSThreadCache->Deallocate(ptr, size);

}

}

CentralCache.h

#pragma once

#include "Common.h"

// 单例模式

class CentralCache

{

public:

static CentralCache* GetInstance()

{

return &_sInst;

}

// 获取一个非空的span

Span* GetOneSpan(SpanList& list, size_t byte_size);

// 从中心缓存获取一定数量的对象给thread cache

size_t FetchRangeObj(void*& start, void*& end, size_t batchNum, size_t size);

// 将一定数量的对象释放到span跨度

void ReleaseListToSpans(void* start, size_t byte_size);

private:

SpanList _spanLists[NFREELIST];

private:

CentralCache()

{}

CentralCache(const CentralCache&) = delete;

static CentralCache _sInst;

};

CentralCache.cpp

#include "CentralCache.h"

#include "PageCache.h"

CentralCache CentralCache::_sInst;

// 获取一个非空的span

Span* CentralCache::GetOneSpan(SpanList& list, size_t size)

{

// 查看当前的spanlist中是否有还有未分配对象的span

Span* it = list.Begin();

while (it != list.End())

{

if (it->_freeList != nullptr)

{

return it;

}

else

{

it = it->_next;

}

}

// 先把central cache的桶锁解掉,这样如果其他线程释放内存对象回来,不会阻塞

list._mtx.unlock();

// 走到这里说没有空闲span了,只能找page cache要

PageCache::GetInstance()->_pageMtx.lock();

Span* span = PageCache::GetInstance()->NewSpan(SizeClass::NumMovePage(size));

span->_isUse = true;

span->_objSize = size;

PageCache::GetInstance()->_pageMtx.unlock();

// 对获取span进行切分,不需要加锁,因为这会其他线程访问不到这个span

// 计算span的大块内存的起始地址和大块内存的大小(字节数)

char* start = (char*)(span->_pageId << PAGE_SHIFT);

size_t bytes = span->_n << PAGE_SHIFT;

char* end = start + bytes;

// 把大块内存切成自由链表链接起来

// 1、先切一块下来去做头,方便尾插

span->_freeList = start;

start += size;

void* tail = span->_freeList;

int i = 1;

while (start < end)

{

++i;

NextObj(tail) = start;

tail = NextObj(tail); // tail = start;

start += size;

}

NextObj(tail) = nullptr;

// 切好span以后,需要把span挂到桶里面去的时候,再加锁

list._mtx.lock();

list.PushFront(span);

return span;

}

// 从中心缓存获取一定数量的对象给thread cache

size_t CentralCache::FetchRangeObj(void*& start, void*& end, size_t batchNum, size_t size)

{

size_t index = SizeClass::Index(size);

_spanLists[index]._mtx.lock();

Span* span = GetOneSpan(_spanLists[index], size);

assert(span);

assert(span->_freeList);

// 从span中获取batchNum个对象

// 如果不够batchNum个,有多少拿多少

start = span->_freeList;

end = start;

size_t i = 0;

size_t actualNum = 1;

while ( i < batchNum - 1 && NextObj(end) != nullptr)

{

end = NextObj(end);

++i;

++actualNum;

}

span->_freeList = NextObj(end);

NextObj(end) = nullptr;

span->_useCount += actualNum;

条件断点

int j = 0;

void* cur = start;

while (cur)

{

cur = NextObj(cur);

++j;

}

if (j != actualNum)

{

int x = 0;

}

_spanLists[index]._mtx.unlock();

return actualNum;

}

void CentralCache::ReleaseListToSpans(void* start, size_t size)

{

size_t index = SizeClass::Index(size);

_spanLists[index]._mtx.lock();

while (start)

{

void* next = NextObj(start);

Span* span = PageCache::GetInstance()->MapObjectToSpan(start);

NextObj(start) = span->_freeList;

span->_freeList = start;

span->_useCount--;

// 说明span的切分出去的所有小块内存都回来了

// 这个span就可以再回收给page cache,pagecache可以再尝试去做前后页的合并

if (span->_useCount == 0)

{

_spanLists[index].Erase(span);

span->_freeList = nullptr;

span->_next = nullptr;

span->_prev = nullptr;

// 释放span给page cache时,使用page cache的锁就可以了

// 这时把桶锁解掉

_spanLists[index]._mtx.unlock();

PageCache::GetInstance()->_pageMtx.lock();

PageCache::GetInstance()->ReleaseSpanToPageCache(span);

PageCache::GetInstance()->_pageMtx.unlock();

_spanLists[index]._mtx.lock();

}

start = next;

}

_spanLists[index]._mtx.unlock();

}

PageCache.h

#pragma once

#include "Common.h"

#include "ObjectPool.h"

class PageCache

{

public:

static PageCache* GetInstance()

{

return &_sInst;

}

// 获取从对象到span的映射

Span* MapObjectToSpan(void* obj);

// 释放空闲span回到Pagecache,并合并相邻的span

void ReleaseSpanToPageCache(Span* span);

// 获取一个K页的span

Span* NewSpan(size_t k);

std::mutex _pageMtx;

private:

SpanList _spanLists[NPAGES];

ObjectPool<Span> _spanPool;

std::unordered_map<PAGE_ID, Span*> _idSpanMap;

PageCache()

{}

PageCache(const PageCache&) = delete;

static PageCache _sInst;

};

PageCache.cpp

#include "PageCache.h"

PageCache PageCache::_sInst;

// 获取一个K页的span

Span* PageCache::NewSpan(size_t k)

{

assert(k > 0);

// 大于128 page的直接向堆申请

if (k > NPAGES-1)

{

void* ptr = SystemAlloc(k);

//Span* span = new Span;

Span* span = _spanPool.New();

span->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

span->_n = k;

_idSpanMap[span->_pageId] = span;

return span;

}

// 先检查第k个桶里面有没有span

if (!_spanLists[k].Empty())

{

Span* kSpan = _spanLists[k].PopFront();

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

// 检查一下后面的桶里面有没有span,如果有可以把他它进行切分

for (size_t i = k+1; i < NPAGES; ++i)

{

if (!_spanLists[i].Empty())

{

Span* nSpan = _spanLists[i].PopFront();

//Span* kSpan = new Span;

Span* kSpan = _spanPool.New();

// 在nSpan的头部切一个k页下来

// k页span返回

// nSpan再挂到对应映射的位置

kSpan->_pageId = nSpan->_pageId;

kSpan->_n = k;

nSpan->_pageId += k;

nSpan->_n -= k;

_spanLists[nSpan->_n].PushFront(nSpan);

// 存储nSpan的首位页号跟nSpan映射,方便page cache回收内存时

// 进行的合并查找

_idSpanMap[nSpan->_pageId] = nSpan;

_idSpanMap[nSpan->_pageId + nSpan->_n - 1] = nSpan;

// 建立id和span的映射,方便central cache回收小块内存时,查找对应的span

for (PAGE_ID i = 0; i < kSpan->_n; ++i)

{

_idSpanMap[kSpan->_pageId + i] = kSpan;

}

return kSpan;

}

}

// 走到这个位置就说明后面没有大页的span了

// 这时就去找堆要一个128页的span

//Span* bigSpan = new Span;

Span* bigSpan = _spanPool.New();

void* ptr = SystemAlloc(NPAGES - 1);

bigSpan->_pageId = (PAGE_ID)ptr >> PAGE_SHIFT;

bigSpan->_n = NPAGES - 1;

_spanLists[bigSpan->_n].PushFront(bigSpan);

return NewSpan(k);

}

Span* PageCache::MapObjectToSpan(void* obj)

{

PAGE_ID id = ((PAGE_ID)obj >> PAGE_SHIFT);

std::unique_lock<std::mutex> lock(_pageMtx);

auto ret = _idSpanMap.find(id);

if (ret != _idSpanMap.end())

{

return ret->second;

}

else

{

assert(false);

return nullptr;

}

}

void PageCache::ReleaseSpanToPageCache(Span* span)

{

// 大于128 page的直接还给堆

if (span->_n > NPAGES-1)

{

void* ptr = (void*)(span->_pageId << PAGE_SHIFT);

SystemFree(ptr);

//delete span;

_spanPool.Delete(span);

return;

}

// 对span前后的页,尝试进行合并,缓解内存碎片问题

while (1)

{

PAGE_ID prevId = span->_pageId - 1;

auto ret = _idSpanMap.find(prevId);

// 前面的页号没有,不合并了

if (ret == _idSpanMap.end())

{

break;

}

// 前面相邻页的span在使用,不合并了

Span* prevSpan = ret->second;

if (prevSpan->_isUse == true)

{

break;

}

// 合并出超过128页的span没办法管理,不合并了

if (prevSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_pageId = prevSpan->_pageId;

span->_n += prevSpan->_n;

_spanLists[prevSpan->_n].Erase(prevSpan);

//delete prevSpan;

_spanPool.Delete(prevSpan);

}

// 向后合并

while (1)

{

PAGE_ID nextId = span->_pageId + span->_n;

auto ret = _idSpanMap.find(nextId);

if (ret == _idSpanMap.end())

{

break;

}

Span* nextSpan = ret->second;

if (nextSpan->_isUse == true)

{

break;

}

if (nextSpan->_n + span->_n > NPAGES-1)

{

break;

}

span->_n += nextSpan->_n;

_spanLists[nextSpan->_n].Erase(nextSpan);

//delete nextSpan;

_spanPool.Delete(nextSpan);

}

_spanLists[span->_n].PushFront(span);

span->_isUse = false;

_idSpanMap[span->_pageId] = span;

_idSpanMap[span->_pageId+span->_n-1] = span;

}