回归预测 | MATLAB实现CNN-GRU卷积门控循环单元多输入多输出

目录

- 回归预测 | MATLAB实现CNN-GRU卷积门控循环单元多输入多输出

- 预测效果

- 基本介绍

- 程序设计

- 往期精彩

- 参考资料

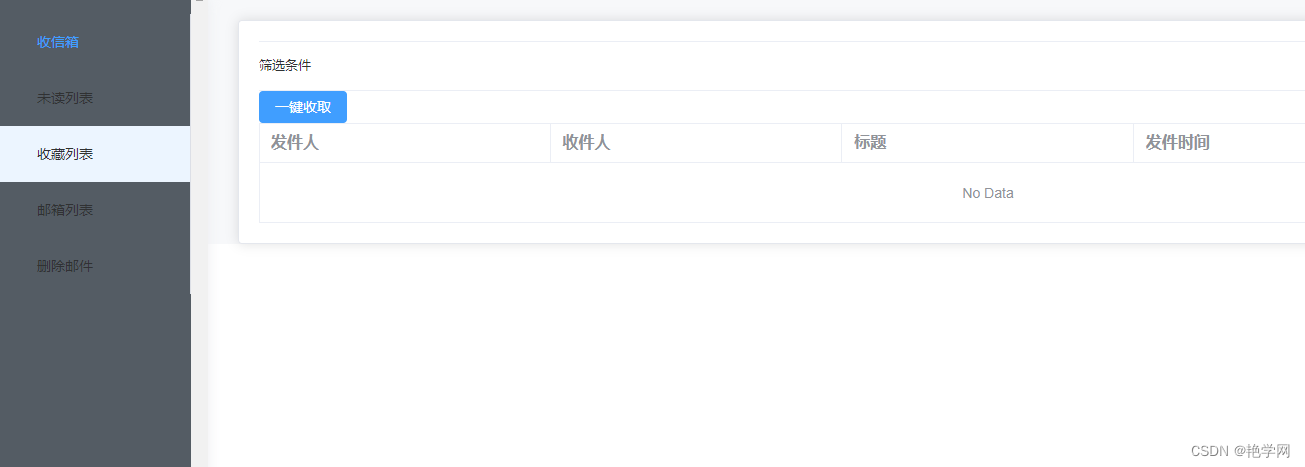

预测效果

基本介绍

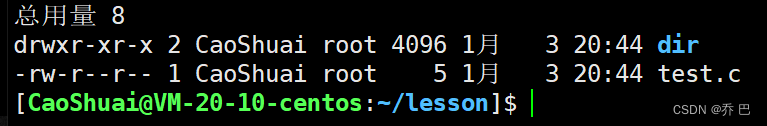

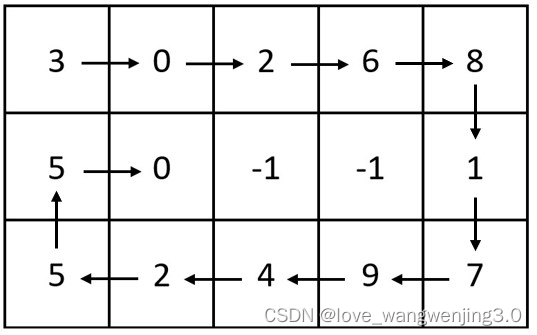

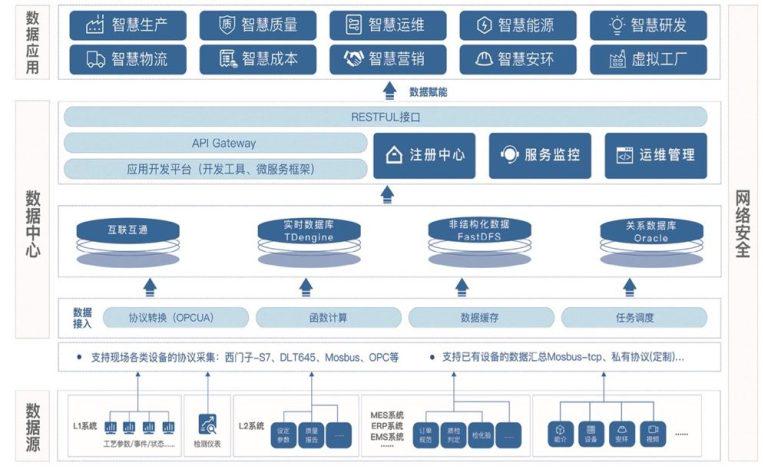

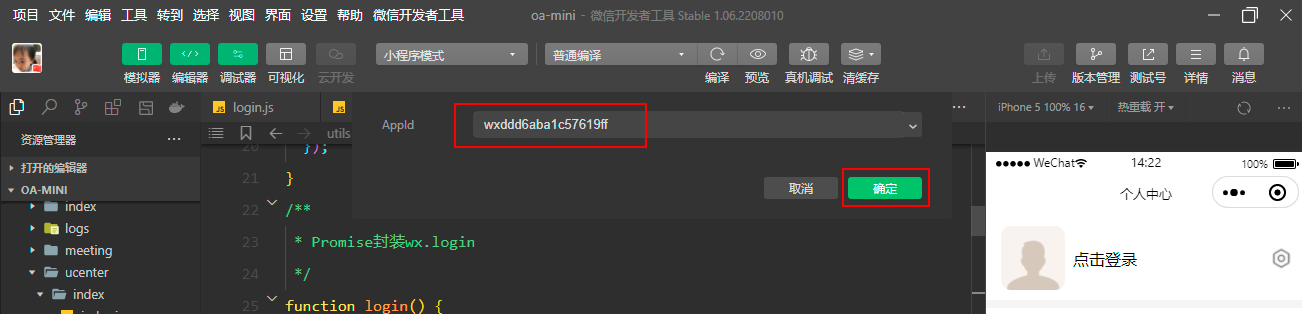

MATLAB实现CNN-GRU卷积门控循环单元多输入多输出,运行环境Matlab2020及以上。采用特征融合的方法,通过卷积网络提取出浅层特征与深层特征并进行联接,对特征通过卷积进行融合,将获得的矢量信息输入GRU单元。

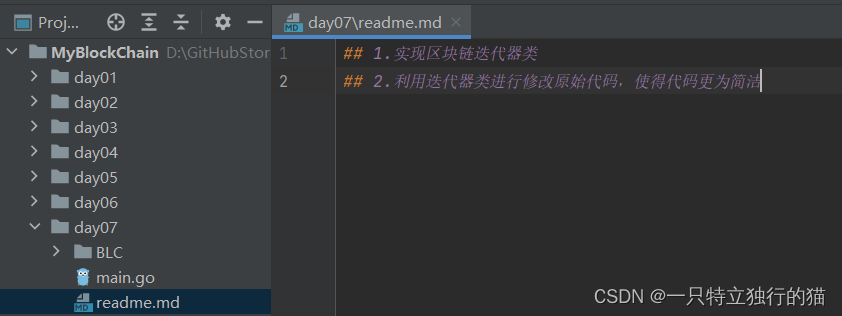

程序设计

- 完整程序和数据下载方式1:同等程序价值兑换。

- 完整程序和数据下载方式2(订阅《组合优化》专栏,数据和程序订阅后私信我获取):MATLAB实现CNN-GRU多输入多输出

%-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

%%

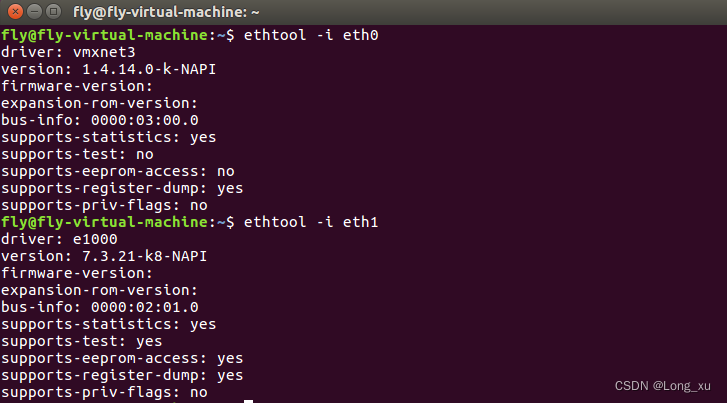

% GRU 层设置,参数设置

inputSize = size(xnorm{1},1); %数据输入x的特征维度

outputSize = size(ynorm,2); %数据输出y的维度

numhidden_units1=50; %网络单元

numhidden_units2= 20;

numhidden_units3=100;

%%

% gru

————————————————

版权声明:本文为CSDN博主「机器学习之心」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/kjm13182345320/article/details/127418340

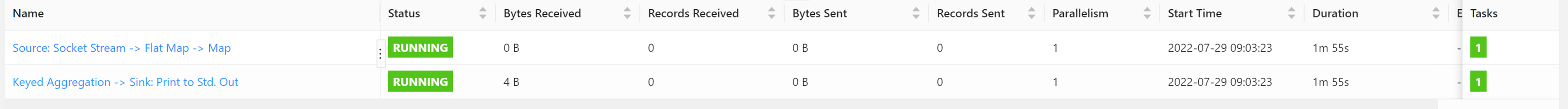

%% 参数设置

options = trainingOptions('adam', ... % Adam 梯度下降算法

'MiniBatchSize', 100, ... % 批大小

'MaxEpochs', 1000, ... % 最大迭代次数

'InitialLearnRate', 1e-2, ... % 初始学习率

'LearnRateSchedule', 'piecewise', ... % 学习率下降

'LearnRateDropFactor', 0.1, ... % 学习率下降因子

'LearnRateDropPeriod', 700, ... % 经过700次训练后 学习率为 0.01 * 0.1

'Shuffle', 'every-epoch', ... % 每次训练打乱数据集

'ValidationPatience', Inf, ... % 关闭验证

'Plots', 'training-progress', ... % 画出曲线

'Verbose', false);

%--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

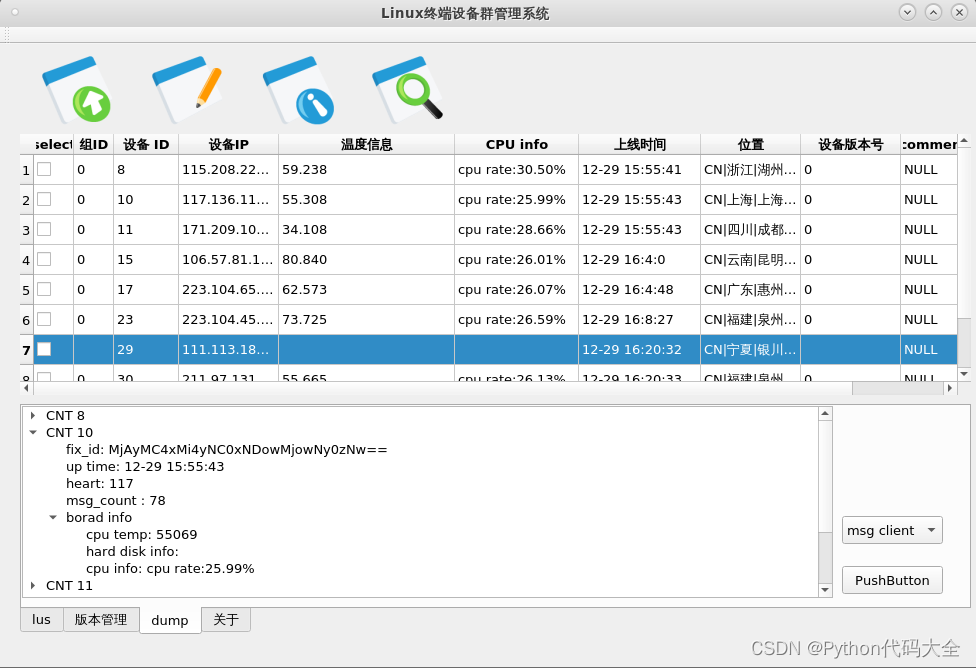

%% 训练模型

net = trainNetwork(p_train, t_train, layers, options);

%--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

%% 仿真预测

t_sim1 = predict(net, p_train);

t_sim2 = predict(net, p_test );

往期精彩

MATLAB实现RBF径向基神经网络多输入多输出预测

MATLAB实现BP神经网络多输入多输出预测

MATLAB实现DNN神经网络多输入多输出预测

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/116377961

[2] https://blog.csdn.net/kjm13182345320/article/details/127931217

[3] https://blog.csdn.net/kjm13182345320/article/details/127894261