激活函数总结(三十二):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 Serf激活函数

- 2.2 FReLU激活函数

- 3. 总结

1 引言

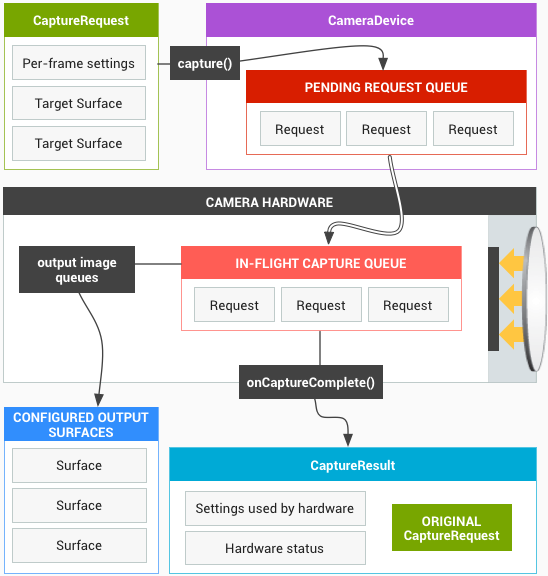

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU、PELU、Phish、RBF、SQ-RBF、ISRU、ISRLU、SQNL、PLU、APL、Inverse Cubic、Soft Exponential、ParametricLinear、Piecewise Linear Unit、CLL、SquaredReLU、ModReLU、CosReLU、SinReLU、Probit、Smish、Multiquadratic、InvMultiquadratic、PSmish、ESwish、CoLU、ShiftedSoftPlus、Logit、Softsign、ELiSH、Hard ELiSH)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

2.1 Serf激活函数

论文链接:Nag, Sayan, and Mayukh Bhattacharyya. “SERF: Towards better training of deep neural networks using log-Softplus ERror activation Function.” arXiv preprint arXiv:2108.09598 (2021).

Serf (或称 Log-Softplus ERror)激活函数是一种属于 Swish 家族的激活函数,具有自正则化和非单调性的特点。其数学表达式和数学图像分别如下所示:

f

(

x

)

=

x

e

r

f

(

l

n

(

1

+

e

x

)

)

f(x)=x erf(ln(1+e^x))

f(x)=xerf(ln(1+ex))

其中,erf表示误差函数。

特点:

- 无上界:避免

饱和问题 - 有下界:以便提供强的

正则化效果 - 可微性:避免了基于梯度的优化过程中的

奇点和任何伴随的不良影响 - 预调节器:使得梯度更

平滑且优化更快,如下公式所示,我们可以将Serf的一阶导数表示为swish的函数,p(x)是一个预调节器,可以使得梯度更加平滑

f ′ ( x ) = 2 π e − l n ( ( 1 + e x ) ) 2 x σ ( x ) + f ( x ) x = p ( x ) s w i s h ( x ) + f ( x ) x f'(x)=\frac{2}{\sqrt{\pi}}e^{-ln((1+e^x))^2}x \sigma (x) + \frac{f(x)}{x} \\ =p(x)swish(x)+ \frac{f(x)}{x} f′(x)=π2e−ln((1+ex))2xσ(x)+xf(x)=p(x)swish(x)+xf(x) - 平滑性:平滑的损失曲线表明更容易的

优化并具有较少的局部最优。因此更好的泛化,最小化初始化和学习率的影响

作为Swish 家族的一员,Serf 具有极其优异的性质,在各个领域都有所应用,但是应用不多。有需要的人可以进行尝试。。。

2.2 FReLU激活函数

论文链接:Qiu, Suo, Xiangmin Xu, and Bolun Cai. “FReLU: flexible rectified linear units for improving convolutional neural networks.” In 2018 24th international conference on pattern recognition (icpr), pp. 1223-1228. IEEE, 2018.

FReLU (Flexible Rectified Linear Units,灵活的整流线性单元)是一种为了捕获负信息并提供 zero-like 属性的激活函数。其数学表达式和数学图像分别如下所示:

F

R

e

L

U

(

x

)

=

{

x

+

b

,

if

x

>

0

b

,

if

x

≤

0

FReLU(x) = \begin{cases} x+b, & \text{if } x > 0 \\ b, & \text{if } x \leq 0 \\ \end{cases}

FReLU(x)={x+b,b,if x>0if x≤0

特点:

- 收敛速度快,性能更高;

- 计算成本低,无指数运算;

- 与批量归一化兼容;

- 弱假设和自适应

该激活函数较为简单,但是也因其简单的性质无法捕获复杂数据中的信息。现在很少使用。。。。

3. 总结

到此,使用 激活函数总结(三十二) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。