激活函数总结(二十):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 Square nonlinearity (SQNL)激活函数

- 2.2 Piecewise Linear Unit (PLU)激活函数

- 3. 总结

1 引言

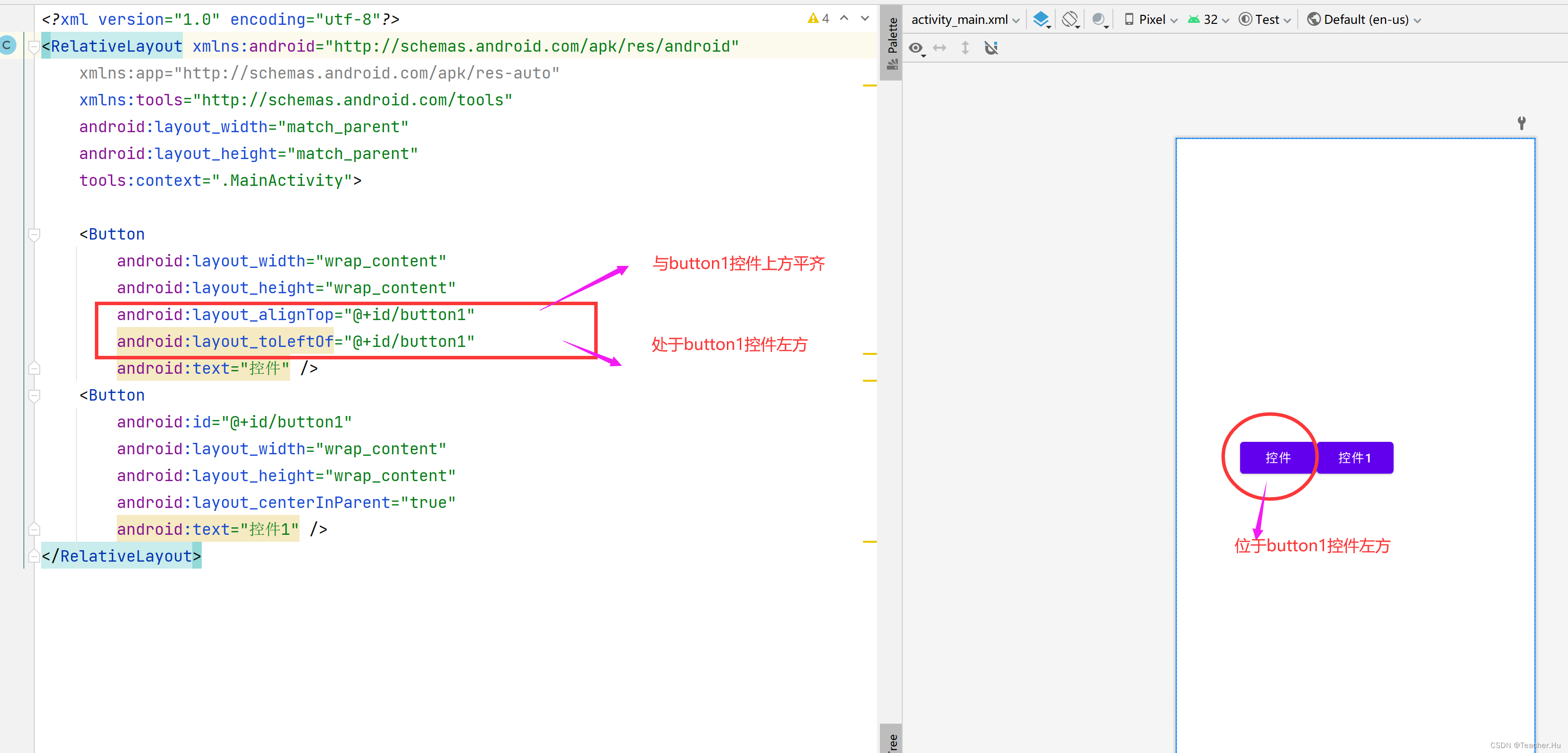

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU、PELU、Phish、RBF、SQ-RBF、ISRU、ISRLU)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

2.1 Square nonlinearity (SQNL)激活函数

Square nonlinearity(SQNL)一种新的计算高效激活函数。由于其固有的平方运算,该函数被命名为平方律非线性(SQNL)函数。其数学表达式和数学图像分别如下所示:

S

Q

N

L

(

x

)

=

{

1

,

if

x

>

2

x

−

x

2

4

,

if

0

≤

x

≤

2

x

+

x

2

4

,

if

−

2

≤

x

<

0

−

1

,

if

x

<

−

2

SQNL(x) = \begin{cases} 1, & \text{if } x > 2 \\ x - \frac{x^2}{4}, & \text{if } 0 \leq x \leq 2 \\ x + \frac{x^2}{4}, & \text{if } -2 \leq x < 0 \\ -1, & \text{if } x < -2 \\ \end{cases}

SQNL(x)=⎩

⎨

⎧1,x−4x2,x+4x2,−1,if x>2if 0≤x≤2if −2≤x<0if x<−2

优点:

- 简单非线性:

平方运算,一个最简单的非线性操作。 - 对称和连续:它在

零附近是对称的,在−∞和+∞之间是连续的。 - 线性微分:SQNL的

导数是线性的。

缺点:

- 可解释性: SQNL不是一个

广泛使用的激活函数,因此可能需要更多的背景知识来解释其作用和效果。 - 过于简单:很难用于处理

复杂问题,提取复杂问题中的关键特征。

SQNL是一个用于数字电路的激活函数,在FPGA中有所用到。。。但是在深度学习中很少出现。。。。

2.2 Piecewise Linear Unit (PLU)激活函数

论文链接:https://arxiv.org/pdf/1809.09534v1.pdf

PLU是一种类似于 ReLU 的激活函数,但在负半部分采用了分段线性变换,以引入更多的非线性性质。其数学表达式和数学图像分别如下所示:

P

L

U

(

x

)

=

m

a

x

(

α

(

x

+

c

)

−

c

,

m

i

n

(

α

(

x

+

c

)

+

c

,

x

)

)

PLU(x)=max(\alpha (x+c)-c, min(\alpha (x+c)+c, x))

PLU(x)=max(α(x+c)−c,min(α(x+c)+c,x))

优点:

- 非线性性质: PLU 引入了

非线性性质,有助于神经网络捕捉数据中的复杂模式,使其在处理非线性问题时表现更好。 - 平滑性: 在输入范围内,PLU 是

分段线性的,有助于梯度计算的稳定性,减少了梯度突变可能引发的问题。 - 参数调节: 通过

调整参数 α 和 c,可以控制 PLU 激活函数的斜率和平移,使其适应不同任务和数据分布。

缺点:

- 参数设置: 需要仔细调整参数 α 和 c 才能获得

最佳性能,这可能需要一些实验和调试。 - 可解释性: PLU 不是最

常见的激活函数之一,可能需要更多的背景知识来理解其作用和效果。

总之,PLU 激活函数通过引入分段线性特性,同时保持一定的平滑性,旨在增加神经网络的非线性能力。但是,这是这种不常见的性质导致其并不常使用。。。。。

3. 总结

到此,使用 激活函数总结(二十) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。