DPFN: A Dual-Path Fusion Network for Pan-Sharpening

(一种用于泛锐化的双路径融合网络)

大多数现有深上用于pan-sharpening方法的几个公认的问题,如光谱失真和足够的空间纹理增强。针对这些问题,提出了一种新的双路径融合网络(DPFN)拟议的DPFN包括两个主要组成部分:1)全局子网(global subnetwork (GSN))和2)局部子网( local subnetwork (LSN))。GSN的目标是在全色(PAN)空间和多光谱(MS)空间中搜索相似的图像块,并利用来自PAN空间的HR纹理信息和来自MS空间的光谱信息,通过使用交叉非局部块(cross nonlocal block (CNL))来精细表示全色锐化的MS特征。同时,提出了一种基于高通修正块(high-pass modification block (HMB))的LSN,用于学习高通信息,以增强MS图像的带域空间信息。HMB强制融合图像从PAN图像中获取高频细节。此外,为了便于生成视觉上吸引人的全色锐化图像,我们提出了一个感知损失函数,并进一步优化了基于近红外空间高级特征的模型。实验结果表明,与现有的全色锐化方法相比,该方法在定量和定性方面都具有更优越的性能。

介绍

随着卫星传感器的迅速发展,遥感图像在各个学术领域、民用和军事领域得到了广泛的应用。然而,正如许多人所认识到的,遥感传感器在空间分辨率和光谱分辨率之间进行一种权衡。因此,对于特定的遥感传感器,所捕获的灰度全色(PAN)图像通常具有比多光谱(MS)图像更精细的分辨率。典型地,全色锐化的目标是将高分辨率(HR)PAN图像的纹理细节与来自低分辨率(LR)MS图像的光谱信息集成,以用于生成HR-MS图像的目的,因此突破了技术限制。鉴于上述效用,全色锐化任务通常被视为许多遥感数据应用的关键预处理步骤,例如城市不透水表面的提取、土地覆被分类和变化检测。

传统的全色锐化方法一般基于手工特征,重建MS图像中缺失信息的能力有限。最近,提出了许多基于学习的框架。这些方法能够从大量成对图像中学习非线性映射和高语义特征,显著提高了全色锐化过程的性能和鲁棒性。

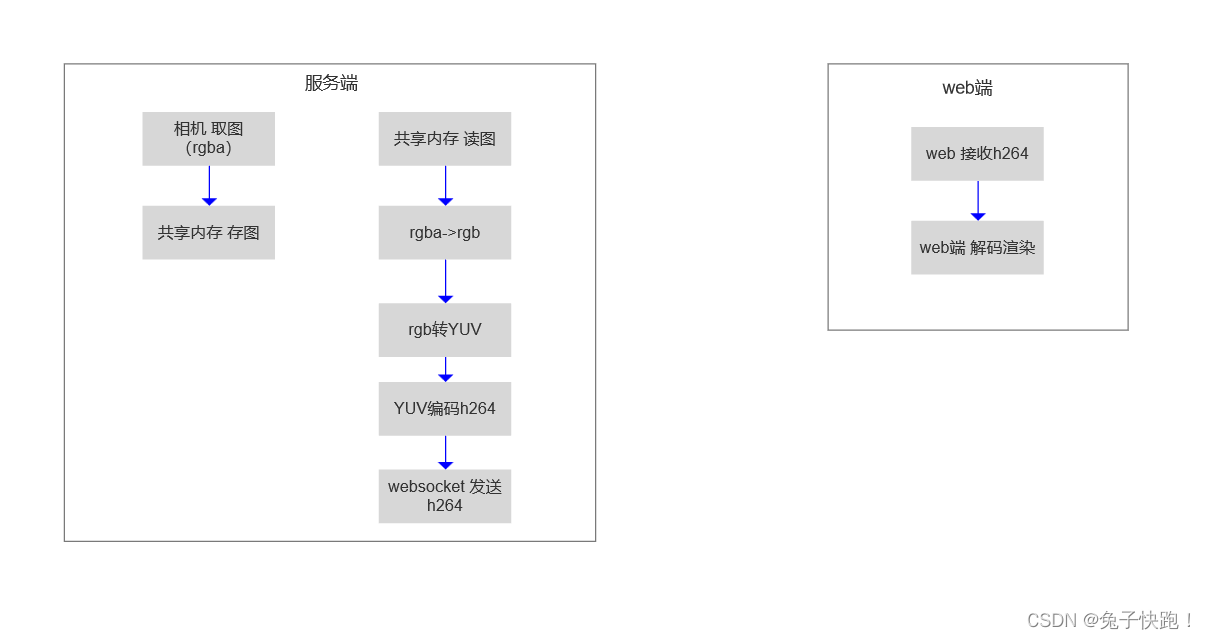

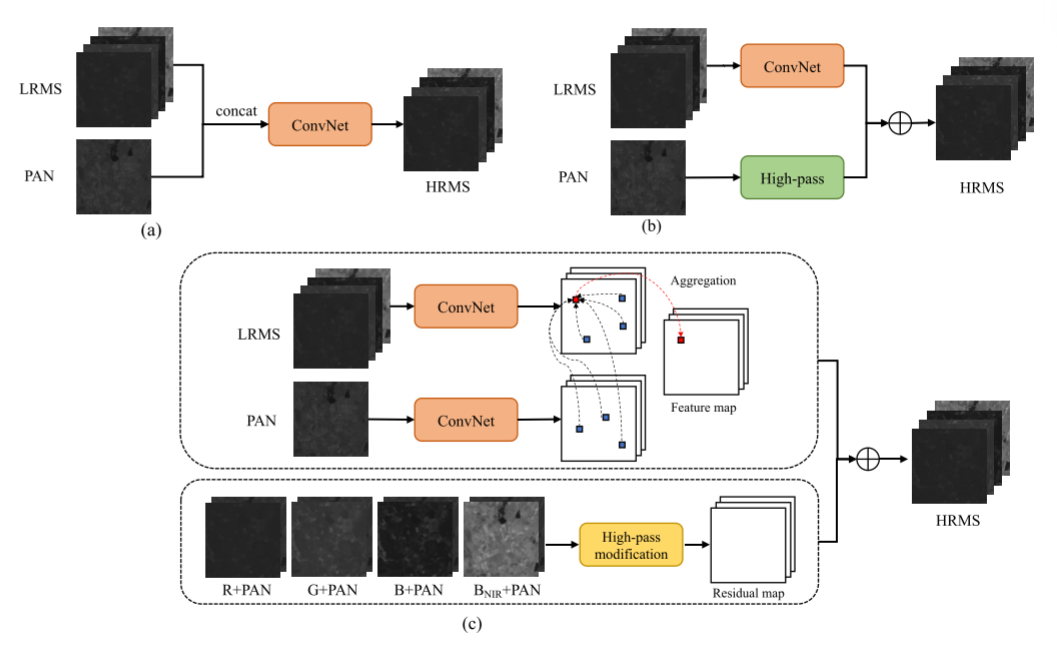

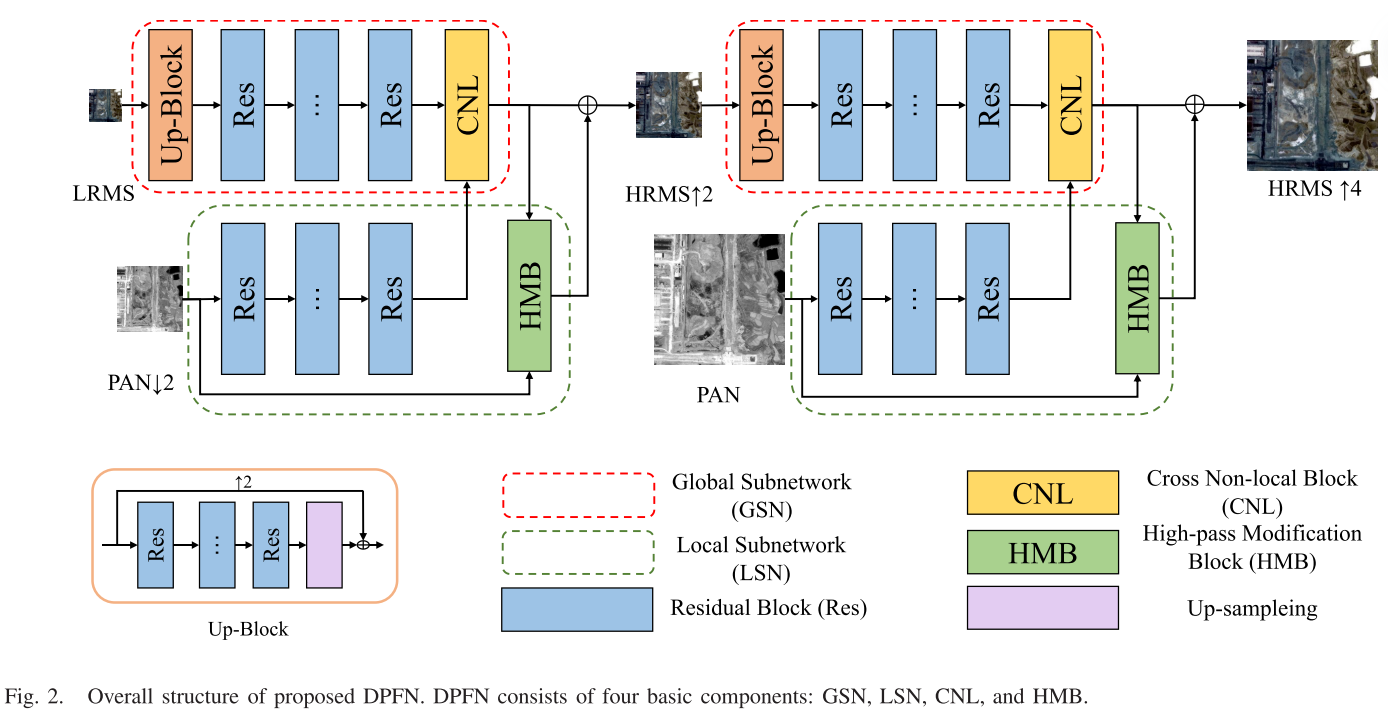

(传统的基于深度学习的全色锐化框架。(a)传统的全色锐化方法通常从LR-MS和PAN到HR-MS图像的级联(五个波段到一个HRMS图像策略)学习映射函数。然而,它们不能以有效的方式利用来自HR-PAN空间的全局信息,从而导致过度平滑的结果。(b)直接从PAN图像学习残差图引起光谱失真(一个高通版本PAN图像和一个LRMS对映射成一个HRMS图像策略)。提出了一种新的DPFN,它通过GSN和LSN分别学习全局谱空间信息和局部高通空间信息。BNIR表示NIR通道。©双路径映像策略:全局像素方式和局部残差方式)

由于来自PAN图像和MS图像的信息是互补的,具有相当大的冗余量,因此构建具有不同规格的高效深度学习模型成为全色锐化任务的主要焦点。利用MS/PAN图像对,图1总结了传统的基于深度学习的全色锐化框架。我们提出的DPFN的目标是逐步学习多尺度特征信息,从而获得最佳性能。受近邻嵌入模型应用的启发,该模型利用PAN图像中的HR块并将这些块重建为全色锐化图像,我们设计了交叉非局部块(CNL)来挖掘长距离和交叉空间依赖性,并聚合这些相关块以表征全局信息。所设计的CNL能有效地降低计算量。我们估计局部逐频带残余分量,而不是同时估计所有频带,目的在于利用唯一的逐频带高通信息。更具体地说,我们设计了一种新的高通修正块(HMB),通过空间关注块提取特殊的残差信息,以自适应地学习细粒度的纹理信息。学习的全局和局部分量被组合为全色锐化图像。此外,我们提出了一个近红外-VGG(near-infrared-VGG (NIR-VGG))损失,以指导网络集中在感知差异和产生视觉愉快的结果。

贡献

1)提出了一种高效的DPFN,分别通过GSN和LSN学习全局和局部信息。定性和定量结果均证实了所提出的DPFN优于现有的最新方法。

2)提出了一种结合邻域嵌入和残差块的全局纹理和光谱信息的GSN算法。融合PAN空间中的HR纹理信息和MS空间中的光谱信息来表征全局轮廓。该方法具有计算简单、空间和频谱失真小的特点。

3)我们设计了一个HMB来增强MS图像每个波段的高频空间信息。校正后的残差图像能够充分利用PAN图像的空间先验信息,在很大程度上避免了光谱失真问题。此外,我们使用感知损失来约束NIR波段的模型。感知域中的特征图在恢复细节纹理信息中起着重要作用。

相关工作

Pan-Sharpening

在过去的几十年中,已经提出和研究了各种全色锐化算法。传统的全色锐化方法可以分为三个主要类别:基于分量替换(CS)、多分辨率分析(MRA)和变分优化(VO)的方法。基于CS方法的主要思想是在合适的空间分离MS图像的空间和光谱信息,并进一步与PAN图像融合。代表性的基于CS的方法包括强度-色调-饱和度(IHS)方法、基于Brovey变换(BT)的方法、主成分分析(PCA)方法、Gram-Schmidt(GS)方法等。相比之下,基于MRA的方法通过拉普拉斯金字塔变换、小波变换、曲波变换和非下采样轮廓波变换将MS和PAN图像分解到多尺度空间。然后,将分解后的PAN图像注入到相应的MS图像中进行信息融合。CS和MRA的结合显示了空间-频谱统一保真度。然而,当不满足精确的图像配准时,上述方法是不足的。

基于VO的方法通过最小化损失函数将全色锐化任务视为不适定问题。Li和Yang首先提出了一种稀疏表示全色锐化方法,该方法在PAN空间中表示非局部关系,并在MS空间中重建HR patch。Cheng等人进一步采用了两步学习策略,提高了其表示能力。在此之后,使用各种正则化项,非局部、贝叶斯正则化和全变分算子被装备到表示系数优化中。然而,由于这些模型中的浅非线性表达,这些方法的性能受到限制。

最近,已经提出了几种基于神经网络的全色锐化算法,这得益于机器学习的强大特征提取能力和基于深度学习的单幅图像超分辨率的发展,有助于恢复LR图像中丢失的高频信息。受超分辨率CNN(SRCNN)的启发,PNN学习了LR-MS和PAN到HR-MS图像的级联之间的非线性映射函数。Scarpa等人提出了一种基于目标自适应神经网络的框架,该框架学习残差图像,进一步提高了图像融合的性能。多尺度多深度CNN(MSDCNN)被提出来提取多尺度特征。Han等人提出了一种基于表层和深层约束的全色锐化网络。Cai和Huang提出了一种超分辨率引导的渐进式全色锐化神经网络,以联合收割机多尺度特征并实现改进的性能。

然而,上述大多数全色锐化方法将MS/PAN图像对视为独立分量,并忽略了它们之间的空间-光谱相关性。Ma等人提出了一种通过生成对抗网络的无监督策略,而Zhang和Ma 等人在生成具有精确光谱分布的高质量图像之前使用梯度变换。

Nonlocal Mechanism

非局部均值运算

非局部均值运算(nonlocal mean operation)广泛用于图像修补任务,允许模型将所有空间位置处的全局面片聚合为位置处的响应。受非局域机制的启发,Zhu和Bamler 提出了一个新的模型,该模型构造了一对HR/LR PAN字典。Jiang等人提出了一种两步模型,利用PAN图像的HR纹理信息对MS特征进行精细表示。尽管这些方法在提高图像质量方面取得了成功,但这些浅学习网络在计算上要求很高,并且具有相当差的非线性表达能力,导致它们在实际应用中的性能有限,尤其是在大数据时代。Wang等人提出了一种非局部神经网络来捕获长距离依赖信息。之后,非局部机制被广泛应用于图像修补和增强任务,例如超分辨率,去噪和去雾。 在我们提出的方法中,总的目标是通过所提出的CNL模块来有效地捕获光谱信息和空间纹理,从而实现跨全局响应(空间和光谱响应)以改进我们的融合结果的质量。

Problem Formulation

现有的基于CNN的全色锐化方法具有保留频谱信息的能力,例如PNN和SDPNet,倾向于将全色锐化处理为黑盒问题。来自MSDCNN和SRPPNN的PAN域中的残差学习可以增强对空间纹理细节的关注,但是导致可观察到的频谱失真。由于融合结果倾向于MS图像或PAN图像,上述方法在性能上受到限制。融合结果的主观方面分别表现为模糊和光谱失真。这些现象背后的主要原因是忽视了MS和PAN图像之间的相关性。因此,提出的双路径策略的主要思想是利用MS和PAN图像之间的全局和局部相关性,以渐进的方式保留纹理和光谱信息。

图2展示出了所提出的方法的流程图,其包括两个主要部分:GSN和LSN。通过级联这些子网络,我们能够在多尺度框架中超分辨输入LR-MS和PAN图像,以减轻计算需求的负担。

我们将LR-MS图像表示为大小为w × h × c的ILRMS,将相应的HR-PAN图像表示为大小为rw × rh × 1的IPAN,并将地面真实HR-MS表示为IGT ∈

r

w

×

r

h

×

c

^{rw×rh×c}

rw×rh×c,其中w和h分别表示LR-MS图像的宽度和高度。c是MS图像中的图像波段的数量,r表示ILRMS和IPAN之间的空间分辨率尺度。我们的目标是生成具有高空间分辨率和高光谱分辨率的HR-MS图像IHRMS,给定输入HR-PAN图像,即IPAN和LR-MS图像,即ILRMS,通过端到端解决方案。

下面以尺度因子为×2的空间中的子网为例,详细给予了GSN和LSN的结构。

1) Global Subnetwork:

具体地,输入LRMS ILRMS被馈送到由特征提取部分(具有残差块)和上采样部分组成的up-block。然后,我们通过上采样空间中的特征提取器从MS和PAN图像中提取深度特征fLRMS和fPAN↓2。最后,利用CNL模块集成MS和PAN特征,学习非局部信息。该子网可表示为

其中HGSN1(·)指的是GSN的操作,其目的是学习全局信息,IGSN1(·)指全色锐化的MS图像,IPAN↓2表示比例因子为×2的IPAN下采样版本。

2) Local Subnetwork:

在GSN中重建的全色锐化MS图像首先被分成c个波段(在本研究中为R、G、B和BNIR,其中BNIR表示NIR通道)。LSN可表示为

其中HLSN1(·)旨在学习局部残差信息的LSN的操作。

进一步,通过求和运算,可以得到尺度因子为×2的空间中的最终全色锐化MS图像

Cross Nonlocal Block

非局部块通常用于图像修复任务,它允许模型将所有空间位置的全局像素聚合为某个位置的响应。具体而言,这些模型旨在计算整个空间空间的全局响应和聚合特征地图,期望有效挖掘相似和重复的互补信息。注意,在标准非局部块中,大小为W × H × C的矩阵相似度计算的算法复杂度为

(

W

H

)

2

(WH)^2

(WH)2。

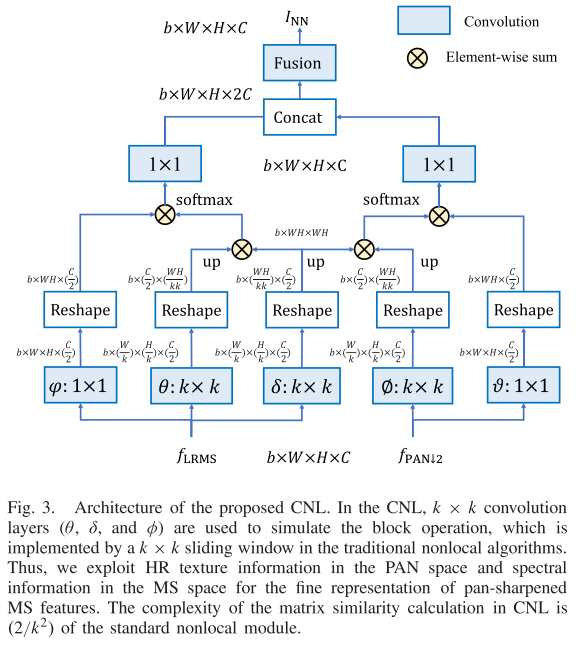

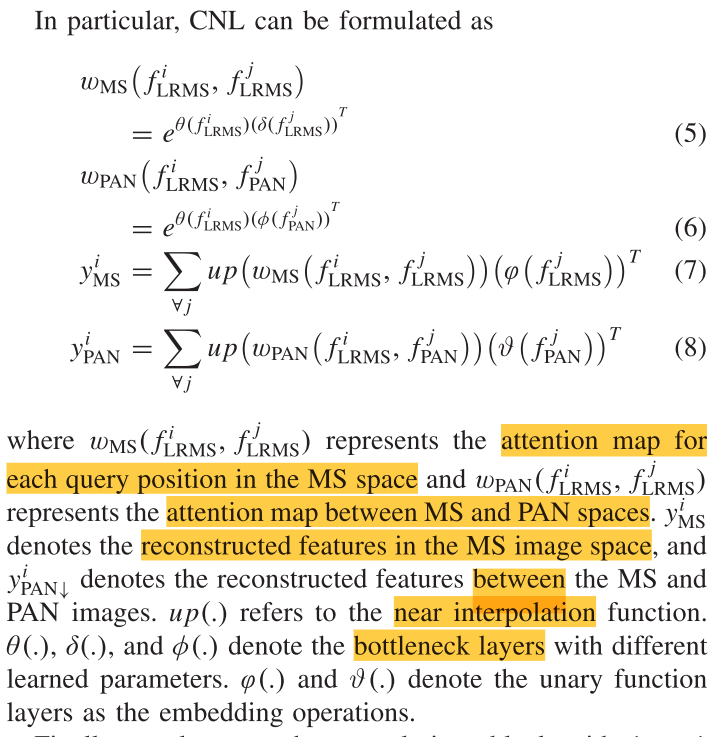

对于全色锐化问题,关键是有效地利用MS的固有特性和PAN图像特性,并聚合来自两个空间的特征图。在本文中,我们提出的CNL利用MS和PAN图像的非局部空间先验,如图3所示。

与标准非局部块不同,CNL利用PAN空间的HR纹理信息和MS空间的光谱信息来精细表示全色锐化的MS特征。 用k × k卷积层(图3中的θ、δ和Φ)来模拟传统非局部算法中由k × k滑动窗口实现的块运算。 CNL中矩阵相似度计算的复杂度为

2(

(

W

H

)

2

(WH)^2

(WH)2/

k

2

k^2

k2)。

以尺度因子为× 2的空间中的CNL为例,首先将输入的大小为W × H × C的MS特征图fLRMS和PAN特征图fPAN↓输入到CNL中。CNL的优点之一是k × k卷积的输入可以重新缩放为(W/k)×(H/k)× C。然后,将重新缩放的特征(在δ卷积层之后)乘以MS空间中的特征(在θ卷积层之后)和PAN空间中的特征(在Φ卷积层之后),以使用归一化(softmax函数)计算特征相关性。我们通过一个近似插值将相似矩阵重新标度为WH × WH。嵌入操作(图3中的φ和υ)旨在通过缩放因子重新缩放原始特征。根据所提出的CNL,我们利用PAN空间中的HR纹理信息和MS空间中的光谱信息来精细表示全色锐化的MS特征。

最后,我们利用具有1 × 1卷积层的卷积块,通过以下公式融合空间和光谱特征:

High-Pass Modification Block

高频和低频信息

全色锐化属于ill-posed问题,它利用来自PAN图像的附加先验信息进行重建。通常,大多数传统方法试图利用高频信息作为残差图。对于MS图像增强问题,关键是要有效利用高通PAN图像与不同波段MS图像各波段之间的内在联系,以减少高通PAN图像中光谱信息的影响。受Zhang等人的启发,我们引入了空间注意机制来自适应地重新缩放每个像素特征,从而提高空间残差信息的表示能力。

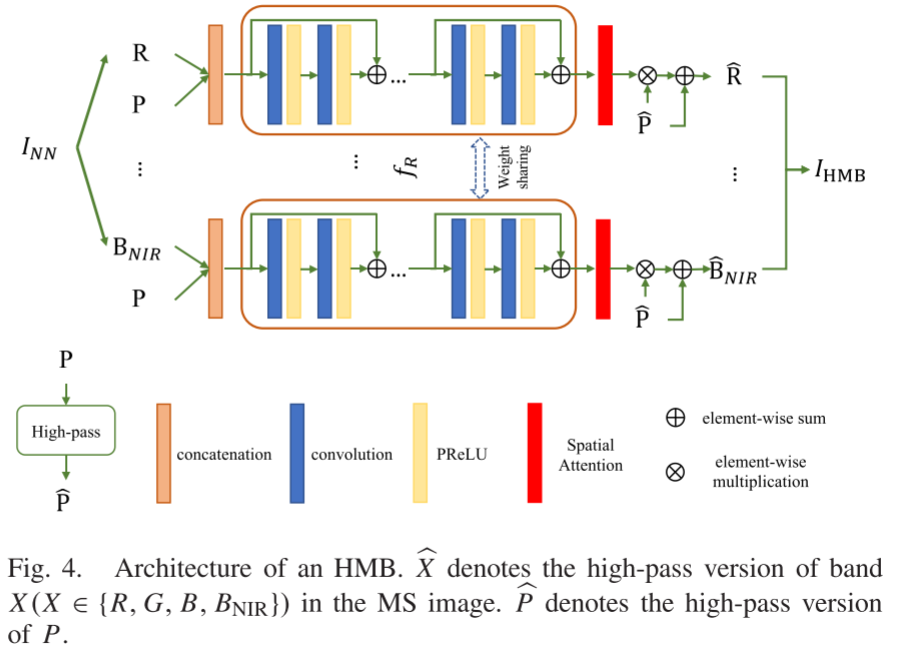

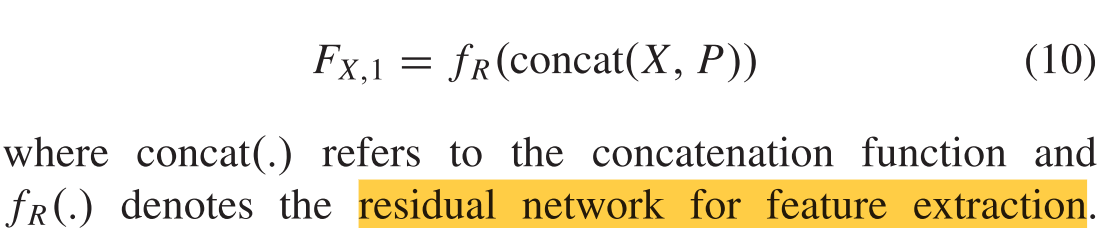

提出的HMB(见图4),称为HMB,旨在利用高频先验。首先,将CNL的输出INN分解为单波段图像X(在本研究中,X ∈ {R,G,B,BNIR})。单波段图像X(在本研究中,X ∈ {R,G,B,BNIR})。之后,我们将单波段图像X和PAN图像P的连接馈送到HMB中用于特征提取。特别地,HMB级联nr(nr = 12)个具有3 × 3卷积的剩余块。

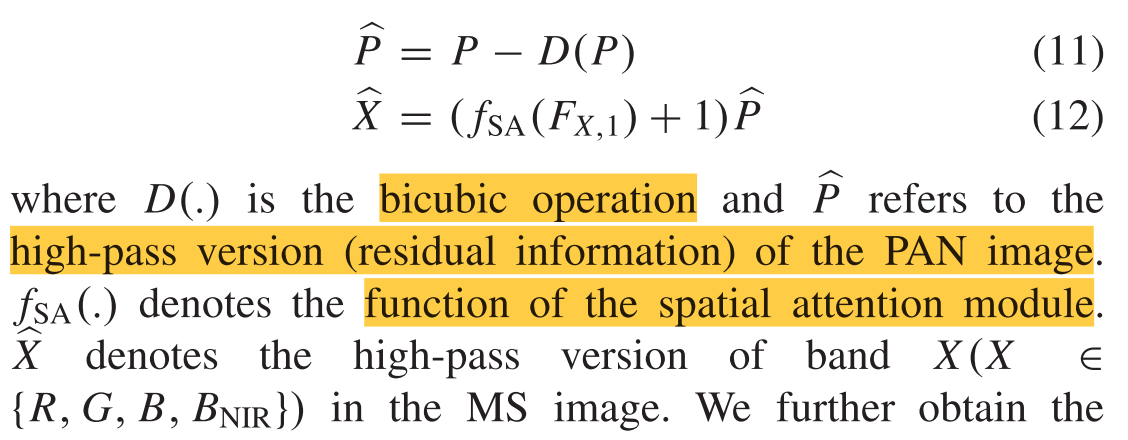

我们进一步将FX,1馈送到空间注意块中,其中通过空间特征的自适应学习,利用高频信息层进一步补充全色锐化图像。此过程可表示为

我们进一步通过下式获得当前HMB的高通输出:

其中IHMB表示用于重建的MS图像的高通版本。全色锐化MS图像可定义为

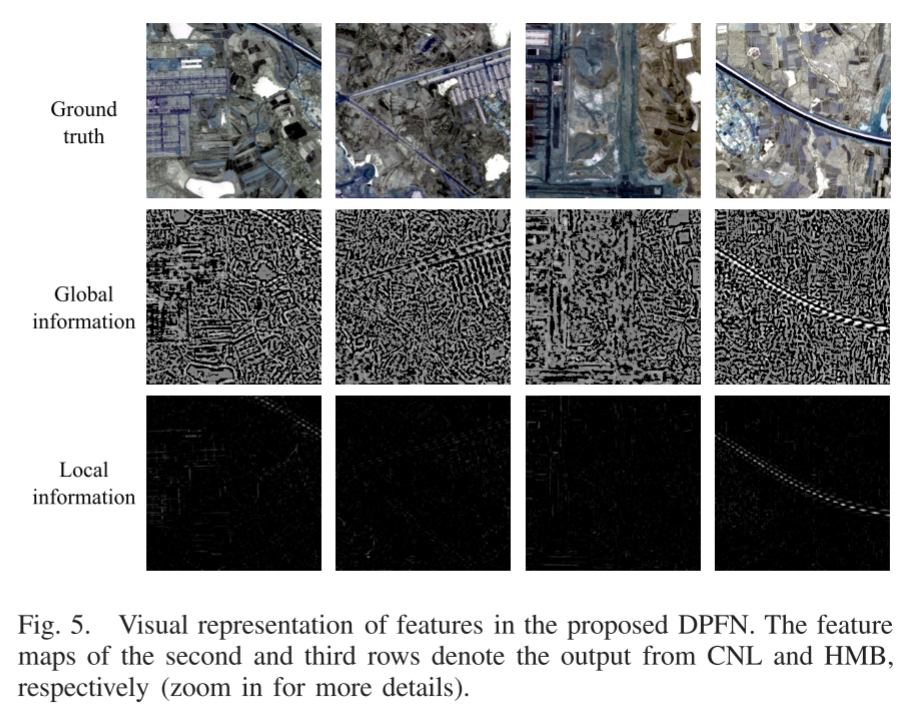

为了更好地理解我们提出的CNL和HMB,我们在图5中给出了中间结果。

第二和第三行的特征图分别表示来自所提出的CNL和HMB的输出特征。第三行的特征中的像素稀疏分布并且具有相对小的值,因为局部信息主要包含高频信息。实验结果表明,所提出的CNL算法能够有效地恢复HMB算法更倾向于推断高通版本局部信息的图像中的全局信息,证明了所提出的双路径策略在全色锐化任务中的有效性.

Loss Function

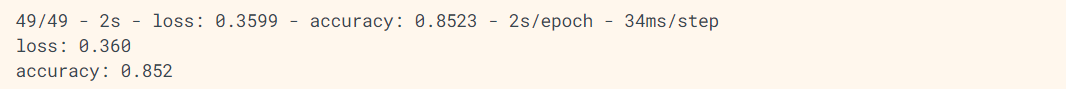

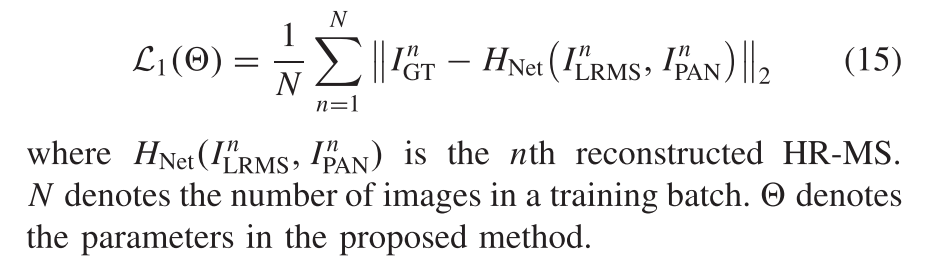

现有的全色锐化模型训练方法大多采用像素级误差作为损失函数,以获得更客观的评价结果。其中,均方误差(MSE)和平均绝对误差(MAE)是应用最广泛的损失函数。具体而言,L2损失定义为HR-MS和真实数据之间的MSE

尽管像素式损失函数可以实现高客观结果,但是它们不能捕获感知差异(例如,纹理和边缘)并且倾向于产生过平滑的图像。在本研究中,设计了一个感知损失函数,以捕获高级特征并生成视觉上令人愉悦的纹理信息。与自然图像不同,MS图像的NIR(近红外波段)的光谱波长比其他波段要大,这使得NIR的纹理信息丰富而完整。因此,我们认为近红外空间(NIR)的感知损失可以捕获可见光成像中被忽略的细节。

受SR任务中基于VGG的特征损失函数的启发,我们提出了一种新的用于纹理增强的NIR-VGG损失。具体而言,NIR-VGG损失最小化了NIR和PAN空间中的特征误差。

其中NIR(·)表示图像的NIR波段,Φ(·)是预训练VGG-19网络的输出特征图。LNN表示在NIR波段空间中HR-MS和PAN图像之间的损失。LNP表示PAN和NIR图像之间的损失。NIR-VGG损失计算如下:

总之,最终损失函数是两个损失之和

其中L1用于避免光谱失真,LNIR−VGG可以恢复纹理信息。

考虑到NIR-VGG损失函数可能降低全色锐化图像的客观性,我们将用L1训练的提议模型命名为DPFN,用Ltotal训练的提议模型命名为DPFN+。

![[附源码]计算机毕业设计健身房预约平台Springboot程序](https://img-blog.csdnimg.cn/398256064ea64c42818e216d6a3ab0c6.png)