Datawhale开源

联合发布:同济子豪兄、Datawhale

文章目录

1.什么是机器学习的可解释性分析。

2.学可解释机器学习有什么用?

3.可解释机器学习开源学习计划,同济子豪兄和 Datawhale 联合发布。

什么是可解释AI

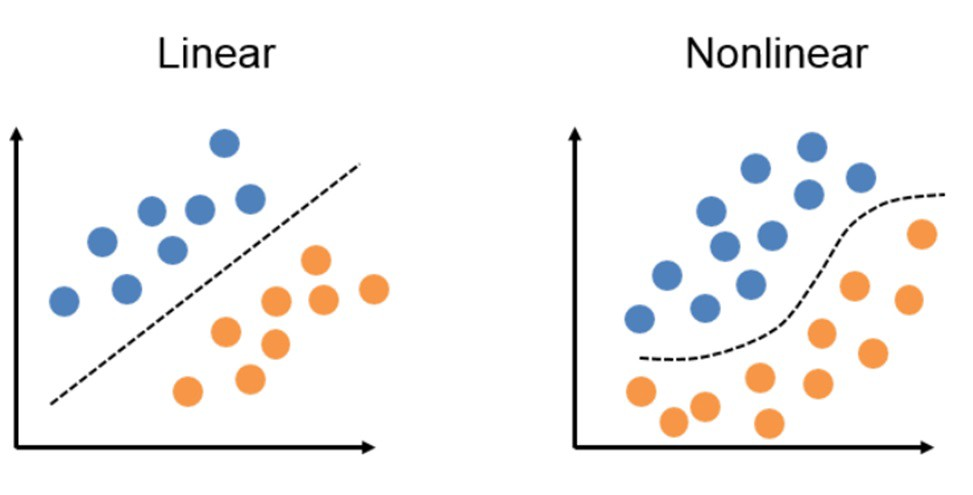

现代的机器学习和人工智能,属于“统计学习”,通过大量的数据和经验训练算法,拟合出决策边界和数据分布。

比如识别猫狗的神经网络,输入大量标注好类别的图像,通过神经网络算法,在高维空间拟合非线性、非凸的数据分布和决策边界。

但没人知道神经网络拟合出的数据分布和决策边界真正长什么样子。

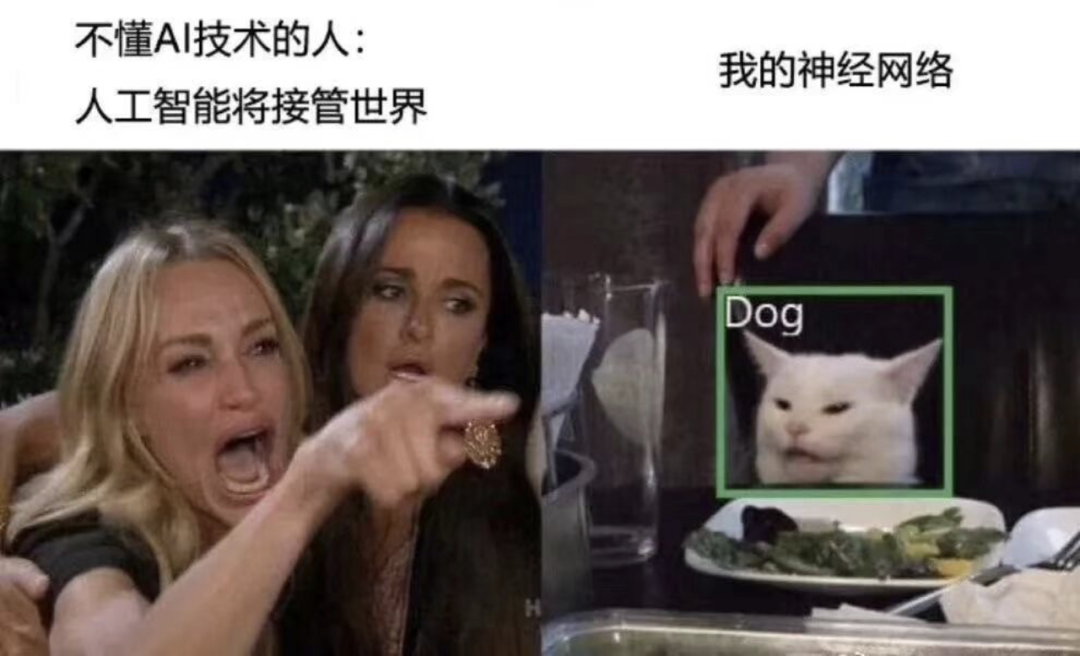

并且随着神经网络越来越深,参数越来越多,数据量越来越大。人工智能变得越来越像黑盒子。

人类根本不清楚它内部的脑回路,到底是怎么做出决策的。

AI到底学习到了哪些特征,是不是符合人类的直觉和常识。

AI什么时候work,什么时候不work。

AI到底有没有过拟合,如何进一步改进它和数据集。

特别是医疗、无人驾驶、金融这些人命关天的领域,你愿不愿意把身家性命托付给AI。

可解释性分析,就是研究如何打开人工智能的黑箱子,洞悉AI的脑回路和注意力,进而解释它、了解它、改进它、信赖它。知其然,也知其所以然。

可解释AI有什么用?

研究AI的脑回路,就是研究AI的本质。

可解释分析是人工智能的通用研究方法,无论传统数据挖掘、计算机视觉、自然语言处理、强化学习,都可以和可解释性分析交叉融合,作为研究工作的核心创新点。

包括但不限于:大模型、缺陷异常检测、细粒度分类、决策AI和强化学习、图神经网络、AI纠偏、AI4Science、Machine Teaching、对抗样本、可信计算。

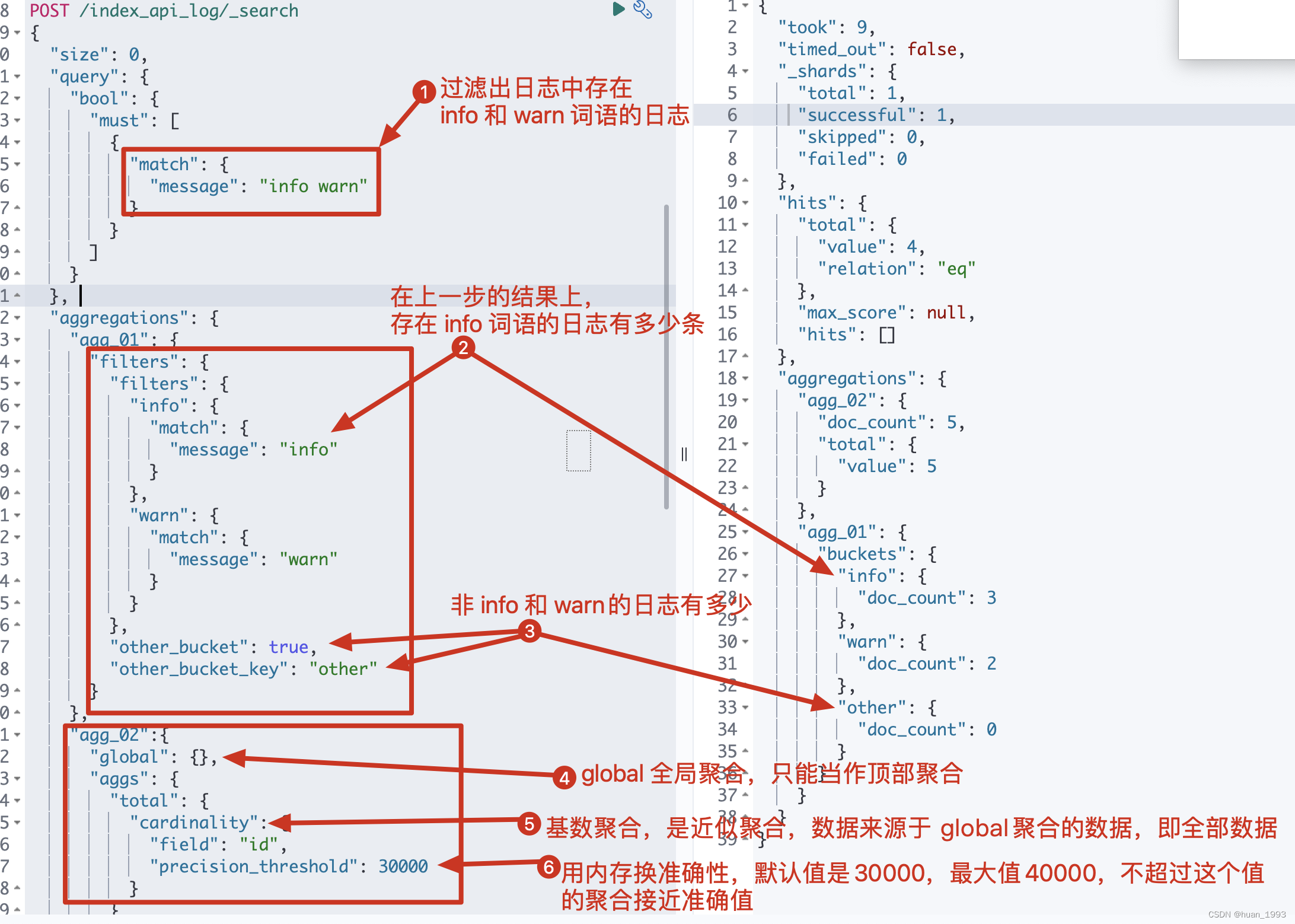

对YOLO目标检测做可解释性分析:

图1:来源OpenMMLab

甚至,还可以让AI把学到的知识教给人类,比如下围棋,识别鸟类、打游戏、画画,从Machine Learning升华到Machine Teaching,引领人类进步。

Datawhale开源学习计划

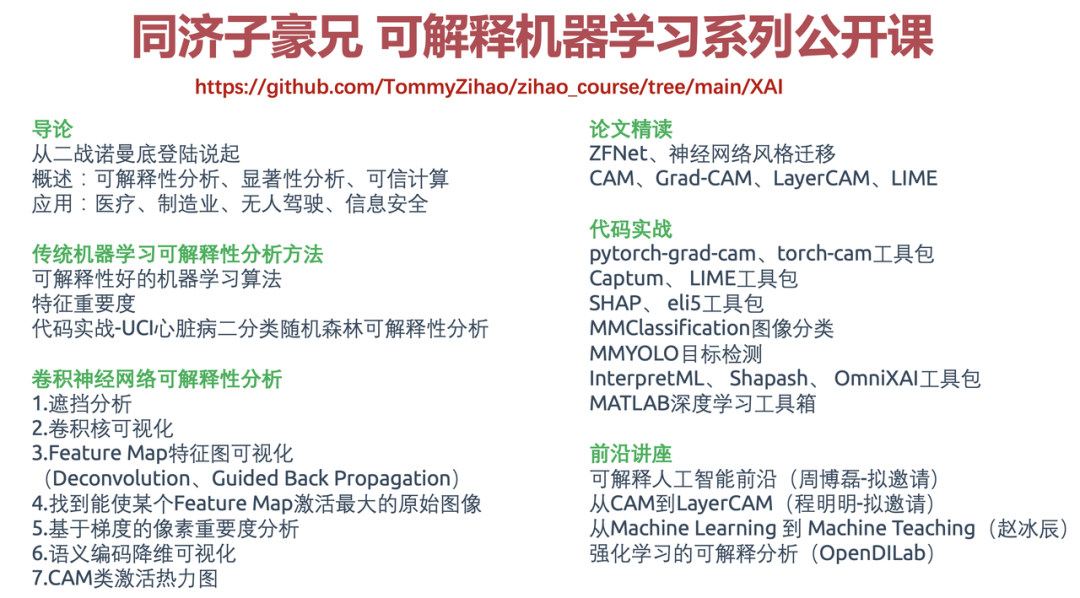

可解释机器学习系列公开课,包含人工智能可解释性分析领域的导论、算法综述、经典论文精读、代码实战、前沿讲座。由B站知名UP主“同济子豪兄”主讲,课程视频免费开源。

开源地址:https://github.com/TommyZihao/zihao_course/tree/main/XAI

更多开源教程:

https://github.com/datawhalechina

参与组队学习:

Datawhale十二月组队学习(可点击)

本课程还得到了周博磊(UCLA)、程明明(南开大学)、姜鹏涛(浙江大学)、赵冰辰(爱丁堡大学)、杨思苇(同济大学)等老师,和Datawhale、量子位、 中国图象图形学学会-科普与教育工作委员会的大力支持。

图2:公开课内容

图2:公开课内容

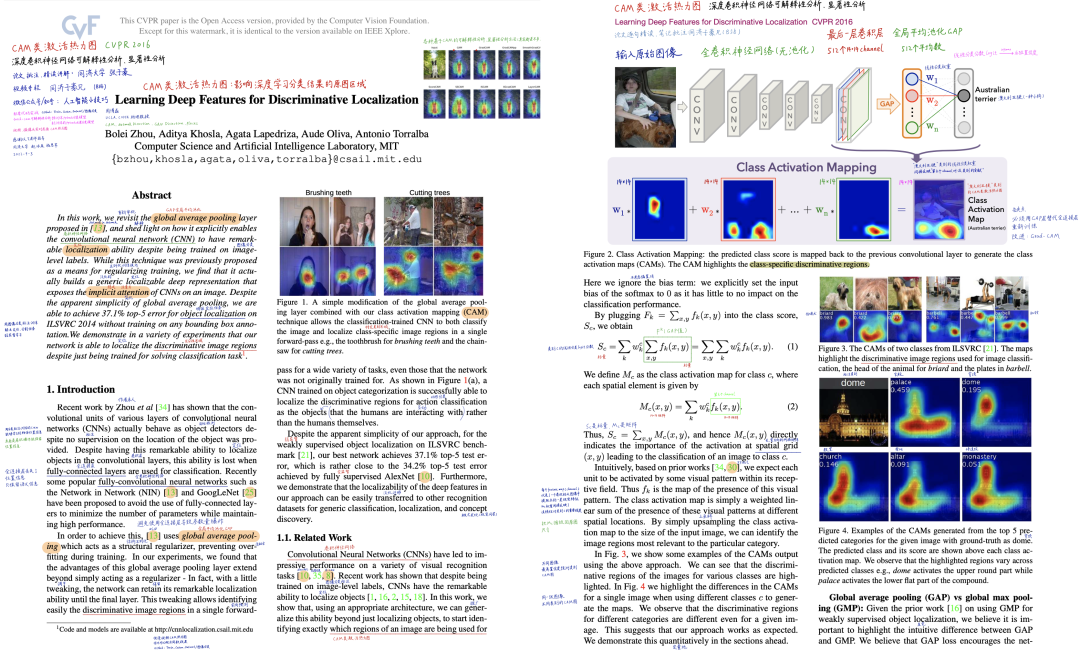

图3:论文逐句精读

开源学习贡献者

航路开辟者(主讲人)

张子豪,B站人工智能科普UP主“同济子豪兄”:https://space.bilibili.com/1900783

微软人工智能最有价值专家(MVP)、华为人工智能HCDE云享专家、上海人工智能实验室计算机视觉算法研究员。

代表作:精读AI经典论文、编程奇妙夜、斯坦福CS231N、CS224W公开课中文精讲、OpenMMLab代码实战。

航海士(助教):

吕豪杰,Datawhale成员,北京邮电大学

乔宇,北京大学软件工程在读研究生,研究方向:可解释性AI、建筑学。

张燕,研究方向:可解释性AI、因果学习。

田文博,曾参与国家田径队人体姿态估计分析工作。

刘一鸣,北京工业大学在读博士,研究方向:深度学习可解释性、废旧家电识别。

![[论文阅读] 颜色迁移-梯度保护颜色迁移](https://img-blog.csdnimg.cn/1a70eda52f5a40c4bfc952c3d8f7e9fe.png)