AI大模型对算力的要求非常高,需要高性能的硬件设备和分布式训练技术来支持。随着AI技术的不断发展,未来可能会出现更大、更复杂的模型,对算力的要求也将更高。今天和大家分享几个大模型及算力要求,希望对大家有所帮助。北京木奇移动技术有限公司,专业的软件外包开发公司,欢迎交流合作。

主要包括以下几种:

1. GPT-3(Generative Pre-trained Transformer 3):GPT-3是OpenAI开发的自然语言处理模型,拥有1750亿个参数。它可以生成非常接近人类水平的文本,进行翻译、问答、摘要等任务。

2. BERT(Bidirectional Encoder Representations from Transformers):BERT是谷歌开发的自然语言处理模型,具有强大的语义理解能力。它可以用于文本分类、命名实体识别、问答等任务。

3. T5(Text-to-Text Transfer Transformer):T5是谷歌开发的自然语言处理模型,将所有NLP任务视为文本到文本的转换问题。它可以用于文本分类、翻译、摘要等任务。

4. Megatron:Megatron是NVIDIA开发的大规模自然语言处理模型,旨在实现更大、更复杂的神经网络。它可以用于各种NLP任务,如文本生成、翻译等。

对于这些大模型的算力要求,主要包括以下几点:

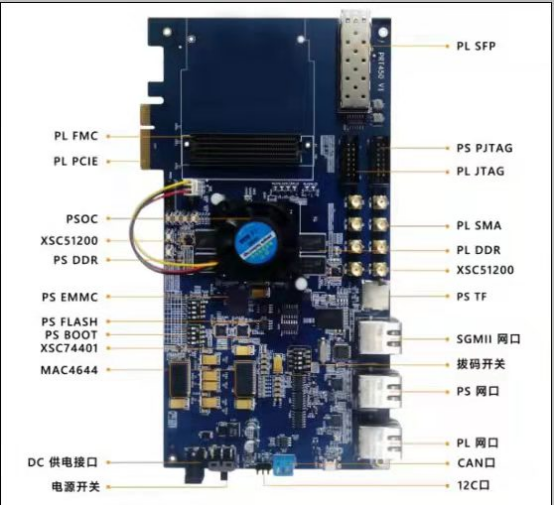

1. 高性能的GPU:大模型需要大量的并行计算能力,因此需要高性能的GPU来进行训练。例如,NVIDIA的A100、V100等GPU可以提供强大的计算能力。

2. 大量的显存:大模型需要在GPU显存中存储大量的参数和梯度信息,因此需要具备足够大的显存。例如,NVIDIA A100具有40GB或80GB的显存。

3. 高速的内存和存储:大模型在训练过程中需要快速读取和写入数据,因此需要高速的内存和存储设备,如DDR4内存、NVMe SSD等。

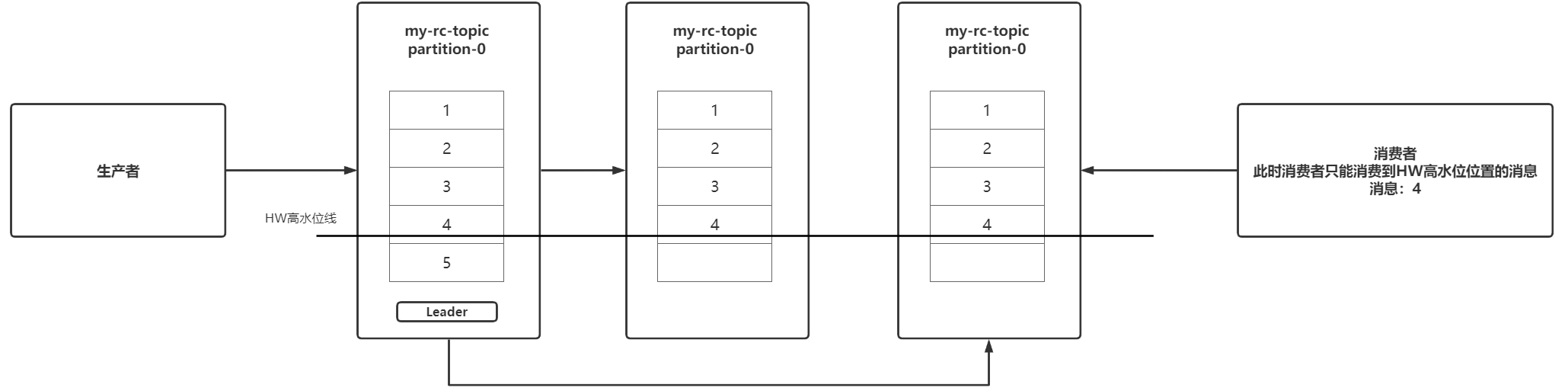

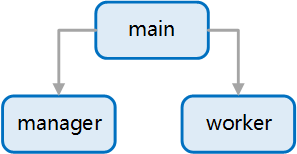

4. 分布式训练:由于大模型的计算量非常大,单个GPU很难满足训练需求。因此,需要使用分布式训练技术,将模型训练任务分配到多个GPU或服务器上进行并行计算。

5. 高速的网络连接:在分布式训练中,各个GPU或服务器之间需要高速的网络连接来传输数据和同步梯度信息。例如,使用InfiniBand或100Gbps以太网等高速网络。