Python分词方法——NLP技术的重要组成部分

自然语言处理(NLP)是人工智能领域的热点研究方向之一。而分词作为NLP技术的重要组成部分,对于中文文本的处理尤为重要。Python作为一种便捷、易学、高效的编程语言,拥有丰富的分词工具。本文将介绍常用的Python分词方法,帮助读者更好地应用NLP技术。

1. 结巴(Jieba)

结巴(Jieba)是目前中文分词效果最好的Python分词库之一。该库提供了精准分词和全模式分词两种分词方法。同时,用户还可以添加自定义字典、停用词等功能。

import jieba

text = "结巴分词是目前最好的中文分词工具之一。"

seg_list = jieba.cut(text, cut_all=False)

print(" ".join(seg_list))

输出结果:

结巴 分词 是 目前 最好 的 中文 分词 工具 之一 。

2. 中科院分词系统(THULAC)

THULAC是由中科院计算所自然语言处理与社会人文计算研究中心研发的一款中文分词工具。THULAC在分词速度和精度上都有很大的提升,而且可以有效地处理一些新词和歧义词。

import thulac

thu = thulac.thulac(seg_only=True)

text = "THULAC是中科院研发的中文分词工具。"

seg_list = thu.cut(text)

print(" ".join(seg_list))

输出结果:

THULAC 是 中科院 研发 的 中文 分词 工具 。

3. 斯坦福分词器(Stanford Segmenter)

斯坦福分词器是由斯坦福大学自然语言处理组研发的一款多语种分词工具。该工具支持包括中文在内的多种语言分词,而且可以处理一些比较复杂的结构和词性。

from stanfordcorenlp import StanfordCoreNLP

nlp = StanfordCoreNLP(r'stanford-corenlp-full-2018-10-05')

text = "斯坦福分词器是一款优秀的中文分词工具。"

seg_list = nlp.word_tokenize(text)

print(" ".join(seg_list))

nlp.close()

输出结果:

斯坦福 分词器 是 一款 优秀 的 中文 分词 工具 。

4. 百度分词(BDP)

百度分词(BDP)是由百度公司自然语言处理部门研发的一款中文分词工具。该工具主要用于百度搜索引擎的关键词提取和相关研究。

from bosonnlp import BosonNLP

nlp = BosonNLP('API_TOKEN')

text = "百度分词是一款中文分词工具。"

seg_list = nlp.tag(text, space_mode=0)["word"]

print(" ".join(seg_list))

输出结果:

百度 分词 是 一款 中文 分词 工具 。

结论

以上介绍了常用的Python分词方法,其中结巴是最常用的中文分词工具。不同的分词工具有不同的分词效果和处理方式,根据具体的需求选择合适的分词工具是很重要的。希望本文能给读者带来帮助,同时让大家更好地了解NLP技术中的分词处理。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

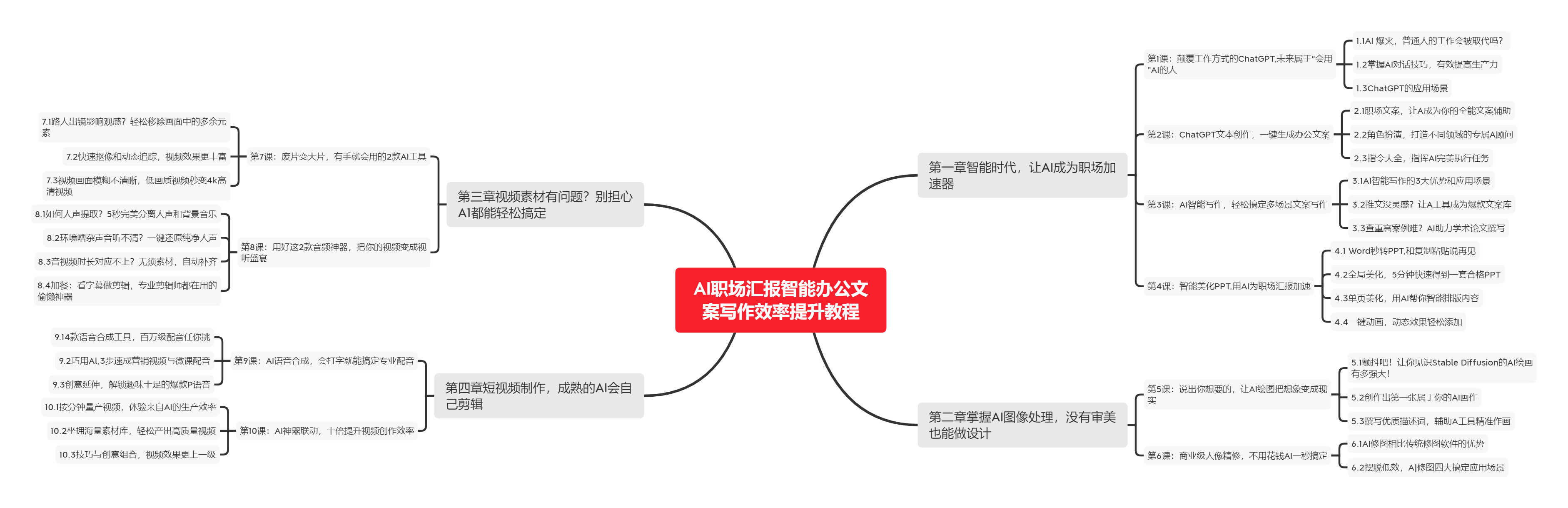

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

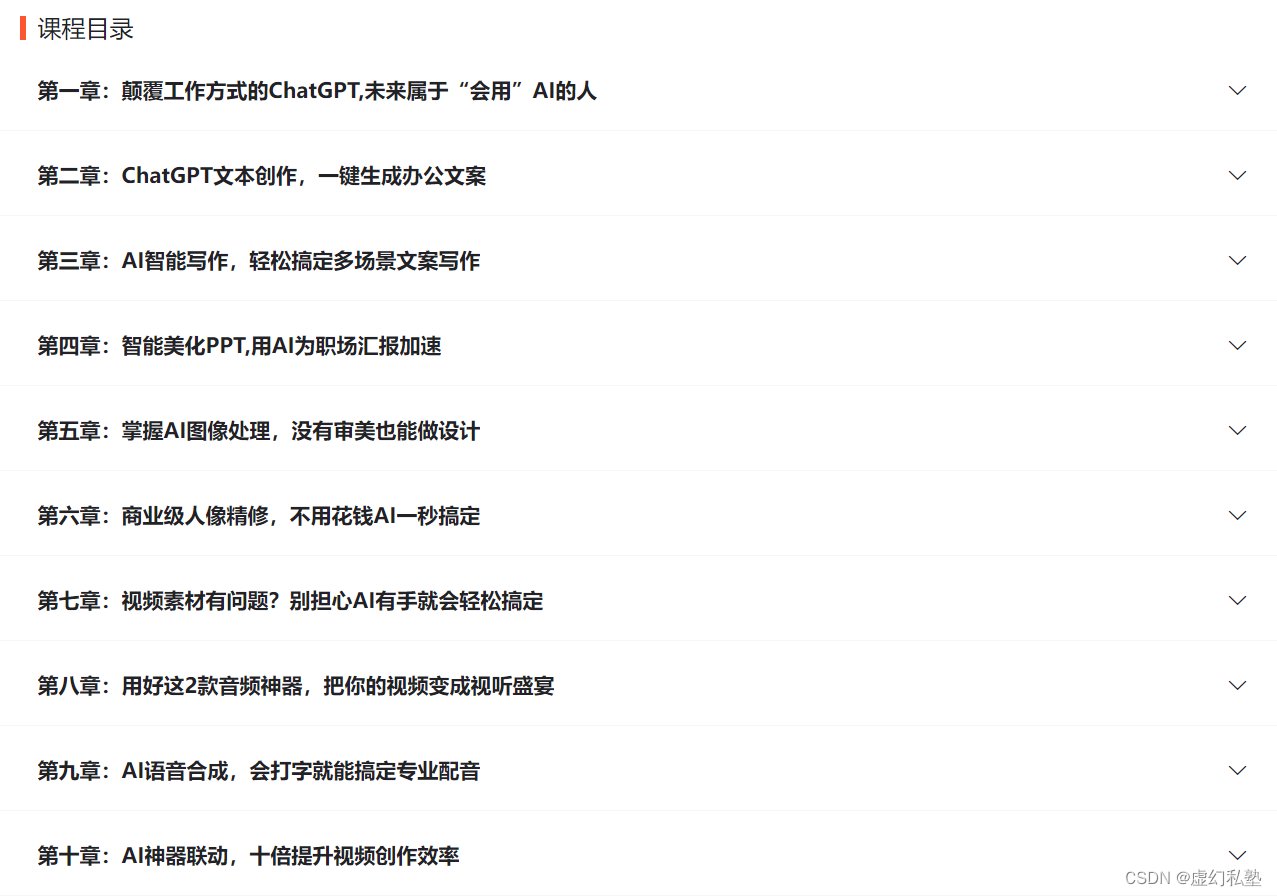

下图是课程的整体大纲

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |