Python3.9安装Scrapy——加速数据抓取的利器

在现代数字化时代,数据抓取和数据挖掘的重要性越来越受到重视。作为一种高效的爬虫框架,Scrapy能够实现快速的页面抓取和数据解析,并帮助我们快速获取所需数据。本篇文章将会为大家介绍如何在Python3.9环境中安装Scrapy,以利用该框架来更加高效地抓取所需数据。

环境准备

在开始安装Scrapy前,首先要确保Python环境已经安装并配置完成。最新的Python版本是Python3.9,在这个版本的Python中,我们已经可以使用官方默认提供的pip工具了。因此,我们可以通过以下命令来检查Python版本是否正常:

python --version

在确认Python环境正常后,我们需要使用pip工具来安装Scrapy。在使用pip前,需要更新pip本身到最新版本:

python -m pip install --upgrade pip

安装Scrapy

在pip更新完成后,我们可以通过以下命令来安装Scrapy:

pip install scrapy

由于Scrapy是一个比较大的库,下载和安装需要较多时间,需要耐心等待。在安装完成后,我们可以通过以下命令来检查Scrapy是否成功安装:

scrapy version

如果输出的版本号符合我们期望,即表示Scrapy已经成功安装。(注:由于Scrapy使用Twisted作为底层网络库,如果我们的系统没有正确安装Twisted,也会导致Scrapy无法正常运行。因此,在安装Scrapy之前,需要确保我们已经安装了正确的Twisted库。)

Scrapy实践

在安装完成Scrapy后,我们可以将其运用到实际的数据抓取中。在Scrapy中,我们可以通过编写一个Spider蜘蛛程序来定义抓取规则和数据解析规则,然后使用Scrapy提供的命令行工具来启动蜘蛛并开始数据抓取。

在定义Spider时,我们需要先定义起始的URL和如何解析该URL页面的方法。Scrapy提供start_urls和parse两个核心方法来实现这个功能。在下面的示例中,我们将定义一个名为"douban_movie"的Spider蜘蛛,该蜘蛛会抓取豆瓣电影Top250中的相关信息。

import scrapy

class DoubanMovieSpider(scrapy.Spider):

name = "douban_movie"

start_urls = ['https://movie.douban.com/top250']

def parse(self, response):

for article in response.xpath('//article[@class="item"]'):

yield {

'title': article.xpath('.//span[@class="title"]/text()').extract(),

'score': float(article.xpath('.//div[@class="star"]/span[@class="rating_num"]/text()').extract_first()),

'summary': article.xpath('.//div[@class="bd"]/p[@class="quote"]/span/text()').extract()

}

next_page = response.xpath('//div[@class="paginator"]/span[@class="next"]/a/@href')

if next_page:

yield response.follow(next_page, self.parse)

在上面的代码中,我们首先定义了Spider蜘蛛的名称为"douban_movie",然后指定起始的URL为https://movie.douban.com/top250。在parse方法中,我们使用XPath选择器来选择对应的HTML元素,并解析出需要的数据。最后通过yield来返回解析结果。在循环中,我们使用了Scrapy提供的response.follow方法来跟踪下一页,并在下一页存在的情况下重复调用parse方法。

在Spider蜘蛛程序定义完成后,我们可以使用Scrapy提供的命令行工具来启动蜘蛛,并开始抓取:

scrapy crawl douban_movie -o douban.json

在上述命令中,我们使用-crawl选项启动名为"douban_movie"的Spider蜘蛛。其中-o选项表示将数据结果保存到douban.json中,以供后续使用。

结论

Scrapy作为一种高效的爬虫框架,可以帮助我们快速地抓取所需数据。在实际的抓取过程中,我们需要注意合理使用Scrapy提供的API接口,并在定义Spider时遵循一定的规范和最佳实践。同时,在使用Scrapy前,我们需要确保Python环境和Scrapy所依赖的Twisted库都已经正确安装和配置。只有这样,我们才能够充分发挥Scrapy的优势,提高数据抓取的效率和准确度。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

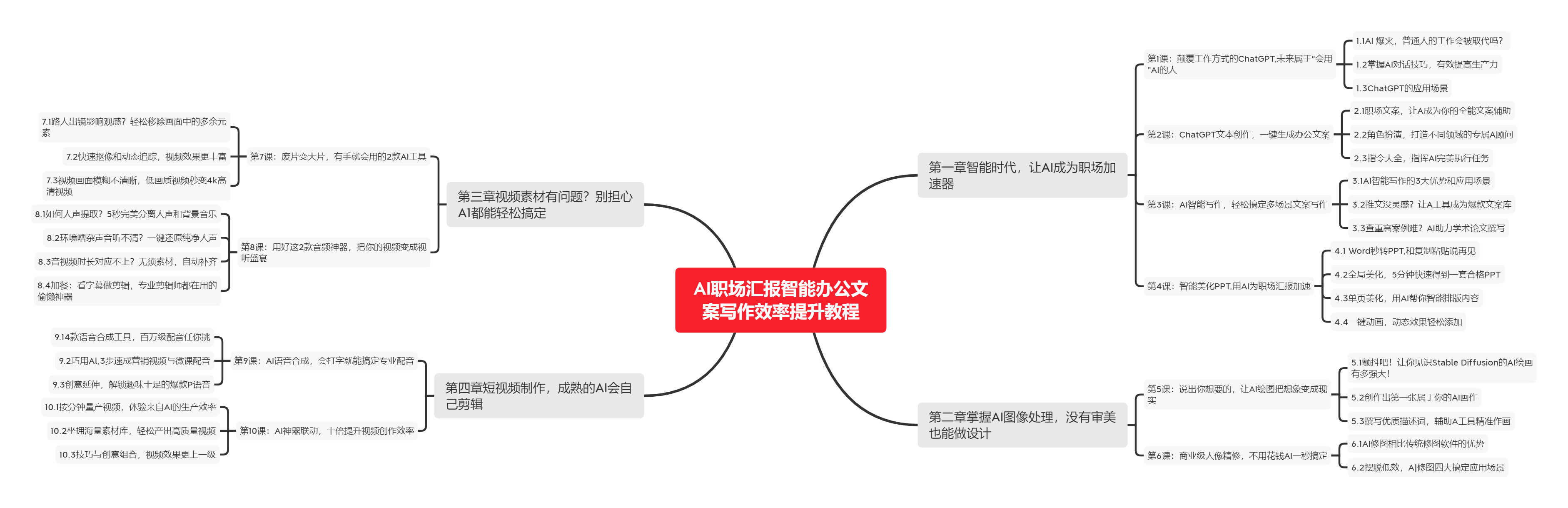

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

下图是课程的整体大纲

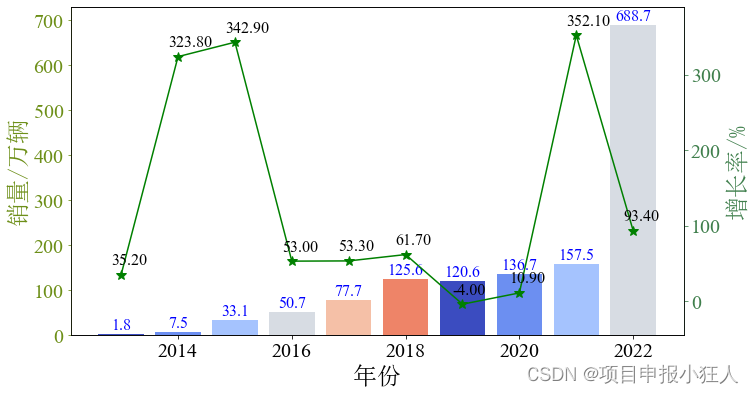

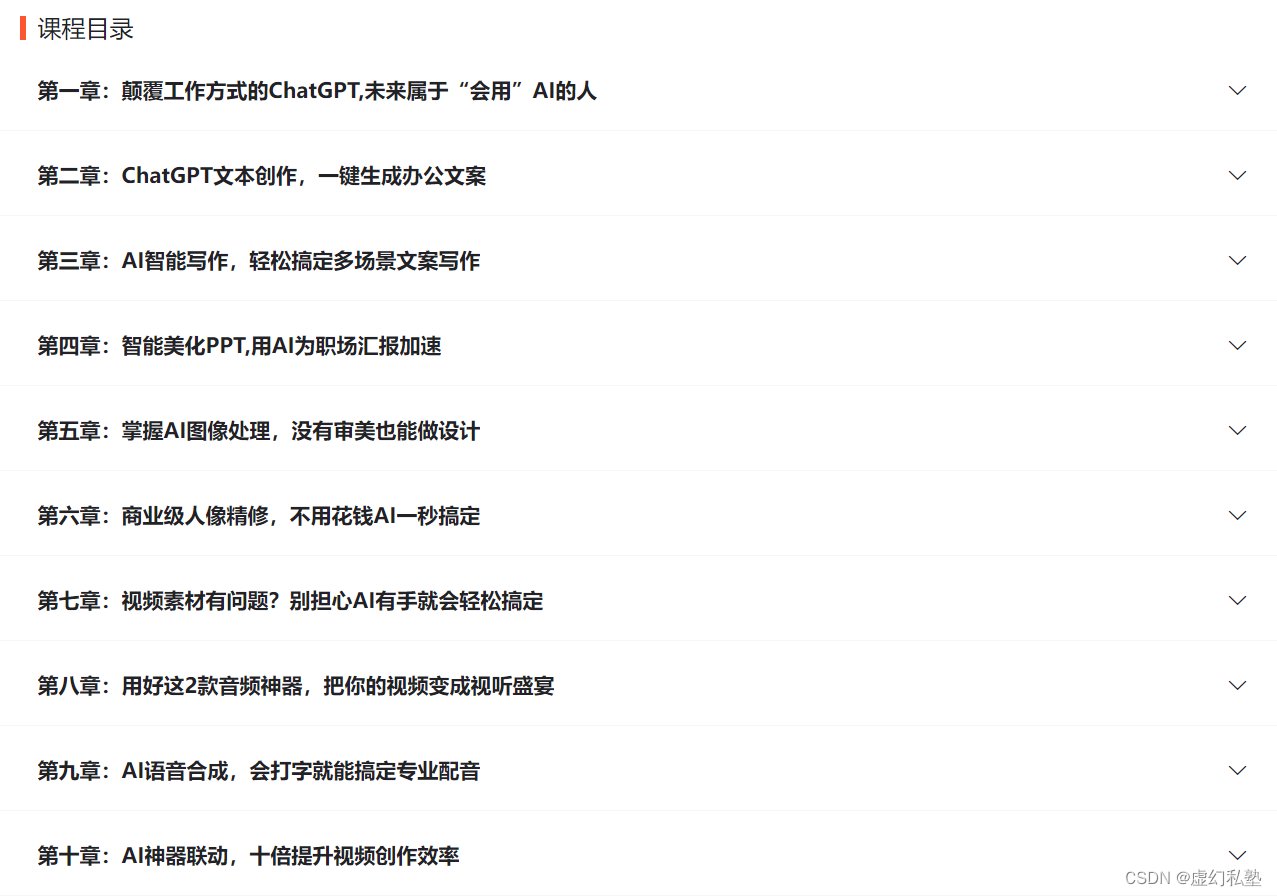

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

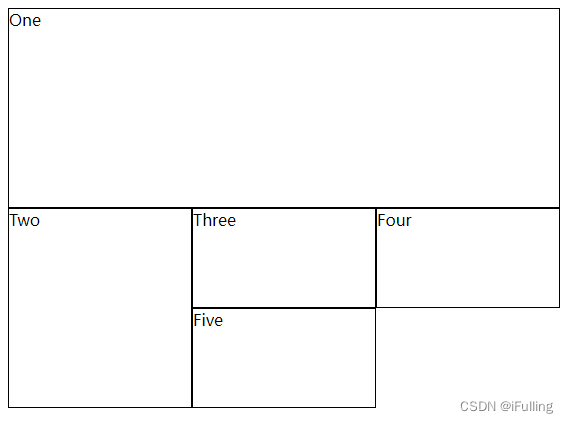

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |