概述

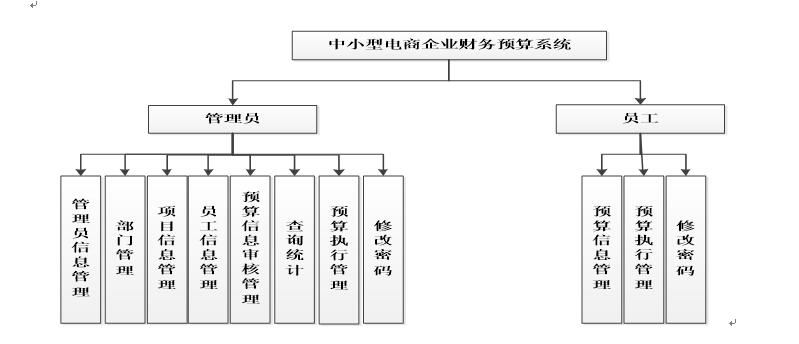

音视频编解码技术在当前的互联网行业中十分热门,特别是高清视频播放器的开发,其中包括4K、8K等超高清分辨率的播放器,具有极高的市场需求和广泛的应用场景。H265编码技术更是实现高清视频压缩的重要手段之一。如果想要掌握音视频编解码及超高清视频播放器的开发技术,以下是一些可以逐步实现的步骤:

- 学习音视频编解码原理和实现方式,掌握常用编解码库的使用,比如FFmpeg、x264/x265等。

- 搭建音视频播放器的开发环境,根据实际需求选择合适的编程语言和开发平台,如使用C++ language编写桌面端播放器,或者使用Java或Kotlin等语言进行Android平台开发。

- 利用FFmpeg等编解码库实现解码、解封装等基本功能,读取高清视频文件及音频文件流数据。

- 实现视频渲染、音频播放等部分功能,根据实际需求实现特效、字幕、调节播放速度等功能。

- 支持H265编码技术,实现4K、8K等超高清视频播放功能,并对不同的分辨率、码率、帧率等进行适配和优化。

- 进一步增加播放器的稳定性和性能,优化内存管理、线程模型等方面的问题,提高用户体验。

手写一个高清播放器之前,我们先来了解一下其他需要用到的 核心技术:

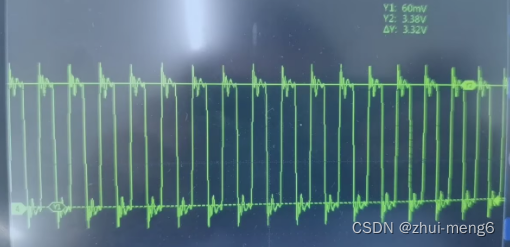

DSP芯片解码流程

数字信号处理器(DSP)是一种专门用于数字信号处理的微处理器,其特点是快速、高效、低功耗。在音视频编解码领域,DSP芯片可以实现高效的音视频解码功能。其解码流程一般包括以下步骤:

- 解封装:DSP芯片需要从音视频文件中读取数据,因此需要进行解封装处理。解封装的过程解析音视频文件格式并提取出其中的音频数据和视频数据。

- 音视频解码:解封装后,需要对音频数据和视频数据进行解码。DSP芯片内置了相应的音视频解码器,可以通过调用解码器接口完成解码工作。

- 重采样:DSP芯片的运行速度有限,可能无法满足高采样率的音频数据的解码工作。因此需要对音频数据进行重采样处理,将高采样率的音频数据转换为低采样率的数据。

- 合成和渲染:将解码后的音频数据和视频数据进行合成,DSP芯片需要维护音视频同步,同时也需要进行视频渲染工作。渲染包括色彩空间转换、缩放、去隔行等。渲染后的结果将通过显示设备呈现给用户。

- 帧缓存管理:解码后的视频数据需要保存在帧缓存中,DSP芯片需要对帧缓存进行管理,包括帧缓存的申请、释放、重用等。

- 优化处理:DSP芯片的计算性能有限,需要进行优化处理,包括指令选择、代码结构优化、内存访问优化等。

- 错误处理:在解码过程中可能会出现各种错误,DSP芯片需要能够检测到这些错误并进行相应的处理,比如重试、回退等操作。

DSP芯片解码流程包括封装解析、音视频解码、重采样、合成和渲染、帧缓存管理、优化处理、错误处理等多个环节,需要结合具体的硬件平台和解码标准进行实现。

MediaPlayer与DSP芯片交互机制

MediaPlayer是Android平台上用于音视频播放的API,而DSP芯片则是专门用于数字信号处理的芯片。虽然它们表面上是不同的组件,但是在特定场景下,你可以将它们合并使用,以提升音视频的处理能力和性能,这就需要考虑MediaPlayer和DSP芯片之间的交互机制了。

一般来说,MediaPlayer和DSP芯片可以通过以下几种方式进行交互:

- 硬件加速:Android平台上的一些高端的DSP芯片支持硬件加速,可以直接在硬件上处理音视频解码和渲染。此时MediaPlayer可以将解码后的音视频数据传输给DSP芯片进行处理,并且可以获取DSP芯片的解码和渲染状态,反馈给应用程序进行调度。

- DSP接口:有些DSP芯片支持标准的接口,比如OpenMAX、GStreamer等,可以直接和MediaPlayer进行交互。此时MediaPlayer会将解码后的音视频数据传输给DSP芯片进行处理,并且通过标准接口获取DSP芯片的解码和渲染状态,包括帧率、码率、分辨率等等。

- 自定义协议:在某些场景下,DSP芯片和MediaPlayer交互需要使用特定的协议。此时应用程序需要实现自定义协议,将解码后的音视频数据传输给DSP芯片,并且实现特定的状态反馈机制,以实现音视频的无缝播放。

MediaPlayer和DSP芯片之间的交互机制需要根据具体硬件平台和解码要求进行选择,以实现最佳的音视频播放效果和性能。在实际开发中,我们需要对MediaPlayer API的调用和DSP芯片的使用进行深入了解,同时了解两者之间的交互机制,针对具体需求进行合理选择和配置。

简单手写高清H265码流播放器

要手写一个简单的高清H265码流播放器,需要掌握H265编码解码和播放器开发的基本知识。

下面给出一个简单的示例代码,并进行解析。

解析码流

FileInputStream fis = new FileInputStream("H265_file.h265");

BufferedInputStream bis = new BufferedInputStream(fis);

byte[] buffer = new byte[1024 * 1024];

int len = 0;

while ((len = bis.read(buffer)) != -1) {

// 解析H265码流

}

bis.close();

fis.close();

这段代码通过 FileInputStream 读取 H265 码流,然后通过 BufferedInputStream 进行缓冲读取,提高读取效率。之后通过循环解析码流,对于码流的解析可以采用开源的 H265 解码库,如 x265、FFmpeg 等。

解码视频

// 解码器初始化

avcodec_register_all();

AVCodecContext* codecCtx = avcodec_alloc_context3(codec);

avcodec_parameters_to_context(codecCtx, stream->codecpar);

avcodec_open2(codecCtx, codec, NULL);

// 读取一帧H265数据

AVFrame* frame = av_frame_alloc();

AVPacket* pkt = av_packet_alloc();

while(av_read_frame(fmtCtx, pkt) >= 0) {

if(pkt->stream_index == videoIndex) {

avcodec_send_packet(codecCtx, pkt);

while(avcodec_receive_frame(codecCtx, frame) == 0) {

// 解码H265码流

}

av_packet_unref(pkt);

}

}

这段代码使用 FFmpeg 进行解码操作,通过 avcodec_register_all() 注册解码器,并分配 AVCodecContext 内存,使用 avcodec_parameters_to_context() 将 AVCodecParameters 转换为 AVCodecContext,最后通过 avcodec_open2() 打开编码器。之后循环读取 H265 码流中的每一帧,通过 avcodec_send_packet() 将 H265 数据发送给解码器,然后通过 avcodec_receive_frame() 接收解码后的视频帧,进行播放。

渲染视频

// 初始化视频显示窗口

SDL_Window *window = SDL_CreateWindow("H265 Player", SDL_WINDOWPOS_CENTERED, SDL_WINDOWPOS_CENTERED, codecCtx->width, codecCtx->height, 0);

SDL_Renderer *renderer = SDL_CreateRenderer(window, -1, 0);

SDL_Texture *texture = SDL_CreateTexture(renderer, SDL_PIXELFORMAT_YV12, SDL_TEXTUREACCESS_STREAMING, codecCtx->width, codecCtx->height);

// 渲染视频帧

AVFrame* frameYUV = av_frame_alloc();

uint8_t *outBuffer = (uint8_t*)malloc(sizeof(uint8_t) * av_image_get_buffer_size(AV_PIX_FMT_YUV420P, codecCtx->width, codecCtx->height, 1));

av_image_fill_arrays(frameYUV->data, frameYUV->linesize, outBuffer, AV_PIX_FMT_YUV420P, codecCtx->width, codecCtx->height, 1);

while (av_read_frame(fmtCtx, pkt) >= 0)

{

if (pkt->stream_index == videoIndex)

{

avcodec_send_packet(codecCtx, pkt);

while (avcodec_receive_frame(codecCtx, frame) == 0)

{

// 解码H265码流

sws_scale(sws_ctx, (const uint8_t* const*)frame->data, frame->linesize, 0, codecCtx->height, frameYUV->data, frameYUV->linesize);

SDL_UpdateYUVTexture(texture, NULL, frameYUV->data[0], frameYUV->linesize[0], frameYUV->data[1], frameYUV->linesize[1], frameYUV->data[2], frameYUV->linesize[2]);

SDL_RenderClear(renderer);

SDL_RenderCopy(renderer, texture, NULL, NULL);

SDL_RenderPresent(renderer);

}

av_packet_unref(pkt);

}

}

这段代码使用 SDL 进行视频的显示,首先使用 SDL_CreateWindow() 创建一个窗口,然后使用 SDL_CreateRenderer() 和 SDL_CreateTexture() 创建渲染器和纹理对象,根据视频的宽高设置纹理的宽高。之后在循环中获取 H265 码流中的每一帧,将解码后的视频帧转换为 YUV 格式,并通过 SDL_UpdateYUVTexture() 更新视频帧的纹理数据,然后通过 SDL_RenderCopy() 将纹理数据渲染到窗口上,最后使用 SDL_RenderPresent() 显示窗口。

至此,一个简单的 H265 码流播放器就完成了。有关音视频的学习还需要很多技术组合,因此学习好音视频还需要非常广阔的知识。音视频核心技术知识点参考《音视频基础到进阶手册》点击查看里面详细类目。

注意事项

手写一个高清播放器需要掌握以下的注意事项:

- 解码器选择:选择适当的解码器非常重要,在开发高清播放器时,需要选择能够支持高清视频解码的解码器。常用的解码器包括FFmpeg、VLC、GStreamer等,选择合适的解码器能够提高播放器的解码性能和稳定性。

- 码流解析:高清码流相对于普通码流来说更加复杂和庞大,因此码流解析对于播放器的性能影响非常大。在处理高清码流时,需要专门针对高清码流进行优化和加速,例如使用硬件解码器、优化解码算法等。

- 渲染窗口:高清视频需要在更大的屏幕上播放,因此需要提供高分辨率的渲染窗口和支持高分辨率的渲染器。同时,还需要考虑视频的宽高比,保证播放过程中视频的宽高比不失真。

- 音频处理:在播放高清视频的同时,播放器还需要对音频进行处理。同样需要选择适当的解码器进行音频解码,同时需要确保视频和音频的同步性,避免播放过程中出现音视频不同步的问题。

- 功能要求:高清播放器通常需要提供一些额外的功能和设置,例如全屏播放、倍速播放、字幕支持、视频截图等。因此在设计高清播放器时,需要考虑这些额外的功能,提高播放器的使用体验。