文章目录

- S5CL: Unifying Fully-Supervised,Self-supervised, and Semi-supervised Learning Through Hierarchical Contrastive Learning

- 摘要

- 本文方法

- 损失函数

- 实验结果

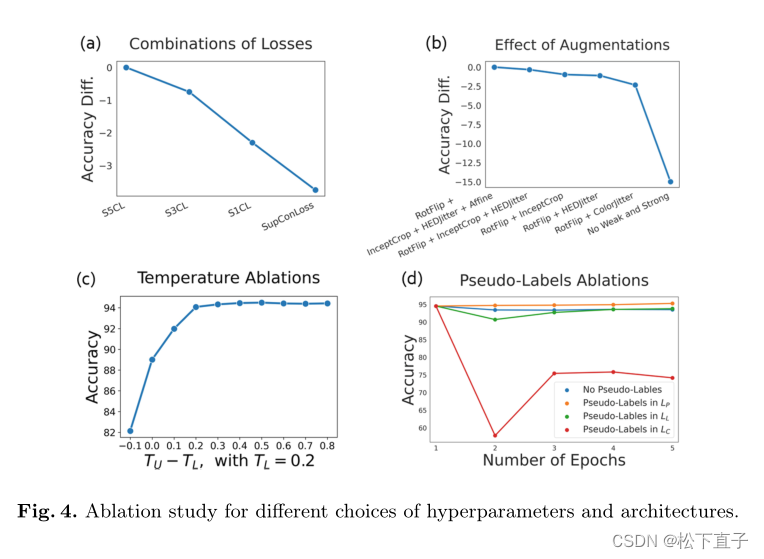

- 消融实验

S5CL: Unifying Fully-Supervised,Self-supervised, and Semi-supervised Learning Through Hierarchical Contrastive Learning

摘要

- 通过引入S5CL将这两个阶段的训练压缩为一个阶段,S5CL是一个用于全监督、自监督和半监督学习的统一框架

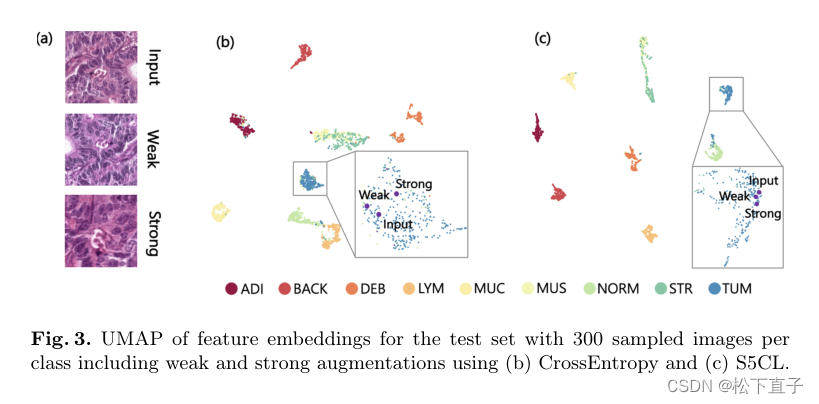

- 为标记图像、未标记图像和伪标记图像定义了三个对比损失的情况下,S5CL可以学习反映距离关系层次的特征表示:相似的图像和增强嵌入得最近,其次是同一类的不同外观的图像,而来自不同类的图像具有最大的距离

- S5CL允许灵活地组合这些损失,以适应不同的场景

代码地址

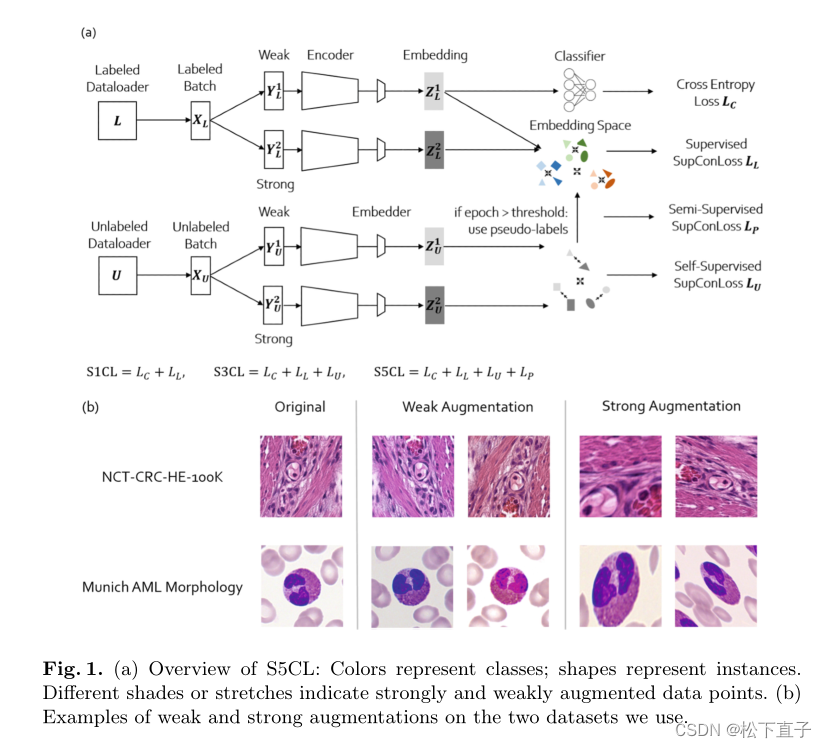

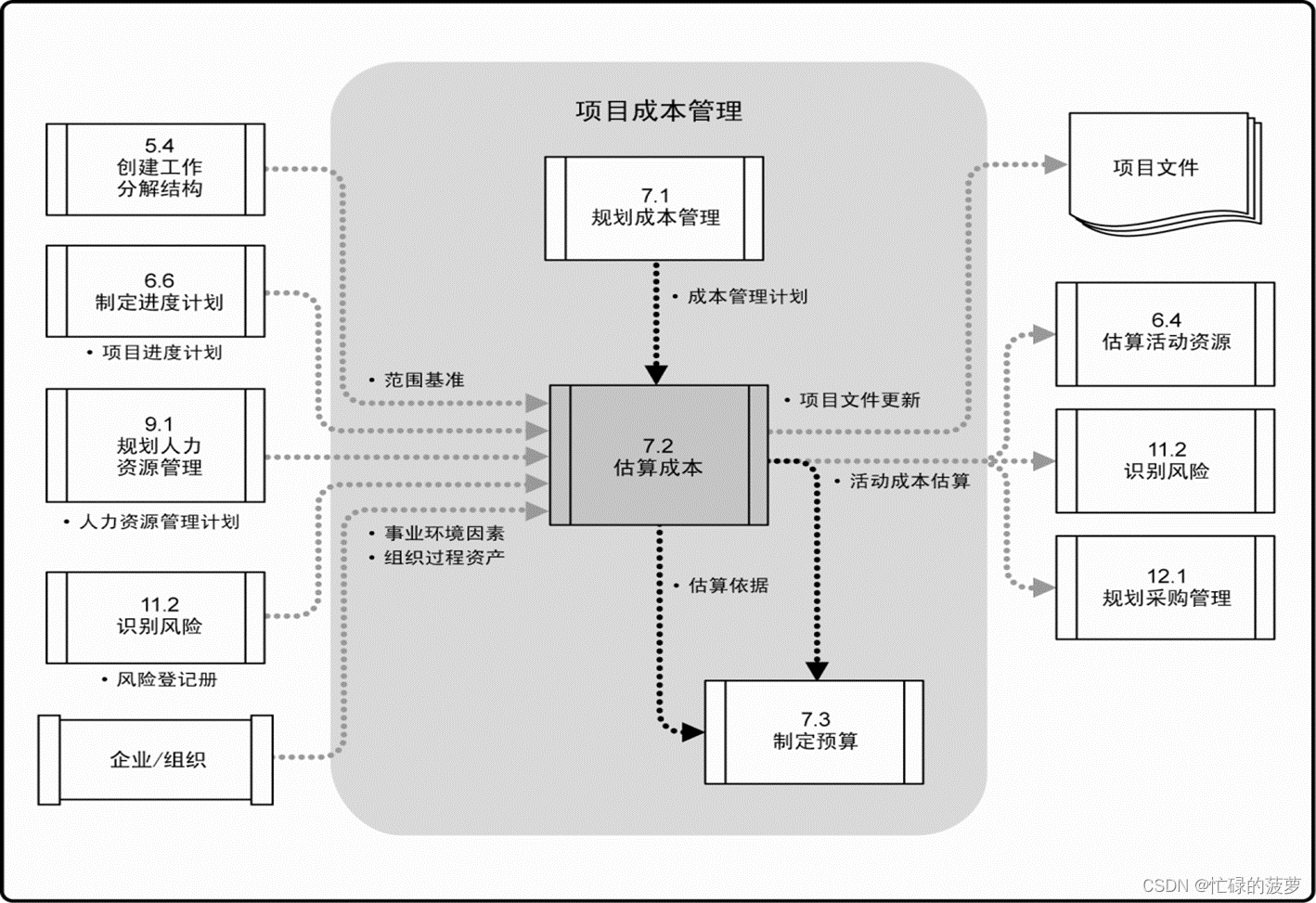

本文方法

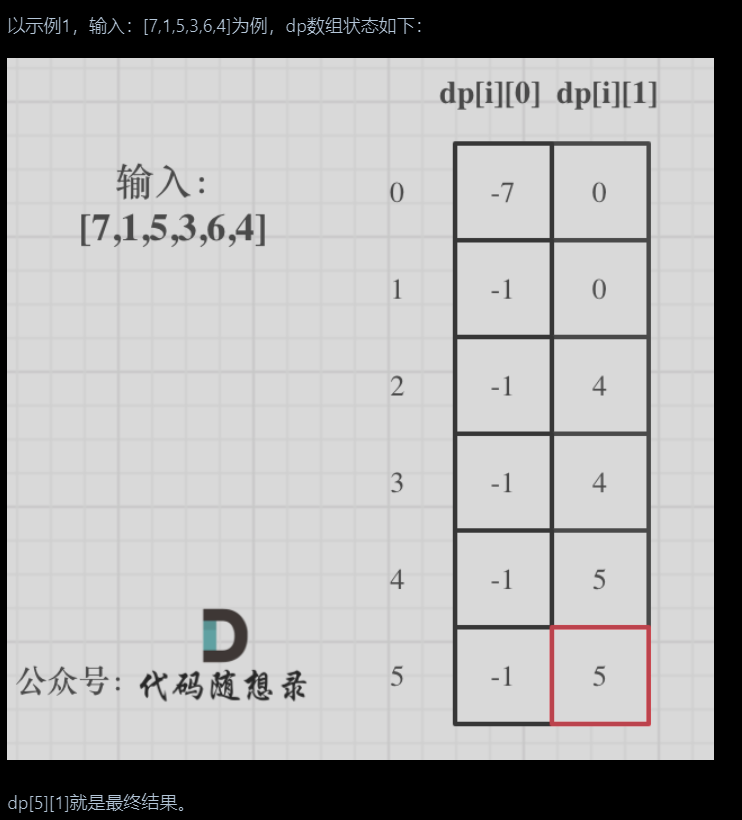

损失函数

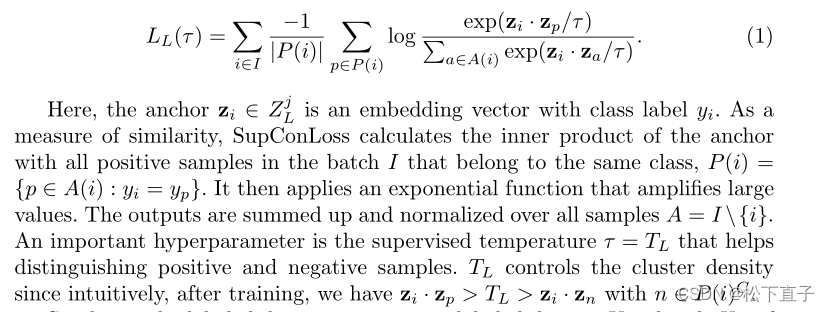

有监督对比损失SupconLoss:

zi为带标签的向量

zp为batch中的正例

zn为负例

za文中未找到,猜是增强的数据

Tl用于区别正例和负例

自监督对比损失类似

但是为了使相同类不同样本靠近

增加了Tu约束

区分阳性样本zi~是同一图像的不同增强版本,而负样本是不同的图像

半监督对比损失

差不多是自监督和自监督的结合,但是需要自监督迭代一段时间后

总损失

Lp是半监督损失,Lu是自监督损失,Lc是交叉熵损失,Ll是标签损失

结合结构图看

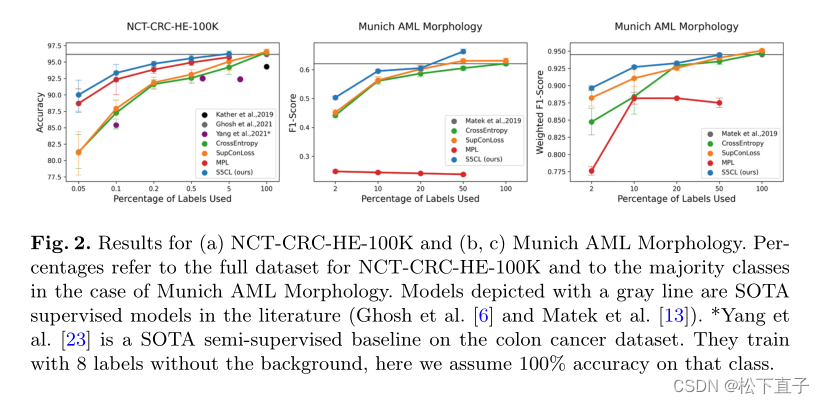

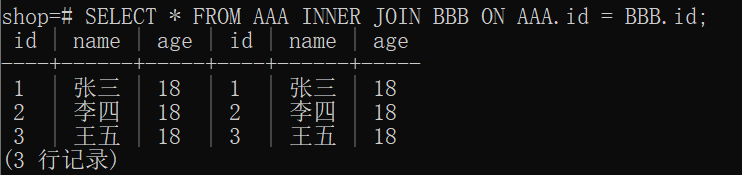

实验结果

消融实验

![P3029 [USACO11NOV]Cow Lineup S 双指针 单调队列](https://img-blog.csdnimg.cn/6af1894944f542299edaa735404b58a3.png)