【深度学习】RNN、LSTM、GRU

- RNN

- LSTM

- GRU

- 结语

RNN

和普通神经网络一样,RNN有输入层、输出层和隐含层,不一样的是RNN在不同的时间

t

t

t会有不同的状态,其中

t

−

1

t-1

t−1时刻隐含层的输出会作用到

t

t

t时刻的隐含层。

RNN因为加入了时间序列,因此训练过程也是和之前的网络不一样,RNN的训练使用的是BPTT(Back Propagation Through Time)。在训练

t

t

t时刻的时候,出现了

t

−

1

t-1

t−1的参数,因此对单个的求导就变成了对整个之前状态的求导之和。也正是因为存在长依赖关系,BPTT无法解决长时依赖问题(即当前的输出与前面很长的一段序列有关,一般超过十步就无能为力了),因为BPTT会带来所谓的梯度消失或梯度爆炸问题。主要问题就是因为在BPTT算法中,以weight为例,其求导过程的链太长,而太长的求导链在以

t

a

n

h

tanh

tanh为激活函数(其求导值在

0

0

0到

1

1

1之间)的BPTT中,连乘就会使得最终的求导为

0

0

0。

LSTM

标准LSTM模型是一种特殊的RNN类型,在每一个重复的模块中有四个特殊的结构,以一种特殊的方式进行交互。在图中,粉色的圈代表一种pointwise操作(将定义域上的每一点的函数值分别进行运算,比如向量的和),而黄色的矩形就是可学习的神经网络层,每一个黄色的矩形为两个线性层(处理input tensor的是从input size到hidden size的线性层,处理t

−

1

-1

−1的hidden tensor的是从hidden size到hidden size的线性层)+一个gate函数(

s

i

g

m

o

i

d

sigmoid

sigmoid)或激活函数(

t

a

n

h

tanh

tanh)。

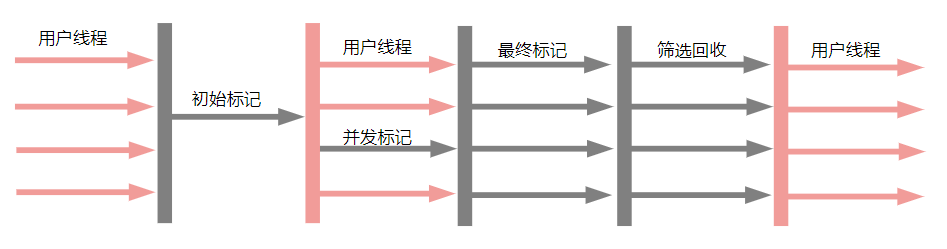

LSTM模型的核心思想是“细胞状态”。“细胞状态”类似于传送带,直接在整个链上运行,只有一些少量的线性交互。信息在上面流传保持不变会很容易。

LSTM 有通过精心设计的称作为“门”的结构来去除或者增加信息到细胞状态的能力。门是一种让信息选择式通过的方法。他们包含一个sigmoid神经网络层和一个pointwise乘法操作。Sigmoid层输出0到1之间的数值,描述每个部分有多少量可以通过。0代表“不许任何量通过”,1就指“允许任意量通过”。LSTM拥有三个门,来保护和控制细胞状态。

在LSTM模型中,第一步是决定我们从“细胞”中丢弃什么信息,这个操作由一个忘记门层来完成。该层读取当前输入

x

t

x_t

xt和前神经元信息

h

t

−

1

h_{t-1}

ht−1,由

f

t

f_t

ft来决定丢弃的信息。输出结果1表示“完全保留”,0 表示“完全舍弃”。

第二步是确定细胞状态所存放的新信息,这一步由两层组成。

s

i

g

m

o

i

d

sigmoid

sigmoid层作为输入门层,决定我们将要更新的值

i

t

i_t

it、

t

a

n

h

tanh

tanh层来创建一个新的候选值向量

C

t

~

\widetilde{C_t}

Ct

加入到状态中。

第三步就是更新旧细胞的状态,将

C

t

−

1

C_{t-1}

Ct−1更新为

C

t

C_t

Ct。我们把旧状态与

f

t

f_t

ft相乘,丢弃掉我们确定需要丢弃的信息。接着加上

i

t

∗

C

t

~

i_t * \widetilde{C_t}

it∗Ct

。这就是新的候选值,根据我们决定更新每个状态的程度进行变化。

最后一步就是确定输出了,这个输出将会基于我们的细胞状态,但是也是一个过滤后的版本。首先,我们运行一个

s

i

g

m

o

i

d

sigmoid

sigmoid层来确定细胞状态的哪个部分将输出出去。接着,我们把细胞状态通过

t

a

n

h

tanh

tanh进行处理(得到一个在-1到1之间的值)并将它和

s

i

g

m

o

i

d

sigmoid

sigmoid门的输出相乘,最终我们仅仅会输出我们确定输出的那部分。

# 默认输入维度为(seq len, batch size, input dims)

torch.nn.LSTM(input_size, hidden_size, num_layers=1, bias=True, batch_first=False, droput=0, bidirectional=False)

# 如果batch_first设置为True, 输入维度为(batch size, seq len, input_dims)

rnn = nn.LSTM(10, 20, 2)

# input: (seq len, batch size, input dims)

input = torch.randn(5, 3, 10)

# h0: (layer nums, batch size, hidden dims)

h0 = torch.randn(2, 3, 20)

# c0: (layer nums, batch size, hidden dims)

c0 = torch.randn(2, 3, 20)

# output: (seq len, batch size, hidden dims)

# hn: (layer nums, batch size, hidden dims)

# cn: (layer nums, batch size, hidden dims)

output, (hn, cn) = rnn(input, (h0, c0))

GRU

LSTM有很多变体,其中较大改动的是Gated Recurrent Unit (GRU)。它将忘记门和输入门合成了一个单一的更新门。同样还混合了细胞状态和隐藏状态,和其他一些改动。最终的模型比标准的 LSTM模型要简单。效果和LSTM差不多,但是参数少了

1

/

3

1/3

1/3,不容易过拟合。

# 默认输入维度为(seq len, batch size, input dims)

torch.nn.GRU(input_size, hidden_size, num_layers=1, bias=True, batch_first=False, droput=0, bidirectional=False)

# 如果batch_first设置为True, 输入维度为(batch size, seq len, input_dims)

rnn = nn.GRU(10, 20, 2)

# input: (seq len, batch size, input dims)

input = torch.randn(5, 3, 10)

# h0: (layer nums, batch size, hidden dims)

h0 = torch.randn(2, 3, 20)

# output: (seq len, batch size, hidden dims)

# hn: (layer nums, batch size, hidden dims)

output, hn = rnn(input, h0)

结语

如果您有修改意见或问题,欢迎留言或者通过邮箱和我联系。

如果我的文章对您有帮助,转载请注明出处。