Subjects: cs.CV

1.Multi-Source Soft Pseudo-Label Learning with Domain Similarity-based Weighting for Semantic Segmentation

标题:用于语义分割的基于域相似性加权的多源软伪标签学习

作者:Shigemichi Matsuzaki, Hiroaki Masuzawa, Jun Miura

文章链接:https://arxiv.org/abs/2303.00979v1

项目代码:https://github.com/shigemichimatsuzaki/ms2pl

摘要:

本文描述了一种使用与目标数据集不一定相关的多个源数据集进行语义分割的域自适应训练方法。我们通过整合来自多个源模型的预测对象概率,提出了一种软伪标签生成方法。每个源模型的预测基于源数据集和目标数据集之间的估计域相似性进行加权,以强调在与目标更相似的源上训练的模型的贡献,并生成合理的伪标签。我们还提出了一种使用软伪标签的训练方法,考虑到它们的熵,以充分利用来自源数据集的信息,同时抑制可能被错误分类的像素的影响。实验表明,与我们之前的工作和另一种现有的多源域自适应方法相比,具有相当或更好的性能,并且适用于各种目标环境。

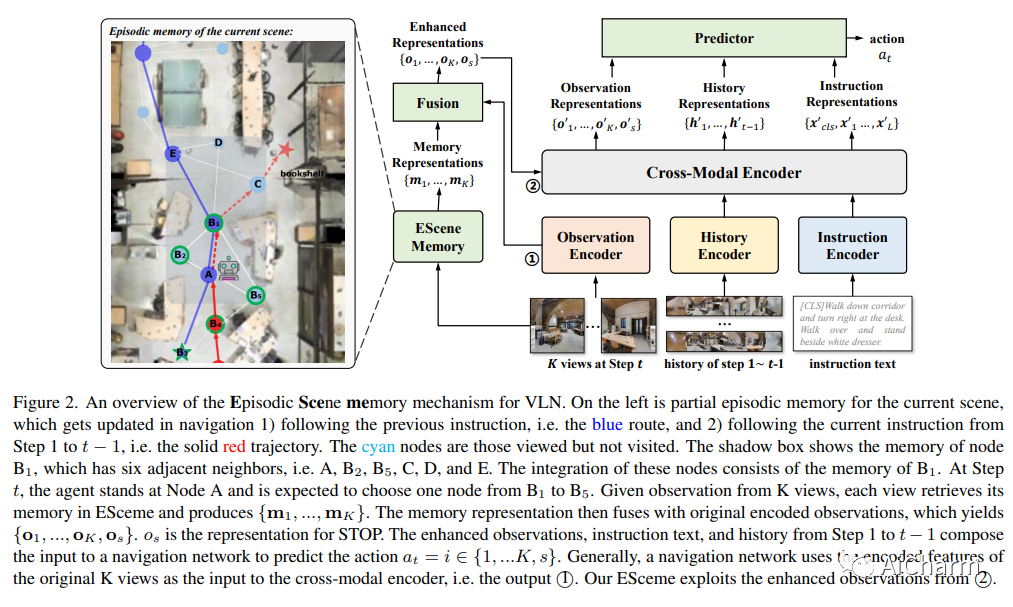

2.ESceme: Vision-and-Language Navigation with Episodic Scene Memory

标题:ESceme:具有情景场景记忆的视觉和语言导航

作者:Qi Zheng, Daqing Liu, Chaoyue Wang, Jing Zhang, Dadong Wang, DaCheng Tao

文章链接:https://arxiv.org/abs/2303.01032v1

项目代码:https://github.com/qizhust/esceme

摘要:

视觉和语言导航 (VLN) 模拟在真实场景中遵循自然语言导航指令的视觉代理。现有方法在新环境中的导航方面取得了巨大进步,例如波束搜索、预探索以及动态或分层历史编码。为了平衡泛化和效率,我们在导航时求助于记住除了正在进行的路线之外的访问场景。在这项工作中,我们为 VLN 引入了情景场景记忆 (ESceme) 机制,该机制可以在代理进入当前场景时唤醒其对过去访问的记忆。情景场景记忆允许代理设想下一个预测的更大画面。通过这种方式,智能体学会充分利用当前可用的信息,而不是仅仅适应所见的环境。我们通过在训练期间增强候选节点的观察特征来提供简单而有效的实现。我们验证了 ESceme 在三个 VLN 任务上的优势,包括短视距导航(R2R)、长视距导航(R4R)和视觉对话导航(CVDN),并实现了新的最先进的技术水平.

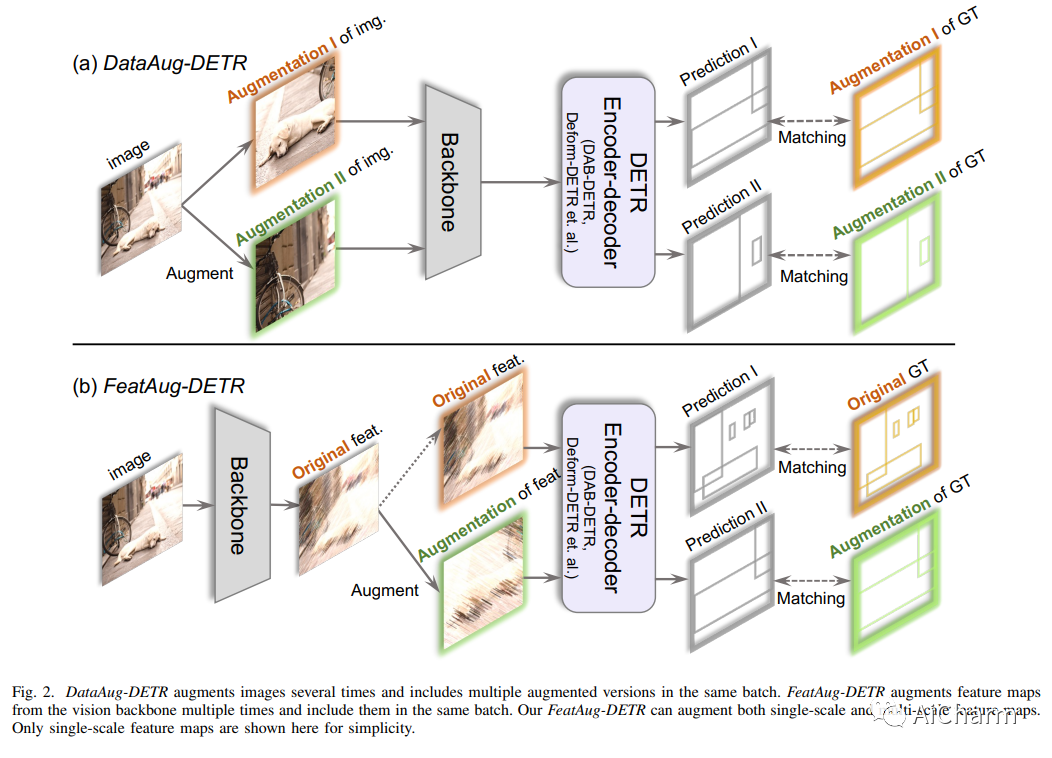

3.FeatAug-DETR: Enriching One-to-Many Matching for DETRs with Feature Augmentation

标题:FeatAug-DETR:通过特征增强来丰富 DETR 的一对多匹配

作者:Rongyao Fang, Peng Gao, Aojun Zhou, Yingjie Cai, Si Liu, Jifeng Dai, Hongsheng Li ·

文章链接:https://arxiv.org/abs/2303.00477v1

项目代码:https://github.com/rongyaofang/feataug-detr

摘要:

一对一匹配是类 DETR 对象检测框架中的关键设计。它使 DETR 能够执行端到端检测。但是,它也面临着缺乏正样本监督和收敛速度慢的挑战。最近的几项工作提出了一对多匹配机制来加速训练和提高检测性能。我们重新审视这些方法,并以增强对象查询的统一格式对它们进行建模。在本文中,我们提出了两种方法,从增强图像或图像特征的不同角度实现一对多匹配。第一种方法是通过数据增强进行一对多匹配(表示为 DataAug-DETR)。它对图像进行空间变换,并在同一训练批次中包含每个图像的多个增强版本。这种简单的增强策略已经实现了一对多匹配,并且令人惊讶地提高了 DETR 的性能。第二种方法是通过特征增强进行一对多匹配(表示为 FeatAug-DETR)。与DataAug-DETR不同的是,它增强了图像特征而不是原始图像,并且在同一批次中包含多个增强特征以实现一对多匹配。 FeatAug-DETR 显着加速 DETR 训练并提升检测性能,同时保持推理速度不变。我们进行了广泛的实验来评估所提出的方法对 DETR 变体的有效性,包括 DAB-DETR、Deformable-DETR 和 H-Deformable-DETR。在没有额外训练数据的情况下,FeatAug-DETR 将 Deformable-DETR 的训练收敛周期缩短至 24 个 epoch,并在以 Swin-L 为骨干的 COCO val2017 集上实现了 58.3 AP。