HIve介绍

Hive是建立在Hadoop上的数据仓库基础构架。它提供了一系列的工具,可以用来进行数据提取转化加载,可以简称为ETL。

Hive 定义了简单的类SQL查询语言,称为HQL,它允许熟悉SQL的用户直接查询Hadoop中的数据,同时,这个语言也允许熟悉MapReduce的开发者开发自定义的mapreduce任务来处理内建的SQL函数无法完成的复杂的分析任务。

Hive中包含的有SQL解析引擎,它会将SQL语句转译成M/R Job,然后在Hadoop中执行。Hive可以通过sql查询Hadoop中的数据,并且sql底层也会转化成mapreduce任务,所以hive是基于hadoop的。

Hive的数据存储

Hive的数据存储基于Hadoop的 HDFS

Hive没有专门的数据存储格式

Hive默认可以直接加载文本文件(TextFile),还支持SequenceFile、RCFile等文件格式

针对普通文本数据,我们在创建表时,只需要指定数据的列分隔符与行分隔符,Hive即可解析里面的数据。

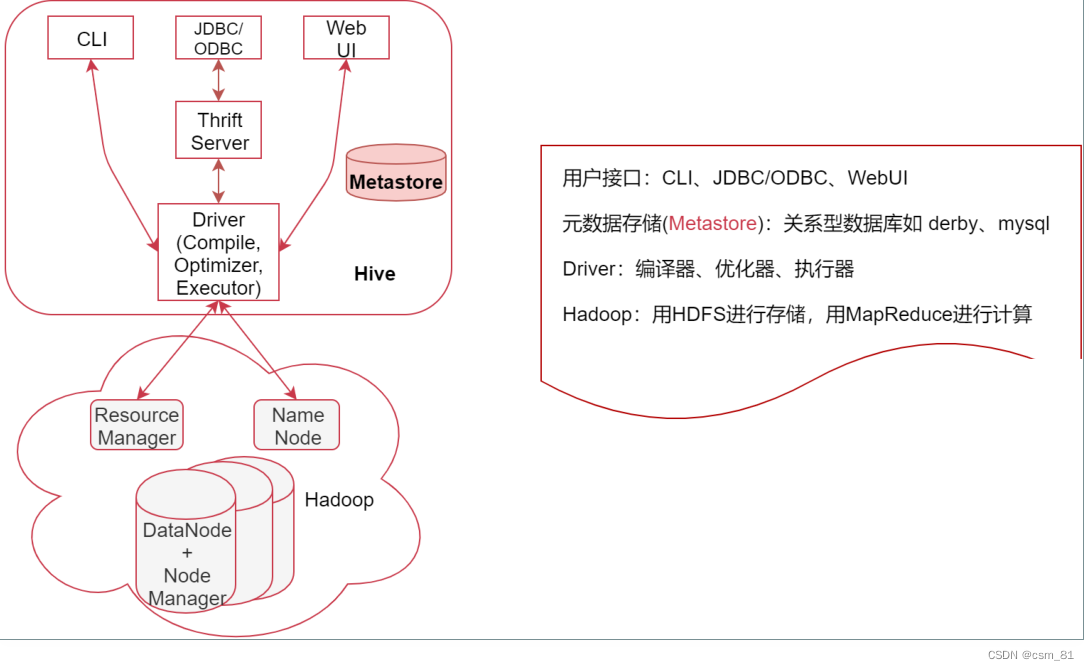

Hive的系统架构

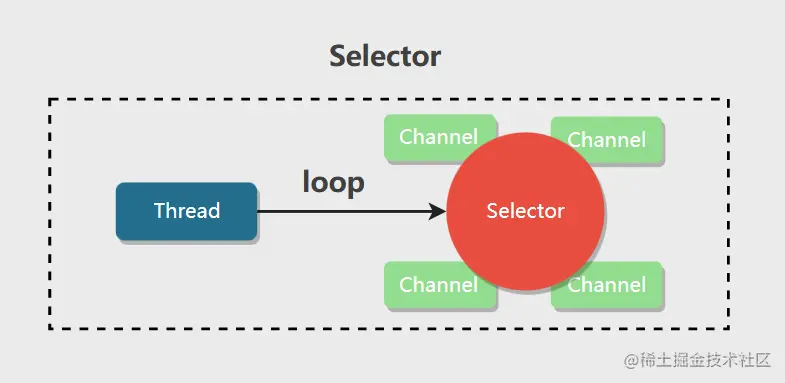

1)用户接口,包括 CLI、JDBC/ODBC、WebGUI CLI,即Shell命令行,表示我们可以通过shell命令行操作Hive JDBC/ODBC 是 Hive 的Java操作方式,与使用传统数据库JDBC的方式类似

2)元数据存储(Metastore),注意:这里的存储是名词,Metastore表示是一个存储系统

Hive中的元数据包括表的相关信息,Hive会将这些元数据存储在Metastore中,目前Metastore只支

持 mysql、derby。

3)Driver:包含:编译器、优化器、执行器

编译器、优化器、执行器可以完成 Hive的 查询语句从词法分析、语法分析、编译、优化以及查询计划的生成。生成的查询计划最终存储在 HDFS 中,并在随后由 MapReduce 调用执行

4)Hadoop:Hive会使用 HDFS 进行存储,利用 MapReduce 进行计算

Hive 的数据存储在 HDFS 中,大部分的查询由 MapReduce 完成(特例 select * from table 不会生

成 MapRedcue 任务,如果在SQL语句后面再增加where过滤条件就会生成MapReduce任务了。

注意:Hive2开始,其实官方就不建议默认使用MapReduce引擎了,而是建议

使用Tez引擎或者是Spark引擎,不过目前一直到最新的3.x版本中mapreduce还是默认的执行引擎

Metastore元数据存储

Metastore是Hive元数据的集中存放地。

Hive 中的元数据包括表的名字,表的列和分区及其属性,表的属性(是否为外部表等),表的数据所在的hdfs目录等

Metastore默认使用内嵌的derby数据库

Derby数据库的缺点:在同一个目录下一次只能打开一个会话

使用derby存储方式时,Hive会在当前目录生成一个derby.log文件和一个metastore_db目录,

metastore_db里面会存储具体的元数据信息

![[计算机网络(第八版)]第三章 数据链路层(学习笔记)](https://img-blog.csdnimg.cn/ba6f0d60ebe74661b339308d5b442428.png)