高斯牛顿法 LM法 DogLeg方法

编辑切换为居中

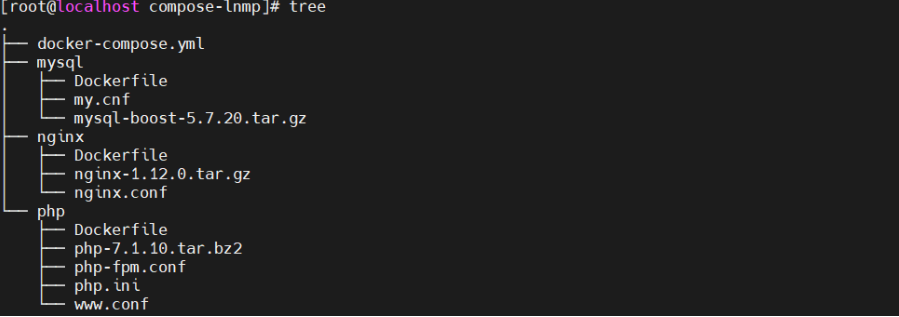

添加图片注释,不超过 140 字(可选)

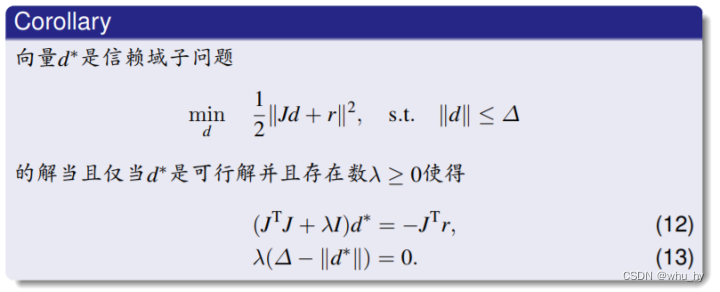

知识点:高斯牛顿是线搜索方法 LM方法是信赖域方法。

编辑切换为居中

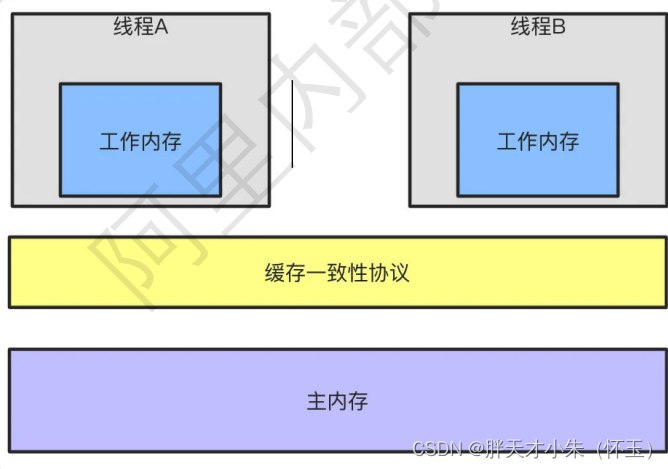

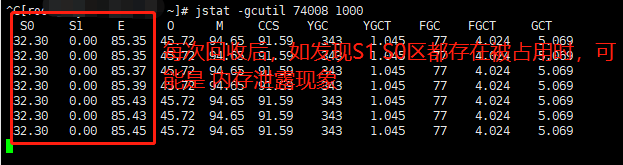

添加图片注释,不超过 140 字(可选)

这个就是JTJ是Hessian矩阵的近似即可,知道这个就完事。这个的话也是推导出来两个公式,然后比较形式得出来的这个结论。

编辑切换为居中

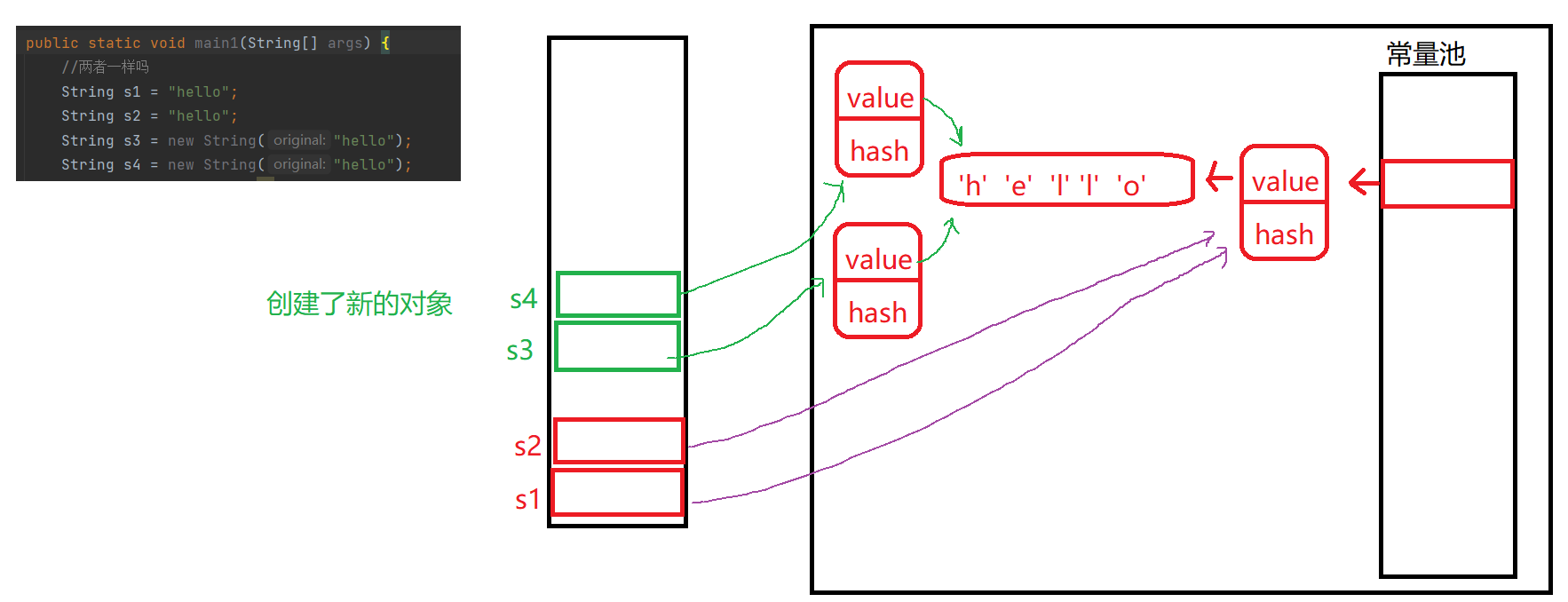

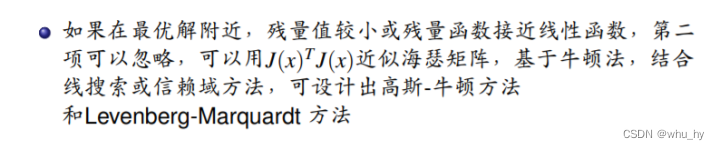

添加图片注释,不超过 140 字(可选)

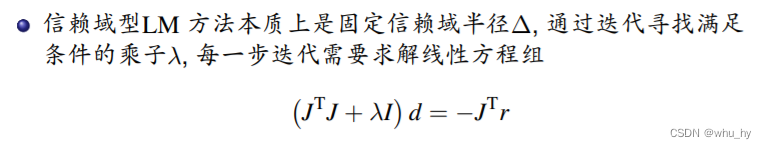

LM方法是信赖域的方法,主要是为了解决JTJ的问题,就是说可能JTJ不可逆,那么加上一个莱姆大*单位阵以后 相当于前面介绍的岭回归,那么这就保证了求逆运算。

编辑切换为居中

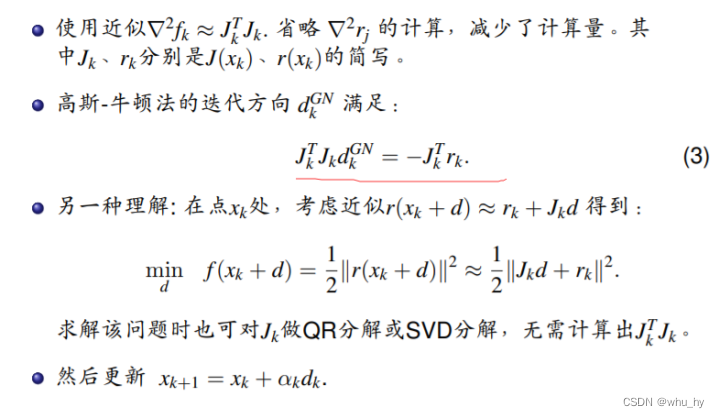

添加图片注释,不超过 140 字(可选)

这里的话就是上面这个公式,和高斯牛顿的区别就是多了一个莱姆达*单位阵。

编辑切换为居中

添加图片注释,不超过 140 字(可选)

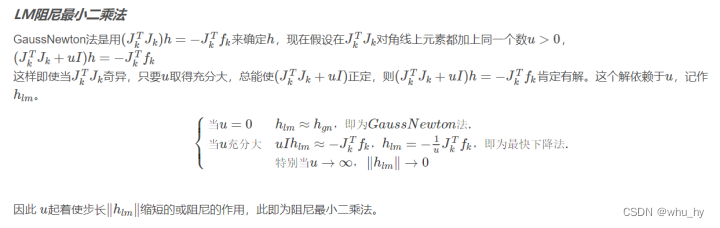

这里的u起着阻尼的作用,就是说步长大了的话就放小点,步长小的话就放大点。

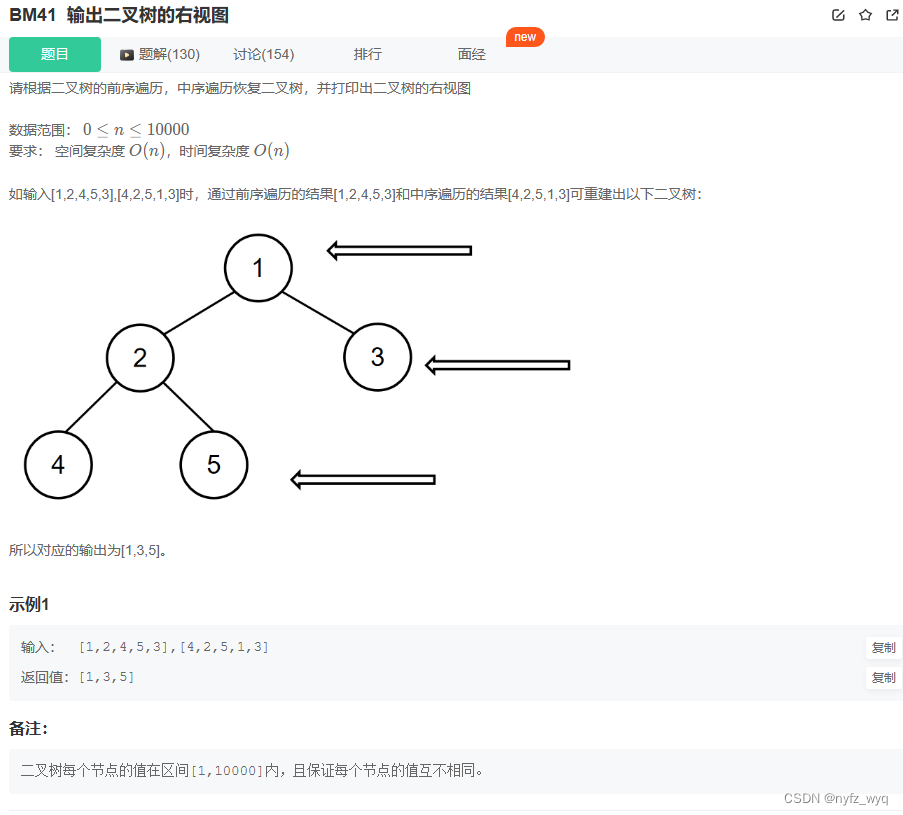

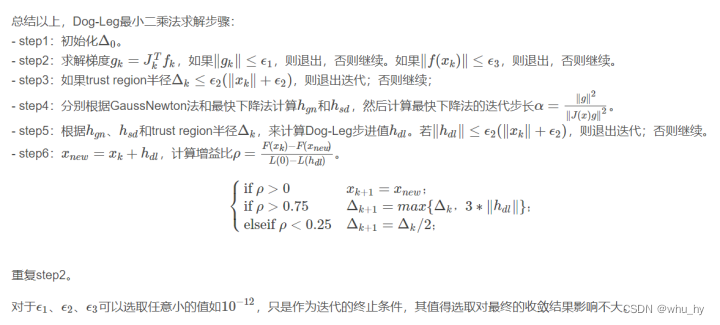

Dogleg方法

编辑切换为居中

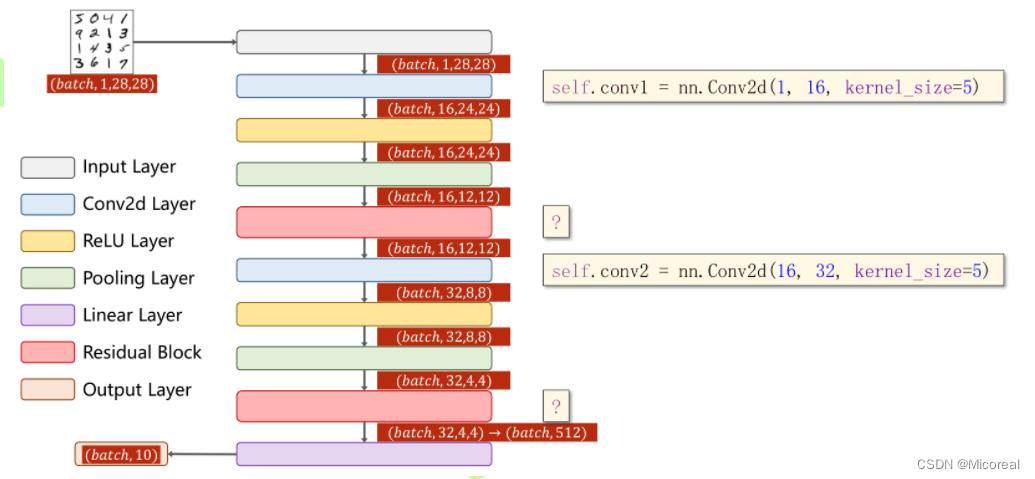

添加图片注释,不超过 140 字(可选)

比较信赖域 高斯牛顿和最速下降之间的关系,然后来确定步长方向,最终找到最优解。

编辑切换为居中

添加图片注释,不超过 140 字(可选)

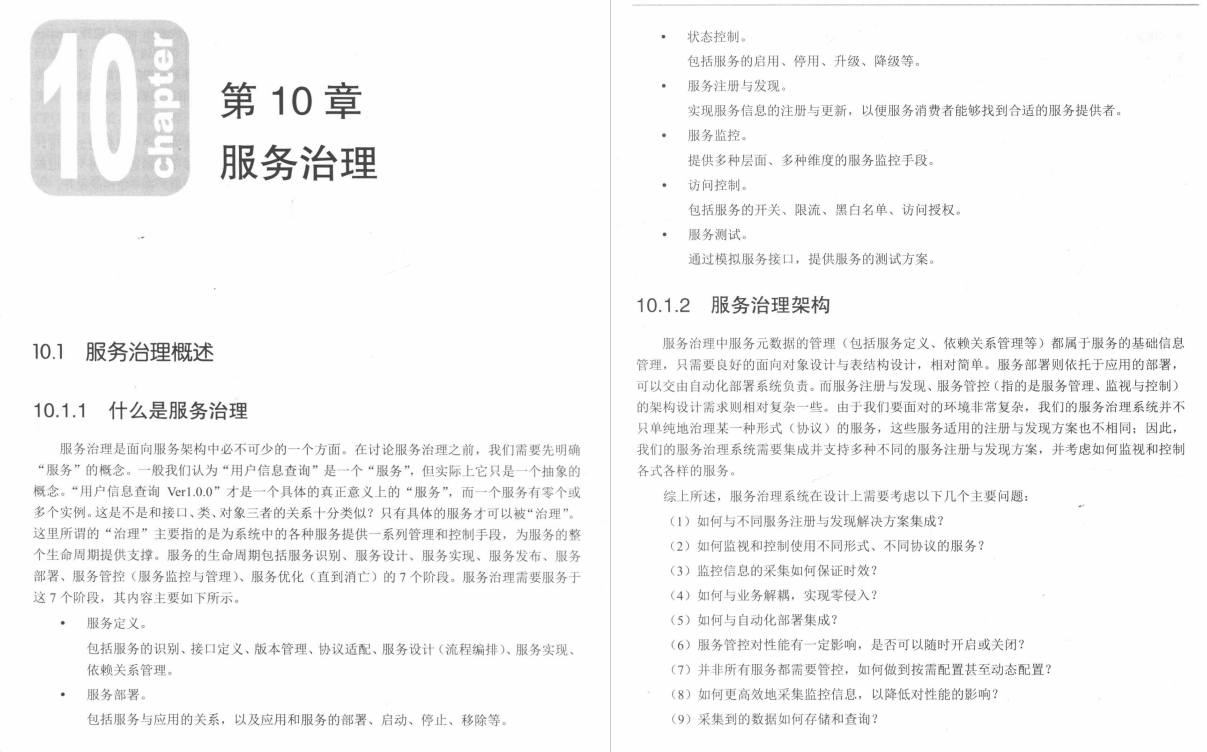

以上三个算法的总结,DogLeg方法是首选的比较好用的方法,然后LM和Dog-Leg方法都比高斯牛顿法要好。说明信赖域方法要好于线搜索的方法。这里有一个小的知识点回顾,就是线性化的话在slam中表达的意义是求雅可比,出自vins的辅导课程中。