诸神缄默不语-个人CSDN博文目录

开宗明义:attention就是一个加权机制,但是权重需要经过训练得到。

本文介绍一些我自己整理的常见attention类型。

本文不关注别的博文里已经写烂了的attention机制的重要性和直觉解释(又不是写论文还要写introduction)。

最近更新时间:2022.11.23

最早更新时间:2022.11.23

文章目录

- 1. attention基础概念讲解

- 2. attention结果计算方法

- 2.1 加权求和式

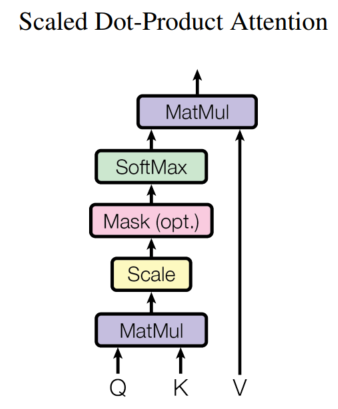

- 2.1.1 Scaled Dot-Product Attention

- 2. KQV计算方式

- 2.1 self-attention

- 3. 其他本文撰写过程中使用到的参考资料

1. attention基础概念讲解

2. attention结果计算方法

2.1 加权求和式

2.1.1 Scaled Dot-Product Attention

经典用例:Transformer1

2. KQV计算方式

2.1 self-attention

KQV都由输入通过线性转换运算得到。

经典用例:Transformer1

3. 其他本文撰写过程中使用到的参考资料

- Transformer 模型详解

Attention Is All You Need ↩︎ ↩︎