- ICLR 2021

- Dongkwan Kim & Alice Oh

- 论文地址

本文介绍的论文是《HOW TO FIND YOUR FRIENDLY NEIGHBORHOOD:

GRAPH ATTENTION DESIGN WITH SELF-SUPERVISION》。

该篇论文提出了一个新的网络模型SuperGAT,目的是解决当图中存在噪声能够学习到更多的表达注意力,并且在17个真实数据集中进行实验,显示出该模型更好的性能。

| 🍁 一、背景 🍁 |

目前图神经网络已广泛应用于各个领域,例如推荐系统、蛋白质分子、智慧交通等领域,近几年GAT网络架构逐渐脱颖而出,它可以采用自我注意力方式来缓解不相关节点之间连接的噪声问题。

换句话说,图注意力网络能够捕捉图关系的重要性,能够学习每个邻居节点对于中心节点的重要程度,GAT在节点分类等方面表现出了很大的性能改进,但是它在数据集之间的改进程度不一致,而且对图注意力实际学习内容较少。

因此作者提出了一个新的模型SuperGAT,是GAT的一种变体,它是基于GO和点积方式的,即自监督图注意力网络。

| 🍁 二、模型方法 🍁 |

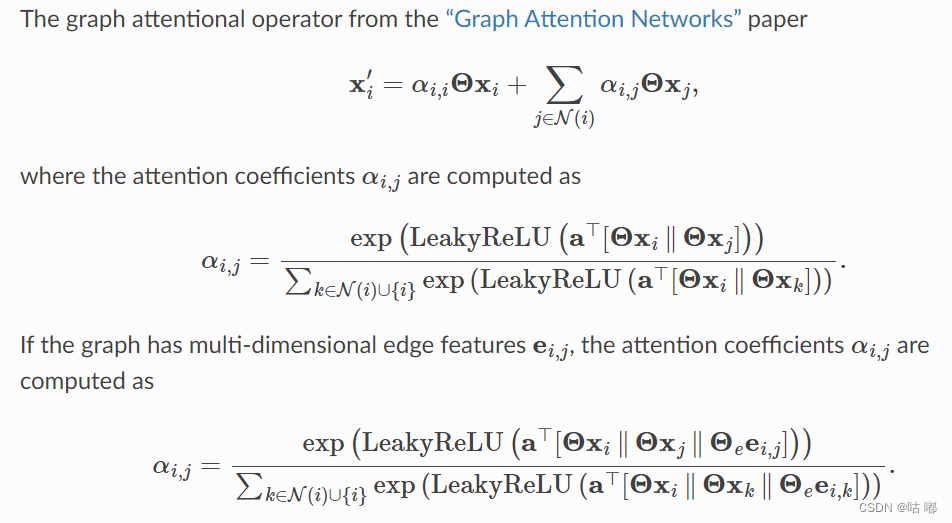

传统的注意力计算方式如下:

简化计算注意力公式为:

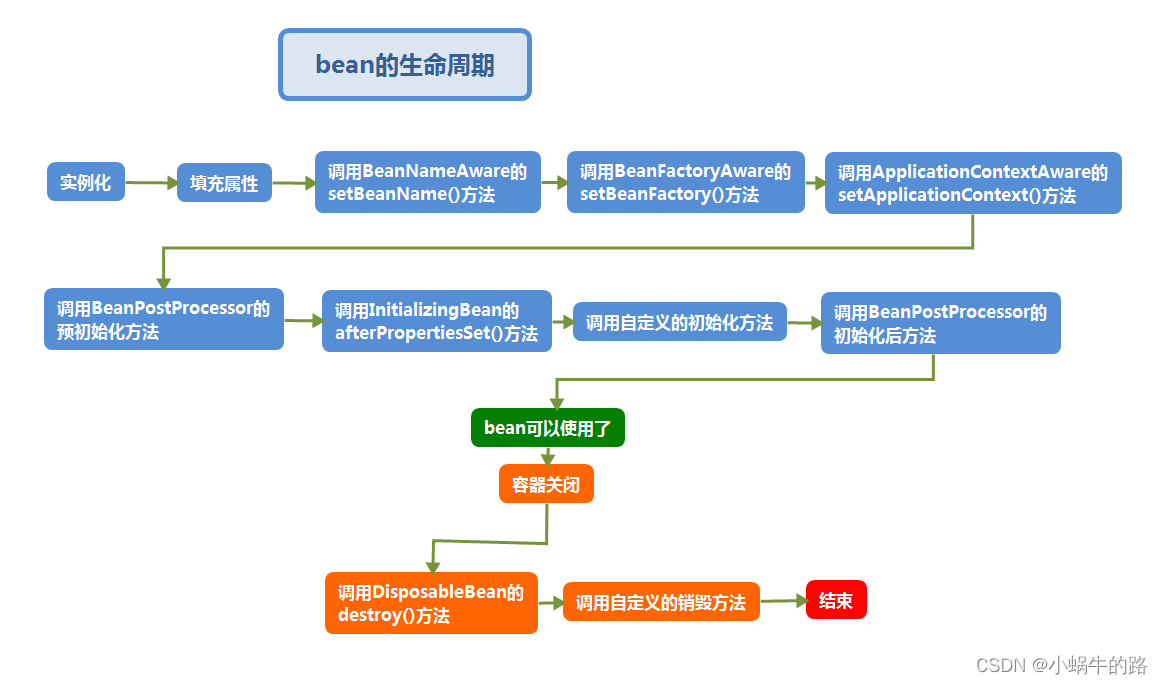

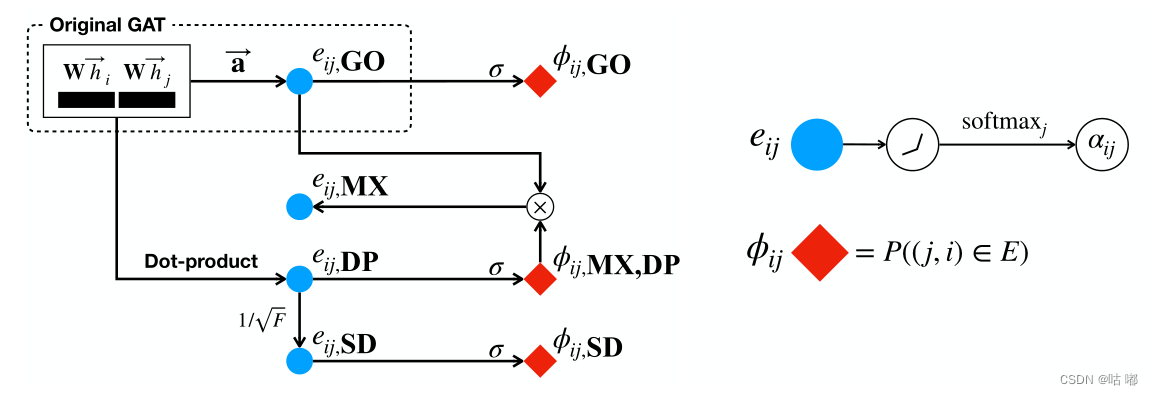

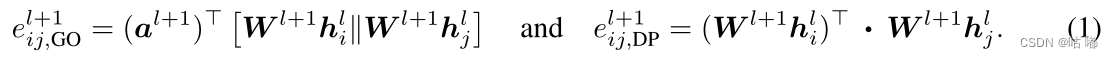

传统的方式GO就是上面公式的第一个,首先通过一个可学习矩阵W分别对中心节点和邻居节点特征进行映射,然后将映射后的特征进行拼接,然后使用另外一个列向量进行点积操作计算得分。

后面的DP方式就是另外一种变体,没有采用 α \alpha α 这个向量来计算分数,而是将两个映射后的向量进行点积操作计算得分。

作者提出的SuperGAT:

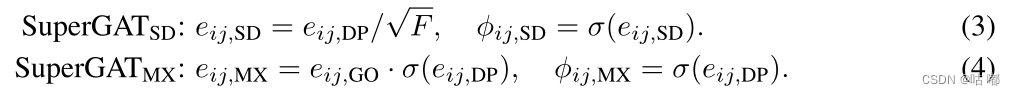

作者提出了SuperGAT的两种方式,第一种就是通过缩放点积方式(SD),就是将DP注意力得分除以特征维度,进行数值缩放,防止一些较大的值在softmax之后占据整个注意力。

第二种是MX混合,它将GO得分与激活后的DP得分进行点积操作计算注意力分数,该种形式的动机来自门控复发单元的门控机制,这可以很柔和地丢弃不太可能链接的邻居,同时隐式地将重要性分配给剩余节点。

| 🍁 三、实验结果 🍁 |

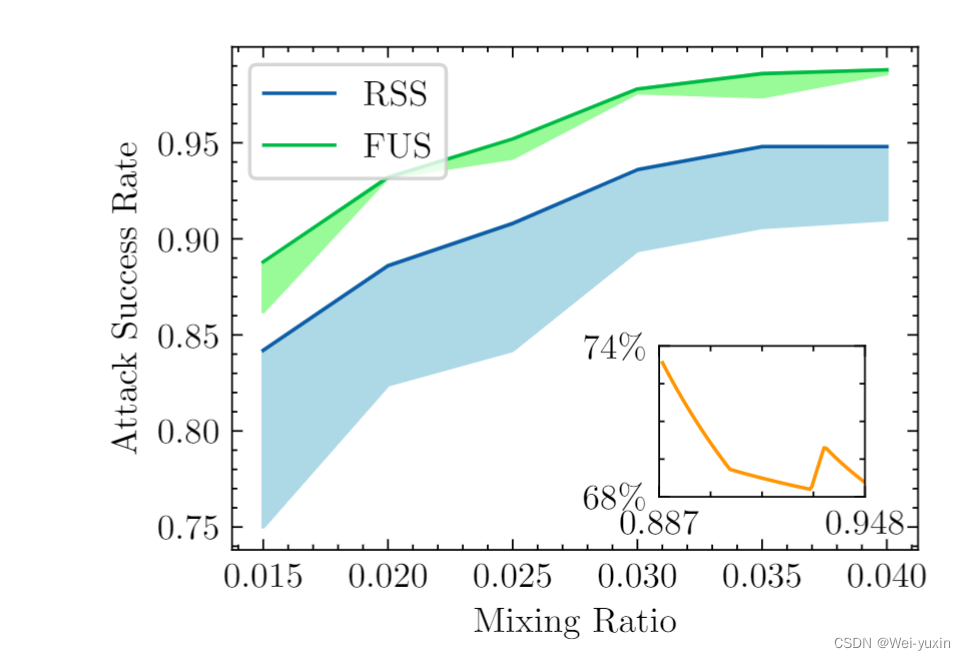

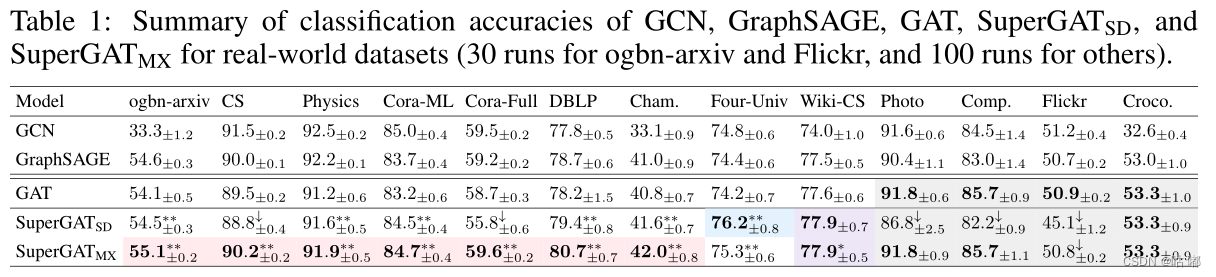

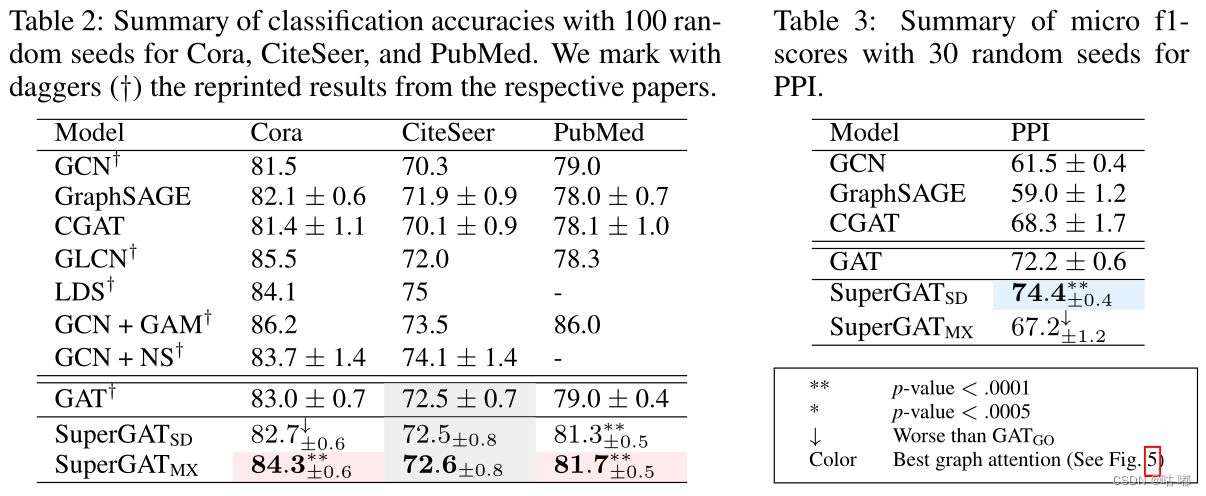

包括GCN在内的所有模型之间没有差异。如果有超过一定数量的正确边缘,我们可以在没有自我监督的情况下学习精细表示。最重要的是,如果平均程度不太低或太高,且亲同性高于0.2,则SuperGA TMX的表现优于或类似于SuperGA TSD。这意味着我们可以通过混合GO和DP来利用GO注意力来学习标签一致性和DP注意力来学习边缘存在。请注意,许多真实世界的图都属于这一范围的图特征。

合成图上的结果表明,在设计图注意力之前,应该先理解图域。也就是说,通过知道图的平均度和同向性,我们可以在设计空间中选择最佳的图注意力。

| 🍁 四、总结 🍁 |

作者提出了一种新颖的图神经结构设计,以根据输入图的特征来自我监督图的注意力。

首先评估了什么是图注意力学习,并分析了边缘自我监督对链接预测和节点分类性能的影响。该分析表明,两种广泛使用的注意力机制(原始GAT和点积)难以同时编码标签一致性和边缘存在。

为了解决这个问题,提出了几种平衡这两个因素的图形注意力形式,并认为应该根据输入图形的平均程度和同型性来设计图形注意力。

最终实验表明,该图形注意力网络在各种真实世界数据集上通用,因此根据该模型优于其他基线模型。