论文地址:https://arxiv.org/abs/2404.16821

Demo: https://internvl.opengvlab.com

Model:https://huggingface.co/OpenGVLab/InternVL-Chat-V1-5

公开时间:2024年4月29日

InternVL1.5,是一个开源的多模态大型语言模型(MLLM),可以在多模态理解中弥合开源和专有商业模型之间的能力差距。我们介绍了三个简单的改进: (1)强视觉编码器:我们探索了大规模视觉基础模型的持续学习策略InternViT-6b,提高其视觉理解能力,并使其可以在不同的llm中转移和重用。(2)动态高分辨率:根据输入图像的高宽比和分辨率,我们将图像分成448×448像素中的1到40块,支持高达4K分辨率的输入。(3)高质量双语数据集:我们精心收集了一个高质量双语数据集,涵盖了常见场景、文档图像,并用中英文问答对进行注释,显著提高了OCR和中文相关任务的性能。

基于强视觉编码器 、动态高分辨率、高质量双语数据集,InternVL v1.5显示了具有和专有的商业模型相竞争的性能,在18个多模态基准中的8个中取得了最先进的结果。

1、Introduction

大型语言模型(llm)在推进人工通用智能(AGI)系统方面发挥了重要作用,在处理开放世界语言任务方面表现出非凡的能力。利用llm中的进步,多模态大型语言模型(MLLMs)[5,18,23,62,63,84,92,116,142]取得了重大进展,促进了复杂的视觉语言对话和交互,弥合了文本和视觉信息之间的差距。尽管取得了这些成就,但在开源模型和专有的商业模型的能力之间仍然存在着明显的分歧,例如,GPT-4V [87],Gemini 系列 [92, 107], and Qwen-VL-Max [5].

这一差距主要反映在以下三个方面:

- (1)

参数规模:最近专有商业MLLMs [5,87,92,102]通常规模不少于1000亿参数,而开源模型通常采用3亿参数视觉基础模型(VFM),集成了70亿或130亿LLMs。 - (2)

图像分辨率:专有的商业模型通常采用动态分辨率的方法,保留原始的纵横比,以促进详细的场景和文档的理解。相比之下,开源模型通常使用固定分辨率的进行训练,如336×336和448×448,这导致了相对于商业同行的相当大的能力差距。 - (3)

多语言能力:专有模型经常利用广泛的多语言数据集来进行训练,从而提高它们跨不同语言的性能。然而,开源模型主要利用英语数据,依赖于LLMs对其他语言的zero-shot能力,例如LLaVA-NeXT [64]。这导致了在非英语场景理解和OCR任务中表现不佳。

为了弥补这一差距,我们引入了InternVL1.5,集成了三个主要的改进来提高其性能和可用性。

- (1)我们对大规模VFM-InternViT-6b实现了持续学习方法,

使用高质量的图像文本数据对其进行改进。这一过程不仅增强了模型理解视觉内容的能力,而且提高了其对各种llm的适应性。此外,使用InternLM2-20B[11]作为语言基础模型,还提供了健壮的初始语言处理能力。 - (2)我们采用

动态高分辨率策略,将图像分割成448×448的patch,根据图像的高宽比和分辨率,patch的数量从1到40(即4K分辨率)。为了捕获全局上下文,我们还包括了一个缩略图视图。 - (3)我们收集了不同的公共数据集,包括高质量的自然场景、图表、文档和中汉对话。此外,我们

使用开源的llm开发了一个数据翻译pipeline,它可以很容易地扩展到更多的语言。

这些设计赋予我们的模型几个优势:

- (1)灵活的分辨率:类似于GPT-4V [87]的“低”或“高”模式,InternVL1.5使用户选择最佳图像分辨率,如使用低分辨率场景主题描述和高分辨率(4k分辨率)文档理解,有效地平衡计算效率和细节保存。

- (2)双语能力:InterVL1.5具有强大的双语能力,熟练处理中汉的多模态感知和理解任务。值得注意的是,在与中文相关的任务中,我们的模型通常表现优于领先的GPT-4V [87]。

- (3)强视觉表示:通过实施持续学习策略,我们增强了intir-6b[18]的视觉表示能力,使其对灵活的输入分辨率和各种视觉领域具有鲁棒性。

得益于InternViT-6B的大量参数,,我们的模型实现了一个水平的视觉表示,可以与超过200亿个参数的llm的语言能力相持平。视觉和语言处理之间的协同作用使我们的系统具有强大的多模态能力。

我们在18个具有代表性的多模态基准上评估了InternVL1.5,这些基准被分为4个特定的组:与ocr相关的、一般的多模态、数学和多回合对话基准。与开源和专有模型相比,IntarmVL1.5显示了具有竞争力的性能,在18个基准测试中的8个中取得了最先进的结果。值得注意的是,如图1所示,它甚至在四个特定的基准测试中超过了领先的专有模型,如Grok-1.5V [125]、GPT-4V [87]、Claude-3 Opus,Gemini Pro 1.5 [92],特别是在与ocr相关的数据集中,如TextVQA [100]、ChartQA [81]和DocVQA [82]。这一评估表明IntarVL1.5有效地缩小了开源模型和领先商业模型之间的差距。我们希望我们的方法和开源模型的权重能够有助于MLLM社区的发展

大视觉模块,与动态分辨率使得InternVL v1.5在ocr相关的DocVQA、TextVAQ等问题上超过了部分开源模型

2. Related Work

2.1. Proprietary Commercial MLLMs

大型语言模型(LLMs)[1,4,7,8,11,25,104,106,108,112,113,122,123,141]通过启用以前被认为是人类独有的复杂语言任务,极大地提高了AGI技术。在此基础上,专有商业mllm的发展代表了一个重大的演变。例如,OpenAI的GPT-4V [87]通过整合视觉输入扩展了GPT-4的功能,使它能够同时处理文本和图像内容,这是mllm领域的一个重大发展。之后,谷歌的Gemini系列从Gemini 1.0 [107]发展到Gemini 1.5 [92],增强了处理文本、图像和音频的能力,并支持多达100万个token,这显著提高了性能。QwenVL-Plus/Max是阿里巴巴QwenVL系列[5]的领先版本,以不需要OCR工具的多模式任务能力而闻名。专有mllm的进展包括Anthropic公司的Claude-3V系列[3]、HyperGAI的HPT Pro [35]、苹果的MM1 [84]、StepFun的Step-1V[102]和xAI的Grok-1.5V [125]。

2.2. Open-Source MLLMs

开源MLLMs [2,13,43,48,51,55,56,69,70,103,110,118,120,124,138,139]的开发通过集成和增强处理视觉和文本数据的能力,显著地影响了AGI景观。在过去的一年里,许多开源的mllm已经变得很出名,包括LLaVA系列[62-64],MiniGPT-4 [142],VisionLLM [116],Qwen-VL [5],CogVLM [117],Shikra [15],和其他[18,23,90,119]。然而,这些模型通常是在具有小的、固定分辨率的图像上进行训练的,如336×336或448×448,这导致了对具有不寻常纵横比或文档数据的图像的次优性能。为了解决这个问题,我们已经探索了许多训练高分辨率图像的方法。目前,有两种常见的技术途径:一种是设计一个双分支图像编码器[32,53,76,77,121],另一种是将一个高分辨率的图像分割成许多低分辨率的瓷砖[24,33,47,55,57,64,68,126,127]。尽管在高分辨率训练方面进行了这些探索,但与领先的商业模型相比,这些开源模型在理解文档、图表和信息图形以及识别场景文本方面仍然表现出显著的差距。

2.3. Vision Foundation Models for MLLMs

视觉基础模型(VFMs)是MLLM社区的一个研究焦点。目前,CLIP-ViT [91]和SigLIP [136]等模型被普遍使用;然而,许多研究已经寻找最适合mllm的视觉编码器。例如:

- Tong等人[111]观察到CLIP和DINOv2 [88]的视觉模式存在显著差异,导致了结合这两个vfm的特征混合模块的开发。

- LLaVA-HR [76]引入了一种双分支视觉编码器,利用CLIP-ViT用于低分辨率路径,而CLIP-ConvNext用于高分辨率路径。

- DeepSeek-VL [71]采用了双视觉编码器设计,使用SigLIP-L处理低分辨率图像,使用SAM-B处理高分辨率图像。

- 在本报告中,我们为我们的视觉基础模型提出了一个持续的学习策略——内部vit-6b[18],它不断提高视觉理解能力,并可以在不同的llm之间转移和重用。

3. InternVL 1.5

3.1. Overall Architecture

如图3所示,InternVL1.5采用了一种类似于广泛使用的开源mllm的体系结构,特别是各种现有研究中引用的“ViT-MLP-LLM”配置[18,23,62-64,71,142]。我们对该架构的实现集成了预先训练的InternlViT-6B[18]和预先训练的InternLM2-20B,使用随机初始化的MLP 投影。

在训练过程中,我们实现了一个动态分辨率策略,根据输入图像的高宽比和分辨率,将图像分成448×448像素的patch,大小从1到12。在测试过程中,可以将零镜头放大到40的patch(即4K分辨率)。为了增强高分辨率的可伸缩性,我们简单地使用了一个像素shuffle操作,将视觉令牌的数量减少到原来的四分之一。因此,在我们的模型中,一个448×448的图像由256个视觉token表示(对应可以算出VIT模型的patch size为28)。

3.2. Strong Vision Encoder

在现有的mllm中[5,23,62-64,78,142],最常用的视觉基础模型通常是一个对比预训练的ViT [18,36,91,136]。然而,这些vit通常是基于固定的低分辨率(如224×224),因此当处理高分辨率图像或来自互联网以外来源的图像,如文档图像时,它们的性能会下降。

InternViT-6B-448px-V1.2. 为了解决这个问题,InternVL1.2更新涉及到InternViT-6B模型的持续预培训。首先,我们发现倒数第4层的特征对多模态任务表现最好,所以我们直接丢弃了最后三层的权重,将InterViT-6B从48层减少到45层。然后,我们将InternViT-6B的分辨率从224提高到448,并将其与Nous-Hermes-2-Yi-34B [130]集成。为了使模型具有高分辨率处理和OCR能力,视觉编码器和MLP都被激活进行训练,混合使用图像caption[10,17,90,93,100]和OCR特定数据集[29,94]。从这个过程中新衍生的内部权重被表示为InternViT-6B-448px-V1.21。

InternViT-6B-448px-V1.5. InternVL1.5的开发继续了InternViT-6B-448px-V1.2的强大基础的预培训。在这次更新中,训练图像的分辨率从固定的448×448扩展到动态的448×448,其中基本的平铺大小为448×448,平铺的数量范围从1到12。此外,我们增强了预训练数据集的数据规模、质量和多样性,从而获得了我们的1.5版本模型的强大的鲁棒性、OCR能力和高分辨率处理能力。动态分辨率和训练数据集的细节在第3.3和3.4节中描述。

值得注意的是,尽管InternVL1.5中的LLM从Nous-Hermes-2-Yi-34B转变为IntarLM2-20B[11],但IntrenViT与新的LLM保持了良好的兼容性和可移植性。这表明IntrenViT-6B在MLLM训练前阶段学习到的视觉特征广泛适用,与特定的LLM没有紧密结合。

3.3. Dynamic High-Resolution

能有效地适应输入图像的不同分辨率和高宽比的分辨率训练方法。这种方法利用了将图像分割成pach的灵活性,增强了模型处理视觉细节的能力,同时适应不同的图像分辨率。它主要由以下步骤组成:

Dynamic Aspect Ratio Matching. 如图4所示,为了在处理过程中保持自然的长宽比,我们从预定义的长宽比集中动态地匹配最佳长宽比。由于有限的计算资源,我们在训练期间最多允许12个patch。因此,这个集合包括由1到12个切片组成的所有35种可能的高宽比组合,例如{1:1、1:2、2:1、3:1、…,2:6}。在匹配过程中,我们对每个输入图像计算其长宽比,并通过测量绝对差将其与35个预先预定义的长宽比进行比较。如果多个预定义的高宽比匹配(例如,1:1和2:2),我们将对不超过输入图像面积两倍的图像进行优先排序,从而防止低分辨率图像的过度放大。

Image Division & Thumbnail. 一旦确定了适当的高宽比,图像就会被调整到相应的分辨率。例如,一个800×1300的图像将被调整为896×1344。调整后的图像被分成448×448像素的切片。在切片旁边,我们还包括了整个图像的缩略图来捕获全局上下文。这个缩略图被缩小到448×448,帮助模型理解整个场景。因此,在训练期间,视觉令牌的数量从256到3328不等。在测试期间,切片的数量最多可以增加到40个,从而产生10,496个视觉token。

3.4. High-Quality Bilingual Dataset

Pre-training Dataset. 在我们的InternVL1.5中使用的训练前数据集包含了各种公共可访问的源。我们在表1a中提供了这些数据集的概述。这些数据集跨多个任务,包括caption,它主要使用Laion-EN [93]、Laion-ZH [93]、COYO [10]和GRIT [90]等数据集,占总数据的53.9%。检测和接地任务利用object-365[97]、GRIT [90]和All-Seeing[119]等数据集,占5.2%。对于OCR任务,我们使用了大规模的数据集,如Wukong-OCR、LaionCOCO-OCR和公共爬虫获取的pdf,它们占我们数据的32.0%。这些数据集使用PaddleOCR [49]对Wukong[29]的中国图像和LaionCOCO [94]的英文图像进行OCR构建。较小的OCR数据集包括MMC-Inst [61]、LSVT [105]、ST-VQA [9]、RCTW-17 [98]、ArT [19]等,占数据的8.9%,这些数据侧重于更具体或更受限的OCR挑战。这种不同的数据集组装确保了InternVL的鲁棒模型预训练,满足了不同任务中的各种语言和视觉元素。

Fine-tuning Dataset. 在微调阶段,我们精心选择的数据集,以提高在各种多模态任务中的模型性能。表1b总结了本阶段使用的数据集。

对于图像caption,我们包括了TextCaps [99]和双语ShareGPT4V [16],这可以帮助模型学习生成英语和中文的描述性字幕。在一般QA领域,VQAv2 [28]、GQA [34]和visalog[22]等数据集教模型处理不同的问答场景。

为了理解科学图像,AI2D [39]、ScienceQA [73]和TQA [40]等数据集提供了内容丰富的场景,以增强模型解释科学图表和文本的能力。图表的解释得到了ChartQA [81]、MMC-Inst [61]和PlotQA [85]的支持,这些软件训练模型来分析和理解图表图像。数学数据集,如GeoQA+ [12],TabMWP [74],和MathQA [132],引入了复杂的数值和几何问题解决任务。基于知识的QA得益于包含像KVQA [96]和双语维基百科[31]这样的数据集,使模型能够跨多种语言提取事实信息和推理。

对于涉及OCR的任务,我们利用OCRVQA [86]、TextVQA [100]和几个专注于中文和英文文本识别的数据集,如SynthDoG [41],来提高对图像的文本识别。文档理解是通过像DocVQA [82]和通用爬虫pdf这样的数据集来实现的,这些数据集有助于建立真实世界的文档分析模型。视觉接地训练使用RefCOCO [79,131]和视觉基因组[42],帮助模型在图像中精确定位目标定位。在多模态对话领域中,像LLaVA-150K [63]和ALLaVA [14]这样的数据集通过模拟交互式和引人入胜的场景,增强了模型的对话能力。最后,纯文本数据集包括OpenHermes2.5 [109],AlpacaGPT4 [106]和其他[6,141],它们用于维护LLM的原始语言能力。

总之,这些数据集一起为微调建立了丰富和多样的基础,这增强了我们的模型处理广泛的多模态任务的能力,并确保其为实际应用做好了准备。

Data Translation Pipeline. 如图5所示,为了增强我们的模型的多语言功能,我们实现了一个数据转换流程。该pipeline利用最先进的开源LLMs [4,11,130]或GPT-3.5将英语数据集转换为另一种语言(如中文),从而保持双语标签的一致性和精度。此外,它可以通过调整语言提示符,很容易地扩展到包含更多的语言,而不依赖于手动注释过程。

在表1中,我们已经为每个数据集进行了语言注释。对于最初是英文的数据集,作为“zh”的注释表示我们已经使用翻译pipeline将其翻译成中文。例如,COYO [10]和GRIT [90]最初是英语数据集,我们已经将它们翻译成了中文。通过利用这种翻译管道,InternVL1.5的中文功能已经大大增强。

4. Experiments

4.1. Implementation Details.

InternVL 1.5是通过将InternVIT-6B[18]视觉编码器与InternLM2-20B[11]语言模型集成而开发的,使用动态高分辨率策略。在这种方法中,图像被分割成448×448像素的瓷砖,根据训练期间图像的长宽比和分辨率,切片的数量范围高达12。在测试阶段,该模型可以处理多达40个切片,相当于4K分辨率,以zero-shot的方式展示其对高分辨率输入的适应性。值得注意的是,我们基于IntarnLM2-20B的聊天版本而不是基本模型构建了我们的模型。

InternVL 1.5的训练分为两个阶段。最初,训练前阶段的重点是训练InternVIT-6B视觉编码器和MLP投影,以优化视觉特征提取。随后,对整个模型的260亿个参数进行了微调,以增强多模态能力。在这两个阶段的训练中,我们都使用了一个上下文长度为4096的方法,并采用了与LLaVA 1.5 [52]相同的响应格式化提示。此外,该评估主要由VLMEvalKit [21]支持。

4.2. Comparison with State-of-the-Art MLLMs

4.2.1 Quantitative Results on 18 Benchmarks

在本节中,我们将对一系列基准进行广泛的评估,以评估我们的模型的多模态理解和推理能力。在我们的研究中使用的基准被分为四种不同的类型:与ocr相关的、一般的多模态的、数学的和多回合的对话基准。如表2所示,InternVL1.5在大多数基准测试中显示了领先的性能。

OCR-related Image Understanding. 我们在OCR的四个关键维度上评估了模型的性能:文档理解(DocVQA [82])、图表理解(ChartQA [81])、信息图理解((Info-graphic VQA[83])和场景文本解释(TextVQA [100])。此外,我们使用OCRBench [67]对模型的整体OCR能力进行全面评估。如表2所示,我们的模型在这些基准测试上显示了与专有模型相当的性能,并且显著优于开源LLaVA-NeXT [64]和InternVL v1.5的前身InternVL v1.2 。值得注意的是,我们的模型在ChartQA和OCRBench上取得了最先进的性能,优于所有竞争的专有模型。

General Multimodal Evaluation. 除了ocr相关的基准测试之外,我们还在几个通用的多模态基准测试上测试了我们的模型:

- 使用RealWorldQA [125]来评估模型的真实世界空间理解能力。

- HallusionBench[30]被用来评估其控制幻觉的能力。

- MMMU [135]被用来评估该模型的多学科能力

- AI2D [39]被评估其对科学图表的理解。

- MMBench-CN测试[66]和CCBench [66]测试了该模型的汉语熟练程度和对中国文化的理解程度

- MME [26]、MMBench-EN [66]、MMVet [133]、SEED [46]和MMT-Bench [129]也被用于评估模型的视觉理解和推理能力。

与其他开源模型如text-Monkey[68]、DocOwl-1.5 [33]和LLaVA-NeXT [64]相比,我们的InternVL v1.5显著缩小了这些基准测试中与专有模型的差距。具体来说,我们的模型在HallusionBench[30]上取得了最好的性能,展示了其减少幻觉的出色能力。此外,得益于我们高质量的双语数据集,我们的模型展示了健壮的中文语言能力,显著超过了MMBench-CN和CCBench上的开源和专有方法。然而,虽然InternVL v1.5超过了MM1 [84],与MMMU上的Gemini Pro 1.0 [107]相当,但它的前身InternVL 1.2略有下降。我们将这种适度的减少归因于语言模型的较小规模,这是在MMT-Bench [129]结果中观察到的类似现象,如表3所示。

Math Reasoning. MathVista [75]是一个基准测试,旨在集成来自各种数学和视觉任务的挑战。完成这些任务需要对视觉效果、逻辑思维和数学知识的深刻理解——许多专有的商业模型在这些领域遇到了重大困难。如表2所示,我们的模型在这个基准测试中明显优于其他模型,包括GPT-4V [87],显示了它处理数学要求很高的任务的能力。

Multi-Turn Conversation. 与单回合对话相比,多回合对话更符合人类的偏好。在实际应用中,多回合对话是通用助手与人类一起解决各种任务的首选模式。因此,我们选择使用ConvBench [65]来评估多回合对话,它逐步评估mllm的感知、推理和创造力能力。如表3描述, InternVL 在开源模型中表现出领先的性能,尽管仍然远远落后于GPT-4V。未来,我们将继续完善内部公司在多回合对话中的能力.

4.3. Ablation Study

Larger LLMs need Larger VFMs. 在本研究中,我们研究了llm和vfm之间的相互作用。该比较涉及两个开源的mllm,LLaVA-NeXT[64]和InternVL1.2,每个都配备了340亿个参数的llm。值得注意的是,尽管两种模型都采用了相同规模的llm,但InternVL 1.2包含了一个显著更大的VFM,有60亿个参数,而LLaVA-NeXT的3亿个参数。由于LLaVA-NeXT的数据不可用,所以我们自己创建了一个类似的数据集。此外,InterVL1.2的固定分辨率为448×448,而LLaVA-NeXT使用更高的动态分辨率为672×672。因此,这种比较并不完全公平或等价的。然而,这些发现仍然揭示了值得注意的见解。例如,在排除了5个与ocr相关的数据集ConvBench和RealWorldQA后,在其余11个数据集中,InternVL v1.2的表现优于LLaVA-NeXT。这种性能差异支持了我们的假设,即对于一个大规模的LLM(例如,34B),一个更大的VFM(例如,6B)可以有效地提高模型处理复杂多模态任务的能力,从而提高整体性能。

Dynamic Resolution Matters. 如图6所示,我们研究了跨各种多模态基准测试的动态分辨率的有效性。我们发现,并非所有的任务都需要高分辨率。具体来说,与OCR相关的任务,如DocVQA、InfoVQA、TextVQA和OCRBench,都受益于提高的分辨率。然而,像AI2D、MMMU、MMBench和HallusionBench等任务在较高分辨率下表现出性能略有下降。总的来说,InternVL1.5对动态分辨率具有很强的鲁棒性。它可以根据每个任务的具体需求来调整分辨率,在高分辨率有益的地方确保最佳性能,在不有利的地方节约资源。

4.3.1 Qualitative Results on Different Scenes

在前面的章节中,我们通过不同的基准测试来评估了我们的模型,并观察到了它的强大性能。在本节中,我们将我们的模型与GPT-4V [87]在不同的场景中进行了定性比较,包括一般QA、与ocr相关的QA、科学理解、中国传统文化、对象定位和多图像对话。我们的目标是展示我们的模型在现实应用程序中的实用性和通用性,从实际用户体验的角度提供见解。

General QA. 为了比较InternVL1.5和GPT-4V的一般功能,我们首先进行了一个实验,涉及对需要一般知识的图像进行简单的用户查询。如图7左侧所示,两个模型都准确地响应查询,显示了它们在一般主题方面的熟练程度。如图7右侧所示,GPT-4V由于涉及到个人隐私,可能会过度拒绝回答一些问题。

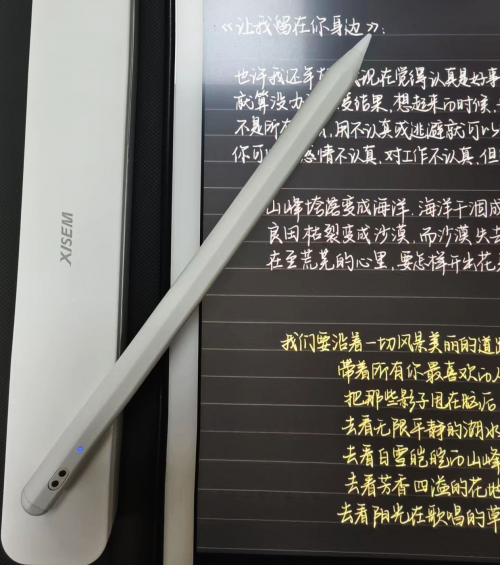

OCR-Related QA. 我们进行了评估,以比较我们的InternVL1.5模型与GPT-4V的OCR能力。在图8的左侧,第一个提示旨在测量模型理解中国场景的能力。在这种情况下,GPT-4V不能提取图像中所有有用的信息。在图8的右侧,GPT-4V和我们的模型在图表理解方面都有良好的性能。

Scientific Understanding. 在科学理解推理任务中评估模型的能力对于推进计算智能至关重要,特别是在需要领域内知识和逻辑推理的情况下。在我们的研究中,我们通过比较我们的内部InternVL1.5模型的性能,管理复杂的多学科问题,以评估其推理的准确性。在图9中,对于第一个问题,两个模型都准确地回答,并从空气动力学的角度提供了分析。对于第二个问题,我们的模型精确地分析了图像中描述的元素,并提供了正确的响应,而GPT-4V则推测了氨基酸转运的趋势。这些结果表明,我们的方法和GPT-4V在科学理解和推理方面表现出相当的能力。

Chinese Traditional Culture. 我们选择了两个与中国传统艺术相关的典型多模态例子来评价我们的模型。如图10所示,InternVL 1.5和GPT-4V都能正确识别出图像中所描述的中国传统文化。值得注意的是,InterVL1.5展示了对这种文化的更深入的理解,它在回应中对文化元素进行了更详细的描述。

Object Localization. 评估机器学习模型在目标定位任务中的熟练程度是必要的,特别是在需要精确空间意识的应用中。在我们的比较分析中,InternVL v1.5模型的性能与GPT-4V相同,重点是它们在不同环境中准确检测和定位对象的能力。我们的评估范围从杂乱场景中的简单物体识别到涉及多个实体之间动态交互的复杂场景。如图11所示,结果表明InternVL v1.5不仅具有较高的精度定位对象,而且对空间关系具有可比性的理解,与GPT-4V的性能相匹配。

Multi-Image Dialogue. 如图12所示,在本实验中,我们要求InternVL 1.5和GPT-4V比较两幅图像的异同。可以看出,GPT-4V和InternVL1.5都提供了详细和准确的响应。通过这个实验,我们发现,虽然InternVL v1.5仅在单个图像输入上进行训练,但它在多图像对话中显示出了很强的zero-shot能力。

5. Conclusion

这项工作引入了InternVL v1.5,这是一个开源的MLLM,旨在在多模态理解中缩小开源模型和专有模型之间的性能差距。通过集成强大的具有连续学习能力的视觉编码器,采用动态高分辨率策略,并利用高质量的双语数据集,InternVL 1.5在各种基准测试中展示了健壮的性能。我们的评估表明,该模型与领先的专有模型取得了具有竞争力的性能,尤其是在ocr相关任务方面,并在中国相关场景理解方面显示出显著的改进。虽然InternVL v1.5对开源多模式理解做出了贡献,但该领域继续面临许多挑战。我们渴望进一步提高InternVL v1.5的能力,并邀请与全球研究界的合作,希望共同丰富和扩大开源模型的覆盖范围。