作者及发刊详情

摘要

正文

主要工作贡献

1)针对大模型自定义矢量点积扩展指令,并设计了专用硬件加速大语言模型的运算

2)基于香山处理器增加矢量点积计算单元和流水线处理逻辑,开发了包含上述指令的处理器nanhu-vdot

3)在FPGA上做测试,硬件资源和功耗几乎没有增加,矢量点积运算速度相比标量方法提高了 4 倍以上

4)在FPGA上进行GPT-2的推理,速度比纯软件实现提高了30%

实验评估

实验验证平台:Xilinx VU19P FPGA

选用模型: GPT-2

选用了三种模型。

工具:

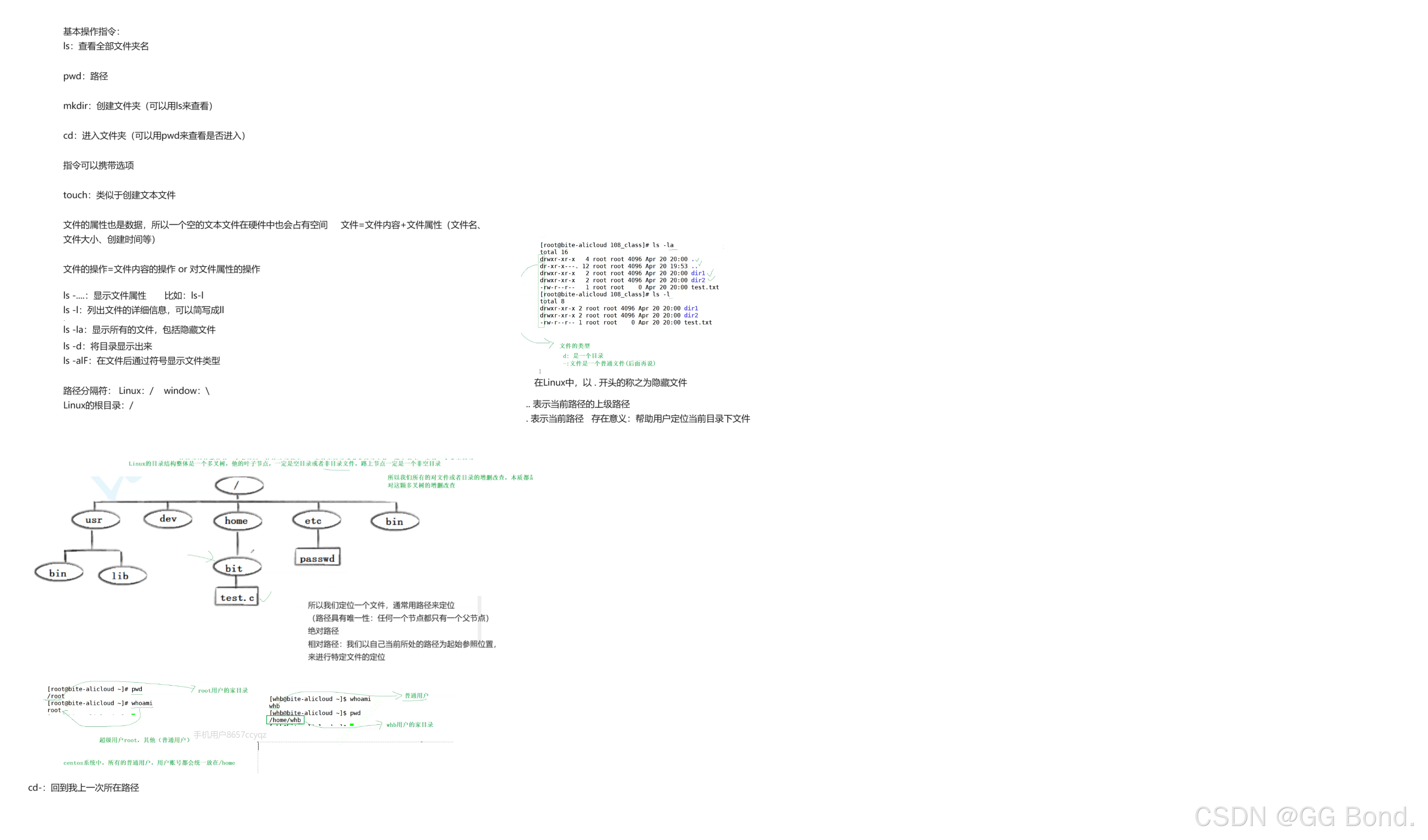

- 该测试系统基于香山处理器的操作系统环境

- 通过测试接口将os可执行文件传输到FPGA的DDR中

- 模型代码和推理程序存在linux的临时文件系统中

PPA

性能

对 GPT-2 小型模型、中型模型、大型模型的推理速度提升分别为 30.9%、27.8%、27.9%。

资源消耗

nanhu-vdot 相比“香山”(nanhu 版本)增加 15677 个 LUT 单元,占比 2.8%,增加 2486 个 Flip-Flop 单元,占比 0.9%,BRAMs 未增加。

功耗

“香山”(nanhu 版本)的功耗开销为 8.454W,nanhu-vdot 功耗为 8.494W。nanhu-vdot 相比于“香山”(nanhu版本)的功耗仅增加 0.5%.

软硬协同设计

硬件:编写矢量点积计算定制自定义扩展指令的单元设计代码,对矢量点积进行加速,与高性能处理器“香山”(nanhu 版本)一起编译,生成可仿真的比特流。

软件:

- 增加自定义矢量点积计算指令

- 修改编译器,使其支持扩展的指令

- 修改 GPT-2 开源 C/C++代码,其中对于 int8 类型矢量点积计算部分通过汇编指令调用硬件执行单元,在调用硬件前后进行数据类型转换,最终通过硬件的加速计算得到文本输出。

自定义点积扩展指令

- R-type 译码模式

- Inst[11:7]表示交换后数据写回的目的寄存器号

模型修改

实现 GPT-2 大模型推理中元素类型为 int8 的矢量点积计算实现

硬件设计

设计了矢量点积计算单元和流水线处理逻辑,即VDOTU模块。

与CPU的集成方式

- 将矢量点积扩展指令与高性能处理器“香山”(nanhu 版本)的流水线紧密、耦合。

- 充分利用 “香山”的现有译码逻辑、寄存器堆和功能单元,尽可能减少额外的面积开销

- 作为流水线中的执行部件,如下图中的EXE单元

VDOTU模块

该模块作为扩展指令的核心执行单元,采用SIMD向量化的执行方式。

- VDOTU 默认配置为 8bit 的整形计算

- 包含八路 8-bit 乘法器和七个加法器

- 输出采用 64-bit,与处理器的通用寄存器大小一致

参考文献

评

该工作的硬件设计较为简单,大量的工作在原软件工作,特别是模型算子的移植。

值得借鉴的是该方案的测试流,极大的简化的软件工作,详细参考实验评估部分。