8G 显存玩转书生大模型 Demo

- 【书生大模型实战营】基础岛-8G 显存玩转书生大模型 Demo

- InternLM2-Chat-1.8B 模型的部署

- 代码运行

- StreamLit部署

- InternLM-XComposer2-VL-1.8B 模型的部署

- InternVL2-2B 模型的部署

【书生大模型实战营】基础岛-8G 显存玩转书生大模型 Demo

InternLM2-Chat-1.8B 模型的部署

代码运行

首先通过VSCode连接开发机,shiyconda activate /root/share/pre_envs/icamp3_demo激活存在的环境:

创建```cli_demo.py``文件,并完成运行模型的代码:

然后运行python cli_demp.py,可以输入用户指令,模型会给出回答:

可以看出,它的自我认知能力还不太行。

StreamLit部署

首先克隆InternLM的Tutorial到本地,使用代码git clone https://github.com/InternLM/Tutorial.git克隆。

然后启动一个 Streamlit 服务,代码为:

streamlit run /root/Project/Tutorial/tools/streamlit_demo.py --server.address 127.0.0.1 --server.port 6006

之后VSCode会弹出一个网址,不需要我们自己在本地进行映射,如下:

然后跟大模型进行了交流,让它写一篇作文,最终得到的界面如下:

InternLM-XComposer2-VL-1.8B 模型的部署

使用如下命令进行部署:

lmdeploy serve gradio /share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-vl-1_8b --cache-max-entry-count 0.1

VSCode会自动对地址进行映射,最后在本地的界面为:

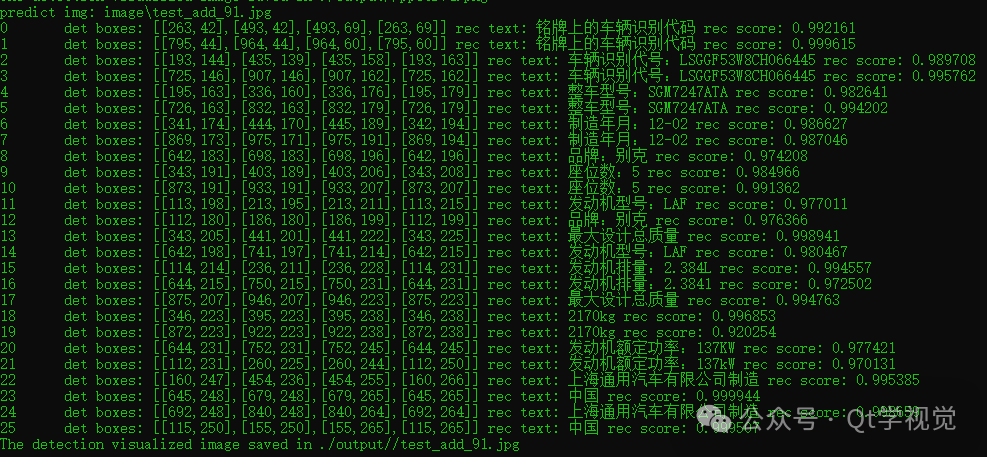

InternVL2-2B 模型的部署

InternVL2-2B是最新一代的视觉-语言多模态大模型,是首个综合性能媲美国际闭源商业模型的开源多模态大模型。

使用如下命令进行部署:

lmdeploy serve gradio /share/new_models/OpenGVLab/InternVL2-2B --cache-max-entry-count 0.1

/share/new_models/OpenGVLab/InternVL2-2B目录下的文件为:

最终的界面如下: