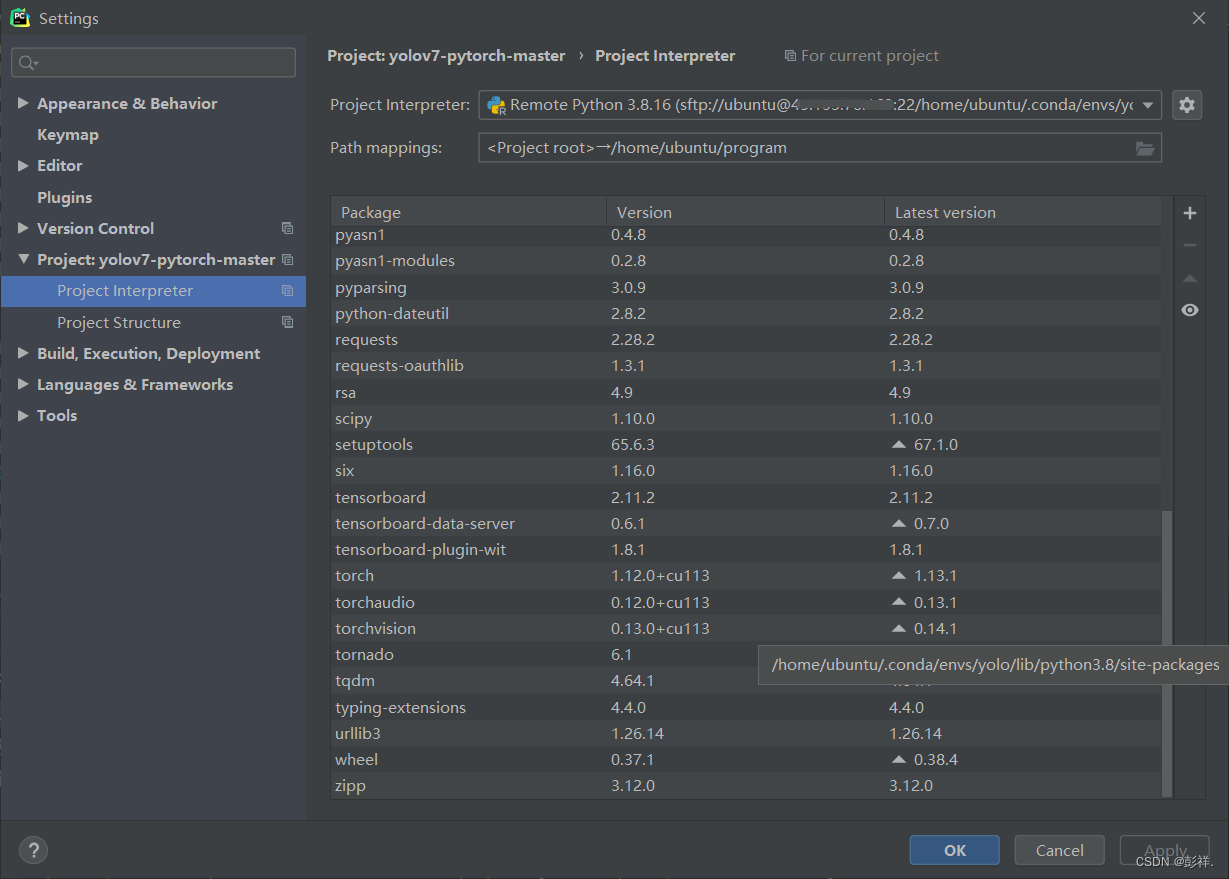

资源包配置

首先就是pytorch的安装了,这里可以使用conda命令或者是pip命令

首先是conda命令,博主在第一个服务器时的安装方式就是这个,很正常,但到第二次安装时却总是出错

conda install pytorch==1.12.0 torchvision==0.13.0 torchaudio==0.12.0 cudatoolkit=11.3 -c pytorch

报错:CondaError: Downloaded bytes did not match Content-Length。

网上的解决方法是添加清华源的镜像,但我的已经是清华源镜像了,所以解决方法是把timeout放大,600还是不行,把时间延长到1000.0就成功安装了。命令如下:

conda config --set remote_read_timeout_secs 1000.0

但博主改了好几次,甚至一度将时间设置为6000,但还是失败了,无奈使用了pip的安装方式。这次就按照成功了。

pip install torch==1.12.0+cu113 torchvision==0.13.0+cu113 torchaudio==0.12.0 --extra-index-url https://download.pytorch.org/whl/cu113

所需其他资源包及安装命令:

sudo apt-get install python3-matplotlib

pip install scipy

pip install tqdm

pip install opencv-python

环境部署:

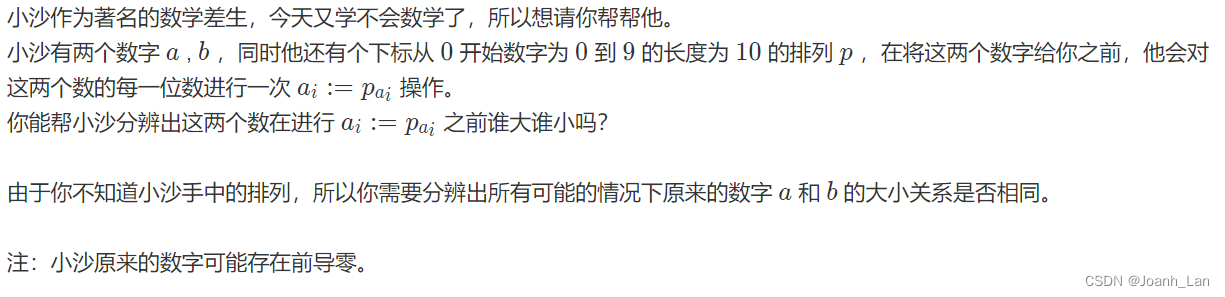

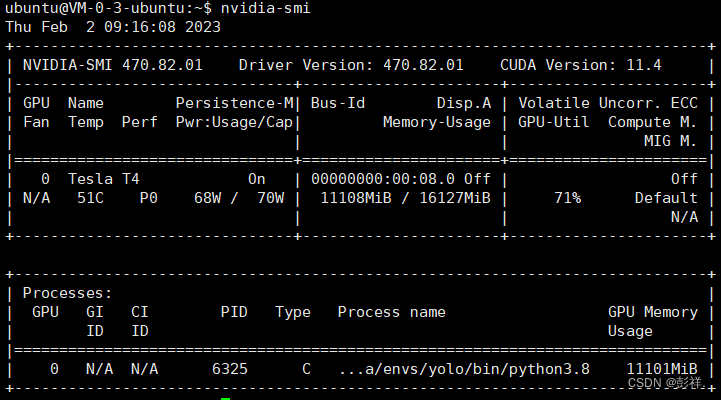

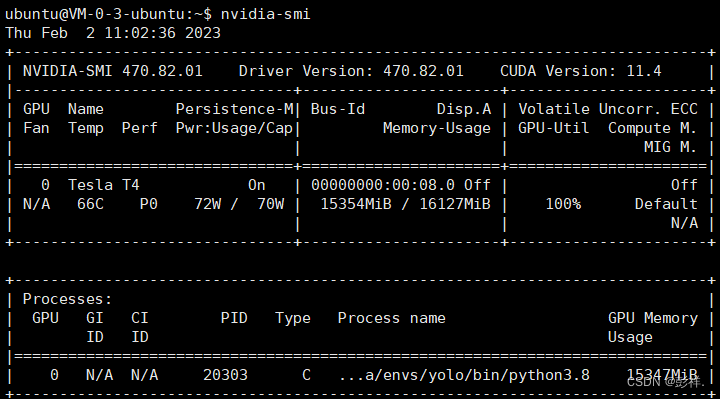

依次执行就可以,本次博主又换了一个服务器,这次在安装过程中遇到了一些问题,最终也解决了,实验数据集换成了CADCD,输入尺寸为1280x1024,很明显此时的显存占用要比640x640的大了很多,下面是本次GPU使用情况:batch-size为16,迭代次数为200次。

然而还没高兴太久就出问题了:

CUDA out of memory. Tried to allocate 2.50 GiB (GPU 0; 15.75 GiB total

capacity; 5.88 GiB already allocated; 479.62 MiB free; 14.15 GiB

reserved in total by PyTorch) If reserved memory is >> allocated

memory try setting max_split_size_mb to avoid fragmentation. See

documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

由于计算累计最终爆显存了,代码中已经使用了torch.no_grad(),但没有用,那么就只能修改批次大小或者是图片大小了,最终把批次大小降为12。

在开始时占用只有11G,但随着训练继续,达到了15G。

这次应该不会有问题了吧,保佑!

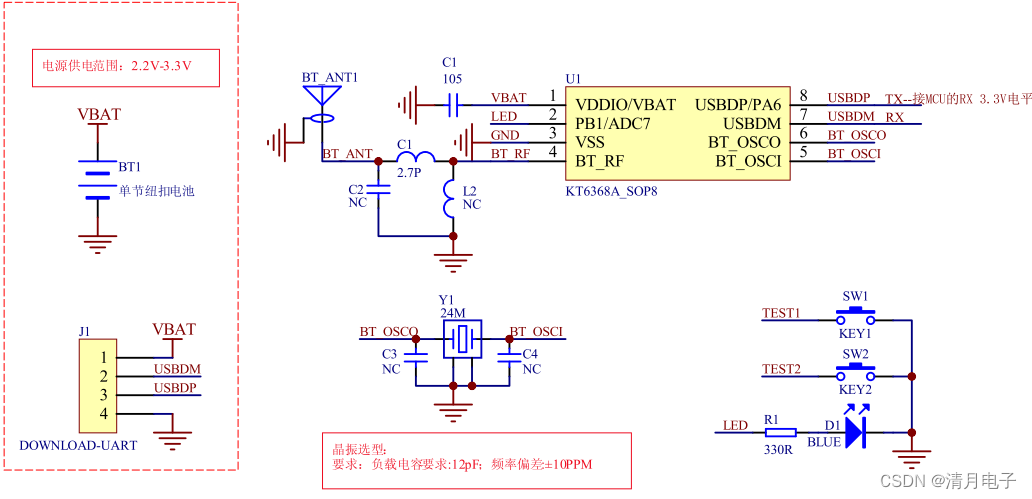

云硬盘挂载问题

在使用这个服务器的过程中意识到每次更换服务器需要重新上传项目和数据集,这让人很苦恼,因此可以采用加装一个云硬盘的方式,这样就不需如此频繁更换了,然而也是刚刚意识到该问题,博主的GPU服务器是硅谷二区的,但并未找到可用区的硬盘,呜呜呜

以下是博主咨询腾讯云客服时给的回复,即云硬盘不支持跨区挂载,也不支持跨账户挂载。