Datawhale 吃瓜教程组队学习task01

还没写完,会持续更新~~

上个月看了周志华老师的机器学习视频课的前三章,但是后面中断了没看…(主要是懒🤐)

于是打算这个月继续来学习西瓜书和南瓜书🤯

Task01:概览西瓜书+南瓜书第1、2章 2天 截止时间 01月18日03:00

- 既然上个月已经看过了视频课,那下面就结合上个月的笔记还有书来总结归纳一下,同时尝试一些学习方式

- 先列出目录进行回忆

- 部分地方画图总结

- 给自己提出一些问题,不限于西瓜书,可以是联想到其他学习AI的过程中的内容从而提出的问题

文章目录

- Datawhale 吃瓜教程组队学习task01

- chap1 绪论

- 1.1 引言 1.2 基本术语

- 画图玩玩

- 总结图1:关于数据集、样本、样本空间、样本维数、本书的向量记法、属性、属性值

- 总结图2:关于学习过程、假设、真相、样例、标记、标记空间、泛化

- 文字总结

- 自问不答🤔

- 术语列表

- 1.3 假设空间

- 1.4 归纳偏好

- 1.5 发展历程

- 1.6 应用现状

- 填空答案(仅供参考)

- chap2 模型评估与选择

- 2.1 经验误差与过拟合

- 2.2 评估方法

- 2.3 性能度量

- 2.4 比较检验

- 2.5 偏差与方差

- 填空答案(仅供参考)

- 填空答案(仅供参考)

- chap2 模型评估与选择

- 2.1 经验误差与过拟合

- 2.2 评估方法

- 2.3 性能度量

- 2.4 比较检验

- 2.5 偏差与方差

- 填空答案(仅供参考)

chap1 绪论

1.1 引言 1.2 基本术语

画图玩玩

总结图1:关于数据集、样本、样本空间、样本维数、本书的向量记法、属性、属性值

总结图2:关于学习过程、假设、真相、样例、标记、标记空间、泛化

文字总结

下面列个大纲就算了吧, 毕竟一图胜千言,何况上面有两图👻👻👻

还是列出一些要点吧hhh

-

”算法”是从数据中学得“模型”的具体方法

-

模型是一个抽象的说法,可以理解为从数据里面产生出来的一个东西,可以是一个神经网络,甚至是一条规则

-

机器学习是关于学习算法(learning algorithm)的设计、分析和应用的学问。所以我们研究的核心是学习算法。

- 学习算法决定了获得什么样的模型,模型的性质很多时候来自于算法。

- 算法是用到数据上,不一定每次都得到同样一个模型。

-

训练:我们拿到的数据用来建立这个模型,建立这个模型的过程就是训练

-

测试是把模型拿来用,而这个用 既可能是 考察模型好不好,也可能是 输入一个东西,让模型给结果

-

假设(hypothesis) 真相 (ground-truth)

-

模型

-

所谓的模型,其实是找到了某种规律。

比如现在要找到的是颜色是青绿色,耕地是蜷缩,敲起来声音很浑浊的这样的西瓜是一个好西瓜,就会得到了一个规则。这个规则假如我们把它当做一个模型,实际上它是揭示了 关于 什么是好西瓜 的一个规律。

-

模型揭示了关于我们要判断的结果的一个规律。

- 这个规律可能是显式的,比如我们一看就知道颜色,青绿色

- 也可能是隐式的。比如一个神经网络,看不清楚它在干什么,但是反正输入一个西瓜,它就能告诉你是好还是不好。

-

所以模型包含了一个规律。而模型找出来的这个规律不一定是正确的,所以它实际上是形成了一种假设。

-

-

当我们说 hypothesis 的时候,它其实就是在指我们学到的模型。对一个问题,我们可以形成很多的hypothesis,真的假设就是事实的真相(ground-truth)。

- 🍉书的原话是

学得模型对应了关于数据的某种潜在规律,因此亦称"假设";这种潜在规律自身,则称为“真相”或“真实”- 我理解为:数据有规律,他们是客观存在的ground-truth,学习数据,学成归来得到模型,不一定功夫到家,所以只敢称自己学得了一种hypothesis

- 比如我们要学习的是“青绿、蜷缩、浑浊是好西瓜“。这一条,它就是 ground-truth,是一个正确的答案。 模型学到了一个东西,而这个东西是关于结果的一个可能的规律,这个规律不一定对。如果它是对的,就是真相。

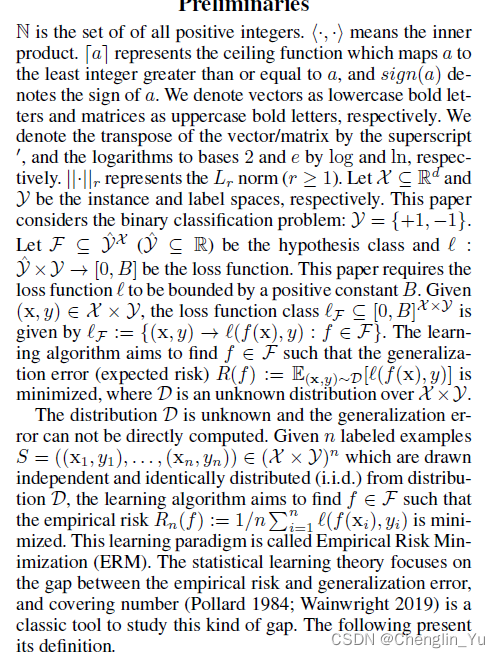

- PAC模型中,f(x)就是hypothesis, y 就是 ground-truth

- 🍉书的原话是

-

- 在上个月的视频课里面记了些术语的笔记

自问不答🤔

引导思考~🙄

-

这本书上的向量写法的区分是什么?什么时候行向量,什么时候列向量?

-

为什么很多书上在没有指明的情况下,一般默认向量为列向量

- prompt:和矩阵乘积的习惯性写法有关

-

经常问自己

- 一个算法针对什么样的数据是有效的

- 这样的数据需要满足什么样的特点

- 它产生的模型什么情况下有效

- 这样的模型具有什么特点

-

在脑子里想一下属性张成空间

- prompt:点、向量、坐标轴

- 联想一下词向量

-

为什么要假设正类和负类是可交换的?

-

有哪些常见的监督学习和无监督学习任务?

-

为什么要假定数据独立同分布?

术语列表

-

数据集 data set

- 样本/示例 sample/instance

- 属性/特征 attribute/feature

- 属性值 attribute value

- 属性空间/样本空间/输入空间 attribute space/sample space

- 样例 example

- 标记 label

- 标记空间/输出空间 label space

- 特征向量 feature vector

- 维数 dimensionality

- 样本/示例 sample/instance

-

学习/训练 learning/training

- 假设 hypothesis

- 真相/真实 ground-truth

-

训练集 training set

- 训练数据 training data

- 训练样本 training sample

- 训练数据 training data

-

测试集 testing set

- 测试数据 testing data

- 测试样本 testing sample

- 测试数据 testing data

-

模型/学习器 model/learner

- 预测 prediction

- 泛化 generalization

-

监督学习 supervised learning

- 分类 classification

- 二分类 binary classification

- 多分类 multi-class classification

- 正类 positive class

- 反类 negative class

- 回归 regression

- 分类 classification

-

无监督学习 unsupervised learning

- 聚类 clustering

-

分布 distribution

- 独立同分布 independent and identically distributed(简称

i.i.d)

- 独立同分布 independent and identically distributed(简称

1.3 假设空间

-

归纳(induction)

想想数学归纳法

- 从特殊到一般:泛化(generalization)

- 具体事实→一般规律

- 例如,"从样例中学习"是一个归纳的过程,亦称 “归纳学习” (inductive learning) .

-

演绎(deduction)

- 从一般到特殊:特化(specialization)

- 基础原理→具体情况

- 例如,在数学公理系镜中,基于一组公理和推理规则推导出与之 相洽的定理,这是演绎;

-

归纳学习有狭义与广义之分

-

广义:大体相当于从样例中学习

-

狭义:要求从训练数据中学得概念(concept) ,因此亦称为"概念学习"或"概念形成"

概念学习技术目前研究、应用都比较少,因为要学得 泛化性能好且语义明确的概念实在太困难了,现实常用的技术大多是产生"黑 箱"模型.然而,对概念学习有所了解,有助于理解机器学习的一些基础思想.

-

-

我们可以把学习过程看作一个在所有假设(hypothesis) 组成的空间中进行 搜索的过程,搜索目标是找到与训练集"匹配"(fit)的假设,即能够将训练集中 的瓜判断正确的假设

- 假设的表示一旦确定,假设空间及其规模大小就确定了.

- 现实问题中我们常面临很大的假设空间?但学习过程是基于 有限样本训练集进行的,因此,可能有多个假设与训练集一致,即存在着一个与 训练集一致的"假设集合",我们称之为"版本空间" (version space).

1.4 归纳偏好

1.5 发展历程

1.6 应用现状

填空答案(仅供参考)

- 1.1

- 001:算法

- 002:数据

- 003:模型

chap2 模型评估与选择

2.1 经验误差与过拟合

2.2 评估方法

2.3 性能度量

2.4 比较检验

2.5 偏差与方差

填空答案(仅供参考)

填空答案(仅供参考)

- 1.1

- 001:算法

- 002:数据

- 003:模型

![关系数据库-2-[mysql8]python3操作mysql](https://img-blog.csdnimg.cn/391f66203d4842fbbf786b26d8084dd2.png)