目录

- 一、前言

- 二、消除图片拼接缝隙

- 三、基于一张图片正脸转侧脸的实现

- 1、人体头部的二维成像知识

- 2、用特征点驱动的方法实现侧脸

- 2.1python核心代码

- 三、后续工作

一、前言

我们在上篇名叫python+人脸识别+opencv实现真实人脸驱动的阿凡达(上博文里已经实现了基于三角映射的仿射变换的图像的任意变形算法,可以对图片的任意区域进行三角映射至新的区域,这样只要对人脸(或者图片)根据特征结构点进行足够细致的分解理论上就可以进行人脸类似跟随相机的运动效果,或者是局部的运动。这样的算法经过测试运行性能上面也是满足实时性的需要。现在人脸的特征点识别已经较为成熟,可以用现有的人识别软件自动识别脸特征点,根据特征点,我们利用对人脸的结构知识就可以对人脸的运动变形做一些变换使得一张二维的人脸图片运动起来,做到类似三维运动的效果。目前国内外高等院校利用深度学习、生成神经网络等技术取得了较大的进展,但主流算法都基于大的神经网络模型,需要耗费大量的算力,动则需要1万元以上的显卡3块并训练3个星期,不是个人能玩得,本篇试图利用简单图像处理原理加上一些人体结构构图透视等美术知识去深入探究人脸驱动应用,作一下平民化入门级研究,目标是基于人脸识别出的特征点(如眉毛、眼睛、嘴唇)并计算相机的相对于人脸的多角度成像原理,简单实现真人脸微表情驱动一张虚拟人脸的微运动,这个虚拟人脸可以是一个二次元人脸、一个卡通脸或者是另一个AI生成的真人脸。

二、消除图片拼接缝隙

上篇我们讲到,利用将图片切割成三角的方式进行逐个仿射变换后再拼接成一张变形后的图片,其中其实涉及到一个问题,那就是拼缝的产生问题,这个问题出现后,我们翻阅了大量的资料,网上所采用的方法主要有:加权平均、边缘羽化、拉斯金字塔等方法进行处理。我们发现对三角形的拼接效果并不是很好。后来我们尝试了引入透明通道的办法,基本原理是类似图层的构念,把各个三角的以外的区域设置为透明处理,然后把所有三角块进行叠加就产生了图层叠加类似的效果,发现肉眼已经无法看出有拼缝的痕迹了。核心的代码如下:

#分离通道,并创建alpha通道

b, g, r = cv2.split(img2Cropped)

alpha = np.ones(b.shape, dtype=b.dtype) * 255 # 创建Alpha通道

# 利用遮罩方式删除三角形以外像素

mask = np.zeros((r2[3], r2[2],3), dtype = np.uint8)

cv2.fillConvexPoly(mask, np.int32(tri2Cropped), (1, 1, 1))

# 将遮罩用于透明通道

alpha1 = alpha * mask[:,:,1]

img2Cropped = cv2.merge((b, g, r, alpha1))

#合并图层

alpha_huzip = img2Cropped[:b.shape[0],:b.shape[1],3] / 255.0

alpha_huzij = 1 - alpha_huzip

bb=0

for c in range(0,3):

backimg[r2[1]+bb:r2[1]+r2[3]+bb, r2[0]+bb:r2[0]+r2[2]+bb, c] = ((alpha_huzij*backimg[r2[1]+bb:r2[1]+r2[3]+bb, r2[0]+bb:r2[0]+r2[2]+bb, c]) + (alpha_huzip*img2Cropped[:b.shape[0],:b.shape[1],c]))

三、基于一张图片正脸转侧脸的实现

本节,我们试图不用神经网络算法,通过一些人头部二维成像的先验知识,和相机运动学知识去实现一张正脸图片的运动实现。

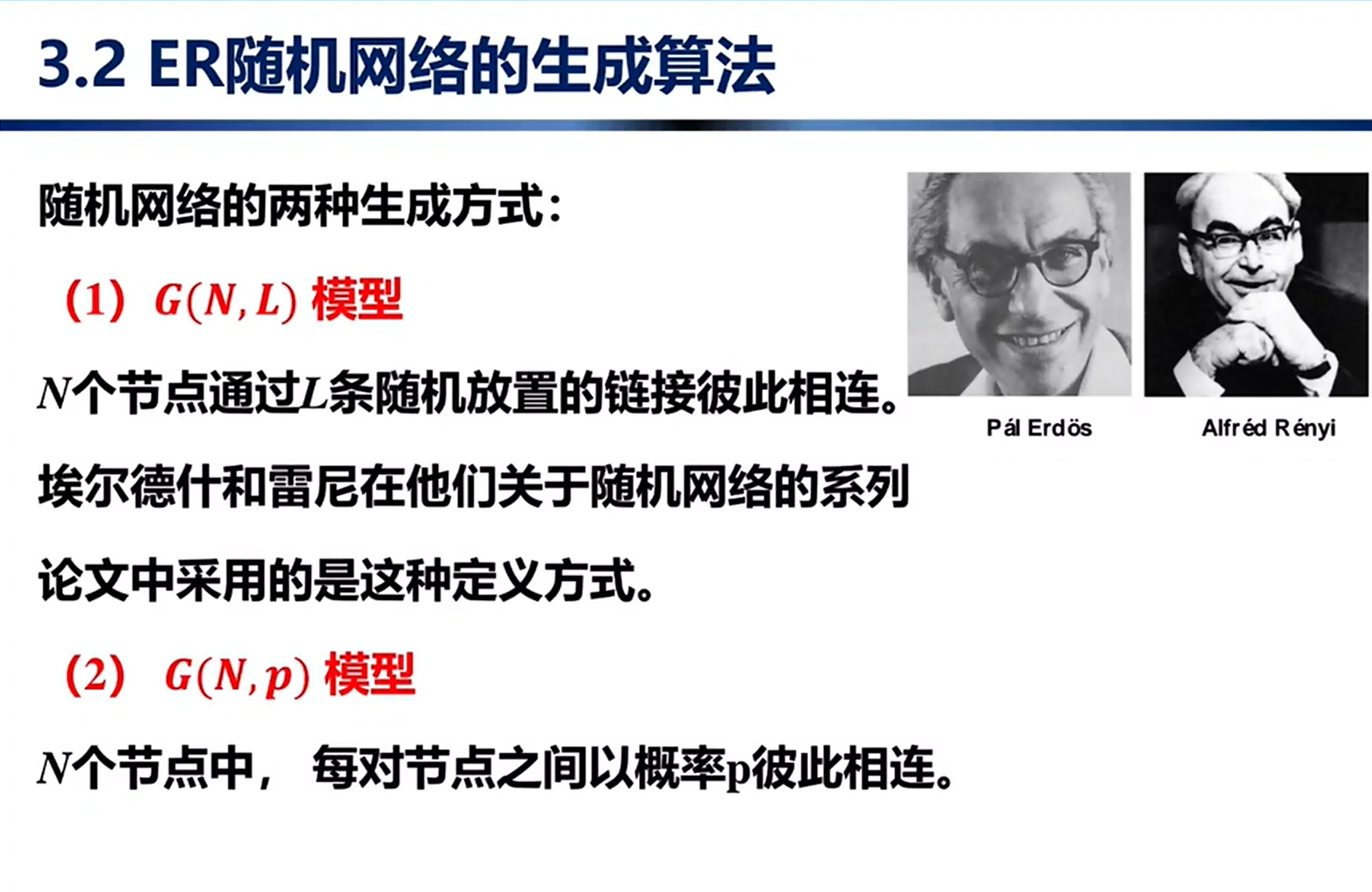

1、人体头部的二维成像知识

我们发现,学素描的人掌握了人头的比例、透视知识后,可以根据真人,很逼真的画出人脸在各个角度朝向的头像。这是因为,在他们的脑海里面,已经形成了一个既定的人头在各个角度的二维透视模型。如下图:

如上图,如果把人头简化为一个长方体,那么正脸就是没有厚度的长方形,侧脸就是厚度不同符合透视规律的的二维投影:

同时,由于真实的人脸,眼睛、鼻子、嘴等是有一些规律特征的,素描上面简称为“三庭五眼”:

我们可以通过人脸特征模块检测一下一张正脸,人脸的比例基本符合以上“三庭五眼”的规律:

根据以上的透视和固定比例原理,我们可以初步的对一张正面人脸进行分割后,相应调整各图形,可以得到了转侧脸的效果,如下图所示:

以上是笔者初步用三角分割后根据透视原理调整的人脸图像,可以感觉这个人脸有点侧过来了,当然看起来不是非常的自然,但是,要清楚的是,这里我们并未用到海量的图片样本,和高深的深度学习算法,仅仅用了入门级的人体头像透视原理和图像基本变换的算法而已,计算的成本几乎微乎其微。我们可以看见,以上利用先验的透视知识结合图像的局部仿射变换实现人脸微运动的方案是可行的。接下来,来实现计算机自动化处理:

2、用特征点驱动的方法实现侧脸

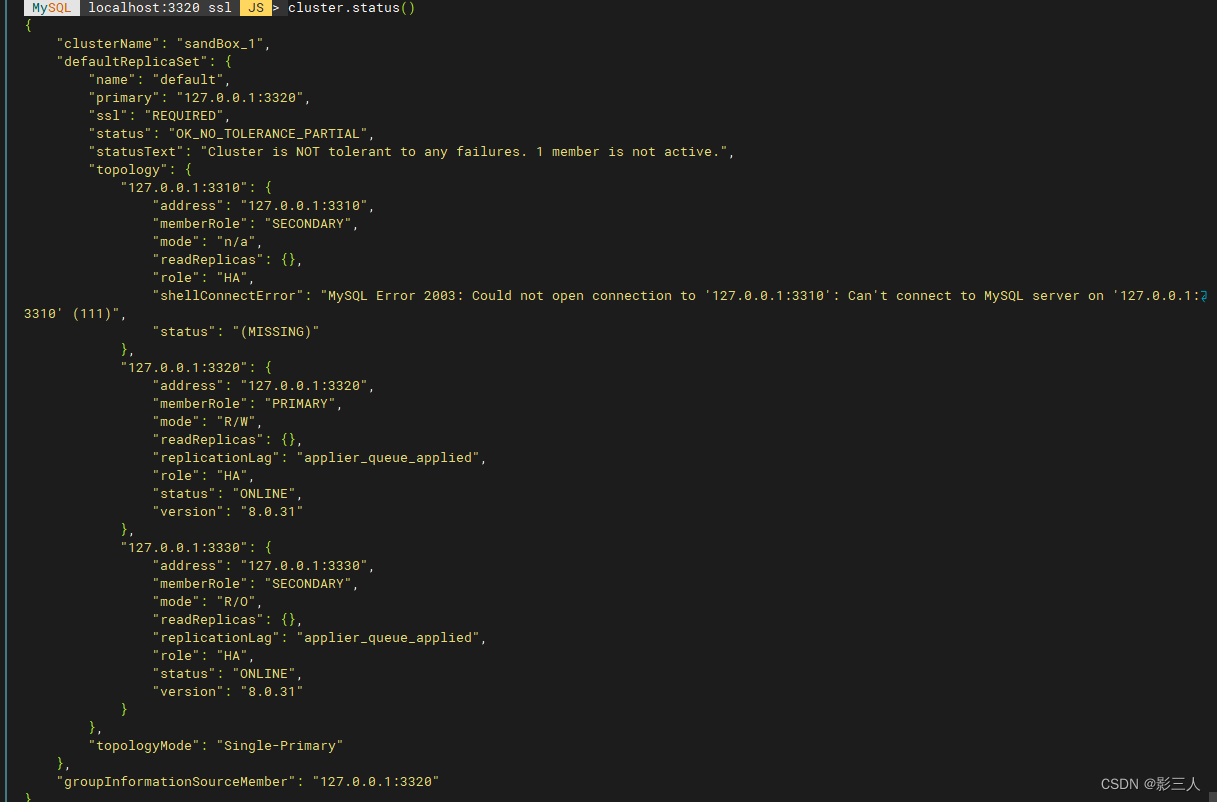

根据以上的分析,我们可以先尝试用一种摄像头实时采集特征点的方法用以定位两张人脸的特征,然后根据头部器官的先验知识进行适当的特征点扩展,就可以快速实现一张图片的人脸旋转跟随运用动!效果如启示的动图。

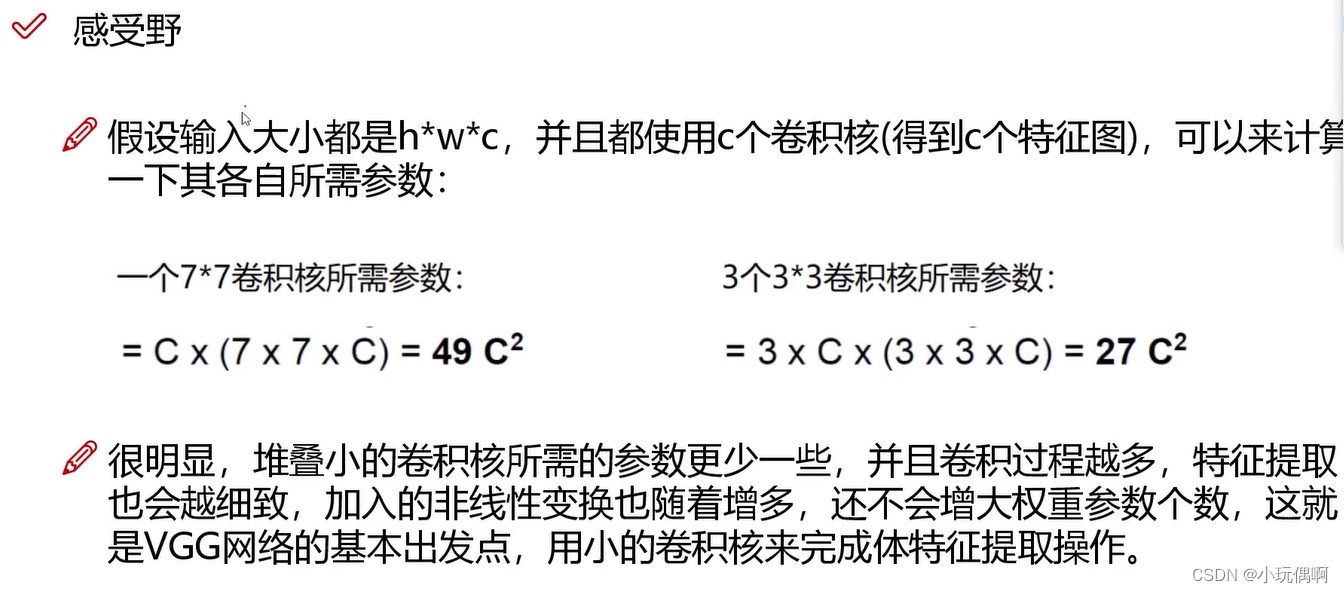

主要的设计思想如下:

2.1python核心代码

face_avatar=cv2.imread("facea.png")

print("计算avatar特征点...")

points_avatar,face_landmarks_list=ffeature_detect(face_avatar.copy())

print("计算完成...共检测到 %s个点"%len(points_avatar))

if len(points_avatar)<=0:

print("退出程序")

exit()

print("计算avatar三角剖分结构...")

tri=get_tri(points_avatar)

tri_avatar=getP_by_tri(points_avatar,tri)

avatar_output= face_avatar

while True:

#clock.tick(0.1)

ticktak+=1

ret, frame = video_capture.read()

small_frame = cv2.resize(frame, (0, 0), fx=1, fy=1)

rgb_frame = small_frame[:, :, ::-1]

firstloop=True

print("avator computing")

points_frame,lendmarks=ffeature_detect(rgb_frame.copy())

print("计算完成...共检测到 %s个点"%len(points_frame))

tri_frame=getP_by_tri(points_frame,tri)

avatar_output=do_avatar(face_avatar.copy(),rgb_frame.copy(),tri_avatar,tri_frame)

small = cv2.resize(frame, (0, 0), fx=1/6, fy=1/6)

cv2.imshow('huzi', small)

cv2.imshow('avatar', avatar_output)

三、后续工作

到此,主要给出了基于一张照片的驱动方法,主要测试了利用人脸实时特征点的进行avatar的驱动,实现了初步的驱动效果。但是,这远远不够,如果真正应用,还有很多需要优化的地方比如:

(1)实时特征点检测的抖动问题

(2)avatar的人脸的相貌变化问题

(3)头发、脖子显示问题

(4)背景分离问题

…

这些工作我们再继续。。。。

![LeetCode[295]数据流的中位数](https://img-blog.csdnimg.cn/img_convert/def2872e75a34ee9a738fabbf5603e7d.png)