文章目录

- 1. 卷积神经网络

- 1.1 卷积神经网络的基础

- 1.2 卷积神经网络和传统的网络的区别

- 1.3 卷积的作用

- 1.3.1 图像颜色通道

- 1.3.2 卷积的次数

- 1.4 卷积层涉及的参数

- 1.4.1 滑动窗口的步长

- 1.4.2 卷积核的大小

- 1.4.3 边缘填充

- 1.4.4 卷积核的个数

- 1.4.5 卷积参数共享

- 1.5 池化层

- 1.6 整体网络架构

- 1.6.1 经典网络-Alexnet

- 1.6.2 Vgg

- 1.6.3 Resnet

- 1.7 感受野

- 2. 卷积网络参数定义

- 2.1 卷积网络的参数定义

1. 卷积神经网络

1.1 卷积神经网络的基础

- CV领域发展

- 检测任务

- 分类和检索

- 超分辨率重构

- 医学任务

- 无人驾驶

- 人脸识别

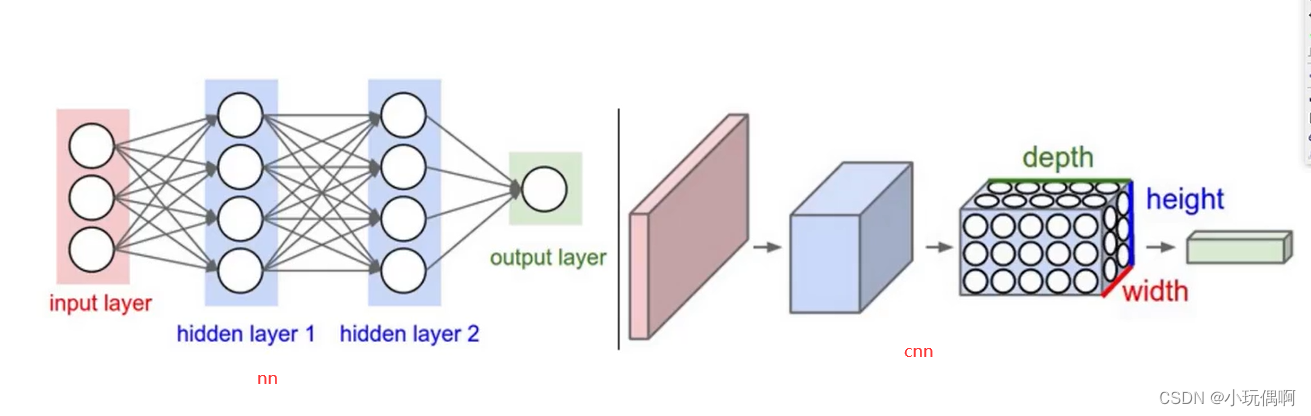

1.2 卷积神经网络和传统的网络的区别

传统网络:像是一个二维

卷积神经网络:像是一个三维的 h * w *c

具体架构

卷积层:提取特征

池化层:压缩特征

1.3 卷积的作用

首先将图整体分割成很多小的区域, 目的是很多小的区域得到的特征值是不一样的,计算每个小区域得到的特征值的大小具体是多少

绿色的叫 执行一次卷积得到的特征图 Filter-Map

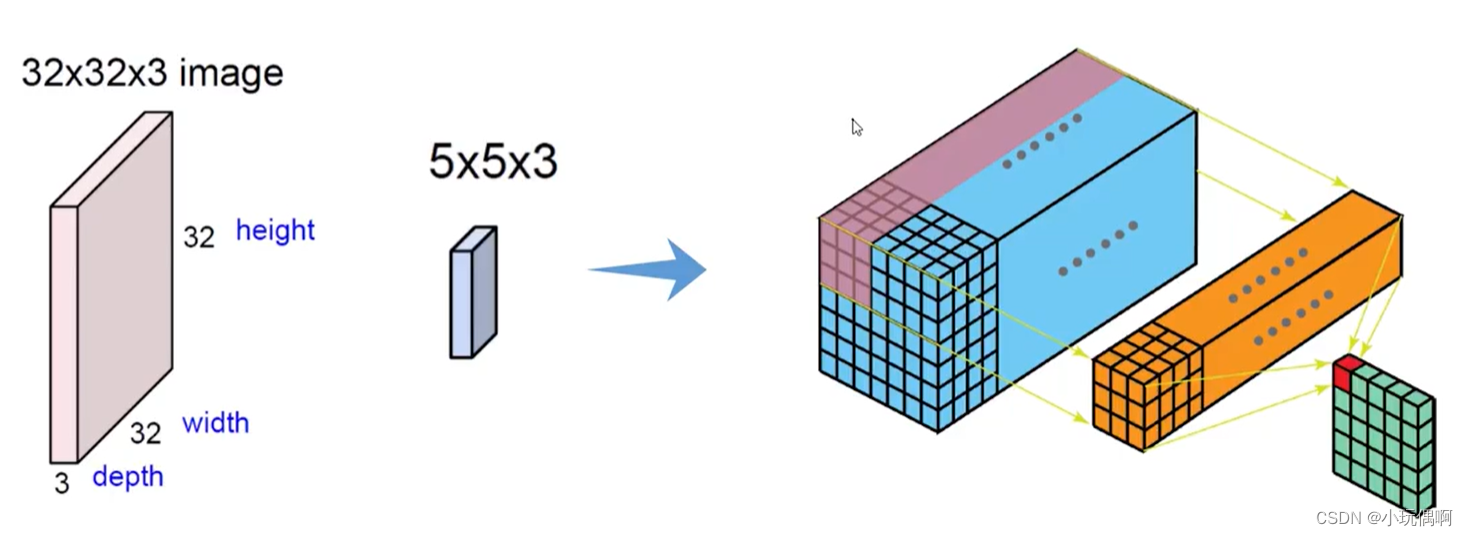

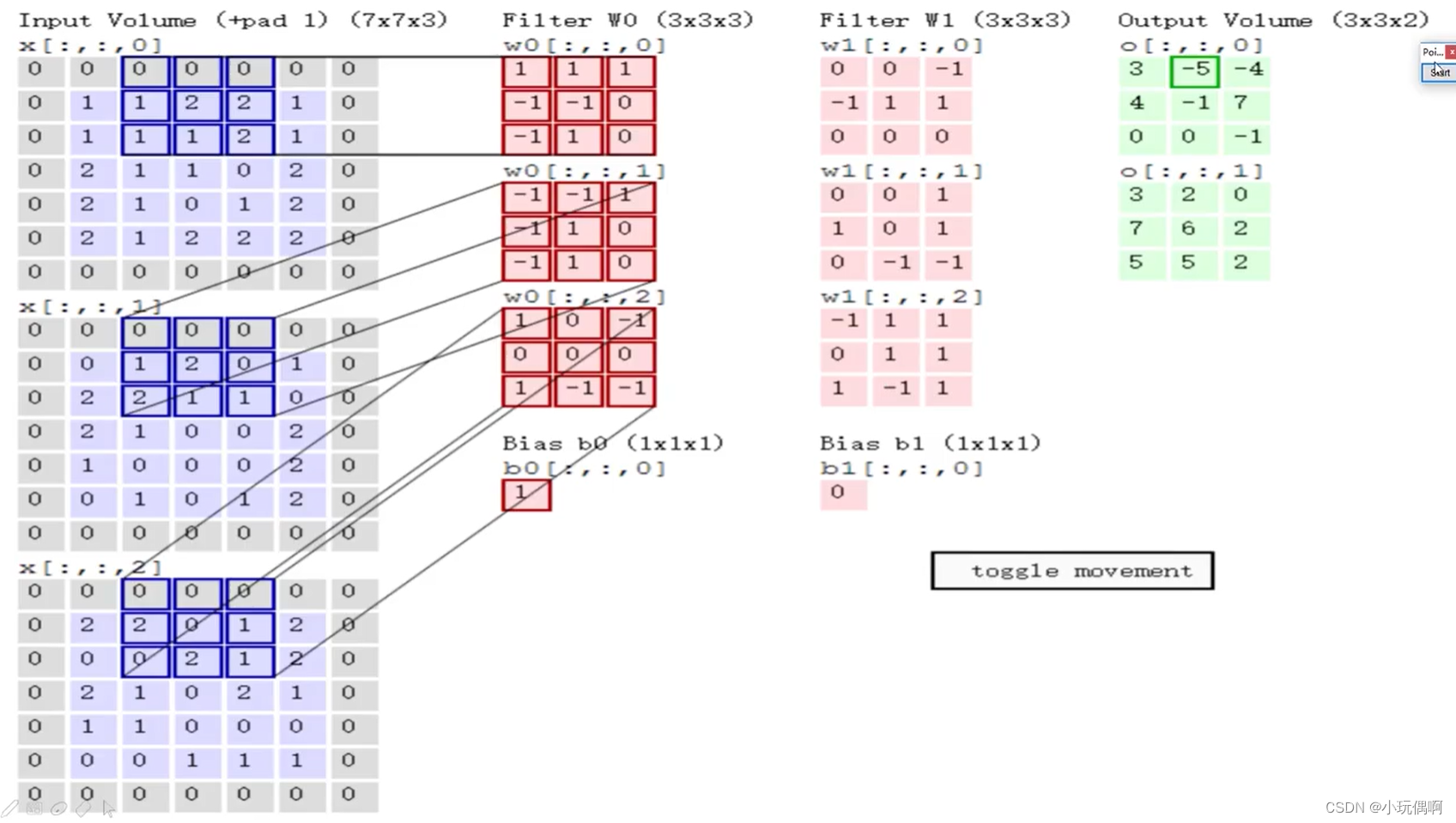

1.3.1 图像颜色通道

多通道分别去做相同的事 比如RGB

特征图的个数可以是多个,所起的作用是让特征结果更加丰富

Fileter中的w* h称为卷积核,代表在原始图像中选择多大的区域 得到特征值

所有的卷积网当中,都是用内积计算的(所有记过相乘,再相加

最终结果0+2+0 这是Filter,然后在加上Bias(偏置) b=1 最终等于3

与上面第一张操作是一样的

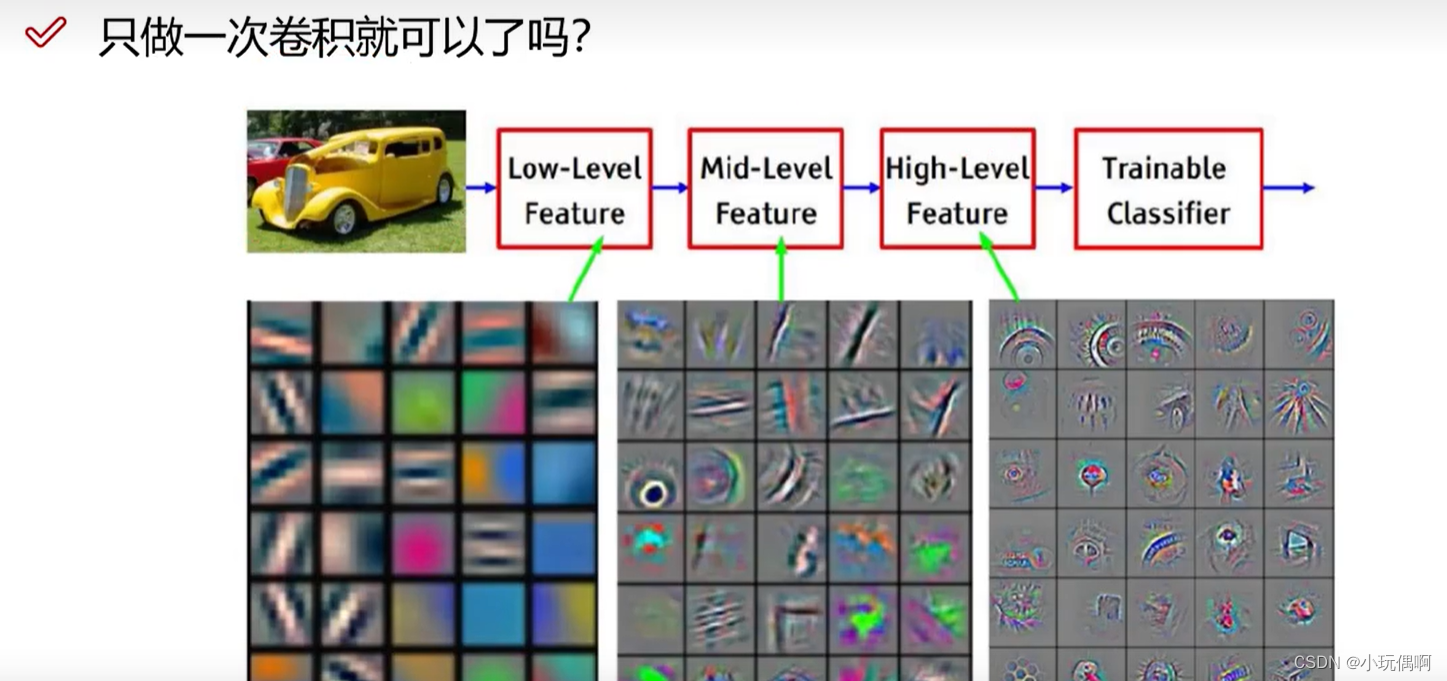

1.3.2 卷积的次数

卷积核的第三个值与前面输入的值一定是一样的

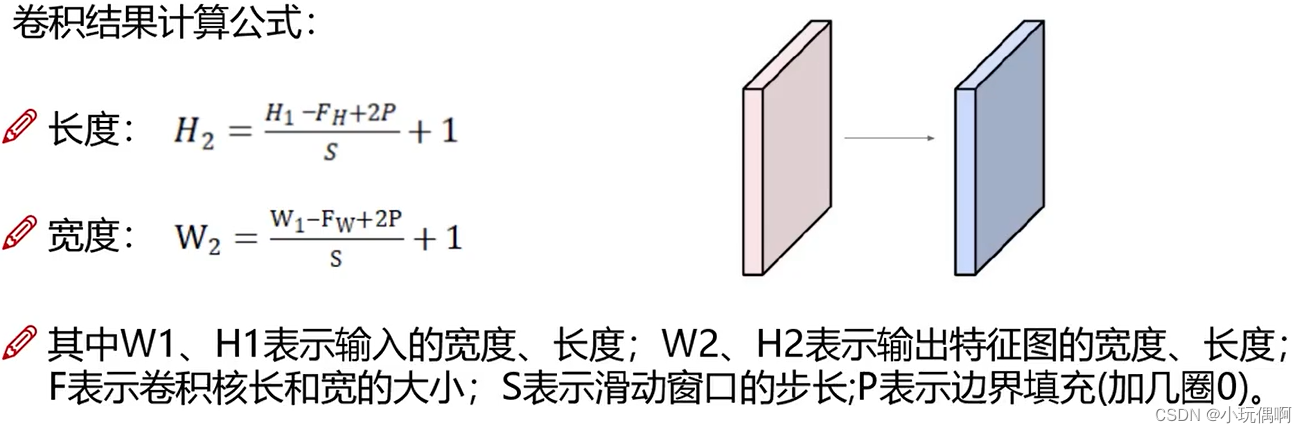

1.4 卷积层涉及的参数

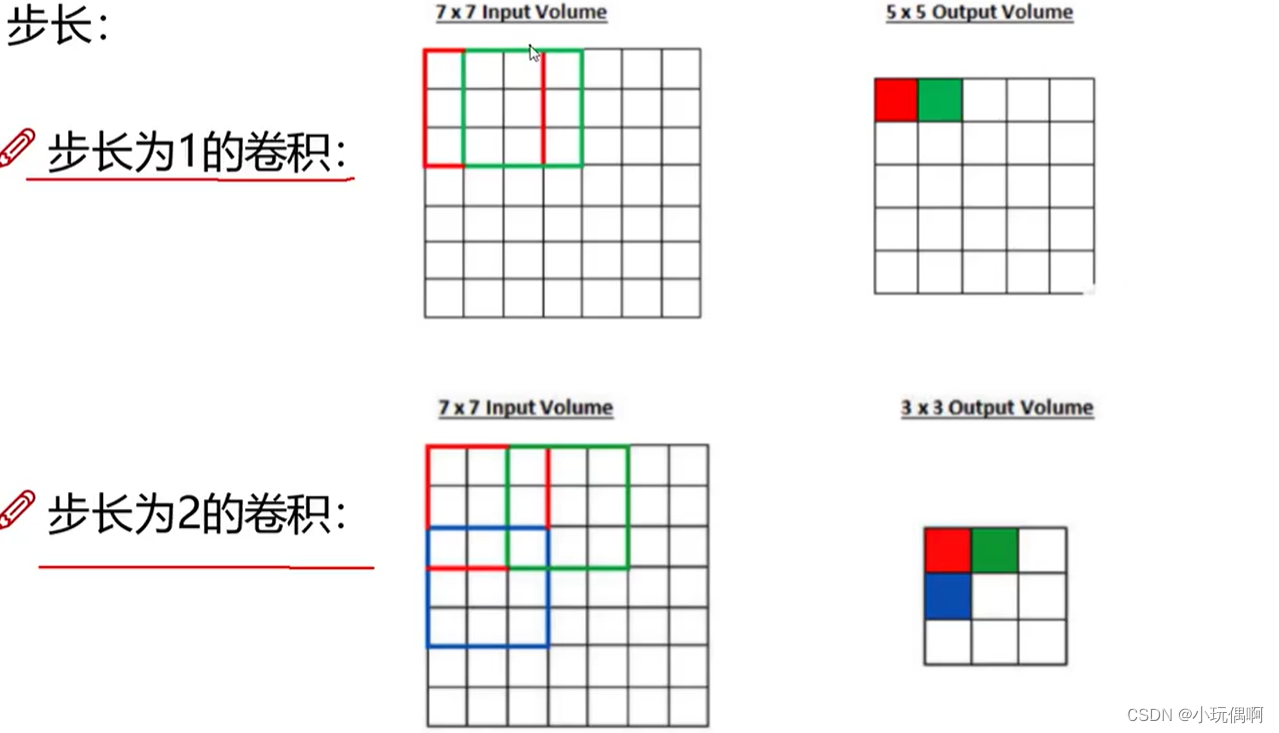

1.4.1 滑动窗口的步长

移动的窗口越多,特征值也就比较丰富,得到的特征图也就越大。

1.4.2 卷积核的大小

卷积核最常见的是3*3 步长为1

1.4.3 边缘填充

+pad 1 填充一圈

越往边界的点,被计算的次数越少。因此 保证边界点利用次数和内部的点的次数一样,进行了边缘填充

为啥要填充0 因此0和任何数字相乘都是0 对最终结果没有影响

一般填充一圈

1.4.4 卷积核的个数

最终计算中,得到的特征图的个数

卷积核中的数据都是不一样的

1.4.5 卷积参数共享

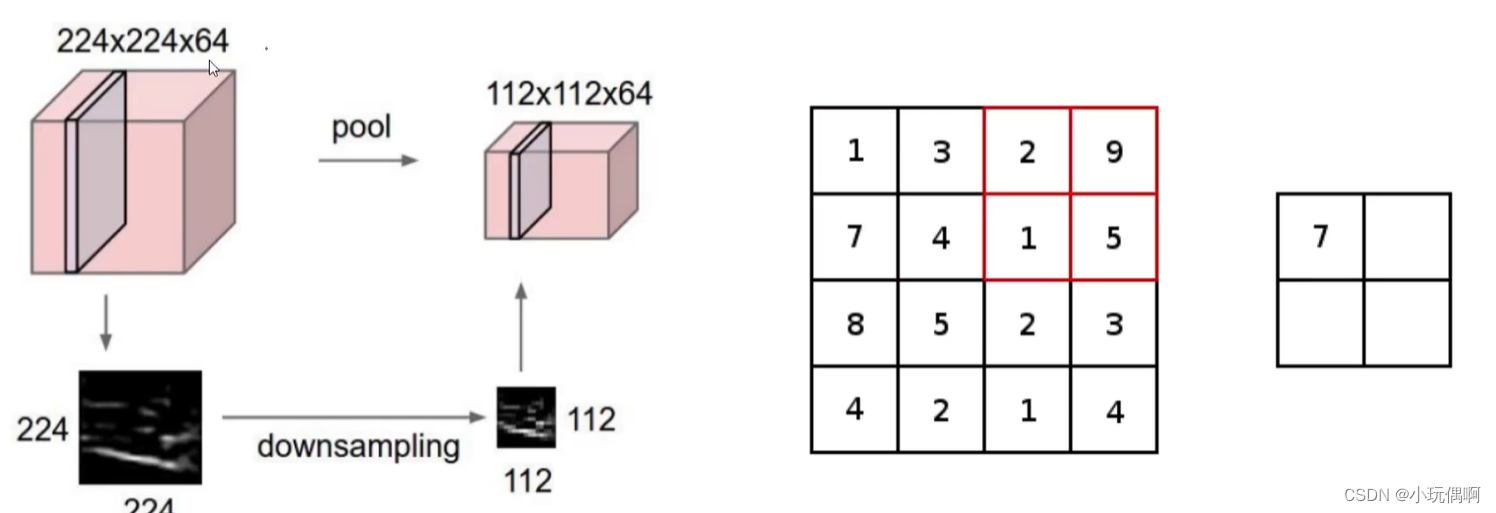

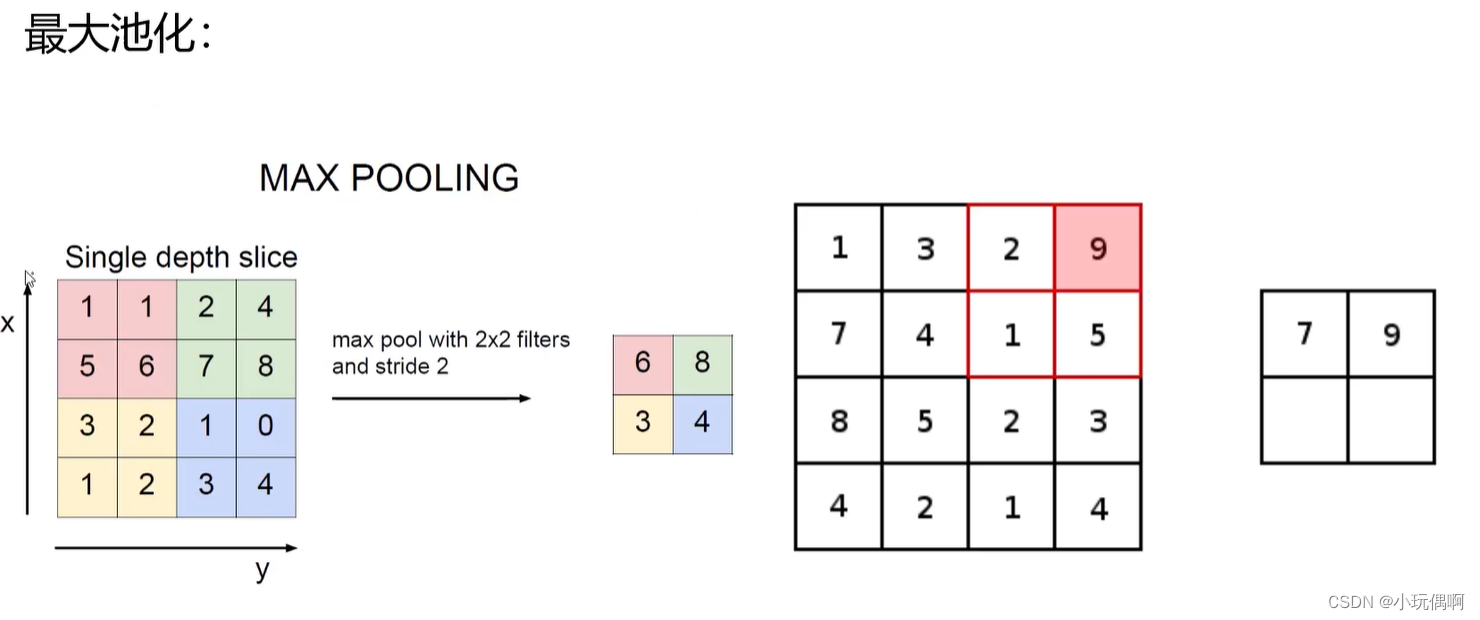

1.5 池化层

将卷积层得到的特征进行压缩(向下 采样)筛选出有意义的值

只是会将特征组的长和宽进行改变,个数不进行修改

只选大的值

还有平均池化(基本使用最大池化)

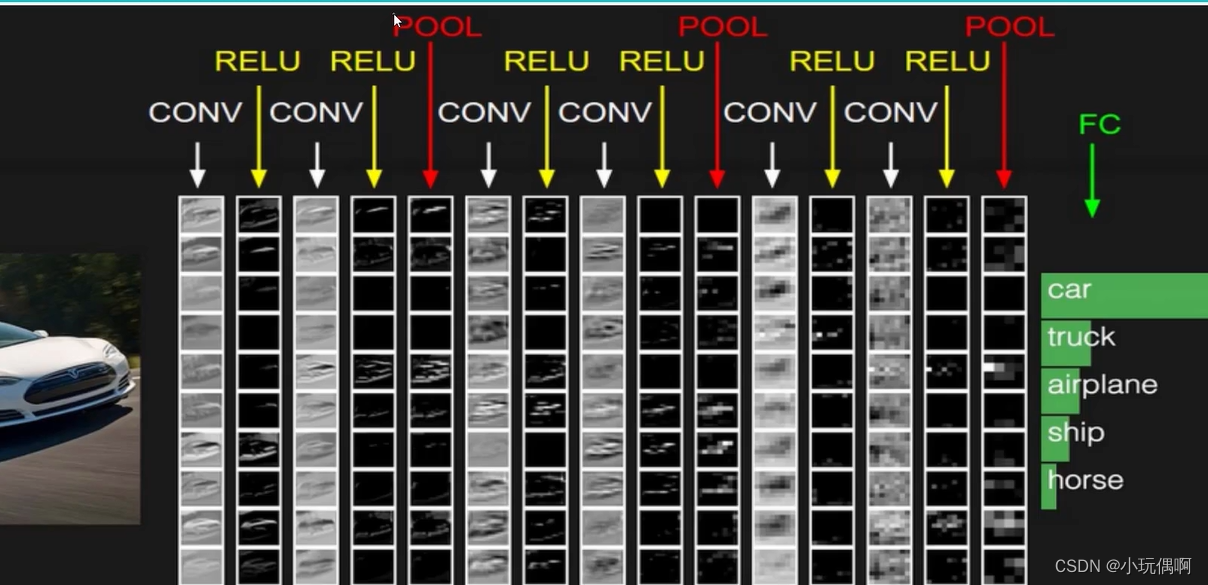

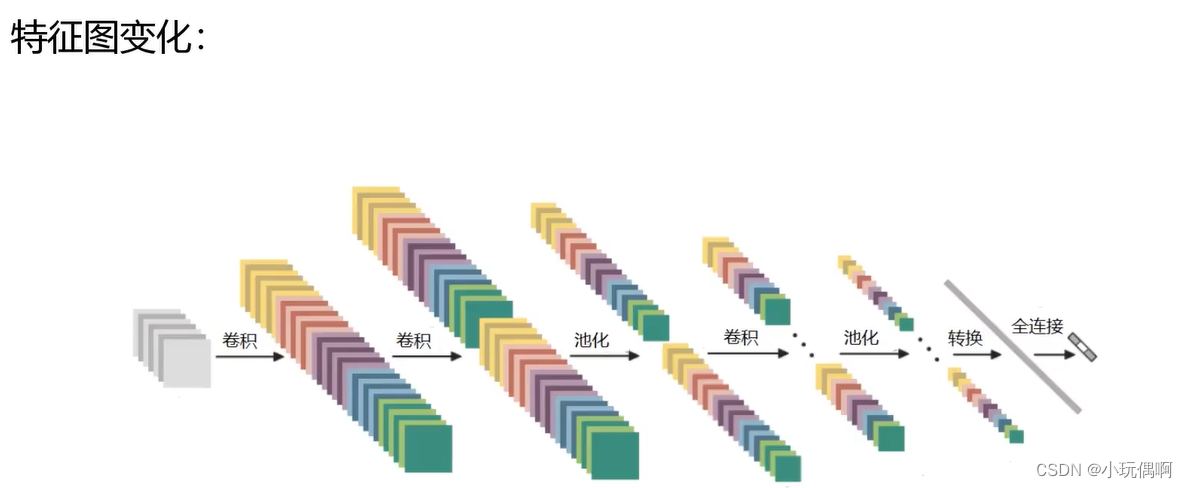

1.6 整体网络架构

基本上是两次卷积一次池化

带参数计算的才可以叫做一层

所以上面有7层 (6层卷积+1层全连接)

转换的意思是将最终得到的特征图,变成一维的特征向量,进而进行全连接

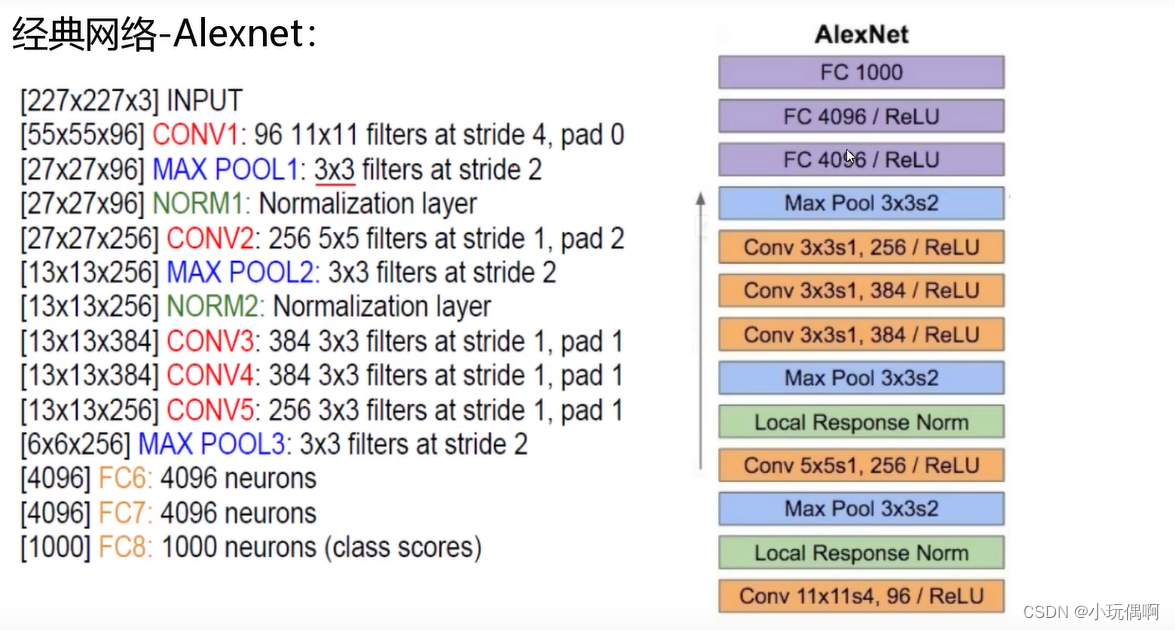

1.6.1 经典网络-Alexnet

filters 11*11 太多了

1.6.2 Vgg

所有卷积层大小都是3*3

vgg有16层到19层

卷积核比较小

那为什么不进行层数的增加呢???

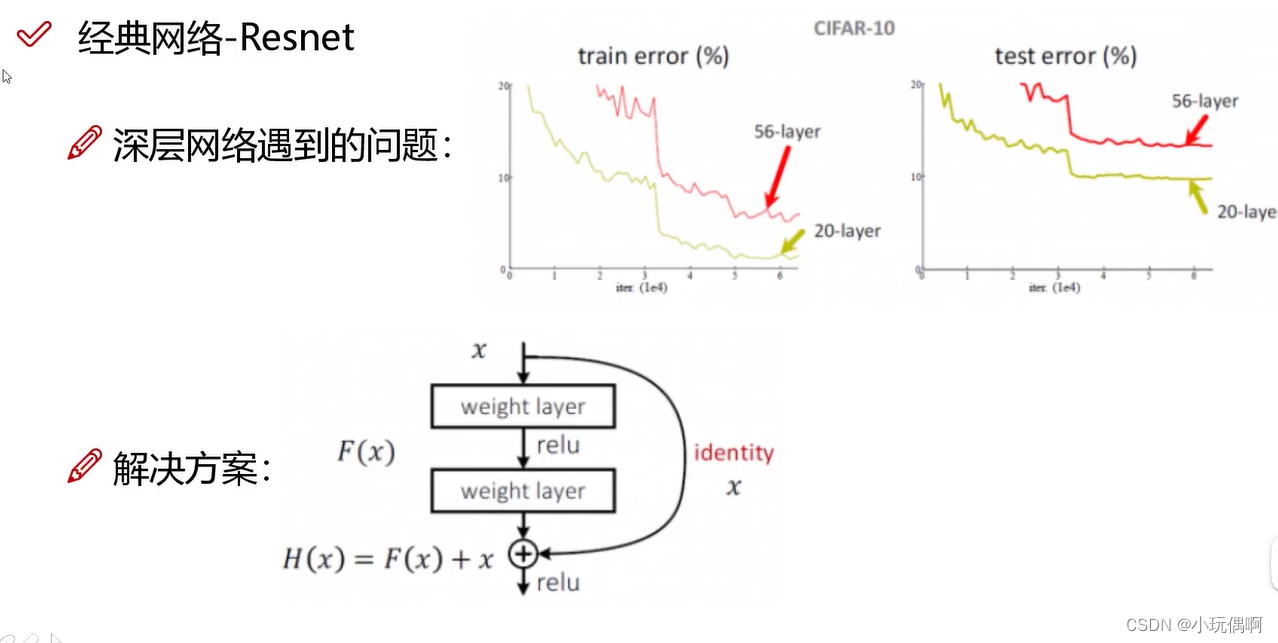

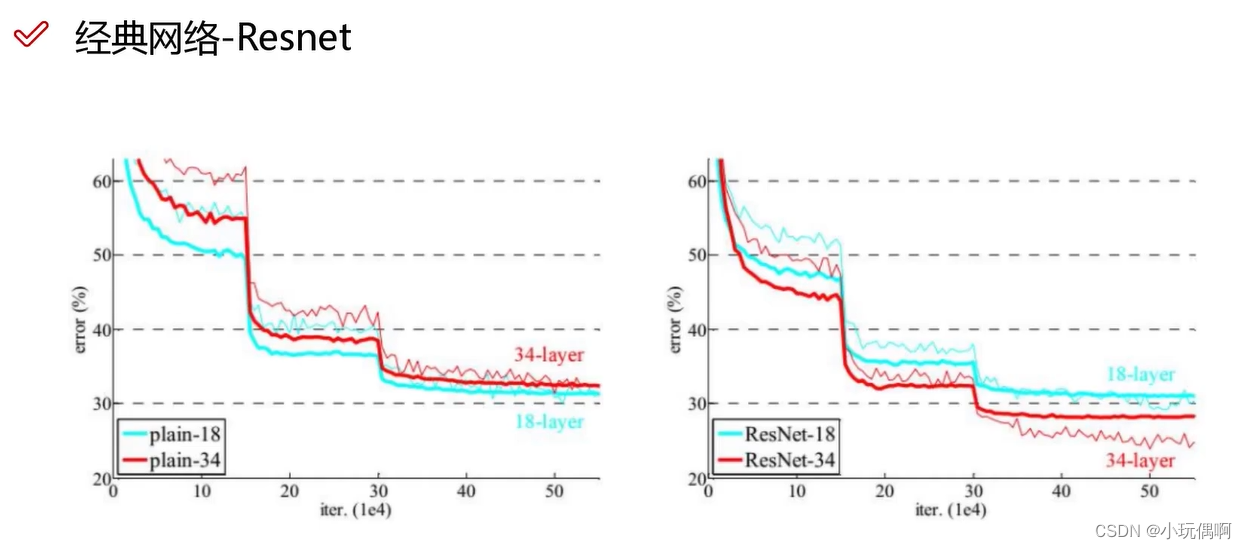

1.6.3 Resnet

将效果不好的层跨过,直接连接下一层

残差网络,层数越多效果一定比层数少的效果好,但是提升程度比较小

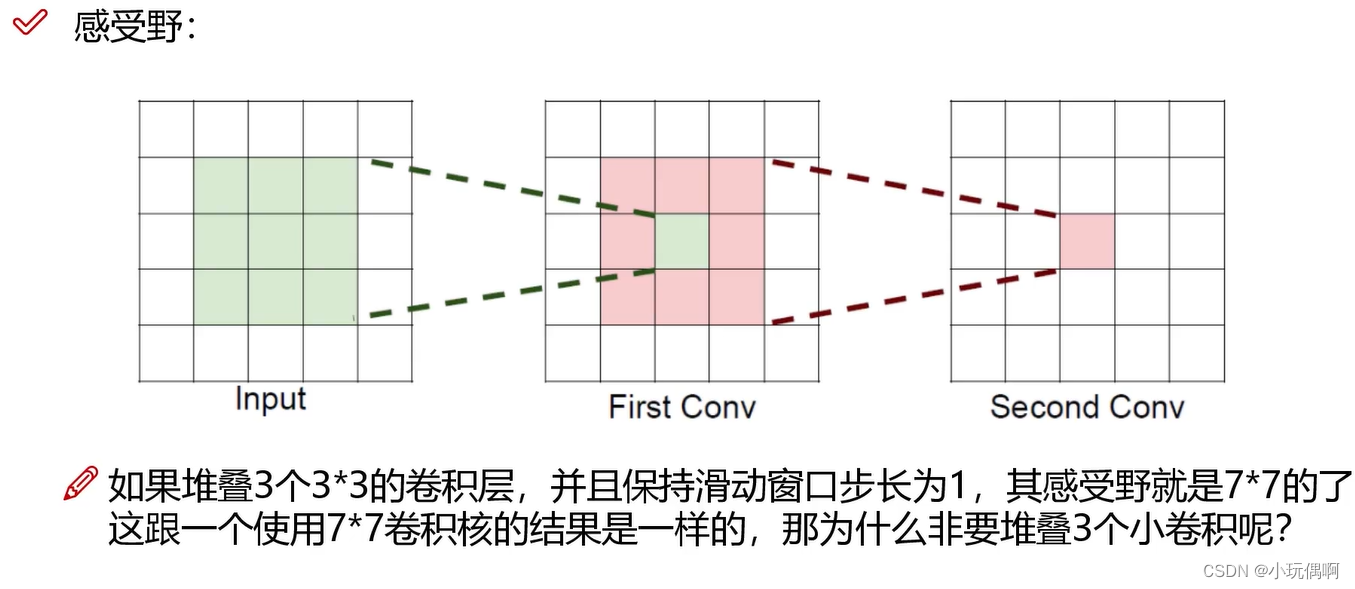

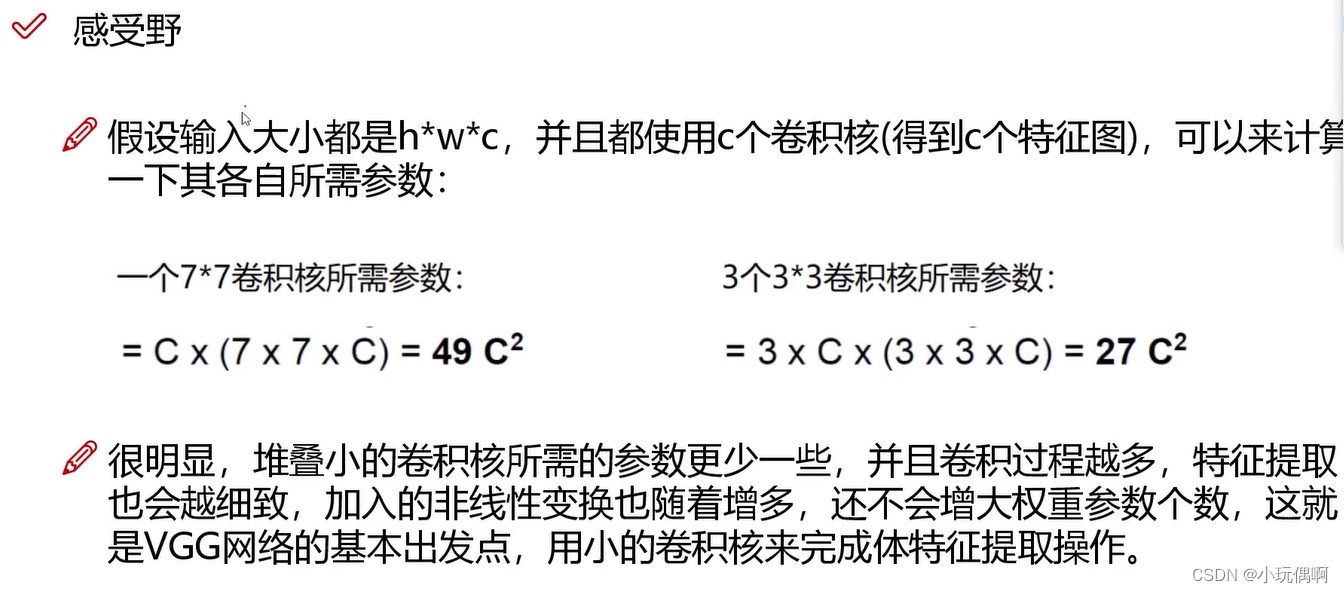

1.7 感受野

感受野希望越大越好

- 那为什么不用大的卷积核进行卷积运算?

- 三个小的比一个大的 参数用的少,风险小,效率高,错误率更小