摘要

知识图嵌入(KGE)旨在将实体和关系表示为低维向量,用于许多现实世界的应用。实体和关系的表征是通过对比正负三联体来学习的。因此,高质量的阴性样品在KGE中是非常重要的。然而,目前的KGE模型要么依赖于简单的负抽样方法,这使得难以获得信息丰富的负三胞胎;或者采用复杂的对抗方法,这需要更多的训练数据和策略。此外,这些方法只能使用现有实体构造负三元组,这限制了探索更困难的负三元组的潜力。为了解决这些问题,我们采用混合操作为知识图生成更难的负样本,并引入了一种廉价但有效的方法MixKG。从技术上讲,MixKG首先提出了两种标准来过滤采样阴性中的硬阴性三联体:基于评分函数和基于正确的实体相似度。然后,MixKG通过配对选择的硬阴性的凸组合合成更硬的阴性样品。在两个公开数据集和四种经典KGE方法上的实验表明,MixKG算法优于以往的负抽样算法。

1.介绍

目前大多数KG嵌入模型使用均匀采样来生成假三联体[Bordes等,2013;Trouillon等人,2016;Yang et al ., 2014]。均匀抽样是随机选取具有等概率的候选实体,简单有效,但只选取固定分布的样本。一些开创性的工作试图从动态分布中提取负样本。IGAN [Wang et al ., 2018]和KBGAN [Cai and Wang, 2018]引入生成式对抗网络来选择高质量的负样本,而NSCaching [Zhang et al ., 2019]利用基于缓存的机制来更多地关注高质量的负样本。不同的是,SANS [Ahrabian等,2020]将图结构信息吸收到负采样过程中,获得了更高的性能。虽然这些工作从不同方面对负抽样机制进行了优化,但这些模型仍然存在一个共同的缺点:这些模型只能选择预先存在的实体来构建负样本,这限制了对更难的负三联体的探索。

目前大多数KG嵌入模型使用均匀采样来生成假三联体[Bordes等,2013;Trouillon等人,2016;Yang et al ., 2014]。均匀抽样是随机选取具有等概率的候选实体,简单有效,但只选取固定分布的样本。一些开创性的工作试图从动态分布中提取负样本。IGAN [Wang et al ., 2018]和KBGAN [Cai and Wang, 2018]引入生成式对抗网络来选择高质量的负样本,而NSCaching [Zhang et al ., 2019]利用基于缓存的机制来更多地关注高质量的负样本。不同的是,SANS [Ahrabian等,2020]将图结构信息吸收到负采样过程中,获得了更高的性能。虽然这些工作从不同方面对负抽样机制进行了优化,但这些模型仍然存在一个共同的缺点:这些模型只能选择预先存在的实体来构建负样本,这限制了对更难的负三联体的探索

- 据我们所知,我们是第一个使用KGs中不存在的实体构造负三元组的人。

- 我们开发了选择硬负样本的两个标准:基于分数函数的选择器和正确的实体相似性选择器。

- 我们通过混合成对选择的硬底片来生成更硬的底片,以使模型更容易区分。

- 我们在不同的数据集和KG嵌入模型上进行了大量的实验,从不同的方面证明了所提出模型的有效性。

2 Related Works

2.1 Negative Sampling

负抽样的目的是生成负样本,因此可以通过区分观察到的正数据和负样本来训练模型。负抽样的优点是放弃了通过抽样计算归一化常数,提高了效率和有效性。从抽样类型来看,负抽样可分为两类:固定负抽样和动态负抽样。

Fixed negative sampling

固定负抽样是一种经典的抽样策略,其思想简单直观。固定负抽样有两种代表性方法:均匀抽样[Bordes et al ., 2013]和伯努利抽样[Wang et al ., 2014]。然而,由于固定采样限制的限制,固定采样策略无法形成较硬的负样本。并遭受梯度消失[Cai and Wang, 2018]。

Dynamic negative sampling

针对固定负抽样存在的问题,提出了将固定分布的负抽样扩展到动态分布的开创性工作。KBGAN [Cai and Wang, 2018]和IGAN [Wang et al ., 2018]尝试吸收生成对抗网络来生成高质量的负三元组。然而,KBGAN和IGAN都是以牺牲不稳定性和退化为代价来获得有效性的[Zhang et al ., 2019]。为了在获得高质量负样本的同时降低模型的复杂性,NScaching [Zhang et al ., 2019]使用缓存来存储负三元组。此外,SANS [Ahrabian et al ., 2020]将负采样中的图结构信息以kg为单位,然后仅从头部或尾部实体的l-hop邻域动态选择负样本。虽然这些方法试图从不同的方面生成高质量的负样本,但它们都有一个共同的缺点:负样本只使用预先存在的实体生成。

2.2 Mixing Method

混合[Zhang et al ., 2017]是一种数据增强方法,通过对样本的凸组合生成新数据。从本质上讲,混合鼓励模型在训练样本之间表现为线性。混合方法在许多应用中显示出其优越性[Lee et al ., 2020;Zhang等,2020;Yoon et al ., 2021]。总的来说,有两种流行的混合领域:监督学习的混合和负样本的混合。

Mixing for supervised learning

Mixup [Zhang et al ., 2017]通过线性插值生成虚构的训练样本及其相关标签,实验结果表明Mixup普遍适用于图像、语音和表格数据集。SSMix [Yoon等人,2021]和MixText [Chen等人,2020]分别通过输入和隐藏空间混合将混合操作扩展到自然语言处理领域。

Mixing for hard negative samples

混合的核心思想是通过线性插值构造虚拟样本,因此一些研究者将混合用于难度较大的负挖掘。MixGCF [Huang et al ., 2021]使用正混合和啤酒花混合获得高质量的负样本,在推荐场景下达到更高的性能。MoCHi [Huang et al ., 2021]表明,将硬负样本与标签混合可以获得更硬的负样本。

3 Mix for Harder negative triplets

在本节中,我们将详细介绍所提出的方法。需要注意的是,本文提出的通过混合操作生成更硬负样本的方法与模型无关,因此它是一个通用框架,可以很容易地插入到现有的KGE模型中。

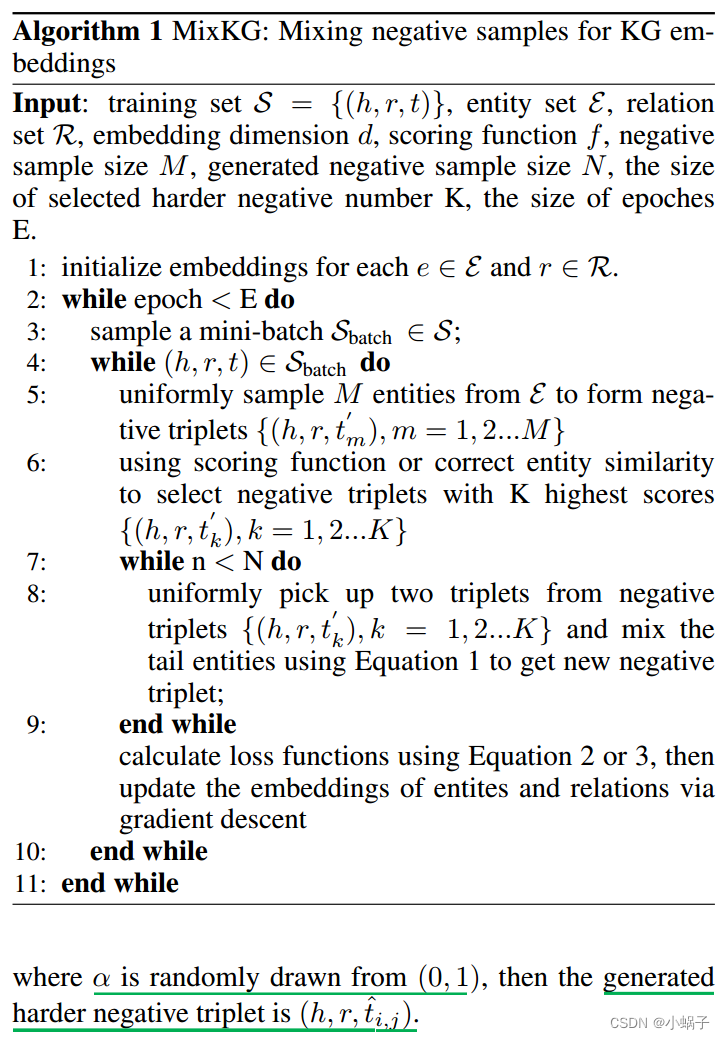

该模型的核心可分为两个步骤:首先,从采样的负三组中选择高质量的负三组;第二,混合成对的高质量负三胞胎,然后产生新的更难的负三胞胎。

3.1 Select hard negative triplets

在kg中,只有真三胞胎作为正样本,负三胞胎可以用从整个实体集中采样的其他实体替换真三胞胎中的头或尾实体来获得。然而,正如之前的作品[Zhang et al, 2019;Ahrabian等人,2020],许多采样的负三元组不能提供判别信息来帮助模型学习实体和关系的有效嵌入。只有少量的负样本有助于模型向正确的方向收敛,这些样本是硬负样本,是本文方法中混合的原材料。

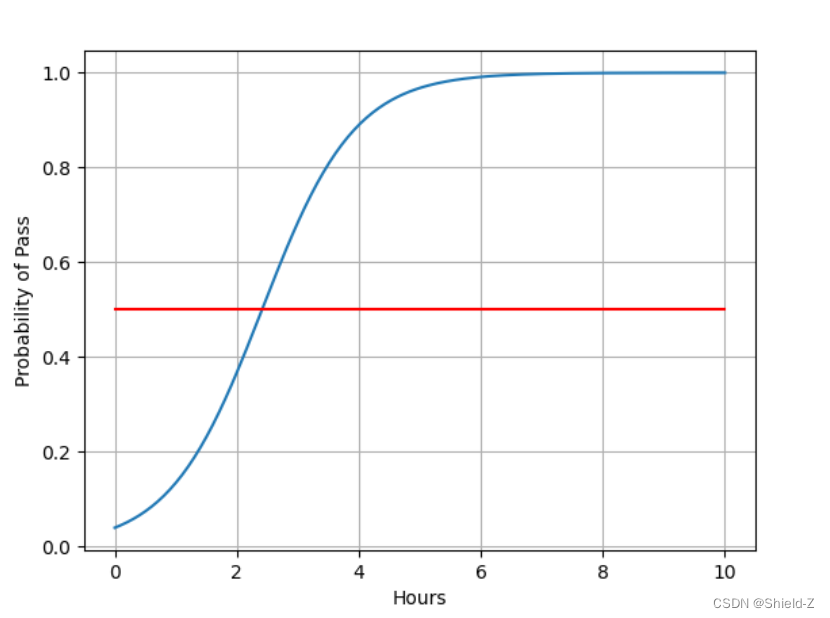

硬负样本是该模型的核心,但如何定义硬负样本仍然是一个问题。之前的几部作品[Zhang et al ., 2019;Kalantidis et al ., 2020]使用分数函数f,将得分较高的负三组作为硬负样本,我们将这种方法称为基于分数函数的硬负样本(HNS-SF)。然而,这个定义只考虑了负集中的负样本,而忽略了真三元组的帮助。因此,我们引入了硬负样本的不同定义,该定义将与正确的头或尾实体更相似的候选实体视为硬负样本。我们将这种硬负样本定义命名为基于正确实体相似度的硬负样本(HNS-CES)。

需要注意的是,我们以破坏尾部实体为例,通过破坏头部实体生成负样本是类似的。在上述两种定义下,选择负硬样品的具体过程如下:

3.2 Mixing among these hard triplets

在获得用于混合的硬负三联体后,我们随机选择成对的硬负三联体,然后混合尾部实体生成新的硬负样本。准确地说,假设有两个负三元组![]() ,则新生成的硬负三重体的尾部实体为

,则新生成的硬负三重体的尾部实体为![]()