文献:Robust Task Offloading in Dynamic Edge Computing

本文介绍了一种新的动态边缘计算模型,并首次研究了容忍h服务器故障的鲁棒任务卸载。提出了在线原始对偶算法,在任务到达时卸载任务。

一、介绍

动态边缘计算(DEC)模型:研究了一个新的鲁棒任务卸载问题,当多达h个边缘服务器发生故障时,该问题可以保证任务的执行,其中h是一个用户定义的参数。

在线原始对偶算法,在任务到达时卸载任务,并分析它们的竞争比率。

二、准备工作

-

用例–无人机

-

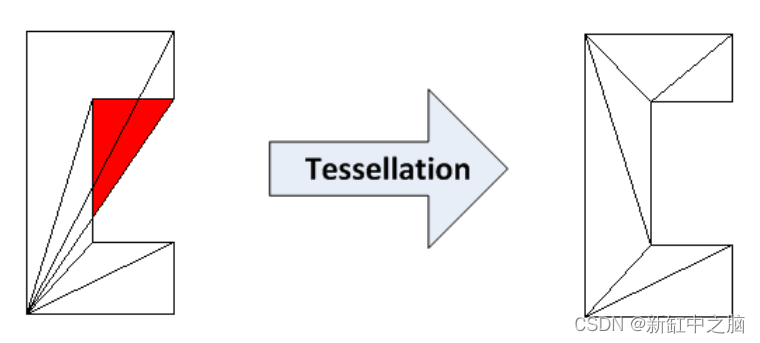

通过边缘动态传输任务

健壮的任务卸载:将中断的任务分配给具有足够资源容量的新边缘服务器。 -

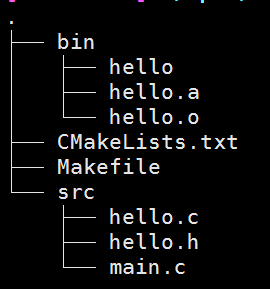

DEC系统模型

动态边缘计算(DEC)系统由生成任务的终端设备、为任务执行提供资源的边缘服务器以及从终端设备接收请求并基于资源可用性将其任务分配给边缘服务器的管理器组成,其中一些端部设备可以充当边缘服务器。 -

通信模型

上行链路传输延迟而言,本文中有两种类型。

一种延迟是终端设备应首先请求运行所提出的鲁棒卸载算法的管理器以获得卸载解决方案。

另一个延迟用于将任务的输入数据传输到指定的边缘服务器。

主要关注的是即使某些边缘服务器出现故障,任务是否可以在边缘服务器上立即执行。

主要考虑任务的资源需求,包括计算资源或其他资源,为最初在故障边缘服务器上执行的任务提供充足的剩余资源。 -

问题陈述

DEC的系统吞吐量定义为成功分配给边缘服务器以立即执行的任务的资源需求总和。

鲁棒任务卸载的问题是将终端设备T分配给边缘服务器P以获得最大系统吞吐量,受限于容量约束,使得分配给任何边缘服务器的任务不应超过服务器的容量,以及鲁棒性约束,使得当多达h个边缘服务器发生故障时,任何分配的任务将被保证执行,其中h是可配置的系统参数。

首先制定一个周期性的离线批量分配策略,管理者将在每个周期开始时安排任务。然后转到在线任务分配策略,任务在到达时安排。

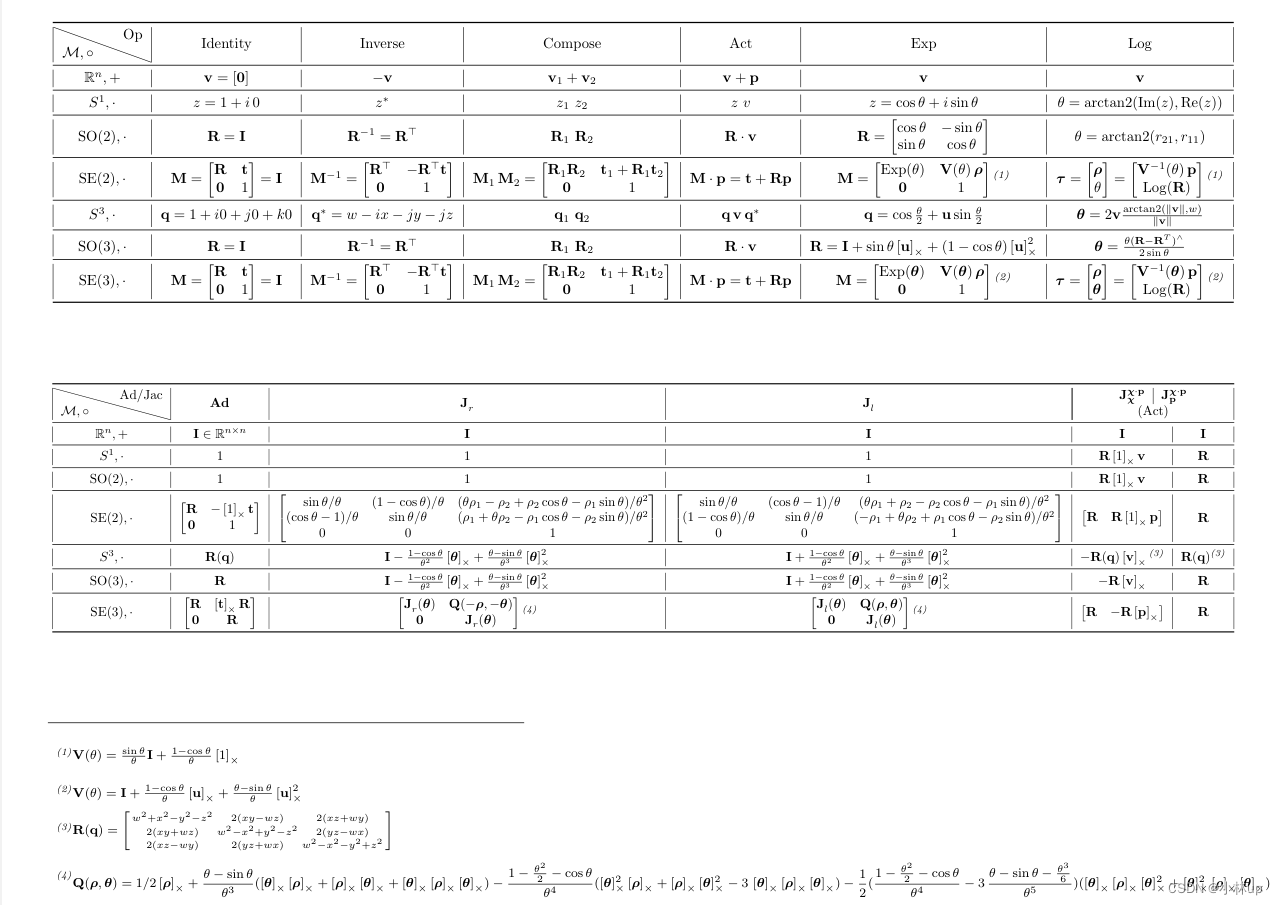

三、健壮的批处理任务卸载

最大化DEC的系统吞吐量:

每个任务ti只能分配给单个(h+1)服务器排列Cj;

每个边缘服务器的负载比不应超过1;

每个边缘服务器上的增量负载不应超过其剩余资源容量。

RTO-TM是NP-hard问题,RTO-TM的解决方案可以抵抗h个边缘服务器故障。

h越大,我们的解决方案就越健壮。h越大,解决方案对边缘服务器资源的利用效率就越低。

四、健壮的在线任务卸载

在线算法,用于h=1的鲁棒任务分配。它在新任务到达时分配新任务,并且可以容忍一个服务器故障。

-

RTO-TM-1问题的在线算法

边缘服务器对,包含用于任务执行的边缘服务器和备份边缘服务器,以在卸载的边缘服务器发生故障时提供足够的剩余资源。 -

性能分析

-

完全原始对偶算法

在线算法应该能够满足每个边缘服务器上的资源约束。否则,可能没有足够的剩余资源用于在故障边缘服务器上执行的任务。 -

扩展到RTO-TM-2问题

-

RTO-TM-h的扩展(h≥3)

-

时间复杂性

对于每个任务:

抵抗1个边缘服务器故障是O(m2)。

抵抗2个边缘服务器故障是O(m3)。

m是边缘服务器的数量。 -

讨论

输入数据的大小也是影响传输延迟的重要参数。

具有大输入数据的任务可能打算在本地执行,从而导致较少的传输延迟。

每个任务ti只能被分配给集合Pi中的边缘服务器,这可以通过仅保持其任务ti的输入数据的传输延迟在阈值内的边缘服务器来定制。

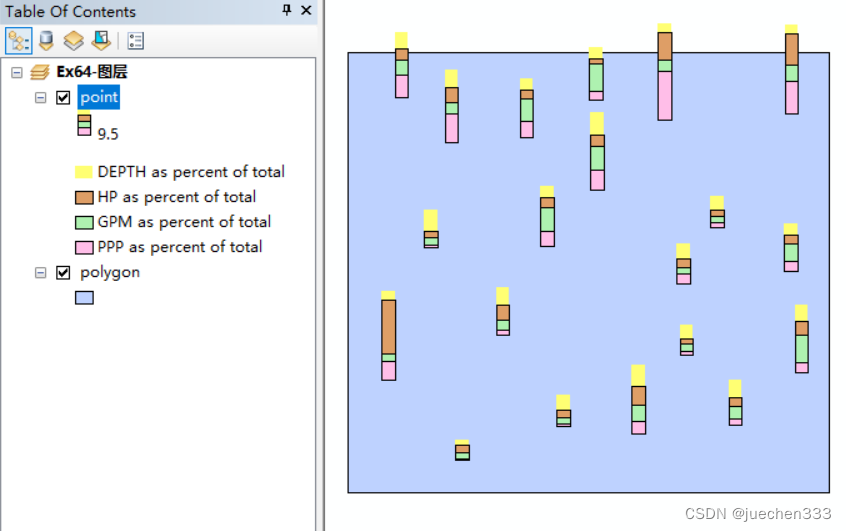

五、性能评估

1、模拟设置

任务集的两种资源:计算资源和内存资源。

计算资源和内存资源的单位是任务使用的平均内核数的归一化值和任务消耗的平均内存的归一化值。

本文任务集将分为两种任务集,即计算强度任务集和记忆强度任务集。

每个边缘服务器的容量被随机设置为所有任务平均资源消耗的30-50倍。

2、绩效方法和指标

基准:

第一种是贪婪算法,其中两个剩余容量较大的边缘服务器将分别被分配为每个任务的边缘服务器和备份边缘服务器。

第二个指标是最佳离线解决方案,表示为Opt-offline。通过使用线性程序求解器中公式化的整数线性程序,可以获得最佳结果。

度量:

第一个度量是系统吞吐量,这意味着DEC中所有接受任务的总负载。

第二个度量是所有边缘服务器之间的负载比率的累积分布函数(CDF)。更高的负载率意味着边缘服务器上的资源利用率更好。

3、系统吞吐量仿真结果

原始对偶算法的性能可以分为两个阶段。

0.05–最佳相位和0.10–下降相位

与贪婪算法相比,原始对偶算法可以容纳更多的任务,并实现更高的系统吞吐量。

随着边缘服务器数量的增加,所有算法的吞吐量都会增加。与PD-0.10和贪婪算法相比,PD-0.05可以有效地卸载任务以减少资源消耗。

4、负载比CDF仿真结果

Opt离线算法导致边缘服务器上的平均负载率最高,这意味着Opt离线可以有效地利用边缘服务器上资源。

贪婪算法无法实现PD0.05和Opt离线那样高的吞吐量。

当所有边缘服务器正常工作时,当一个服务器发生故障时,边缘服务器之间的负载比(除了发生故障的服务器)非常接近。

当一个边缘服务器发生故障时,贪婪算法无法实现公平的任务卸载。当发生边缘服务器故障时,不同边缘服务器上的负载比率变化很大。

PD-0.10的所有边缘服务之间的最小负载,大于贪婪算法的所有边缘服务器之间的最大负载比。

原始对偶算法旨在最大化DEC的吞吐量,同时考虑单边缘服务器故障的情况。

对于内存密集型任务集,PD-0.05算法和Opt-offline可以在所有边缘服务器中实现接近100%的负载比,PD-0.05算法可以在重载DEC下充分利用所有边缘服务器的资源。

5、两个服务器故障下的负载比CDF

- 与Opt离线算法相比,我们的原始对偶算法,特别是PD0.05,可以实现接近最优的系统吞吐量。

- 当所有边缘服务器正常运行时,与贪婪算法相比,我们提出的算法可以保证公平的任务卸载。我们算法的所有边缘服务器之间的最小负载比大于贪婪算法的最大负载比。

- 我们提出的算法适用于DEC中的任务卸载。

6、运行时间

7、实用性评估

互联网共享服务,共享对等设备数据预算的示例

有一个管理器模块,它收集每个任务的资源消耗和每个边缘服务器的数据预算。

当终端设备产生任务时,它会将信息发送给管理器,管理器运行我们的在线任务卸载算法,并计算出分配的边缘服务器和备份边缘服务器。

从发送任务请求到建立到指定边缘服务器的连接的时间称为卸载延迟。

对于边缘动态,边缘服务器可能会出现故障。然后,终端设备将重新连接到备份边缘服务器。重新连接期间的时间称为重新连接延迟。

管理器模块在第三方主机或边缘服务器中运行,这分别对应于有第三方宿主和无第三方服务器的情况。

控制消息的数据使用情况,包括从终端设备到控制器的任务请求、从控制器到终端设备的卸载决策,以及从一个终端设备到一个边缘服务器的连接设置。

六、相关工作

关注于对等端设备的任务执行,而不是边缘或移动云。

MEC任务卸载—激励终端设备提供资源

边缘动态是MEC中的一个重要属性,这可能是由终端设备的移动性或不可避免的设备故障造成的。

七、结论

为了克服边缘服务器的动态性,我们提出了一种抗h(≥1)个边缘服务器故障的鲁棒任务卸载方案,研究了不同h值的问题。

设计了一种基于原始对偶的在线算法,可以很好地处理边缘服务器故障,并实现接近最优的DEC吞吐量。