HADOOP-3.2.2安装

- 一. 准备工作

- 二.安装阶段

- 1. 创建安装目录并安装解压包

- 2.修改配置文件core-site.xml

- 3. 修改hdfs-site.xml

- 4. 修改修改yarn-site.xml

- 5.修改workers文件

- 6.修改hadoop-env.sh

- 7.修改mapred-site.xml

- 8.递归创建目录

- 9.分发文件

- 三.运行阶段

- 1.启动hdfs

- 2.启动yarn

- 3.启动jobHistory

- 四.检查阶段

- 1.hdfs检查

- 2.yarn检查

- 3.历史任务的查看

- 五.DEMO测试

- 六.补充点

一. 准备工作

zookeeper集群安装

从官网下载hadoop-3.2.2.tar.gz

地址:https://hadoop.apache.org/release/3.2.2.html

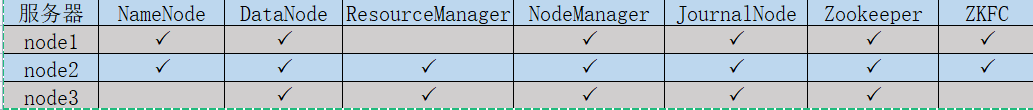

集群规划

二.安装阶段

1. 创建安装目录并安装解压包

上传安装hadoop-3.2.2.tar.gz 包

解压到安装目录(我用的普通用户)

#解压文件

tar -zxvf hadoop-3.2.2.tar.gz -C /app/install

2.修改配置文件core-site.xml

cd /app/intall/hadoop-3.2.2/etc/hadoop

vi /core-site.xml

<configuration>

<!-- 指定NameNode的HA高可用的zk地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>node1:2181,node2:2181,node3:2181</value>

</property>

<!-- 指定HDFS访问的域名地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://ns</value>

</property>

<!-- 临时文件存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/app/install/hadoop-3.2.2/data/tmp</value>

</property>

<!-- 开启hdfs垃圾箱机制,指定垃圾箱中的文件七天之后就彻底删掉

单位为分钟

-->

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

</configuration>

3. 修改hdfs-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /hdfs-site.xml

<configuration>

<!-- 指定命名空间 -->

<property>

<name>dfs.nameservices</name>

<value>ns</value>

</property>

<!-- 指定该命名空间下的两个机器作为我们的NameNode -->

<property>

<name>dfs.ha.namenodes.ns</name>

<value>nn1,nn2</value>

</property>

<!-- 配置第一台服务器的namenode通信地址 -->

<property>

<name>dfs.namenode.rpc-address.ns.nn1</name>

<value>node1:8020</value>

</property>

<!-- 配置第二台服务器的namenode通信地址 -->

<property>

<name>dfs.namenode.rpc-address.ns.nn2</name>

<value>node2:8020</value>

</property>

<!-- 所有从节点之间相互通信端口地址 -->

<property>

<name>dfs.namenode.servicerpc-address.ns.nn1</name>

<value>node1:8022</value>

</property>

<!-- 所有从节点之间相互通信端口地址 -->

<property>

<name>dfs.namenode.servicerpc-address.ns.nn2</name>

<value>node2:8022</value>

</property>

<!-- 第一台服务器namenode的web访问地址 -->

<property>

<name>dfs.namenode.http-address.ns.nn1</name>

<value>node1:50070</value>

</property>

<!-- 第二台服务器namenode的web访问地址 -->

<property>

<name>dfs.namenode.http-address.ns.nn2</name>

<value>node2:50070</value>

</property>

<!-- journalNode的访问地址,注意这个地址一定要配置 -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node1:8485;node2:8485;node3:8485/ns1</value>

</property>

<!-- 指定故障自动恢复使用的哪个java类 -->

<property>

<name>dfs.client.failover.proxy.provider.ns</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 故障转移使用的哪种通信机制 -->

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<!-- 指定通信使用的公钥 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_rsa</value>

</property>

<!-- journalNode数据存放地址 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/app/install/hadoop-3.2.2/data/dfs/jn</value>

</property>

<!-- 启用自动故障恢复功能 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- namenode产生的文件存放路径 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///app/install/hadoop-3.2.2/data/dfs/nn/name</value>

</property>

<!-- edits产生的文件存放路径 -->

<property>

<name>dfs.namenode.edits.dir</name>

<value>file:app/install/hadoop-3.2.2/data/dfs/nn/edits</value>

</property>

<!-- dataNode文件存放路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///app/install/hadoop-3.2.2/data/dfs/dn</value>

</property>

<!-- 关闭hdfs的文件权限 -->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<!-- 指定block文件块的大小 -->

<property>

<name>dfs.blocksize</name>

<value>134217728</value>

</property>

</configuration>

4. 修改修改yarn-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<!-- 是否启用日志聚合.应用程序完成后,日志汇总收集每个容器的日志,这些日志移动到文件系统,例如HDFS. -->

<!-- 用户可以通过配置"yarn.nodemanager.remote-app-log-dir"、"yarn.nodemanager.remote-app-log-dir-suffix"来确定日志移动到的位置 -->

<!-- 用户可以通过应用程序时间服务器访问日志 -->

<!-- 启用日志聚合功能,应用程序完成后,收集各个节点的日志到一起便于查看 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!--开启resource manager HA,默认为false-->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!-- 集群的Id,使用该值确保RM不会做为其它集群的active -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>mycluster</value>

</property>

<!--配置resource manager 命名-->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 配置第一台机器的resourceManager -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>node3</value>

</property>

<!-- 配置第二台机器的resourceManager -->

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>node2</value>

</property>

<!-- 配置第一台机器的resourceManager通信地址 -->

<property>

<name>yarn.resourcemanager.address.rm1</name>

<value>node3:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address.rm1</name>

<value>node3:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address.rm1</name>

<value>node3:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address.rm1</name>

<value>node3:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm1</name>

<value>node3:8088</value>

</property>

<!-- 配置第二台机器的resourceManager通信地址 -->

<property>

<name>yarn.resourcemanager.address.rm2</name>

<value>node2:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address.rm2</name>

<value>node2:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address.rm2</name>

<value>node2:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address.rm2</name>

<value>node2:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm2</name>

<value>node2:8088</value>

</property>

<!--开启resourcemanager自动恢复功能-->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!--在node3上配置rm1,在node2上配置rm2,注意:一般都喜欢把配置好的文件远程复制到其它机器上,但这个在YARN的另一个机器上一定要修改,其他机器上不配置此项-->

<property>

<name>yarn.resourcemanager.ha.id</name>

<value>rm1</value>

<description>If we want to launch more than one RM in single node, we need this configuration</description>

</property>

<!--用于持久存储的类。尝试开启-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>node2:2181,node3:2181,node1:2181</value>

<description>For multiple zk services, separate them with comma</description>

</property>

<!--开启resourcemanager故障自动切换,指定机器-->

<property>

<name>yarn.resourcemanager.ha.automatic-failover.enabled</name>

<value>true</value>

<description>Enable automatic failover; By default, it is enabled only when HA is enabled.</description>

</property>

<property>

<name>yarn.client.failover-proxy-provider</name>

<value>org.apache.hadoop.yarn.client.ConfiguredRMFailoverProxyProvider</value>

</property>

<!-- 允许分配给一个任务最大的CPU核数,默认是8 -->

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>4</value>

</property>

<!-- 每个节点可用内存,单位MB -->

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>32768</value>

</property>

<!-- 单个任务可申请最少内存,默认1024MB -->

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>1024</value>

</property>

<!-- 单个任务可申请最大内存,默认8192MB -->

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>16384</value>

</property>

<!--多长时间聚合删除一次日志 此处-->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>2592000</value><!--30 day-->

</property>

<!--时间在几秒钟内保留用户日志。只适用于如果日志聚合是禁用的-->

<property>

<name>yarn.nodemanager.log.retain-seconds</name>

<value>604800</value><!--7 day-->

</property>

<!--指定文件压缩类型用于压缩汇总日志-->

<property>

<name>yarn.nodemanager.log-aggregation.compression-type</name>

<value>gz</value>

</property>

<!-- nodemanager本地文件存储目录-->

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/app/install/hadoop-3.2.2/data/yarn/local</value>

</property>

<!-- resourceManager 保存最大的任务完成个数 -->

<property>

<name>yarn.resourcemanager.max-completed-applications</name>

<value>1000</value>

</property>

<!-- 逗号隔开的服务列表,列表名称应该只包含a-zA-Z0-9_,不能以数字开始-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--rm失联后重新链接的时间-->

<property>

<name>yarn.resourcemanager.connect.retry-interval.ms</name>

<value>2000</value>

</property>

</configuration>

5.修改workers文件

(老版本叫slave文件)

cd /app/install/hadoop-3.2.2/etc/hadoop

vi workers

node1

node2

node3

6.修改hadoop-env.sh

cd /home/hadoop-3.2.2/etc/hadoop

vi hadoop-env.sh

export JAVA_HOME=/app/install/jdk-11.0.2

7.修改mapred-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /mapred-site.xml

<configuration>

<!-- 设置MR程序默认运行模式: yarn集群模式 local本地模式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- MR程序历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>node1:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node1:19888</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

</configuration>

8.递归创建目录

mkdir -p /app/install/hadoop-3.2.2/data/dfs/nn/name

mkdir -p /app/install/hadoop-3.2.2/data/dfs/nn/edits

9.分发文件

cd /app/install

scp -r hadoop-3.2.2/ node2:$PWD

scp -r hadoop-3.2.2/ node3:$PWD

三.运行阶段

1.启动hdfs

cd /app/intsall/hadoop-3.2.2

# 启动 journalnode

sbin/hadoop-daemons.sh start journalnode

# 因为是daemons所以启动的是JournalNode集群

# 格式化 namenode

bin/hdfs namenode -format

# bin/hdfs namenode -initializeSharedEdits -force

#因为有两个namenode,所以要把格式化后的NameNode data文件拷贝到node2上

scp data node2:$PWD

启动zkfc

bin/hdfs zkfc -formatZK

# 启动hdfs

sbin/start-dfs.sh

2.启动yarn

因为我们的node2和node3部署的是resourmanager

所以我们在node3上

cd /app/install/hadoop-3.2.2/etc/hadoop

sbin/start-yarn.sh

3.启动jobHistory

在node3上执行

cd /home/hadoop-3.2.2/etc/hadoop

sbin/mr-jobhistory-daemon.sh start historyserver

四.检查阶段

1.hdfs检查

主节点hdfs

http://node1:50070/dfshealth.html#tab-datanode

备用节点hdfs

http://node2:50070/dfshealth.html#tab-datanode

2.yarn检查

http://node3/cluster

3.历史任务的查看

http://node3/jobhistory

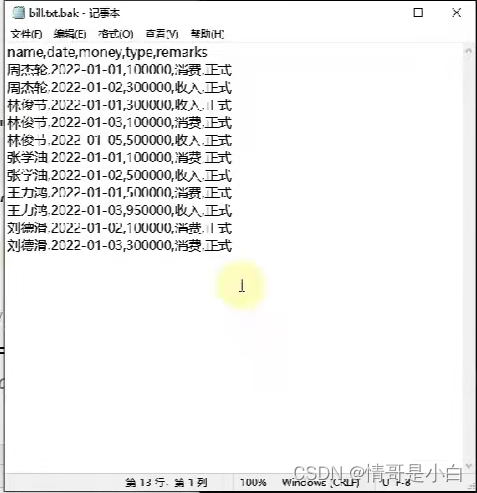

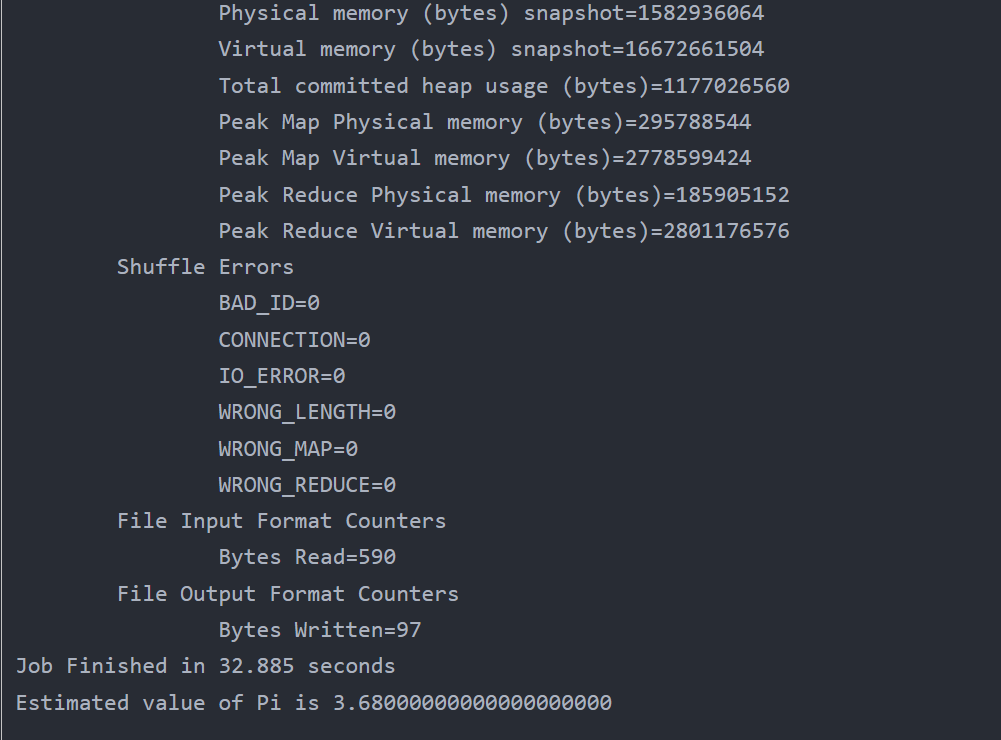

五.DEMO测试

cd /app/install/hadoop-3.2.2/share/hadoop/mapreduce

hadoop jar hadoop-mapreduce-examples-3.2.2.jar pi 5 5

六.补充点

在命令行输入hadoop version,发现没有此命令,是因为环境变量没有配

此时我们修改用户变量

vim ~/.bashrc

#添加

export HADOOP_HOME=/app/install/hadoop-3.3.3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

# wq保存退出

# 刷新配置

source ~/.bashrc

# 重新输入命令,就可以了

hadoop version