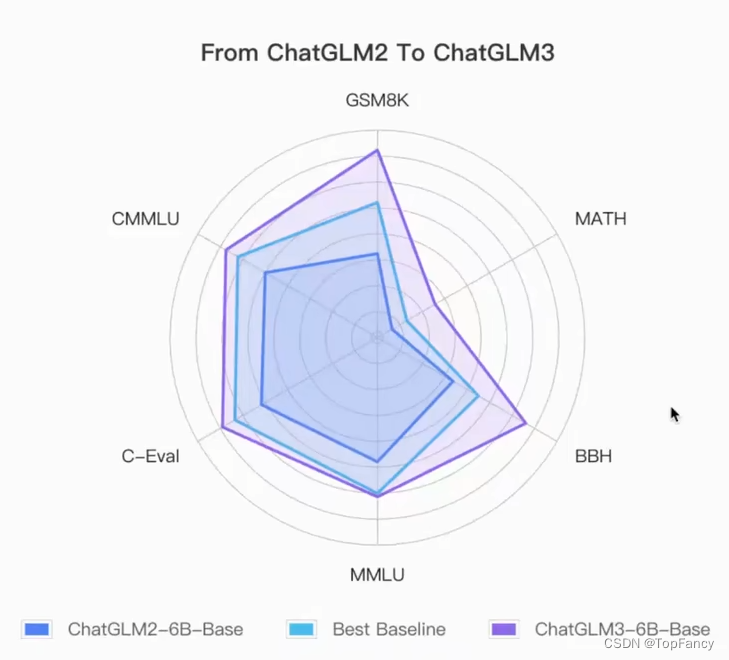

之前写过ChatGLM2-6B大语言模型的部署安装文档,现在ChatGLM模型已经更新迭代到第三代了,从官方公布的数据来看,模型的能力是得到了进一步的增强。

这次写文章主要是来记录一下使用过程,方便回头查看。

ChatGLM3-6B官方的视频教程已经在B站上发布,有兴趣可以去看看【官方教程】ChatGLM3-6B 部署和微调(Function Call、Code Interpreter、Agent)

同样,官方教程也是非常详细的:ChatGLM3 技术文档

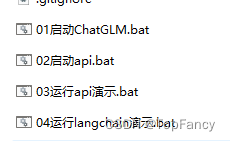

教程中提供了懒人包的安装,一键启动,告别所有烦恼:

百度网盘链接:https://pan.baidu.com/s/1fHElFanrdK9Y-pTpeY_azg?pwd=glut

下载下来懒人包后,可以发现官方真的是把饭喂到了喉咙里,需要哪种运行方式都可以直接一键启动。我这边使用第一个来进行测试

模型加载耗费了一些时间,系统还会根据显存大小自动进行量化运行,借用饭圈一句话:真的我哭死,他太贴心了!

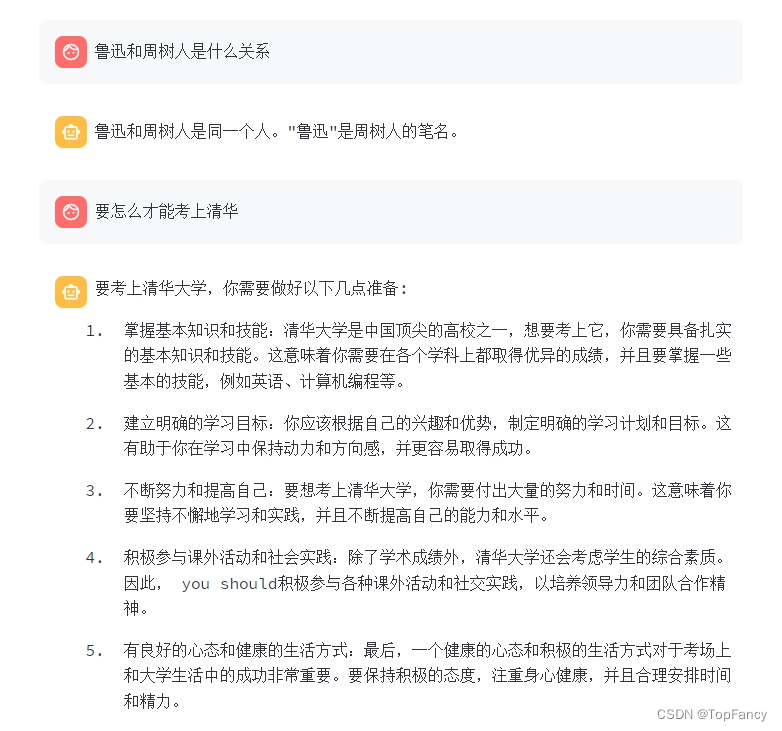

然后测试一下基本问题:

发现他能回答出GPT-3.5没法回答的世纪难题“鲁迅和周树人的关系”,真的可以用在实际的项目中。

语言大模型本地部署最常用的功能就是构建本地知识库,这需要和langchain结合,这部分的内容网上也有好多,我还没有真正上手体验过,等我体验一下,也来这里汇报一下工作吧!