Bi-channel Multiple Sparse Graph Attention Networks for Session-based Recommendation

GitHub - QEpiphany/MSGAT: Multiple Sparse Graph Attention Networks for Session-based Recommendation

摘要

基于会话的推荐(SBR)最近受到了极大的关注,因为它能够提供个性化的建议的基础上的匿名会话用户的交互序列。SBR面临的挑战主要包括如何利用当前会话以外的信息,以及如何减少会话数据中无关信息对预测的负面影响。为了解决这些挑战,我们提出了一种新的基于图注意力网络的模型,称为多稀疏图注意力网络(MSGAT)。MSGAT利用两个并行通道对会话内和会话间信息进行建模。在会话内通道中,我们利用门控图神经网络执行初始编码,然后通过自注意机制生成目标表示。然后基于目标表示对全局表示进行降噪。此外,目标表示用作连接两个通道的媒介。 在会话间通道中,使用目标感知的全局注意机制生成噪声降低的关系表示。此外,MSGAT通过整合来自两个通道的有效信息,从意图的角度充分考虑会话相似性。最后,意图邻居协作模块有效地组合相关信息以增强当前会话表示。在五个数据集上的实验表明,会话内和会话间数据的同时建模可以有效地提高SBR模型的性能。

引言

贡献:

- 我们提出了一种新的双通道SBR模型与多个稀疏图注意力网络,有效地利用会话内和会话间的去噪信息。

- 我们引入了会话关系图和INC组件,这有利于会话间的依赖关系建模,并导致提高推荐精度。

- 我们在五个数据集上进行了大量的实验,结果表明MSGAT模型的性能明显优于SOTA模型。

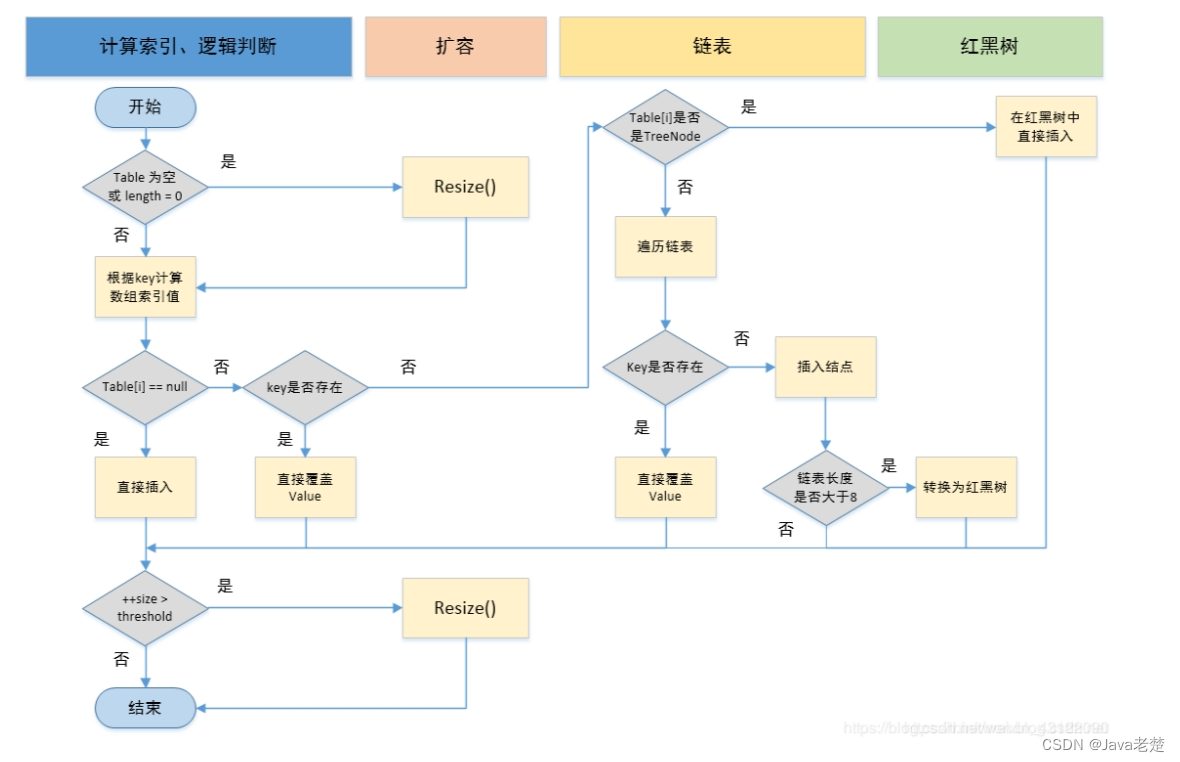

3.4稀疏图注意力网络

随着GNN层数的增加,模型捕获高阶邻域信息的能力也会增加,但这也会导致过度平滑的问题。在自然语言处理任务中,自注意机制通过计算单词之间的相互影响成功地解决了长距离依赖性[32]。基于这个想法,我们采用图注意力机制来增强单层GNN捕获长期依赖关系的能力,从而产生一种新的基于GAT的编码器。在本节中,我们将详细描述每个编码器组件。

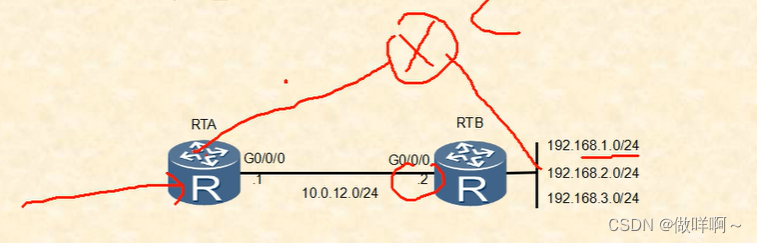

,我们采用GGNN [20]作为初始编码器,结合了GNN和GRU属性。与SR-GNN [35]中采用的方法类似,我们将此组件定义如下:

3.4.3稀疏自我注意机制

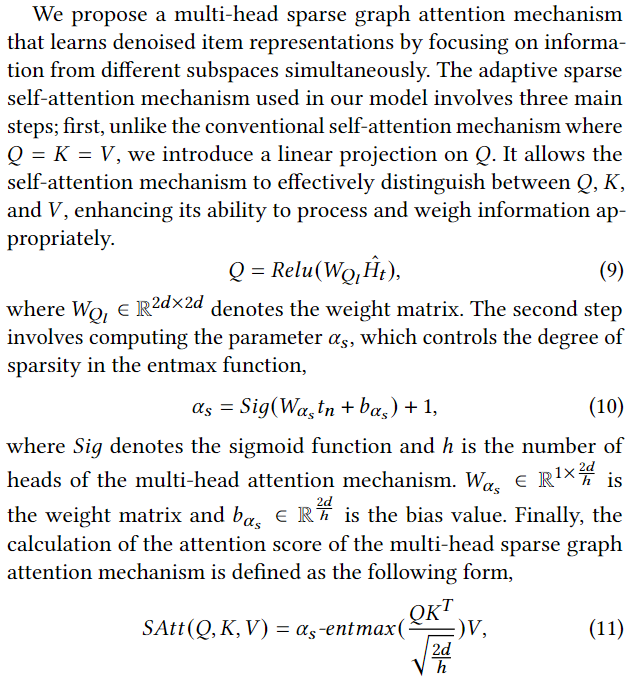

标准的softmax函数注意力机制中的事件将概率分配给序列中的所有项目,而不管它们与用户意图的相关性。经过多个注意力层后,初始的较小权重累积到较大的值,影响模型建议的准确性[42]。相比之下,sparsemax [24]将0值分配给不相关的项。在这项研究的基础上,Correia等人在2019年提出了基于entmax的稀疏注意力机制[6]。这种方法适应数据,可以确定适当的稀疏性,从而实现更准确和可靠的预测。

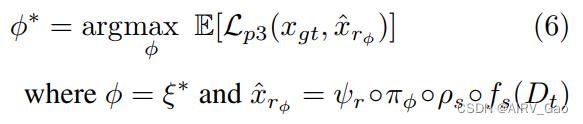

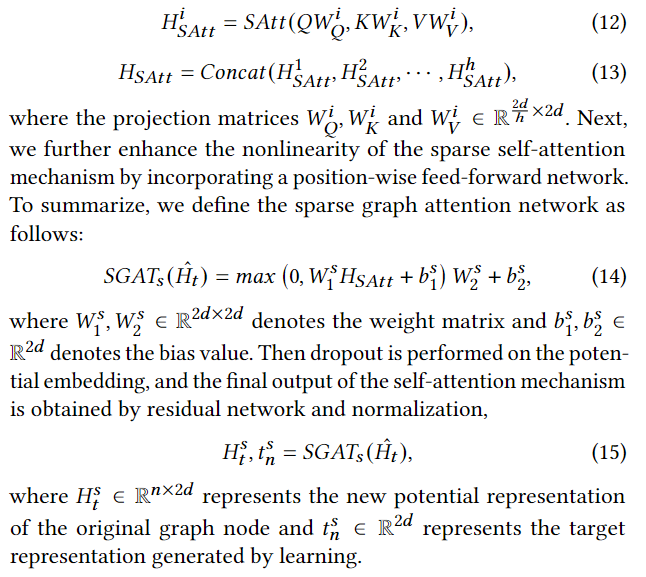

我们提出了一种多头稀疏图注意机制,通过同时关注来自不同子空间的信息来学习去噪项表示。在我们的模型中使用的自适应稀疏自注意机制包括三个主要步骤;首先,与传统的自注意机制不同,它使自我注意机制能够有效地区分“非”、“非”和“非”,增强其适当处理和权衡信息的能力。

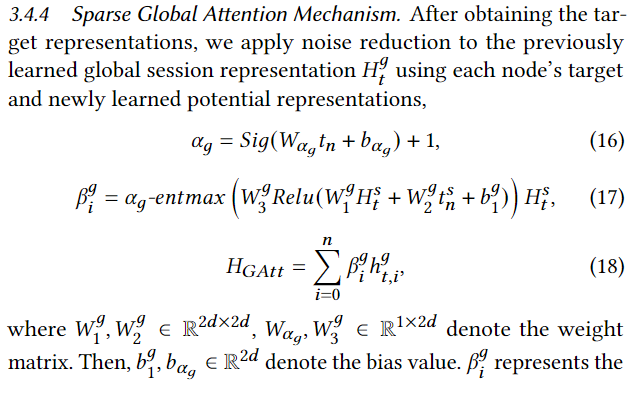

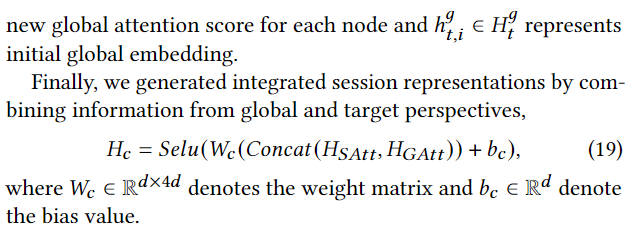

3.4.4稀疏全局注意力机制。

在获得目标表示,我们使用每个节点的目标和新学习的潜在表示对先前学习的全局会话表示进行降噪

参考文献

[6] Gonçalo M Correia, Vlad Niculae, and André FT Martins. 2019. Adaptively sparse transformers. arXiv preprint arXiv:1909.00015

[20] Yujia Li, Daniel Tarlow, Marc Brockschmidt, and Richard Zemel. 2015. Gated

graph sequence neural networks. arXiv preprint arXiv:1511.05493.

相关工作

Dual Sparse Attention Network For Session-based Recommendation

SPARSE TRANSFORMER浅析

- 跨步注意力 (Strided Attention): 这种方法将注意力操作分为两个部分。第一部分关注序列中固定数量的前一个位置。第二部分关注某个跨步长度的倍数的位置。

- 固定注意力 (Fixed Attention): 这种方法也将注意力操作分为两个部分。第一部分关注在同一固定长度块内的位置。第二部分关注块内固定数量的位置。

- Top-k选择 (Top-k Selection): 这种方法只保留最有助于注意力的前k个元素,有效地使注意力稀疏.