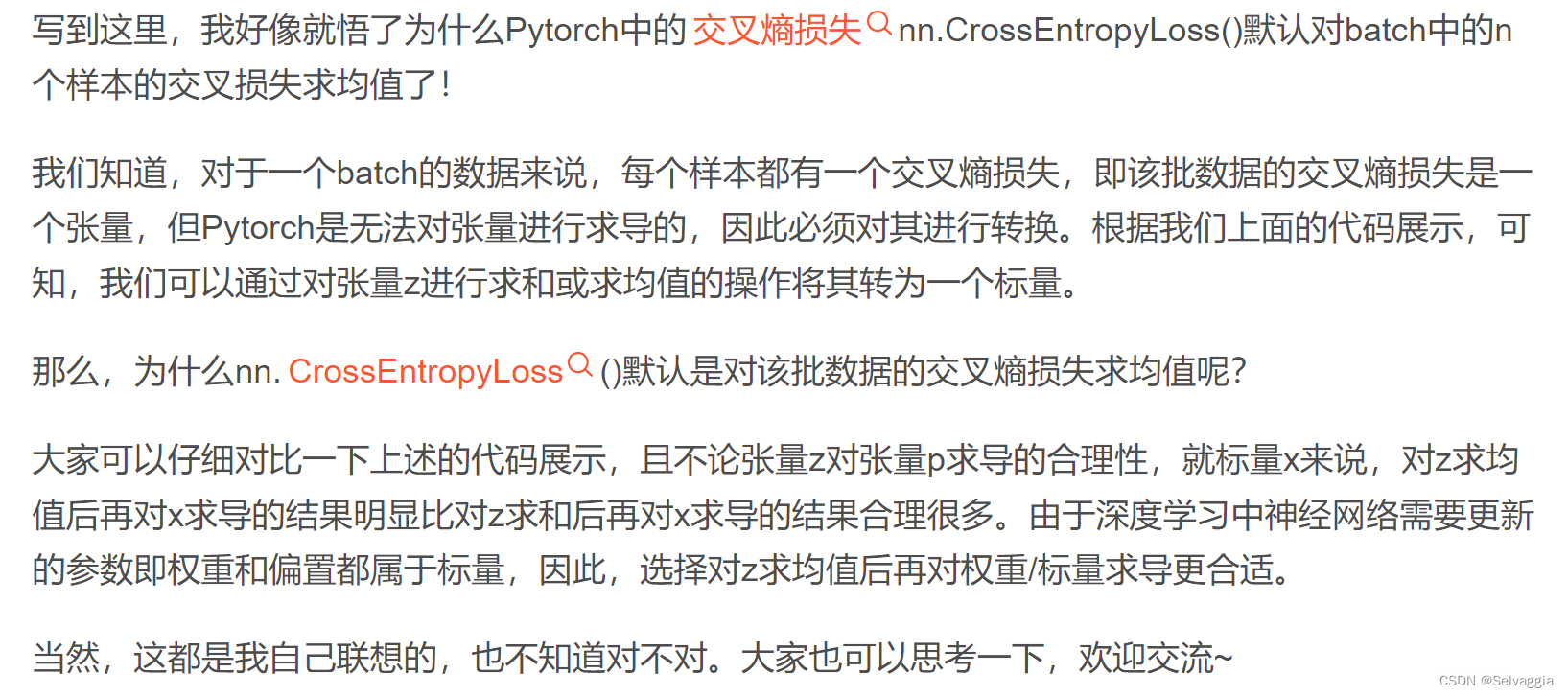

多模态指的是通过多种感知方式(如视觉、听觉、语音等)来处理和理解信息。虽然多模态对于智能系统的发展和提高用户体验非常重要,但它并不是智能的核心。

智能的核心是指系统具备自主学习、推理和决策的能力。智能系统需要能够通过分析和理解大量的数据和信息,从中提取有意义的模式和规律,并基于这些模式和规律做出适当的决策。多模态在这个过程中起到了辅助的作用,可以提供更全面、准确的信息,但它并不决定系统是否具备智能。因此,多模态是智能系统中的一个重要组成部分,但并不是智能的核心,智能的核心在于系统的学习、推理和决策能力。

包括GPT4.0在内的大语言模型并没有解决“应该”如何的问题。大语言模型通常是基于大规模文本数据进行训练的,其主要用途是生成自然语言文本或回答特定的问题。对于从“是”中推出“应该”的问题,涉及到道德、伦理、价值观等主观因素,需要考虑人类的道德判断和价值观。大语言模型仅能基于训练数据中的模式和规律进行推理和生成,缺乏对主观判断的理解和评估。解决“应该”问题需要考虑多方面的因素,如伦理道德标准、法律规范、社会责任等,这些因素无法简单地通过机器学习模型来得出。相反,这需要人类的价值观和伦理判断来指导和决策。虽然大语言模型本身并不能解决“应该”问题,但它可以作为辅助工具,帮助人类进行决策和评估。通过为人类提供更多的信息和视角,大语言模型可以帮助人们更全面地了解问题,并提供不同的观点和思考方向,从而辅助人类做出“应该”的决策。

人工智能的危险相关因素包括:

坏人坏用:人工智能技术可以被恶意使用,例如网络攻击、社会工程、虚假信息传播等。恶意行为者可能利用人工智能来进行网络犯罪、隐私侵犯、社会操纵等活动。

好人误用:即使是善意的使用者,也可能出于无知、疏忽或不当的目的将人工智能技术误用。例如,在决策支持系统中忽略了系统的局限性,导致不良的结果。

软硬件bug:人工智能系统的软件和硬件可能存在错误和漏洞。这些漏洞可能导致系统的不可预测的行为或错误的决策。例如,无意中训练了一个有偏见的模型,或者由于软件错误而导致机器人判断错误。

环境影响:人工智能系统的环境可能会对其行为产生重要影响。例如,一个自动驾驶汽车可能无法适应突发的天气状况或道路改变,导致事故。

这些因素的组合可能增加了人工智能系统的潜在危险性。为了减轻这些风险,需要采取一系列措施,例如制定合适的法律和伦理规范、加强系统的安全性和鲁棒性、进行透明度和可解释性研究等。

不能测量的自然规律是指一些无法直接通过实验或观测来确定或验证的自然现象或规律。这可能是由于技术限制、观测工具的不足或其他不可预测的因素所致。一些不能测量的自然规律包括但不限于以下几个方面:量子力学的某些现象:量子力学研究微观领域的粒子行为,其中一些现象如量子纠缠和超决定性等是无法直接测量或验证的。

宇宙的起源和演化:我们无法回溯到宇宙大爆炸之前或观测到其演化的所有阶段,因此对于宇宙起源和演化的确切规律仍存在一定的不确定性。

意识和思维:人类的意识和思维活动是主观的,无法直接测量或验证。虽然我们可以通过行为或脑电图等间接的方式来研究大脑活动,但对于意识和思维本质的理解仍存在许多争议和未解之谜。

宇宙的结构和组成:我们对宇宙中黑暗物质和暗能量的本质和分布仍知之甚少。这些无形的物质和能量对于测量和直接观测来说是困难的,因此我们对宇宙结构和组成的认识仍有待深入研究。

需要注意的是,尽管存在一些不能直接测量的自然规律,科学仍在不断发展,通过间接观测和推理等方法,我们可以逐步增加对这些规律的理解。

有些自然规律只能估算而不能精确测量的原因有以下几点:

实验条件限制:对于某些自然规律,我们无法创造出完全符合理想条件的实验环境。例如,对于宏观领域中的物理规律,我们无法消除所有可能的干扰因素,导致测量结果的误差无法完全排除。

精度限制:对于某些现象,我们的测量技术无法达到足够的精度。例如,对于非常微小或非常大的物理现象,我们的测量仪器可能无法捕捉到足够精细的数据,导致测量结果出现误差。

不确定性原理:量子力学中的不确定性原理指出,对于某些物理量,例如粒子的位置和动量,我们无法同时精确地确定它们的值。这意味着,对于这些物理量,我们无法通过测量获得其准确的数值。

复杂性和非线性:有些自然规律涉及到复杂的非线性关系,难以通过简单的测量来准确确定其数值。例如,对于复杂的生态系统或气候系统,其中的相互作用和反馈机制很难通过单一的测量来完全捕捉。

综上所述,自然界中存在一些复杂性和不确定性,以及实验条件和测量精度的限制,导致我们只能通过估算而不能精确测量一些自然规律。虽然当前的测量学贡献很大,但绝不是包治百病的良药!