P2Sharpen: A progressive pansharpening network with deep spectral transformation

(P2Sharpen:一种具有深度光谱变换的渐进式全色锐化网络)

大多数现有的基于深度学习方法pansharpening的监督任务仅仅依靠伪ground-truth多光谱图像,展示两个限制生产高质量的图像的因素。一方面,它是不可控的调节完全解决性能是因为他们的整个培训过程只保持在降低分辨率的规模。另一方面,他们忽略了准确的高分辨率全色图像的空间信息参考监督不足导致空间结构的细节。为应对这些挑战,我们提出一个渐进式pansharpening网络与深度谱变换,称为P2Sharpen,平衡性能在不同的决议和充分利用观测卫星数据来提高融合结果的质量。首先,我们设计一个光谱变换网络(STNet)交叉的形态区别多光谱和全色数据数据,建立了准确的映射函数从MS到Pan图像。其次,提出了一种渐进式全色锐化网络(P2Net),该网络分两个阶段考虑降分辨率和全分辨率下的全色锐化优化,有效地平衡了两个尺度下的性能。此外,引入训练好的STNet,在降分辨率和全分辨率阶段建立锐化结果与PAN图像的一致性约束,进一步提高了P2Net的空间纹理保持能力。

介绍

对于传统方法的关于泛锐化的介绍:略。

提出了一种基于深度谱变换的渐进式全色锐化网络(P2Sharpen),该网络充分利用了全色图像的空间细节信息,同时兼顾了各分辨率下的性能。首先,设计了一个渐进式全色锐化网络(P2Net),用于分阶段生成融合结果。在融合过程中,前一阶段对应于降低分辨率阶段,后一阶段对应于全分辨率阶段。因此,我们可以通过精心优化每个阶段的网络来实现全分辨率和降低分辨率性能的双赢局面。其次,引入深度光谱变换网络(STNet),寻求光谱响应中全色波段与多光谱波段之间的精确映射关系,从本质上模拟了多光谱成像过程。训练好的STNet可以在融合图像和PAN图像之间架起一座桥梁,从而约束P2Net充分利用PAN图像的空间信息,加强对空间结构的保持。在这些因素的帮助下,P2Net可以在降分辨率和全分辨率下产生高质量的锐化结果,不仅具有准确的光谱分布,而且具有合理的空间结构。

贡献

1)我们提出一个新的进步的融合策略定制新的pansharpening网络(例如,P2Net),在整个培训的过程分为两个阶段,因此提出一种新的方式来平衡不同分辨率的表现通过调整优化为每个阶段。

2)深谱变换网络(例如,STNet)是为了交叉Pan和MS图像之间的形态差异和扩展到非线性空间,该方法可以引入对PAN图像的额外监督来指导P2Net的优化,增强对空间细节的保留。

3)我们证明该方法的优越性最先进的通过广泛的实验定性和定量,还将我们的方法应用于遥感任务,即,生成HR归一化植被指数(NDVI)。

相关工作

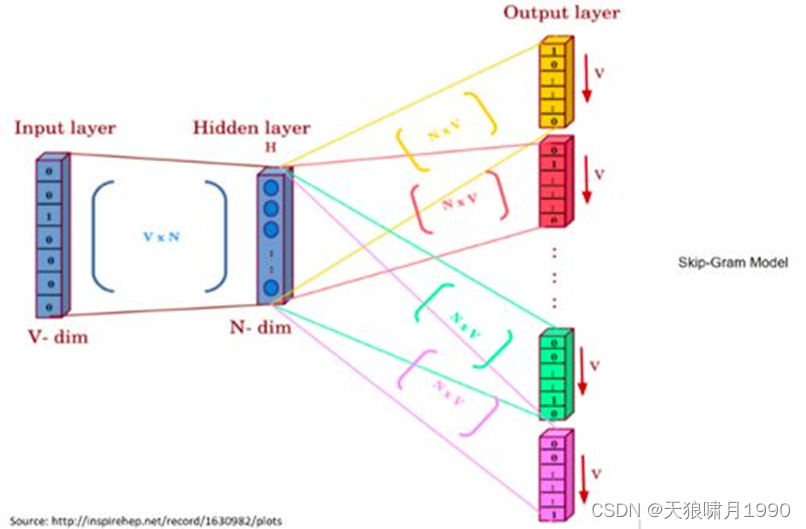

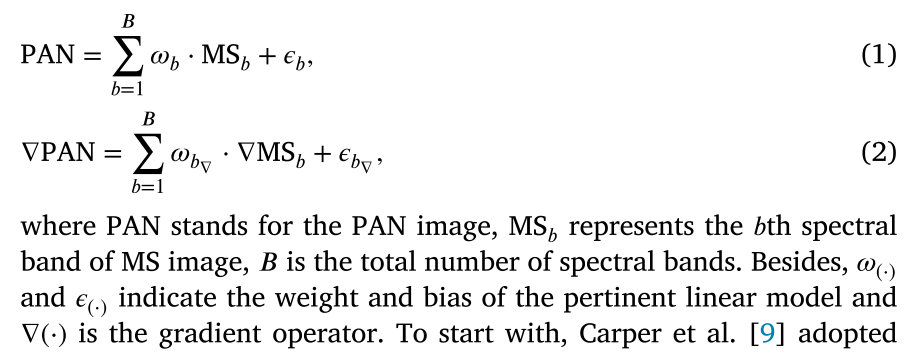

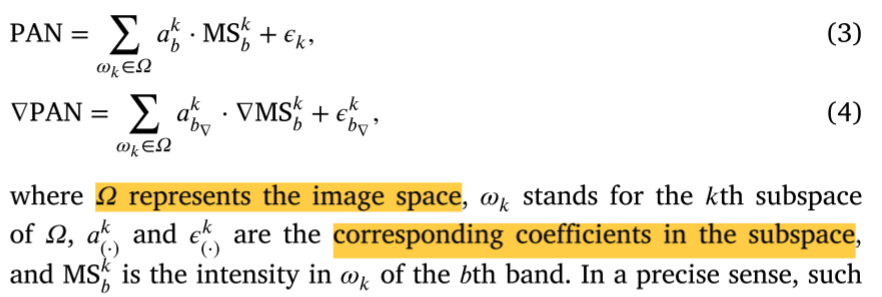

Spectral transformation

全色锐化旨在融合MS图像的光谱信息和PAN图像的空间信息。在此背景下,寻找MS和PAN影像之间的内在联系,对于空间和光谱信息的协同融合具有重要意义。然而,MS和PAN图像具有不同的通道和分辨率,这使得很难找到跨模态的对应关系。为了解决这个问题,提出了几个相关的光谱转换模型等试图打破信息壁垒。他们中的大多数需要重采样操作实现分辨率对齐,随后根据以下假设寻求回归关系:PAN的图像(或其梯度)可以建模为一个MS图像(或其梯度),的线性组合,这一行为可以形式化:

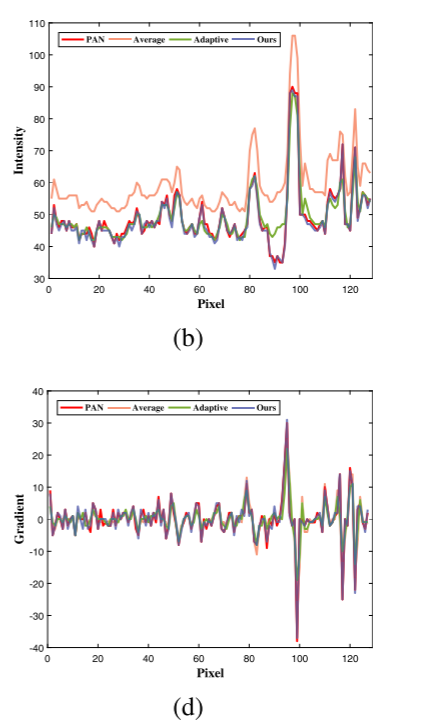

Carper等人采用不同波段的平均重量来搜索,粗略的解决Eq.(1)。此外,改进应用于自适应分配重量的不同波段Ballester等人找到更准确的解决方案,其中系数在一个优化的方法获得。然而,这样的全局关系不适用一些局部区域,这或多或少导致光谱失真,如图2(b)和(d)所示。换句话说,卫星数据之间的关系是非常复杂的物理条件和完全不同的各种传感器。因此,合成pseudo-PAN未能符合真正的锅在强度和梯度。因此,融合图像的空间信息是极其扭曲的。

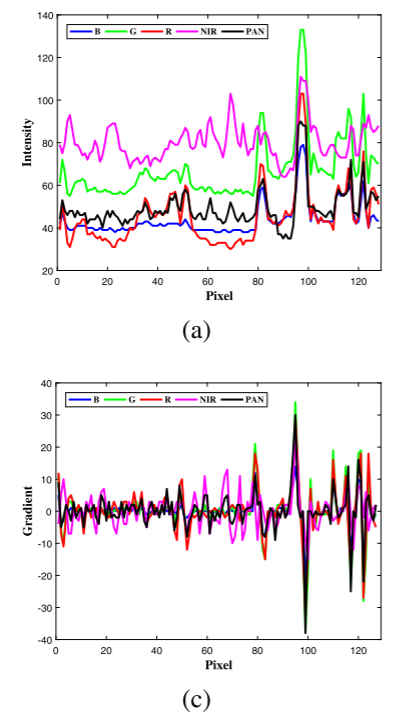

鉴于PAN和MS图像的复杂性,如图2(a)和(c)所示

为每个局部区域分配相关系数更为合理,从而进一步提高解的精度。因此,主要思想是建立基于局部制导的线性模型,其可以形式化为:

在一个精确的意义上,这样的本地约束提供进一步改善解决方案的准确性。然而,有限的线性组合的性能很难精确地符合复杂PAN和MS图片光谱之间的映射关系,这意味着仍然存在改进的空间。神经网络强大的非线性拟合能力可以寻求所需的MS和PAN图像之间的对应关系。GTP-PNet中带头做一个尝试,设计一个TNet建立梯度从MS的图像映射到PAN图片,可以正式化为:

在一个精确的意义上,这样的本地约束提供进一步改善解决方案的准确性。然而,有限的线性组合的性能很难精确地符合复杂PAN和MS图片光谱之间的映射关系,这意味着仍然存在改进的空间。神经网络强大的非线性拟合能力可以寻求所需的MS和PAN图像之间的对应关系。GTP-PNet中带头做一个尝试,设计一个TNet建立梯度从MS的图像映射到PAN图片,可以正式化为: 其中𝑆(·)是TNet的函数。尽管TNet大大有助于提高转换精度,它只专注于稀疏的梯度,既不充分利用图像的信息也不符合直觉的光谱退化。因此,我们提出一个更精确的非线性光谱转换采用定制网络探索在强度域中PAN和MS之间映射关系。

其中𝑆(·)是TNet的函数。尽管TNet大大有助于提高转换精度,它只专注于稀疏的梯度,既不充分利用图像的信息也不符合直觉的光谱退化。因此,我们提出一个更精确的非线性光谱转换采用定制网络探索在强度域中PAN和MS之间映射关系。

Deep-learning-based methods

略

方法

Notations

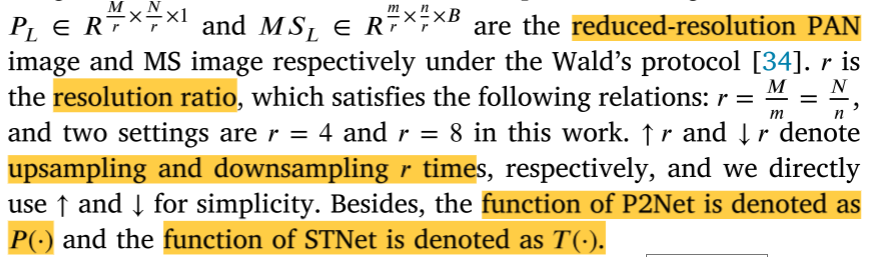

本文总结了如下符号。典型的卫星数据包括两种类型的图像,即。HRPAN和LRSM图像。高度为𝑀,宽度为𝑁的HRPAN图像表示为𝑷𝒉 ∈

𝑅

𝑀

×

𝑁

×

1

𝑅^{𝑀 ×𝑁 ×1}

RM×N×1。而𝑴𝑺𝒉∈

𝑅

𝑚

×

𝑛

×

𝐵

𝑅^{𝑚 ×𝑛 ×𝐵}

Rm×n×B是总波段的观测LRMS图像𝐵,其中𝑚,𝑛分别表示其高度和宽度。

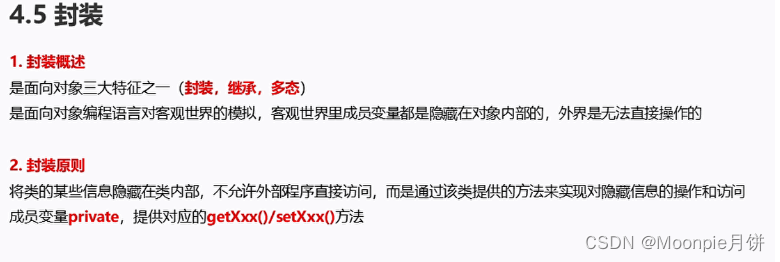

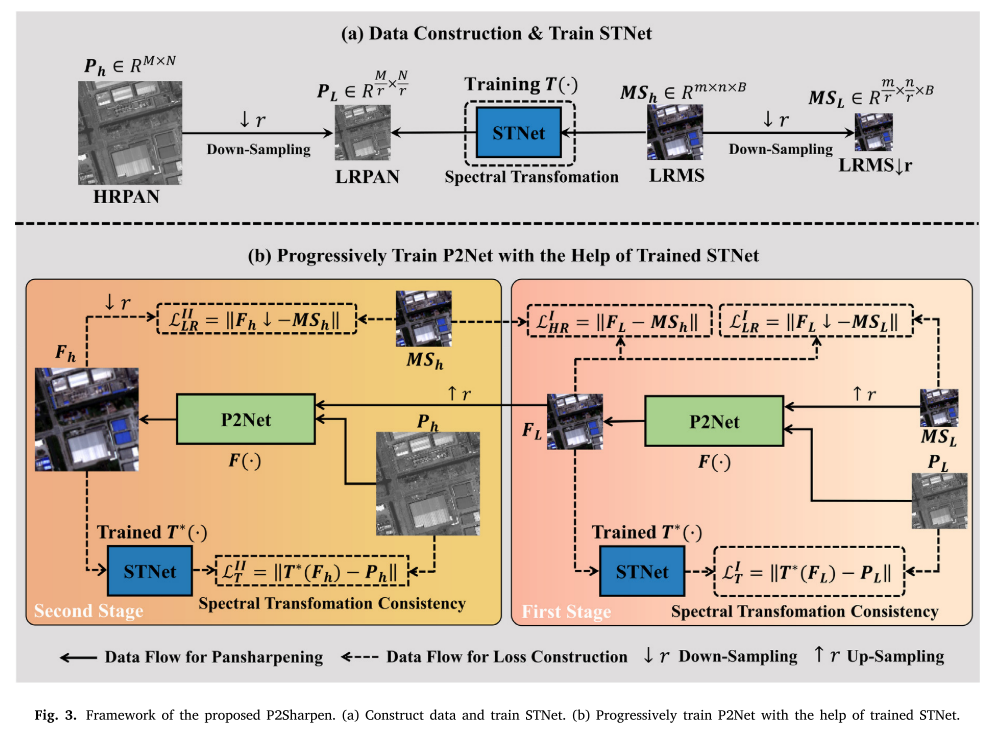

Overview of the framework

提议的方法的初衷是解决上面提到的两个挑战,例如,完整性能之间的不平衡和减少决议由于传统监督学习,和空间细节的失真引起的忽略HRPAN图像。为此,我们提出一种新颖的进步pansharpening网络与深度谱变换,称为P2Sharpen,如图3所示。总的来说,提出的P2Sharpen包含两个子网STNet 和P2Net, STNet旨在学习从MS到PAN图像的映射,而P2Net致力于学习优质pansharpening函数。下面,我们解释具体设计拟议的框架来解决上面提到的这两个挑战。

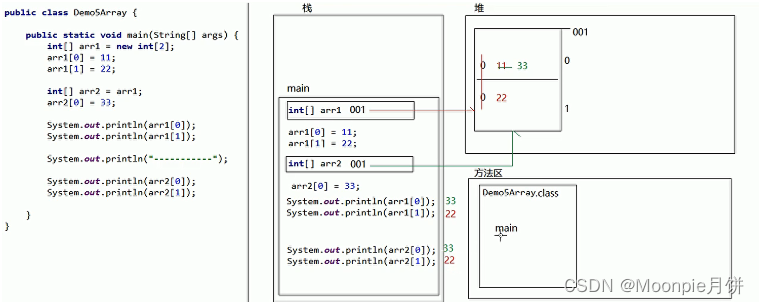

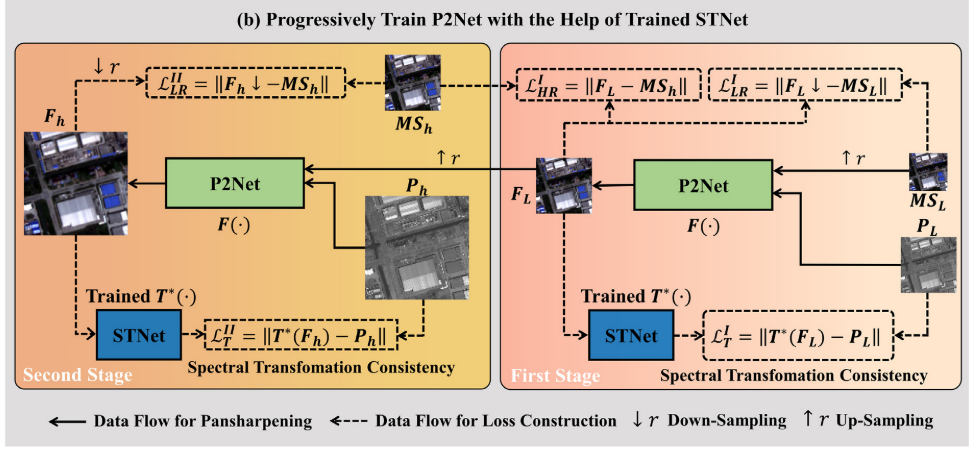

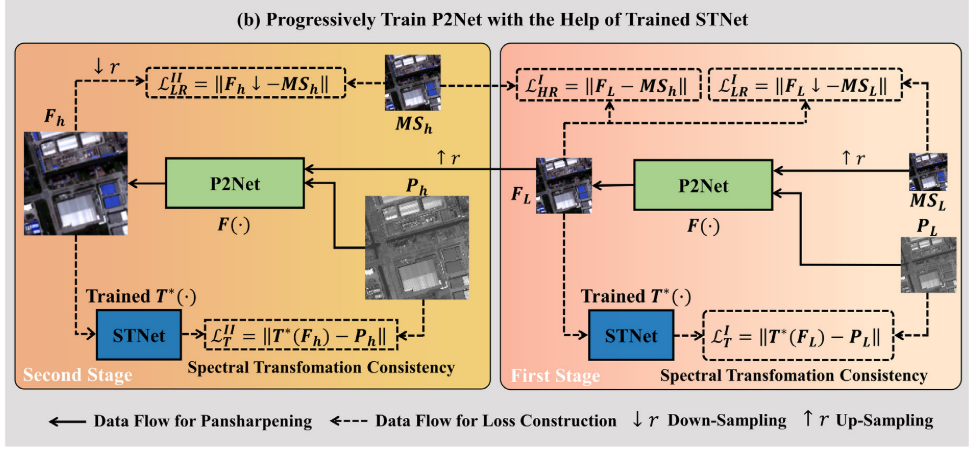

首先,针对全分辨率(full-resolution)和降分辨率(reduce-resolution)下的性能不平衡,提出了一种渐进式两阶段学习策略。一方面,两阶段学习的概念指的是我们在完全分辨率和降低分辨率下同时训练P2Net,但共享P2Net的相同参数集。另一方面,渐进式战略意味着第一阶段和第二阶段紧密相连。具体地,我们将第一级的输出视为第二级的输入,如图3(b)所示。形式上,所提出的渐进式两阶段学习可以定义为:

Eq.(6)表示pansharpening在第一阶段,而Eq.(7)描述pansharpening在第二阶段。𝜃 代表了P2Net的网络参数,可以看到,这两个阶段共享相同的𝜃。𝐹L表示分辨率降低的融合图像,𝐹h是全分辨率融合图像。通过这样一个进步的二级策略,我们P2Net可以同时学习数据分布特征完整和减少决议,以平衡pansharpening表现这两个尺度。

其次,针对忽略HRPAN影像而导致的空间细节失真,提出了一种新的约束条件,即保证HRPAN影像与全分辨率融合影像光谱变换的一致性𝐹h。具体地说,我们引入STNet将多波段图像𝐹h转换为单波段伪PAN图像,并确定转换后的伪PAN图像与真实HRPAN图像之间的最小距离损失。值得注意的是,由于我们的方法包括两个阶段,即,全分辨率和低分辨率融合图像,我们还使用STNet在LRPAN和低分辨率融合图像之间构建类似的一致性约束𝐹𝐿,如图3(b)所示

结果表明,融合后的图像能够进一步充分利用PAN模态所包含的空间信息,提高了结构纹理的保存质量。然而,实现这一目标的前提是,STNet寻求一个相当准确的MS到PAN的映射图像。因此,我们进行数据构建,并使用成对的MS和PAN图像[𝑀𝑆h,𝑃𝐿]训练STNet,以获得从多波段MS图像到单波段PAN图像的局部非线性光谱映射关系:

除了以上两个主要设计外,我们还引入了一些其他的约束来加强光谱信息的保存。一方面,我们遵循一般的监督损失,要求降分辨率融合图像与𝑀𝑆h第一阶段的可用一致。另一方面,我们限制down-sampled融合结果在这两个阶段(FL↑和Fh↓)与相应的低分辨率MS图像(MSh)是一致的。通过以上设计,我们的方法可以有效地保持空间结构和频谱分布,同时缓解全分辨率和降分辨率之间的性能不平衡。值得注意的是,整个锐化过程是由P2Net独立完成的,而STNet只是在训练过程中出现来指导P2Net的优化。

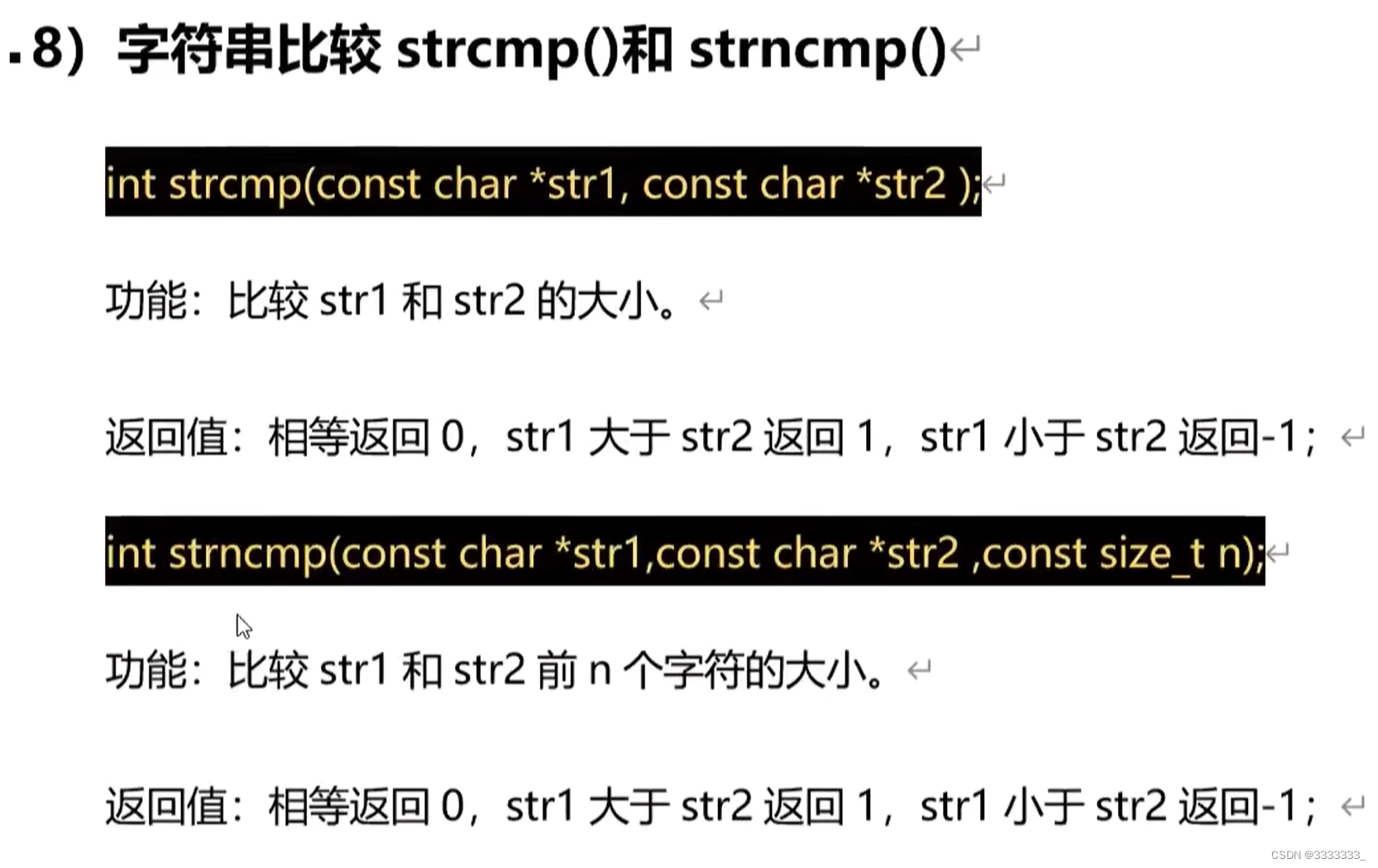

STNet

一个训练有素的STNet约束P2Net实现优质pansharpening的先决条件。

Network structure

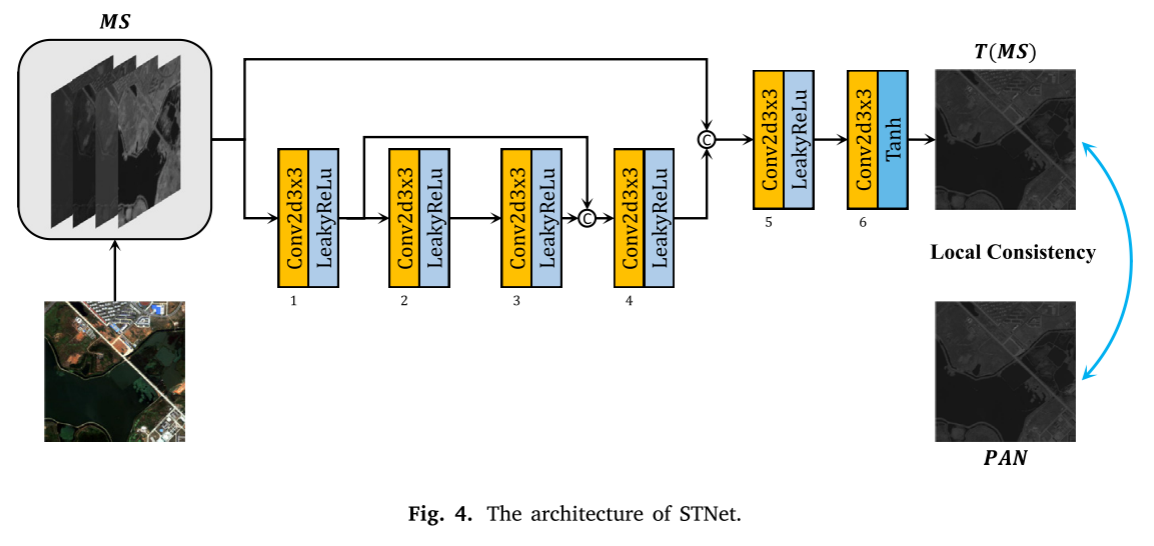

STNet的网络结构是图4所示,这是一个完全卷积网络寻找局部的 MS和PAN图像之间的映射关系。具体地说,所提出的STNet由几个基本卷积层组成,其中核大小固定为3 × 3。对于STNet的前五层,我们将LeakyReLu激活函数附加到每个卷积层,而Tanh用于在最后一层产生伪PAN图像。整个网络类似于一个U型框架,采用两个跳跃连接将前一级输出的特征图传递到后一级,提高了网络的特征利用能力。

Loss function

为了更好地约束STNet的优化,根据目标导向设计了特定的损失函数。更具体地,STNet在非线性空间中寻求从MS图像到PAN图像的局部光谱映射。因此,目的是生成的图像和PAN是一致的图像在相同的规模。损失 函数 LSTNet 定义 如下 通过减少这种损失,STNet能够建立深谱变换从MS到PAN图片,训练函数STNet被标记为𝑇∗。

通过减少这种损失,STNet能够建立深谱变换从MS到PAN图片,训练函数STNet被标记为𝑇∗。

P2Net

Network structure

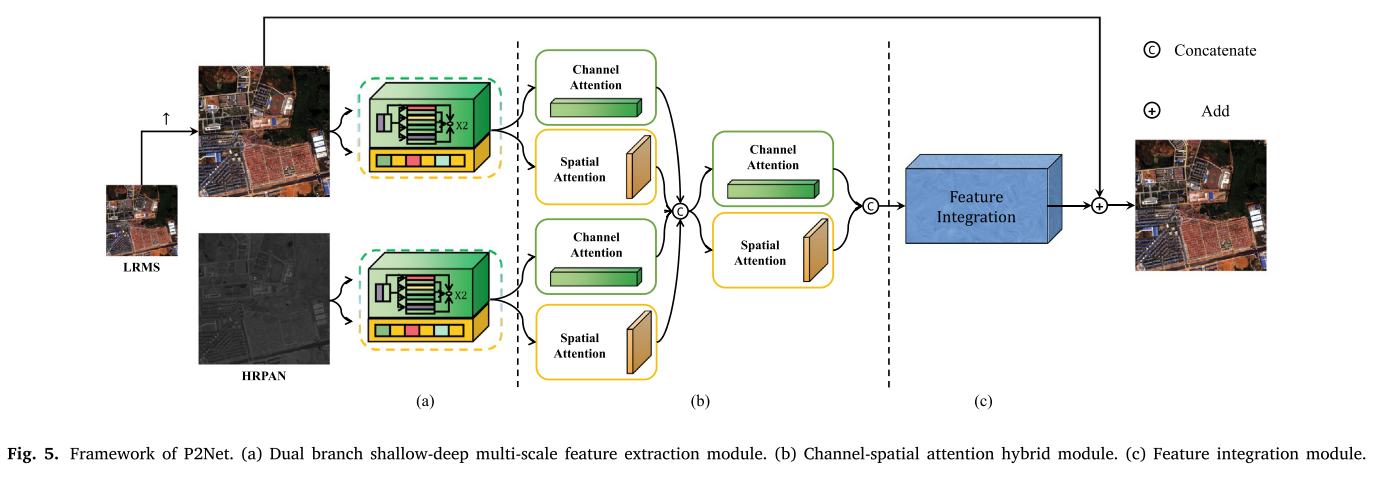

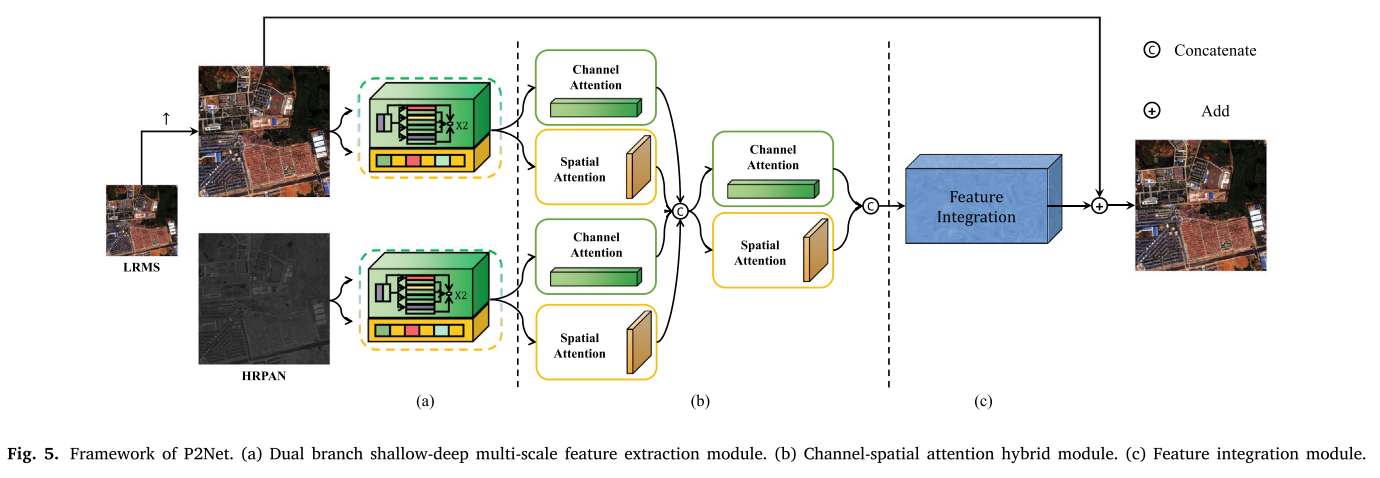

P2Net采用典型的残差学习策略,利用残差连接保持光谱信息和注入残差空间特征映射,以生成最终的融合的结果,如图5所示。 取得的残留特征地图,三个模块包括双分支shallow-deep多尺度特征提取模块(DSMFEM)、 channel-spatial关注混合模块(CSAHM)和功能集成模块(FIM)设计用于特征提取,分别增强和集成。

取得的残留特征地图,三个模块包括双分支shallow-deep多尺度特征提取模块(DSMFEM)、 channel-spatial关注混合模块(CSAHM)和功能集成模块(FIM)设计用于特征提取,分别增强和集成。

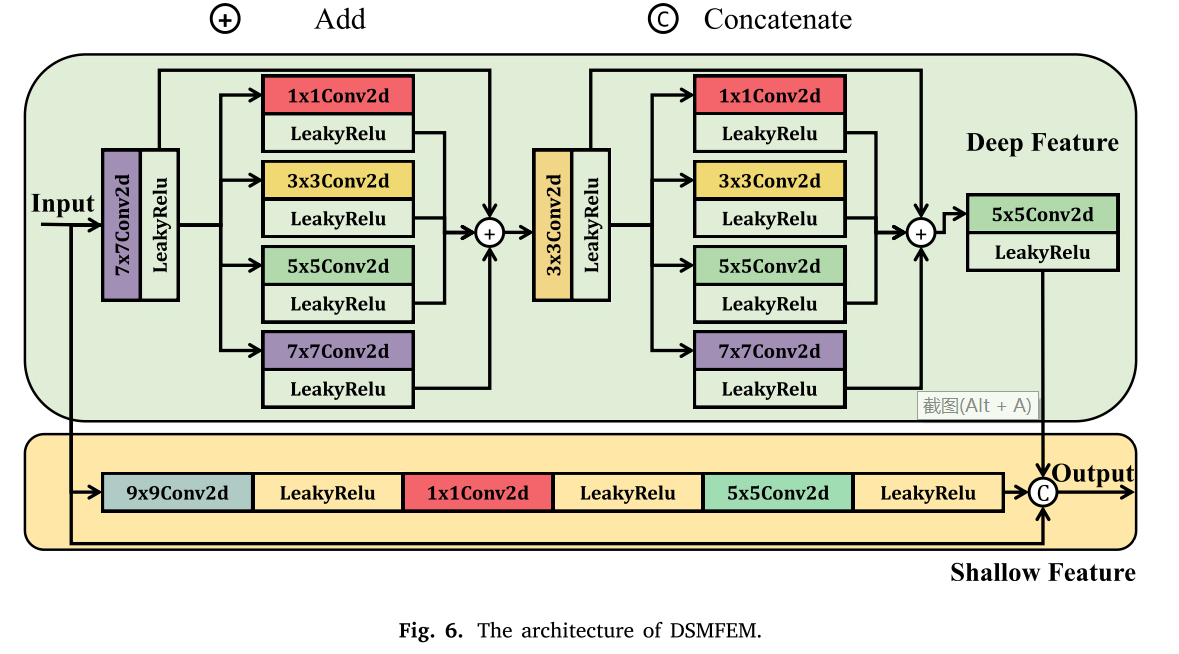

Feature extraction

为了充分挖掘PAN和MS图像的层次特征,分别采用两分支网络进行特征提取。由于MS和PAN数据的空间分辨率和光谱响应有很大差异,权重共享参数化网络不能胜任对位地捕获相关特征。因此,我们引入了两个模块,以探索不同模态图像的本质特征。该模块由浅径和深径组成,如图6所示。

一方面,认为小规模的特点(例如,short edges of buildings)反应良好过滤器与小的内核,而大规模的特点(如coarse flatland)回应过滤器有一个很大的内核。因此,在深度路径中,采用不同核大小的卷积层来呈现相应的感受野,用于粗结构和纹理细节的特征提取,并采用残差连接来提高特征提取的精度。另一方面,深度网络关注语义特征,而浅度网络关注细节信息特征。因此,为了充分利用输入图像,我们提供了一种浅路径来提取细节信息。最后,提取的特征以及输入和输出连接。

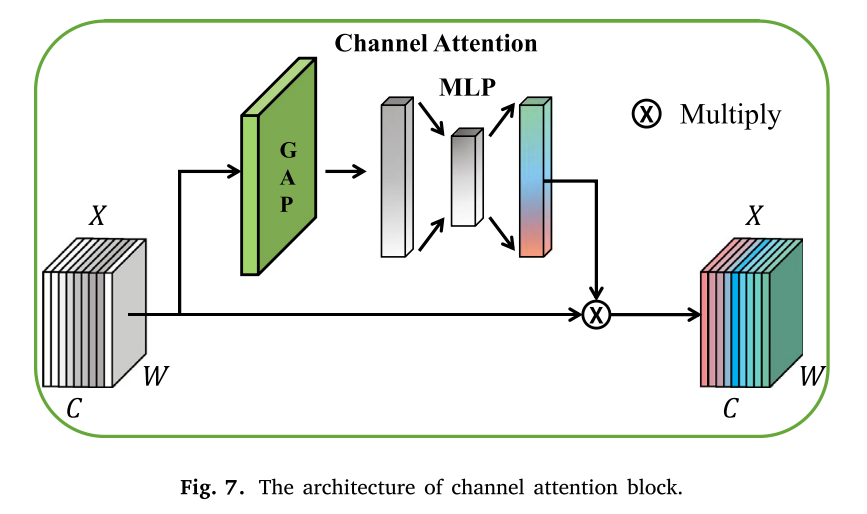

Feature enhancement

为了更有效地保留有用的空间和光谱信息,有必要对重要的特征通道进行增强,对其他特征通道进行弱化。具体来说,我们希望通过增加权重来更加关注表征PAN图像空间信息的高频特征和表征MS图像光谱分布的特征。至于其他通道冗余功能,我们希望减少相应的权重,从而提高网络的泛化能力。因此,我们采用通道注意块来实现此目的,如图7所示。

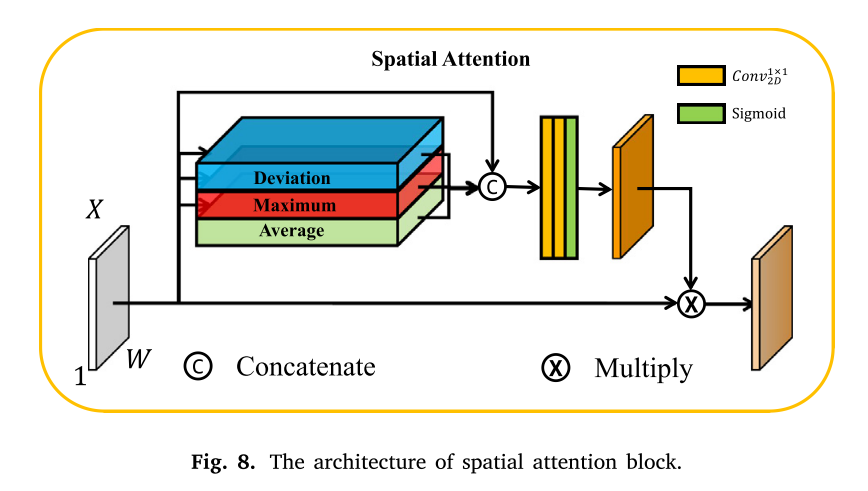

与此同时,我们也把这一事实的信息空间像素并不都是有用的考虑。为了提高信息的关注重要的空间位置,我们采用一块空间的关注,如图8所示。

在图5的特征增强阶段,将上述通道和空间注意块混合以构造混合注意模块。

混合关注模块可以极大地增强特征信息,促进后续网络的功能集成。

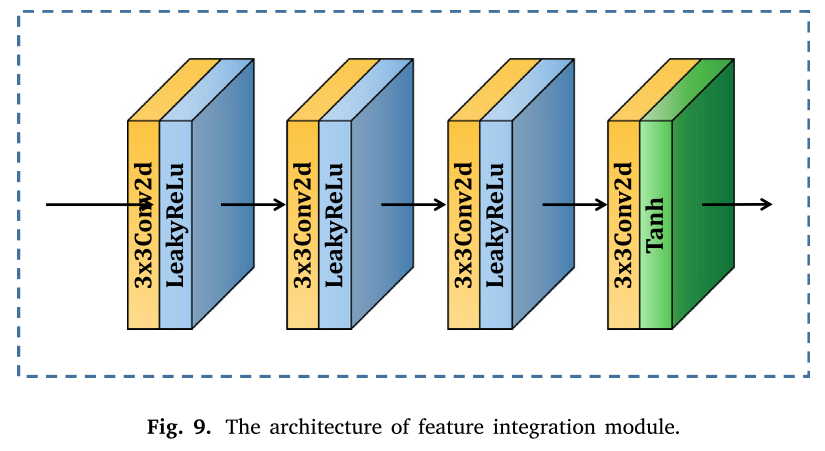

Feature integration

输出增强特征图连接和发送到后续模块功能集成,以便制作适当的残余信息的地图。卷积模块的结构由四层,卷积层和内核的大小是3×3。我们使用LeakyReLU(⋅)激活函数前三层,并以Tanh(⋅)为激活函数在最后一层,如图9所示。

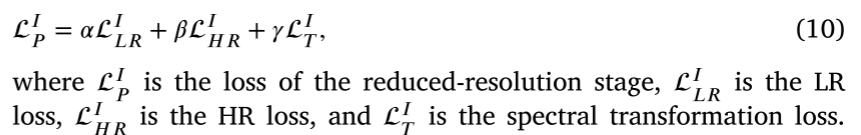

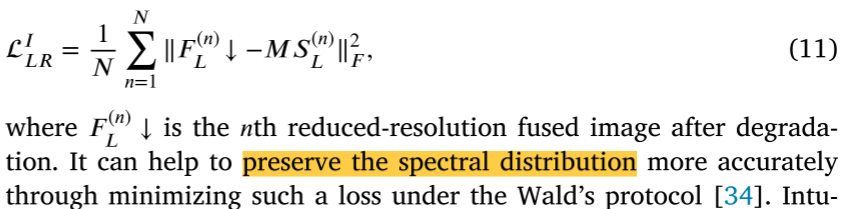

Loss function

对于降低分辨率级,设计了三个损耗项用于优化,其可概括为 三个不同的系数𝛼𝛽𝛾用于在这些损耗项之间进行权衡。首先,利用LR损失来保证降低分辨率的融合图像在空间退化的情况下仍然具有与LRMS图像相同的光谱分布,其可以用公式表示为:

三个不同的系数𝛼𝛽𝛾用于在这些损耗项之间进行权衡。首先,利用LR损失来保证降低分辨率的融合图像在空间退化的情况下仍然具有与LRMS图像相同的光谱分布,其可以用公式表示为:

直观地,任何融合图像退化的降低空间分辨率应当尽可能接近原始MS图像。第二,利用HR损失来约束与观测的LRMS图像一致的降低分辨率融合图像的光谱信息𝐹𝐿,其公式为:

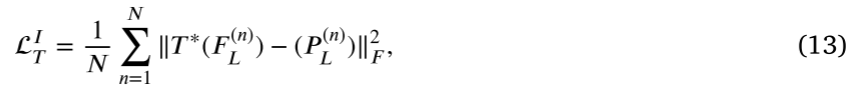

虽然上述两个损失方面可以提供融合图像的光谱的指导,缺乏保护空间的约束。为了保持空间信息更加合理,我们介绍了训练STNet建立空间指导:

其中𝑇 *(·)是训练有素的STNet的功能。这种空间引导要求降分辨率融合结果必须满足STNet学习的光谱变换关系,以增强空间细节。在这三个损失项的约束下,融合图像的质量基本可以得到保证。

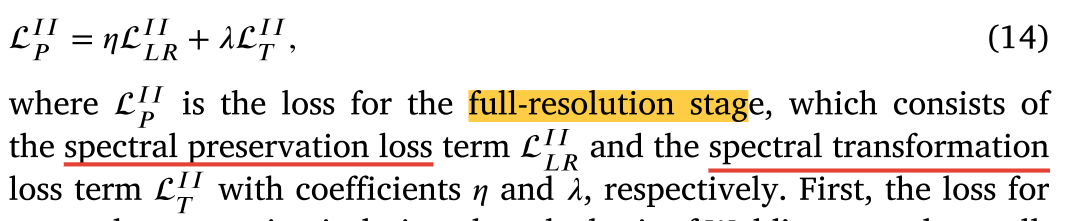

然而,如果仅仅依靠上述约束分辨率降低,pansharpening模型将落入陷阱方差。因此,我们进一步介绍了损失函数在full-resolution阶段调节性能,可制定为:

首先,在Wald协议的基础上设计了损失谱保存,这是制定为:

其中

𝐹

(

𝑛

)

𝐹^{(𝑛)}

F(n)h表示第𝑛个全分辨率融合图像。损失可以保证融合图像的光谱信息完整。此外,为了更好地保留空间信息,在训练好的STNet的光谱变换关系下,将全分辨率融合图像与HRPAN图像进行约束,如下式所示:

最后,我们将reduced- and full-resolutions阶段的损失函数组合起来,以获得全约束:

在充分约束的指导下,P2Net能够产生光谱分布准确、空间信息丰富、跨分辨率性能均衡的融合图像。

![[附源码]Python计算机毕业设计高校学生心理健康信息咨询系统Django(程序+LW)](https://img-blog.csdnimg.cn/0463643c4db043068452dafd2818d168.png)