前言:Hello大家好,我是小哥谈。YOLOv5基础知识入门系列、YOLOv5源码中的参数超详细解析系列和YOLOv5入门实践系列学习完成之后,接着就进入YOLOv5进阶改进算法系列了。🎉为了让大家能够清楚地了解如何去改进YOLOv5算法以及从哪几方面去进行改进,本篇文章就简单介绍一下本系列的算法改进思想,希望大家学习之后能够有所收获!🌈

![]() 前期回顾:

前期回顾:

YOLOv5基础知识入门系列

YOLOv5源码中的参数超详细解析系列

YOLOv5入门实践系列

目录

🚀1.YOLOv5简介

💥💥1.1 YOLOv5基础

💥💥1.2 YOLOv5网络架构改进

🚀2.YOLOv5改进思路

🚀3.数据增强策略

💥💥3.1 常见数据增强方法

💥💥3.2 数据增强作用

💥💥3.3 Mosaic数据增强方法

🚀4.模型架构改进

🚀5.训练策略改进

💥💥5.1 调整学习率策略

💥💥5.2 优化损失函数

💥💥5.3 数据采样策略

🚀6.多尺度训练和推理

🚀7.结合其他技术

💥💥7.1 注意力机制

💥💥7.2 跨尺度特征融合

💥💥7.3 模型蒸馏

🚀8.数据集扩充

🚀9.推理优化

🚀10.结论

🚀1.YOLOv5简介

💥💥1.1 YOLOv5基础

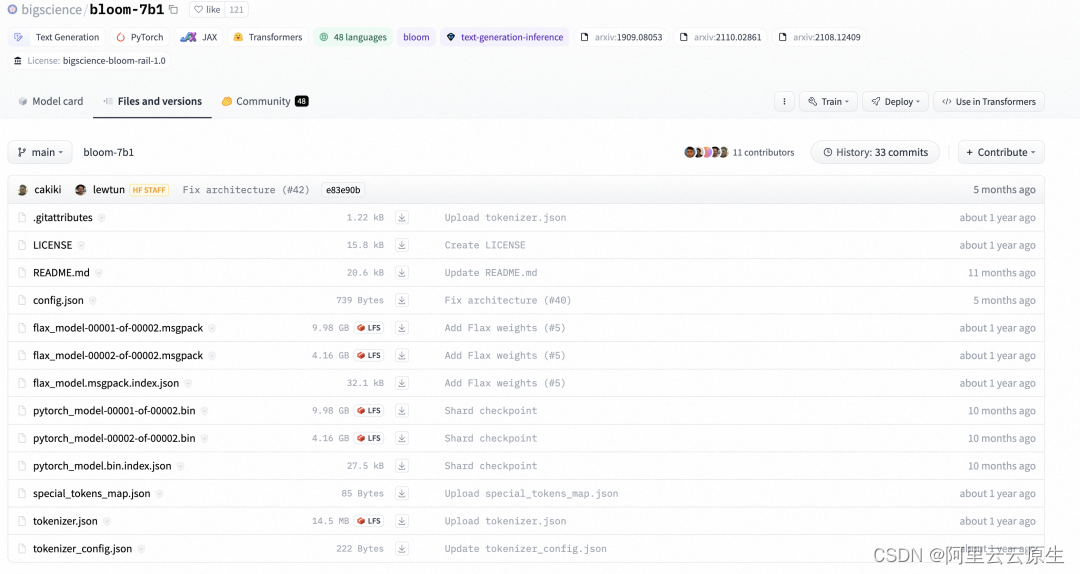

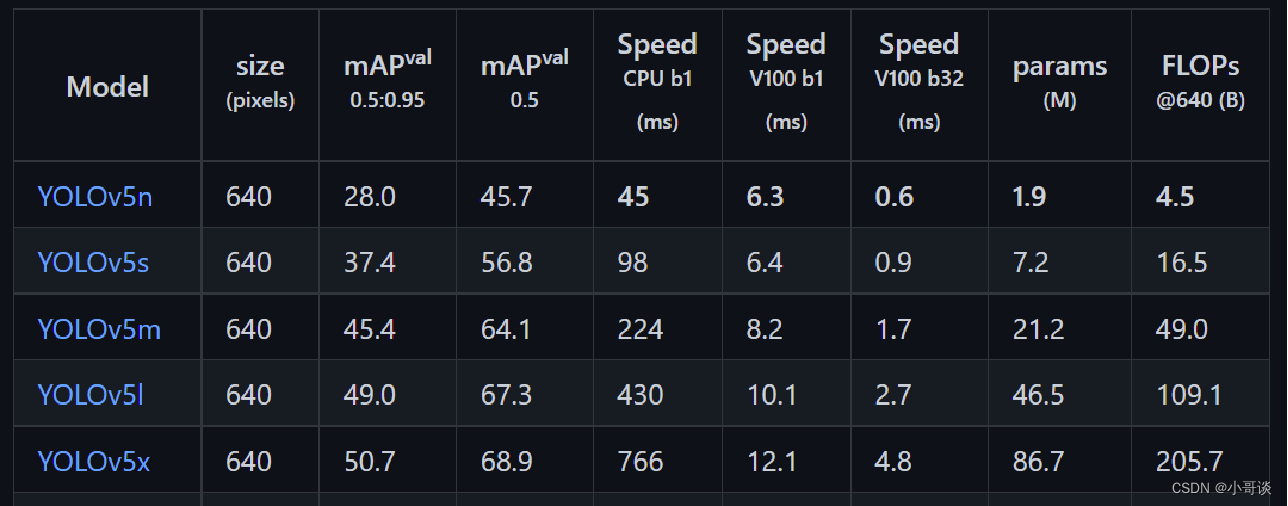

YOLOv5目标检测算法是Ultralytics公司于2020年发布的,根据模型的大小,YOLOv5有5个版本,分别为YOLOv5n、YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x,这5个版本的权重、模型的宽度和深度是依次增加的。本文将使用YOLOv5s检测模型。 YOLOv5自发行以来,一直都在更新迭代版本,本文改进的是YOLOv5-master版本,以其为baseline进行模型优化。🌟

YOLOv5的5个版本的相关参数如下图所示:✨

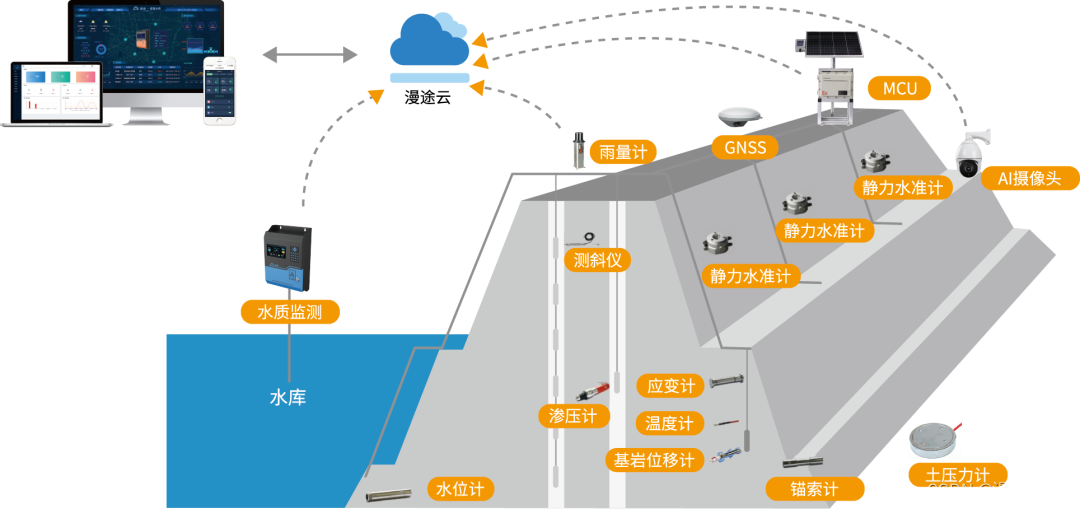

YOLOv5的网络模型分为4个部分,包括输入端、主干网络(Backbone)、Neck模块和输出端。💞

☘️(1)输入端 :YOLOv5的输入端主要包括Mosaic数据增强、自适应锚框计算和自适应图像缩放三个部分。Mosaic数据增强是在模型训练阶段使用的,将四张图片按照随机缩放、随机裁剪和随机排布的方式进行拼接,可以增加数据集中小目标的数量,从而提升模型对小目标物体的检测能力。 YOLOv5会根据参数启动自适应锚框计算功能,自适应的计算不同类别训练集中的最佳锚框值。

☘️(2)主干网络(Backbone): 模型的Backbone主要由Focus、C3(改进后的BottleneckCSP)和空间金字塔池化(Spatialpyramidpooling,SPP)模块组成。

☘️(3)Neck模块:该模块采用特征金字塔结构(FeaturePyramidNetworks,FPN)+路径聚合网络结构(PathAggregationNetwork,PAN)的结构,可以加强网络对不同缩放尺度对象特征融合的能力。

☘️(4)输出端:输出端采用GIOU函数作为边界框的损失函数,在目标检测后处理过程中,使用NMS(NonMaximumSuppression,非极大值抑制)来对多目标框进行筛选,增强了多目标和遮挡目标的检测能力。

说明:

YOLOv5官方下载代码地址:♨️♨️♨️

GitHub - ultralytics/yolov5: YOLOv5 🚀 in PyTorch > ONNX > CoreML > TFLite🌷🌷🌷

💥💥1.2 YOLOv5网络架构改进

YOLOv5的网络架构已经在YOLOv4的基础上进行了多个改进,下面是一些关于YOLOv5网络架构改进的要点:✨

☘️(1)CSPDarknet53架构:YOLOv5采用了CSPDarknet53作为主干网络。CSP(Cross Stage Partial)结构可以有效地提高特征的表示能力,并且通过将主干网络分成两个分支来降低计算量,提高推理速度。

☘️(2)PANet特征金字塔:为了处理不同尺度的目标,YOLOv5引入了PANet特征金字塔。这个金字塔结构可以在不同层级上获取多尺度的特征,并通过上采样和特征融合来提高目标检测性能。

☘️(3)SAM注意力机制:YOLOv5还引入了SAM(Spatial Attention Module)注意力机制,用于增强网络对感兴趣区域的关注程度。这个注意力机制可以在特征图上自适应地学习空间注意力权重,从而提高目标检测的准确性。

☘️(4)自适应模型锚框:YOLOv5使用自适应模型锚框来调整预测框的大小和比例。这种方法可以根据数据集中目标的分布情况自动调整锚框的尺寸,从而更好地适应不同尺度和纵横比的目标。

说明:♨️♨️♨️

除了以上的架构改进,YOLOv5还进行了其他一些细节上的优化,如改进的数据增强策略、更高的输入分辨率、更精细的损失函数等。这些改进使得YOLOv5在目标检测任务上取得了更好的性能和速度。请注意,具体的网络架构细节可能会因YOLOv5的不同版本而有所不同,建议查阅Ultralytics团队发布的官方文档和源代码以获取最新的架构改进信息。📚

🚀2.YOLOv5改进思路

要改进YOLOv5,可以考虑以下几个方面:✨

☘️(1)数据增强策略:优化数据增强策略,可以尝试使用更多的数据增强技术,如旋转、缩放、随机遮挡等,以增加模型对不同场景和变形目标的鲁棒性。

☘️(2)模型架构改进:尝试引入新的模型架构或改进现有的骨干网络,例如使用更强大的特征提取网络,或者探索新的模块组合方式来提高检测性能。

☘️(3)训练策略改进:改进训练策略可以包括调整学习率策略、优化损失函数、设计更有效的数据采样策略等,以提高模型的收敛速度和检测性能。

☘️(4)多尺度训练和推理:引入多尺度训练和推理策略,可以提高模型对不同目标尺度的检测能力,并且可以在不同场景下获得更好的性能表现。

☘️(5)结合其他技术:可以考虑结合其他相关技术来改进YOLOv5,例如注意力机制、跨尺度特征融合、模型蒸馏等,以提高检测精度和鲁棒性。

☘️(6)数据集扩充:增加更多的训练数据,尤其是对于特定场景或特定目标的数据集进行扩充,可以提高模型的泛化能力和准确性。

☘️(7)推理优化:YOLOv5对推理过程进行了优化,采用了一些轻量化的技巧,如精简卷积和模型剪枝等,以提高推理速度和模型的轻量级部署能力。

等等.......🍉 🍓 🍑 🍈 🍌 🍐 🍍 🍠 🍆 🍅 🌽

注意事项:♨️♨️♨️

改进YOLOv5需要进行大量的实验和调优,并且需要根据具体应用场景和需求来选择合适的改进方向。同时,要保持对相关研究论文和最新技术的关注,以获取更多的灵感和参考。

🚀3.数据增强策略

💥💥3.1 常见数据增强方法

数据增强是一种常见的数据预处理方法,旨在扩充数据集并提高模型的泛化能力。以下是一些常见的数据增强策略:✨

☘️(1)随机裁剪(Random Cropping):随机对图像进行裁剪,并将裁剪后的图像放大到原始尺寸,可以扩充数据集并增加模型的鲁棒性。

☘️(2)随机旋转(Random Rotation):随机对图像进行旋转,可以提高模型对旋转变化的适应性。

☘️(3)随机缩放(Random Scaling):随机对图像进行缩放操作,可以扩充数据集并提高模型的泛化能力。

☘️(4)随机翻转(Random Flipping):随机对图像进行水平或垂直翻转,可以扩充数据集并增加模型的鲁棒性。

☘️(5)随机亮度、对比度和色调(Random Brightness, Contrast and Hue):对图像的亮度、对比度和色调进行随机调整,可以提高模型对图像颜色变化的适应性。

☘️(6)随机加噪声(Random Noise):在图像中添加随机噪声,可以扩充数据集并增加模型的鲁棒性。

☘️(7)Mixup:将不同的图像进行混合,生成新的图像,可以扩充数据集并增加模型的泛化能力。

☘️(8)CutMix:在图像中随机选取一个矩形区域,并将其用另一张图像的对应区域进行替换,可以扩充数据集并增加模型的鲁棒性。

以上是一些常见的数据增强策略,当然还有其他很多的策略。选择合适的数据增强策略需要考虑具体的数据集和应用场景,可以根据实际情况进行选择。🌱

💥💥3.2 数据增强作用

☘️(1)避免过拟合。当数据集具有某种明显的特征,例如数据集中图片基本在同一个场景中拍摄,使用Cutout方法和风格迁移变化等相关方法可避免模型学到跟目标无关的信息。

☘️(2)提升模型鲁棒性,降低模型对图像的敏感度。当训练数据都属于比较理想的状态,碰到一些特殊情况,如遮挡,亮度,模糊等情况容易识别错误,对训练数据加上噪声,掩码等方法可提升模型鲁棒性。

☘️(3)增加训练数据,提高模型泛化能力。

☘️(4)避免样本不均衡。在工业缺陷检测方面,医疗疾病识别方面,容易出现正负样本极度不平衡的情况,通过对少样本进行一些数据增强方法,降低样本不均衡比例。

💥💥3.3 Mosaic数据增强方法

要获得一个表现良好的神经网络模型,往往需要大量的数据作支撑,然而获取新的数据这项工作往往需要花费大量的时间与人工成本。使用数据增强技术,可以充分利用计算机来生成数据,增加数据量,如采用缩放、平移、旋转、色彩变换等方法增强数据,数据增强的好处是能够增加训练样本的数量,同时添加合适的噪声数据,能够提高模型的泛化能力。 💞

在YOLOv5中除了使用最基本的数据增强方法外,还使用了Mosaic数据增强方法,使用随机增减亮度、对比度、饱和度、色调以及随机缩放、裁减、翻转、擦除等基本方法进行数据增强。Mosaic数据增强选取四张经过进行上述基本方法操作后的图片进行随机编排和拼接,一方面变相地增大了BatchSize,降低显存占用率,另一方面扩充了原始数据集,防止过拟合的发生,提高了模型的整体鲁棒性。💞

采用Mosaic方法的增强版——Mosaic-8,即采用8张图片随机裁剪、随机排列、随机缩放,然后组合成一张图片,以此来增加样本的数据量,同时合理引入一些随机噪声,增强网络模型对图像中小目标样本的区分力,提升模型的泛化力,其细节如图所示。

🚀4.模型架构改进

YOLOv5 是目标检测领域的一个重要模型,它是基于单阶段检测器 YOLO(You Only Look Once)系列的版本。对于YOLOv5模型架构的改进,有很多不同的方法和技术可以尝试,以下是一些可行的方法:✨

☘️(1)Backbone 网络改进:YOLOv5 使用的是 CSPDarknet53 作为其主干网络,可以考虑使用其他更强大的主干网络,如 MobileNetV3、ShuffleNetV2、EfficientNetV2、GhostNet、ResNet、BiFPN 等。这样可以提高模型的特征提取能力和表达能力。

☘️(2)增加层级预测:YOLOv5 通过在不同尺度上进行预测来检测不同大小的目标。可以考虑增加更多的层级预测,以进一步提升模型对不同尺度目标的检测性能。

☘️(3)网络宽度和深度调整:YOLOv5 的网络结构可以根据任务的需要进行适当的调整。增加网络的宽度和深度可以提升模型的表达能力,但也会增加模型的计算量和参数数量。可以通过合理的调整来平衡性能和效率。

等等.......🍉 🍓 🍑 🍈 🍌 🍐 🍍 🍠 🍆 🍅 🌽

🚀5.训练策略改进

💥💥5.1 调整学习率策略

学习率是指在机器学习中用来控制模型参数更新的速度和幅度的超参数,它决定了每一次参数更新时的步长大小。较大的学习率会导致参数更新幅度过大,可能会错过最优解;而较小的学习率则可能导致参数更新过于缓慢,收敛速度慢。💦

选择合适的学习率是训练模型时需要进行调整的重要步骤。通常可以通过试验不同的学习率来找到一个合适的取值。如果学习率过大,可以尝试降低学习率;如果学习率过小,可以尝试增大学习率。总之,选择适当的学习率对于训练好的模型至关重要,需要根据具体情况进行调整和优化。💦

学习率策略的调整是优化YOLOv5算法模型的重要步骤之一。以下是一些常见的学习率调整策略:✨

☘️(1)固定学习率:在训练过程中保持不变的学习率。这种策略简单直接,但可能不够灵活。

☘️(2)学习率衰减:随着训练的进行,逐渐降低学习率。可以通过设置固定的衰减率或者根据训练过程中的指标动态调整衰减速度。

☘️(3)学习率分段调整:将训练过程分为多个阶段,在每个阶段使用不同的学习率。通常,在初始阶段使用较大的学习率以快速收敛,然后逐渐减小学习率以细化模型。

☘️(4)学习率重启:周期性地将学习率重置为初始值,以帮助模型跳出局部最优解并找到新的最优解。

☘️(5)自适应学习率方法:使用自适应算法(如Adam、RMSprop等)来动态调整学习率。这些算法会根据参数梯度和历史梯度信息自动调整学习率。

说明:♨️♨️♨️

选择适合的学习率策略需要考虑训练数据、模型架构和任务类型等因素。通常,需要通过实验和调优来确定最佳的学习率策略。🍃

💥💥5.2 优化损失函数

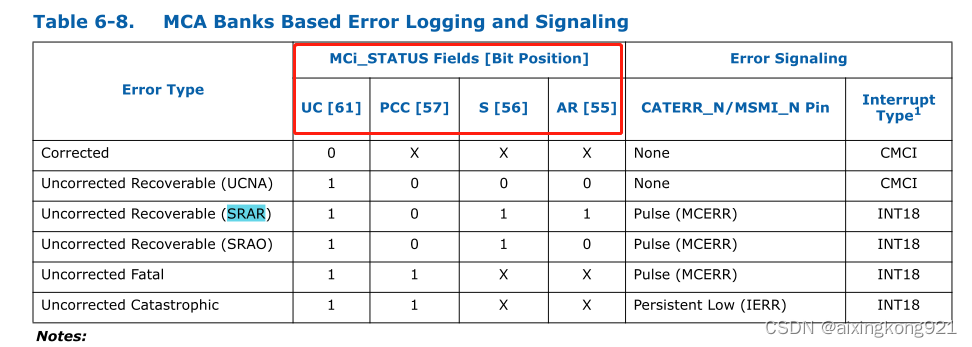

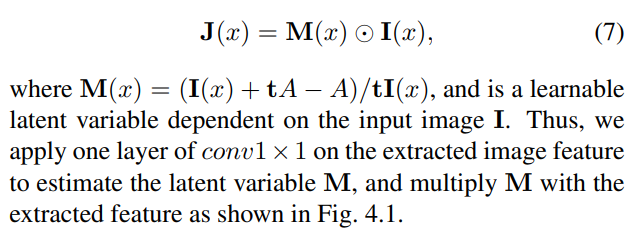

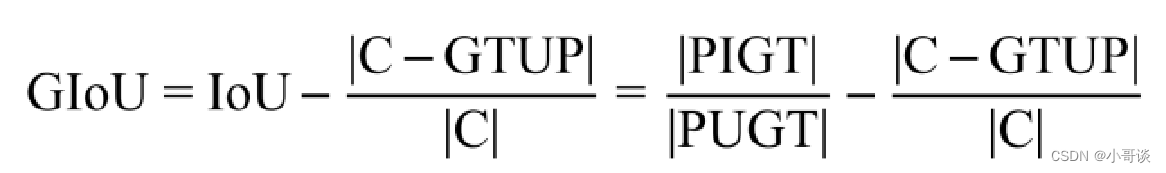

原始YOLOv5损失函数由定位损失、置信度损失和类别损失3部分构成。其中置信度损失和类别损失采用二元交叉熵损失函数进行计算,原始YOLOv5中使用GIoU来计算定位损失:

优化损失函数是YOLOv5模型训练过程中的一个重要的任务,它的目标是通过调整模型的参数来最小化损失函数的值。下面是一些常见的优化损失函数的方法:✨

☘️(1)梯度下降法(Gradient Descent):梯度下降是一种迭代的优化算法,通过计算损失函数对参数的偏导数来更新参数,使得损失函数逐渐减小。有多种梯度下降的变体,如批量梯度下降(Batch Gradient Descent)、机梯度下降(Stochastic Gradient Descent)和小批量梯度下降(Mini-batch Gradient Descent)。

☘️(2)学习率调整(Learning Rate Schedule):学习率是梯度下降中一个重要的超参数,决定了参数更新的步幅大小。学习率调整的目的是在训练过程中逐渐减小学习率,以提高训练效果。常见的学习率调整方法有固定学习率、指数衰减学习率和自适应学习率等。

☘️(3)正则化(Regularization):正则化是一种常用的优化方法,通过在损失函数中添加正则项,限制模型参数的大小,以防止过拟合。常见的正则化方法有L1正则化和L2正则化。

☘️(4)批归一化(Batch Normalization):批归一化是一种常用的技术,通过对每一层的输入进行归一化处理,加速模型的训练和提高模型的泛化能力。

☘️(5)随机初始化(Random Initialization):在训练神经网络时,参数的初始值非常重要。随机初始化参数可以帮助打破对称性,避免陷入局部最优解。

☘️(6)损失函数的改进:除了常见的损失函数如均方误差(Mean Square Error)和交叉熵(Cross Entropy),还有一些改进的损失函数如平滑L1损失函数、Huber损失函数等,可以根据具体任务的特点选择合适的损失函数。

以上是一些常见的优化损失函数的方法,实际应用中,根据具体问题和数据集的特点选择合适的优化方法是非常重要的。🍁

说明:

关于损失函数,请参考我的另外一篇文章。♨️♨️♨️

YOLOv5基础知识入门(5)— 损失函数(IoU、GIoU、DIoU、CIoU和EIoU)

💥💥5.3 数据采样策略

在 YOLOv5 中,数据采样策略是为了训练目标检测模型,以下是一些常用的数据采样策略:✨

☘️(1)随机采样:从整个数据集中随机选择一部分样本进行训练。这种采样策略适用于数据集分布均匀的情况下。

☘️(2)分层采样:如果数据集中存在多个子集或子群体,可以使用分层采样方法,确保每个子集都能够被充分代表。例如,可以根据目标类别或图像属性将数据集分为不同的子集,然后从每个子集中按比例采样。

☘️(3)重要性采样:对于一些重要的样本,可以根据其重要性或权重进行采样,以确保这些样本在训练中得到更多的关注。例如,可以根据物体大小、难度等因素对样本进行加权采样。

☘️(4)数据增强:通过对原始数据进行一定的变换和增强,生成更多的样本。常用的数据增强方法包括随机裁剪、旋转、缩放、翻转等操作,以增加数据的多样性和模型的鲁棒性。

☘️(5)平衡采样:针对数据集中类别不平衡的情况,可以使用过采样(增加少数类样本)或欠采样(减少多数类样本)的方法来平衡数据。这有助于模型更好地学习各个类别的特征。

☘️(6)确定采样比例:根据数据集的大小和模型的训练需求,确定采样的比例。可以根据经验或通过尝试不同的比例来找到最佳的采样比例。

说明:♨️♨️♨️

需要根据具体情况选择合适的数据采样策略,以上是一些常用的方法和注意事项,在训练 YOLOv5 模型时可以进行参考。最好根据你的数据集特点和训练目标进行调整和优化。🌴

🚀6.多尺度训练和推理

YOLOv5引入了多尺度训练和推理方法,以提高不同尺度目标检测能力。以下是YOLOv5中多尺度训练和推理的一些关键要点:✨

多尺度训练:

☘️(1)随机尺度训练:在每个训练样本上,将输入图像随机缩放到不同的尺度进行训练。这样做可以使模型具备对不同大小目标的识别能力,并提高鲁棒性。

☘️(2)多尺度输入:在训练过程中,使用不同尺度的输入图像进行训练。YOLOv5支持在不同尺度上进行训练,例如使用640x640、768x768或896x896等不同分辨率的图像。

☘️(3)MixUp 数据增强:YOLOv5还采用了MixUp数据增强技术。MixUp将两个不同的图像按照一定比例进行混合,生成具有不同尺度的训练样本。这有助于提高模型对多尺度目标的识别能力。

多尺度推理:

☘️(1)多尺度预测:在推理阶段,YOLOv5会使用多个不同尺度的输入图像进行目标检测预测。通过在不同尺度上进行预测,可以捕捉到不同大小的目标。

☘️(2)多尺度测试策略:在多尺度预测的基础上,YOLOv5还采用了多尺度测试策略。它会在不同尺度上进行检测,并结合不同尺度的置信度进行结果融合或后处理,从而提高对多尺度目标的检测性能。

说明:♨️♨️♨️

综上所述,YOLOv5通过多尺度训练和推理的方式,能够有效地处理不同尺度的目标,提高目标检测的准确性和鲁棒性。这些方法可以根据具体任务和需求进行调整和优化,以获得最佳的检测结果。🍄

🚀7.结合其他技术

💥💥7.1 注意力机制

注意力机制(Attention Mechanism)源于对人类视觉的研究。在认知科学中,由于信息处理的瓶颈,人类会选择性地关注所有信息的一部分,同时忽略其他可见的信息。上述机制通常被称为注意力机制。人类视网膜不同的部位具有不同程度的信息处理能力,即敏锐度(Acuity),只有视网膜中央凹部位具有最强的敏锐度。为了合理利用有限的视觉信息处理资源,人类需要选择视觉区域中的特定部分,然后集中关注它。例如,人们在阅读时,通常只有少量要被读取的词会被关注和处理。🍃

综上,注意力机制主要有两个方面:决定需要关注输入的哪部分;分配有限的信息处理资源给重要的部分。📢

计算机视觉中的注意力机制是指在图像识别、目标检测、语义分割等任务中,通过对输入数据中的重要区域进行加权处理,以提高模型的准确率和性能。

注意力机制的原理可以理解为,模型在处理输入数据时,为了实现特定的任务,需要从输入数据中关注一些重要的信息,而忽略一些不重要的信息。因此,注意力机制可以通过对不同的输入数据进行加权处理,以调整模型对每个输入数据的关注程度,从而提高模型的性能。🔖

具体来说,注意力机制可以分为自底向上的注意力和自顶向下的注意力两种。✨

- 自底向上的注意力是指模型在处理输入数据时,从低级别的特征开始,逐步关注越来越高级别的特征,最终汇聚成完整的输入表示。

- 自顶向下的注意力是指模型在处理输入数据时,通过从高级别的特征开始,逐步关注越来越低级别的特征,最终汇聚成完整的输入表示。

在实现注意力机制时,常用的方法包括软注意力(Soft Attention)和硬注意力(Hard Attention)两种。✨

- 软注意力是指对输入数据进行加权平均,以获得加权后的特征表示。

- 硬注意力是指对输入数据进行选择,以选择出最重要的数据,并将其作为模型的输入。

这两种方法都可以用于实现注意力机制,具体的选择取决于具体的应用场景和任务。总的来说,注意力机制是一种有效的模型优化技术,在计算机视觉领域中被广泛应用。通过加强模型对输入数据中重要区域的关注程度,注意力机制可以提高模型的准确率和性能,并在图像识别、目标检测、语义分割等任务中发挥重要作用。💎

💥💥7.2 跨尺度特征融合

跨尺度特征融合(Cross-Scale Feature Fusion)是指在计算机视觉任务中,将来自不同尺度的特征进行融合,以提高模型对于多尺度信息的理解能力和性能。

在计算机视觉中,图像往往包含了不同尺度的信息。例如,物体可能在图像中的不同区域以不同的尺度出现,或者图像中的物体可能具有不同的大小。为了更好地利用这些多尺度的信息,跨尺度特征融合被广泛应用于许多计算机视觉任务,如目标检测、语义分割和图像生成等。

跨尺度特征融合的方法有多种,常见的包括:✨

☘️(1)金字塔结构:通过构建多层次的特征金字塔,从粗糙到细致地捕捉不同尺度的信息。这些金字塔中的每一层都包含了图像在不同尺度上的特征表示,可以通过上采样或下采样操作将它们融合在一起。

☘️(2)多尺度特征融合模块:通过设计特殊的网络模块,将来自不同尺度的特征进行融合。这些模块通常包括跨尺度的连接或卷积操作,以便有效地整合多尺度的信息。

☘️(3)注意力机制:通过引入注意力机制,使得网络能够自适应地关注不同尺度的特征。通过计算特征之间的相似度,可以将更多的注意力放在重要的尺度上,从而提高模型对于多尺度信息的利用能力。

说明:♨️♨️♨️

跨尺度特征融合可以帮助模型更好地理解和处理具有多尺度特征的图像,提高模型的鲁棒性和泛化能力。

💥💥7.3 模型蒸馏

模型蒸馏(Model Distillation)是一种常用的模型压缩技术,旨在将一个复杂的模型(称为教师模型)的知识传递给一个简化的模型(称为学生模型),以减少模型的复杂度和计算资源消耗,同时保持高性能。

模型蒸馏的基本思想是通过让学生模型学习教师模型的输出概率分布来进行知识传递。通常,教师模型是一个大型而准确的模型,它在训练数据上表现出色。学生模型是一个轻量级模型,它的目标是在保持高性能的同时具有更小的模型大小和计算开销。

在模型蒸馏中,教师模型的知识可以通过两种方式传递给学生模型:✨

- 软目标(Soft Targets):教师模型产生的输出概率分布被用作学生模型的训练目标。这样,学生模型不仅会尝试预测正确的类别,还会努力模拟教师模型的输出分布。这种软目标可以提供更多的信息,使得学生模型能够更好地捕捉数据集中的细微特征。

- 知识蒸馏(Knowledge Distillation):除了软目标外,还可以将教师模型的中间层特征传递给学生模型,使得学生模型能够学习到教师模型在特定任务上的特征表示。这种知识蒸馏可以帮助学生模型更好地理解数据和任务。

说明:♨️♨️♨️

通过模型蒸馏,学生模型可以在保持高性能的同时具有更小的模型体积和更高的推理效率。这使得模型在资源受限的环境下更易于部署和使用。模型蒸馏已经在各种任务和领域中得到广泛应用,包括自然语言处理、计算机视觉和语音识别等。

🚀8.数据集扩充

数据集扩充是指通过增加更多的数据样本来丰富和扩大现有的数据集。这可以帮助提高机器学习模型的性能和泛化能力,尤其是在训练样本有限的情况下。以下是一些常见的方法来进行数据集扩充:✨

☘️(1)数据采集:通过网络爬虫、API等方式收集更多的数据样本。这可以是从公共数据源、论坛、社交媒体等地方获取相关数据。

☘️(2)数据增强:通过对现有数据进行一系列的转换和变换来生成新的数据样本。例如,对图像进行旋转、缩放、镜像等操作,或者对文本进行词语替换、插入、删除等操作。

☘️(3)合成数据:根据现有数据的特征和分布生成新的合成数据样本。这可以通过使用生成模型(如GAN)或基于规则的方法来实现。

☘️(4)迁移学习:利用已有的大规模数据集进行预训练,并将其应用于目标任务。这可以通过将模型在预训练数据上进行微调来扩展目标任务的数据集。

☘️(5)伪标签:使用模型对未标记的数据进行预测,并将其作为标签加入到训练数据中。这可以通过半监督学习或主动学习等方法来实现。

说明:♨️♨️♨️

请注意,数据集扩充需要谨慎操作,确保生成的样本保持与原始数据的一致性和合理性,并避免引入噪声或不准确的样本。

🚀9.推理优化

YOLOv5是一种流行的目标检测算法,它基于深度学习模型,并在实时目标检测任务中表现出色。为了优化YOLOv5的推理过程,可以考虑以下几个方面:✨

☘️(1)模型压缩:YOLOv5的原始模型可能会比较大,因此可以使用模型压缩技术来减小模型的大小,以提高推理速度。例如,可以使用剪枝、量化或蒸馏等技术来减少参数量或精度损失。

☘️(2)模型加速:可以通过使用加速硬件(如GPU、TPU等)或优化网络结构来加速YOLOv5的推理过程。例如,可以使用深度学习加速库(如TensorRT、OpenVINO等)来优化模型的计算图,或者使用轻量级网络结构(如MobileNet、EfficientNet等)来减少计算量。

☘️(3)并行推理:利用硬件资源的并行计算能力,可以将YOLOv5的推理任务划分为多个子任务,并在多个设备上并行执行,以提高推理的速度。例如,可以使用多GPU或分布式计算框架(如Horovod、NCCL等)来实现并行推理。

☘️(4)输入预处理:对输入图像进行预处理可以减少YOLOv5的推理时间。例如,可以对图像进行缩放、裁剪或转换等操作,以适应模型的输入要求,并减少不必要的计算。

☘️(5)后处理优化:YOLOv5在检测完成后,需要进行后处理操作(如NMS,非极大值抑制),可以通过优化后处理算法和参数来减少计算负担,提高推理速度。

说明:♨️♨️♨️

综上所述,通过模型压缩、模型加速、并行推理、输入预处理和后处理优化等方法,可以对YOLOv5进行推理优化,提高其速度和效率。具体的优化策略可以根据实际场景和需求进行选择和调整。

🚀10.结论

算法创新分为三种方式:✨

第1种:面目一新的创新,比如YOLOv5、Faster-RCNN、CenterNet等,开创出新的算法领域,不过这种也是最难的。

第2种:守正出奇的创新,比如将图像金字塔改进为特征金字塔。

第3种:各种先进算法集成的创新,比如不同领域发表的最新论文的tricks,集成到自己的算法中,却发现有出乎意料的改进。